새로운 BEV LV Fusion 솔루션: BEVFusion을 넘어선 Lift-Attend-Splat

- PHPz앞으로

- 2024-01-13 22:45:07761검색

논문: Transformer 기술을 이용한 조감도 카메라 및 LiDAR 융합을 위한 Lift-Attend-Splat 방법

파일을 보려면 링크를 클릭하세요: https://arxiv.org/pdf/2312.14919.pdf

안전을 위해- 자율 주행과 같은 중요한 애플리케이션에는 보완적인 센서 양식을 결합하는 것이 중요합니다. 최근 자율주행 카메라-라이다 융합 방식은 인식 향상을 위해 단안 깊이 추정을 사용하는데, 이는 라이다의 깊이 정보를 직접 활용하는 것에 비하면 어려운 작업이다. 우리의 연구에서는 이 접근 방식이 깊이 정보를 완전히 활용하지 못하고 깊이 추정을 단순하게 개선해도 객체 감지 성능이 향상되지 않음을 보여줍니다. 놀랍게도 깊이 추정을 완전히 제거해도 객체 감지 성능이 저하되지는 않습니다.

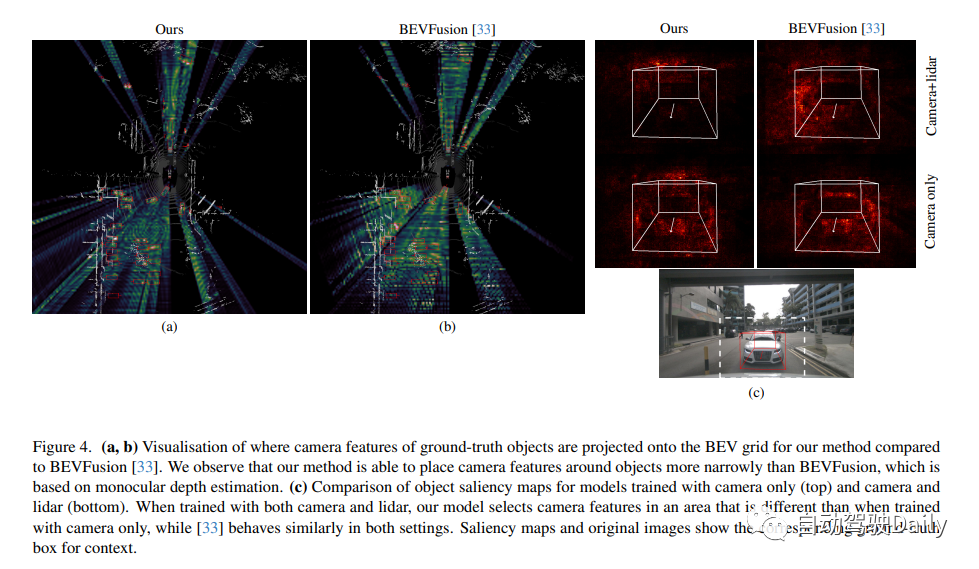

이는 단안 깊이에 대한 의존이 카메라-라이다 융합 중에 불필요한 아키텍처 병목 현상이 될 수 있음을 시사합니다. 본 연구에서는 단안 깊이 추정을 완전히 우회하고 대신 간단한 주의 메커니즘을 활용하여 BEV 그리드에서 카메라와 LiDAR 기능을 선택하고 융합하는 새로운 융합 방법을 제안합니다. 결과는 제안된 모델이 LiDAR 기능의 가용성에 따라 카메라 기능의 사용을 조정할 수 있으며 단안 깊이 추정을 기반으로 한 기본 모델보다 nuScenes 데이터 세트에서 더 나은 3D 감지 성능을 갖는다는 것을 보여줍니다.

이 연구 소개 새로운 카메라 - "Lift Attented Splat"이라는 LiDAR 융합 방식이 개발되었습니다. 이 방법은 단안 깊이 추정을 피하고 대신 간단한 변환기를 사용하여 BEV에서 카메라와 LiDAR 기능을 선택하고 융합합니다. 실험은 단안 깊이 추정 기반 방법과 비교하여 이 연구 방법이 카메라를 더 잘 활용하고 객체 감지 성능을 향상시킬 수 있음을 입증합니다. 본 연구의 기여는 다음과 같습니다.

- Lift Splat 패러다임을 기반으로 한 카메라-라이다 융합 방법은 예상대로 깊이를 활용하지 않습니다. 특히, 단안 깊이 예측이 완전히 제거되면 동일하거나 더 나은 성능을 발휘한다는 것을 보여줍니다.

- 이 논문에서는 순수 BEV에 카메라와 LiDAR 기능을 융합하기 위해 간단한 주의 메커니즘을 사용하는 새로운 카메라-LIDAR 융합 방법을 소개합니다. 이 논문은 Lift Splat 패러다임을 기반으로 한 모델에 비해 카메라를 더 잘 활용하고 3D 감지 성능을 향상시킬 수 있음을 보여줍니다.

주구조 소개

깊이 예측의 정확도는 일반적으로 낮습니다. 절대 상대 오차(Abs.Rel.) 및 평균 제곱근 오차(RMSE)를 사용하여 BEVFusion에서 예측한 깊이 품질을 LiDAR 깊이 맵과 비교하여 정성적 및 정량적 분석을 수행할 수 있습니다. 그림 1에서 볼 수 있듯이 깊이 예측은 장면의 구조를 정확하게 반영하지 못하고 라이더 깊이 맵과 크게 다르므로 단안 깊이가 예상대로 완전히 활용되지 않음을 나타냅니다. 또한 연구에서는 깊이 예측을 개선해도 객체 감지 성능이 향상되지 않는다는 사실도 발견했습니다. 깊이 예측을 완전히 제거해도 객체 감지 성능에 영향을 미치지 않습니다

단안 깊이 추정을 완전히 우회하고 대신 간단한 변환기를 사용하여 조감도 카메라와 LiDAR 기능을 융합하는 카메라-라이다 융합 방법을 제안합니다. 그러나 카메라와 라이더 기능의 수가 많고 주목의 2차 특성으로 인해 트랜스포머 아키텍처는 카메라-라이다 융합 문제에 간단히 적용하기가 어렵습니다. BEV에서 카메라 기능을 투영할 때 문제의 기하학적 구조를 사용하여 주의 범위를 크게 제한할 수 있습니다. 카메라 기능은 해당 광선을 따르는 위치에만 기여해야 하기 때문입니다. 우리는 이 아이디어를 카메라-라이다 융합 사례에 적용하고 카메라 평면의 기둥과 라이다 BEV 그리드의 극광선 사이의 교차 주의를 사용하는 간단한 융합 방법을 소개합니다! 단안 깊이를 예측하는 대신 교차 주의는 광선을 따라 LiDAR 기능이 제공하는 맥락에서 어떤 카메라 기능이 가장 두드러지는지 학습합니다.

우리 모델은 Lift Splat 패러다임을 기반으로 한 방법과 전체 아키텍처가 유사합니다. BEV에서. 아래 그림과 같이 카메라와 라이더 백본, 각 모달 특징을 독립적으로 생성하는 모듈, 카메라 기능을 BEV에 내장하고 이를 라이더와 융합하는 프로젝션 및 융합 모듈, 감지 헤드로 구성됩니다. 표적 탐지를 고려할 때 모델의 최종 출력은 위치, 크기, 방향, 속도 및 분류 정보를 포함한 장면 내 표적의 속성이며 3D 경계 상자 형태로 표현됩니다.

Lift Attented Splat 카메라 LiDAR 융합 아키텍처는 아래와 같습니다. (왼쪽) 전체 아키텍처: 카메라와 LiDAR 백본의 기능이 감지 헤드로 전달되기 전에 함께 융합됩니다. (삽입) 3D 투영의 기하학적 구조: "리프트" 단계에서는 쌍선형 샘플링을 사용하여 라이더 BEV 기능을 투영된 수평선에 삽입하여 z 방향을 따라 라이더 기능을 들어 올립니다. "스플랫(splat)" 단계는 역변환에 해당합니다. 이는 쌍선형 샘플링을 사용하여 투영된 수평선의 특징을 다시 z 방향을 따라 BEV 그리드로 투영하기 때문입니다! 오른쪽에는 프로젝트 모듈의 세부정보가 표시됩니다.

실험 결과

원본 링크: https://mp.weixin.qq.com/s/D7xgvrp8633S2SeUfCRFXQ

위 내용은 새로운 BEV LV Fusion 솔루션: BEVFusion을 넘어선 Lift-Attend-Splat의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!