대규모 기계 학습의 환각 완화 기술에 대한 종합적인 연구

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2024-01-05 16:54:111391검색

대형 언어 모델(LLM)은 텍스트 이해 및 생성과 같은 자연어 처리(NLP) 분야의 다양한 작업을 수행할 수 있는 대량의 매개변수와 데이터를 갖춘 심층 신경망입니다. 최근 몇 년 동안 컴퓨팅 성능과 데이터 규모가 향상됨에 따라 LLM은 GPT-4, BART, T5 등과 같이 눈에 띄는 발전을 이루며 강력한 일반화 기능과 창의성을 보여주었습니다.

LLM에도 심각한 문제가 있습니다. 텍스트를 생성할 때 실제 사실이나 사용자 입력과 일치하지 않는 콘텐츠, 즉 환각을 생성하기 쉽습니다. 이러한 현상은 시스템 성능을 저하시킬 뿐만 아니라 사용자의 기대와 신뢰에 영향을 미치고 일부 보안 및 윤리적 위험을 초래할 수도 있습니다. 따라서 LLM에서 환각을 감지하고 완화하는 방법은 현재 NLP 분야에서 중요하고 시급한 주제가 되었습니다.

1월 1일 방글라데시의 이슬람 과학기술대학교, 미국 사우스캐롤라이나대학교 인공지능연구소, 미국 스탠포드대학교, 아마존 인공지능학과의 여러 과학자들이 미국, SM Towhidul Islam Tonmoy, SM Mehedi Zaman, Vinija Jain, Anku Rani, Vipula Rawte, Aman Chadha 및 Amitava Das는 "A Comprehensive Survey of Hallucination Mitigation Techniques in Large Language Models"라는 제목의 논문을 발표했습니다. LLM(대형 언어 모델)에서 환각 완화 기술을 소개하고 분류합니다.

먼저 환각의 정의와 원인, 효과, 평가 방법을 소개했습니다. 그런 다음 환각 완화 기술을 데이터 세트 기반, 작업 기반, 피드백 기반 및 검색 기반의 네 가지 광범위한 범주로 나누는 상세한 분류 시스템을 제안합니다. 각 범주 내에서 다양한 하위 범주를 더욱 세분화하고 몇 가지 대표적인 방법을 설명합니다.

저자는 이러한 기술의 장점, 단점, 과제 및 한계뿐만 아니라 향후 연구 방향도 분석합니다. 그들은 현재 기술이 여전히 일반성, 해석성, 확장성, 견고성 부족 등 몇 가지 문제를 안고 있다고 지적했습니다. 그들은 향후 연구가 보다 효과적인 환각 탐지 및 정량화 방법 개발, 다중 모드 정보 및 상식 지식 활용, 보다 유연하고 사용자 정의 가능한 환각 완화 프레임워크 설계, 인간 참여 및 피드백 고려 등의 측면에 초점을 맞춰야 한다고 제안했습니다.

1. LLM의 환각 분류 시스템

LLM의 환각 문제를 더 잘 이해하고 설명하기 위해 다음과 같이 환각의 출처, 유형, 정도 및 영향을 기반으로 한 분류 시스템을 제안했습니다. 그림 1 쇼. 그들은 이 시스템이 LLM 환각의 모든 측면을 다룰 수 있고, 환각의 원인과 특성을 분석하는 데 도움이 되며, 환각의 심각도와 피해를 평가할 수 있다고 믿습니다.

그림 1

그림 1

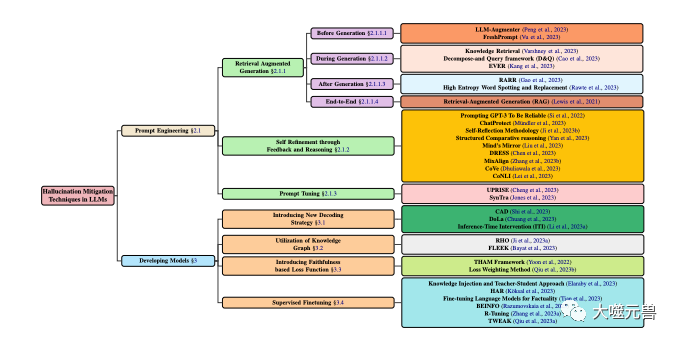

LLM의 환각 완화 기술 분류. 모델 개발 및 유도 기술과 관련된 대중적인 방법에 중점을 둡니다. 모델 개발은 새로운 디코딩 전략, 지식 그래프 기반 최적화, 새로운 손실 함수 구성 요소 추가, 감독된 미세 조정 등 다양한 방법으로 구분됩니다. 한편 큐 엔지니어링에는 검색 향상 기반 방법, 피드백 기반 전략 또는 큐 조정이 포함될 수 있습니다.

환각의 근원

환각의 근원은 LLM에서 환각의 근본 원인이며, 이는 다음 세 가지 범주로 요약될 수 있습니다.

파라메트릭 지식: LLM은 대규모 교육을 통해 학습합니다. 사전 훈련 단계 문법, 의미, 상식 등과 같은 레이블이 지정되지 않은 텍스트에서 학습된 암시적 지식입니다. 이 지식은 일반적으로 LLM의 매개변수에 저장되며 활성화 기능 및 주의 메커니즘을 통해 호출될 수 있습니다. 파라메트릭 지식은 LLM의 기초이지만 부정확하고 오래되었거나 편향된 정보가 포함되어 있거나 사용자가 입력한 정보와 충돌할 수 있으므로 환상의 원천이 될 수도 있습니다.

비모수적 지식: LLM이 미세 조정 또는 생성 단계에서 사실, 증거, 인용문 등 외부 주석이 달린 데이터로부터 얻는 명시적 지식입니다. 이러한 지식은 일반적으로 구조화된 형태나 구조화되지 않은 형태로 존재하며 검색 또는 기억 메커니즘을 통해 접근할 수 있습니다. 비모수적 지식은 LLM을 보완하지만 일부 노이즈, 오류 또는 불완전한 데이터를 포함하거나 LLM의 매개변수적 지식과 일치하지 않을 수 있으므로 환상의 원인이 될 수도 있습니다.

생성 전략: 디코딩 알고리즘, 제어 코드, 프롬프트 등과 같이 텍스트를 생성할 때 LLM에서 사용하는 일부 기술 또는 방법을 나타냅니다. 이러한 전략은 LLM을 위한 도구이지만 LLM이 특정 지식에 과도하게 의존하거나 무시하게 만들거나 생성 프로세스에 약간의 편견이나 소음을 도입할 수 있기 때문에 환상의 원천이 될 수도 있습니다.

환각 유형

환각 유형은 LLM에서 생성된 환각의 특정 표현을 나타내며 다음 네 가지 범주로 나눌 수 있습니다.

문법적 환각: LLM에서 생성된 텍스트의 문법 오류를 나타냅니다. 또는 철자 오류, 구두점 오류, 어순 오류, 시제 오류, 주어-동사 불일치 등과 같은 불규칙성이 있습니다. 이러한 환상은 일반적으로 LLM의 언어 규칙에 대한 불완전한 이해 또는 시끄러운 데이터에 대한 과적합으로 인해 발생합니다.

의미적 환각(Semantic Hallucination): 단어 의미 오류, 참조 오류, 논리적 오류, 모호성, 모순 등 LLM이 생성한 텍스트의 의미론적 오류나 비합리성을 말합니다. 이러한 환상은 LLM이 언어 의미를 제대로 이해하지 못하거나 복잡한 데이터를 제대로 처리하지 못하여 발생하는 경우가 많습니다.

지식 환각: LLM에서 생성된 텍스트에 사실 오류, 증거 오류, 인용 오류, 입력 또는 문맥 불일치 등 지식의 오류나 불일치가 포함되어 있다는 사실을 말합니다. 이러한 환상은 일반적으로 LLM의 잘못된 획득이나 지식의 부적절한 사용으로 인해 발생합니다.

창의적 환각: 스타일 오류, 감정적 오류, 잘못된 관점, 작업 또는 목표와의 부적합성 등 창의적 오류나 부적절함이 있는 LLM에서 생성된 텍스트를 말합니다. 이러한 환상은 종종 LLM의 생성에 대한 불합리한 통제 또는 부적절한 평가로 인해 발생합니다.

환각의 정도

환각의 정도는 LLM이 생성하는 환각의 양과 질을 말하며 다음 세 가지 범주로 나눌 수 있습니다.

경미한 환각: 환각이 덜하고 가벼워집니다. 텍스트의 전체적인 가독성과 이해도에 영향을 주지 않으며 텍스트의 주요 메시지와 목적을 훼손하지 않습니다. 예를 들어, LLM은 사소한 문법 오류, 의미적 모호함, 세부적인 지식 오류 또는 창의적인 미묘한 차이를 생성합니다.

중간 환각: 텍스트의 가독성과 이해도에 일부 영향을 미치고 텍스트의 2차 정보와 목적을 손상시키는 심한 환각이 많이 있습니다. 일반적으로 LLM은 큰 문법 오류나 의미론적 비합리성을 생성합니다.

심각한 환각: 환각은 매우 많고 매우 무거워서 텍스트의 전반적인 가독성과 이해도에 영향을 미치고 텍스트의 주요 메시지와 목적을 파괴합니다.

환각의 영향

환각의 영향은 LLM이 생성한 환각이 사용자와 시스템에 미치는 잠재적인 결과를 말하며, 이는 다음 세 가지 범주로 나눌 수 있습니다.

무해한 환각: 무해한 환각 : 사용자와 시스템에 미치는 영향 부정적인 영향은 없으며 재미, 창의성, 다양성 증가 등 긍정적인 영향도 미칠 수 있습니다. 예를 들어, LLM은 작업이나 목표와 관련이 없는 일부 콘텐츠, 사용자의 선호도나 기대와 일치하는 일부 콘텐츠, 사용자의 기분이나 태도와 일치하는 일부 콘텐츠, 또는 다음과 같은 목적에 도움이 되는 일부 콘텐츠를 생성합니다. 사용자의 커뮤니케이션 또는 상호작용 콘텐츠.

유해한 환각: 효율성, 정확성, 신뢰성, 만족도 감소 등 사용자와 시스템에 부정적인 영향을 미칩니다. 예를 들어, LLM은 작업이나 목표와 일치하지 않는 일부 콘텐츠, 사용자의 선호도나 기대와 일치하지 않는 일부 콘텐츠, 사용자의 기분이나 태도와 일치하지 않는 일부 콘텐츠, 사용자의 의사소통을 방해하는 일부 콘텐츠를 생성합니다. 또는 콘텐츠.

위험한 환각: 오해, 갈등, 분쟁, 부상 등을 일으키는 등 사용자와 시스템에 심각한 부정적인 영향을 미칩니다. 예를 들어, LLM은 사실이나 증거에 위배되는 일부 콘텐츠, 도덕이나 법률에 상충되는 일부 콘텐츠, 인권이나 존엄성과 상충되는 일부 콘텐츠, 안전이나 건강을 위협하는 일부 콘텐츠를 생성합니다.

2. LLM의 환각 원인 분석

LLM의 환각 문제를 더 잘 해결하려면 환각의 원인에 대한 심층적인 분석이 필요합니다. 위에서 언급한 환각의 출처에 따르면, 저자는 환각의 원인을 다음 세 가지로 분류합니다.

불충분하거나 과도한 매개변수 지식: 사전 훈련 단계에서 LLM은 일반적으로 언어 규칙과 지식을 학습하기 위해 레이블이 지정되지 않은 대량의 텍스트를 사용하여 매개변수 지식을 형성합니다. 그러나 이러한 종류의 지식에는 불완전하거나, 부정확하거나, 업데이트되지 않거나, 일관성이 없거나, 관련성이 없는 등 몇 가지 문제가 있을 수 있으며, 이로 인해 LLM은 텍스트를 생성할 때 입력 정보를 완전히 이해하고 활용할 수 없거나 올바르게 구별하고 활용하지 못할 수 있습니다. 출력 정보를 선택하여 환각을 생성합니다. 반면, 매개변수 지식은 너무 풍부하거나 강력하여 LLM이 텍스트를 생성할 때 자신의 지식에 지나치게 의존하거나 선호하는 동시에 입력 정보를 무시하거나 충돌하여 환각을 일으킬 수도 있습니다.

비모수적 지식의 부족 또는 오류: 미세 조정 또는 생성 단계에서 LLM은 일반적으로 외부 주석 데이터를 사용하여 언어 지식을 얻거나 보완하여 비모수적 지식을 형성합니다. 이러한 종류의 지식에는 희소성, 잡음, 오류, 불완전성, 불일치, 부적합성 등과 같은 몇 가지 문제가 있을 수 있으며, 이로 인해 LLM이 텍스트를 생성할 때 입력 정보를 효과적으로 검색 및 융합하거나 텍스트를 정확하게 확인하고 수정할 수 없게 됩니다. 정보를 출력하여 환각을 일으킨다. 비모수적 지식은 너무 복잡하거나 다양할 수 있으므로 LLM이 텍스트를 생성할 때 다양한 정보 소스의 균형을 맞추고 조정하거나 다양한 작업 요구 사항을 조정하고 충족하는 것이 어려워서 환상이 생길 수 있습니다.

부적절하거나 불충분한 생성 전략: LLM은 텍스트를 생성할 때 일반적으로 생성 프로세스와 결과를 제어하거나 최적화하기 위해 일부 기술이나 방법을 사용하여 생성 전략을 형성합니다. 이러한 전략에는 부적절함, 불충분함, 불안정함, 설명할 수 없음, 신뢰할 수 없음 등과 같은 몇 가지 문제가 있을 수 있으며, 이로 인해 LLM이 텍스트를 생성할 때 생성 방향과 품질을 효과적으로 규제하고 안내할 수 없거나 발견하고 수정할 수 없게 됩니다. 적시에 오류가 발생하여 환각이 발생했습니다. 생성 전략은 너무 복잡하거나 변경 가능하여 LLM이 텍스트를 생성할 때 생성의 일관성과 신뢰성을 유지하고 보장하기 어렵게 만들거나 생성 효과에 대한 평가 및 피드백을 제공하기 어려워 환각을 일으킬 수 있습니다.

3. LLM의 환각 탐지 방법 및 평가 기준

LLM의 환각 문제를 더 잘 해결하려면 LLM에서 발생하는 환각을 효과적으로 탐지하고 평가해야 합니다. 위에서 제안한 환각 유형에 따라 저자는 환각 감지 방법을 다음 네 가지 범주로 나눕니다.

문법적 환각 감지 방법: 일부 문법 검사 도구 또는 규칙을 사용하여 LLM에서 생성된 텍스트의 문법 오류를 식별하고 수정합니다. 아니면 불규칙합니다. 예를 들어, 철자 확인, 구두점 확인, 단어 순서 확인, 시제 확인, 주어-동사 일치 확인 등과 같은 일부 도구나 규칙을 사용하여 LLM에서 생성된 텍스트에서 문법적 환상을 감지하고 수정할 수 있습니다.

의미적 환각 탐지 방법: 의미론적 분석 도구나 모델을 사용하여 LLM에서 생성된 텍스트의 의미론적 오류나 비합리성을 이해하고 평가합니다. 예를 들어, 단어 의미 분석, 참조 해결, 논리적 추론, 모호성 제거 및 모순 감지와 같은 일부 도구 또는 모델을 사용하여 LLM에서 생성된 텍스트에서 의미론적 환상을 감지하고 수정할 수 있습니다.

지식 환상 감지 방법: 일부 지식 검색 또는 검증 도구나 모델을 사용하여 LLM에서 생성된 텍스트의 지식 오류나 불일치를 얻고 비교합니다. 예를 들어, 지식 그래프, 검색 엔진, 사실 확인, 증거 확인, 인용 확인 등과 같은 일부 도구 또는 모델을 사용하여 LLM에서 생성된 텍스트에서 지식 착각을 감지하고 수정할 수 있습니다.

창작 환상 감지 방법: 일부 창작 평가 또는 피드백 도구나 모델을 사용하여 LLM에서 생성된 텍스트의 생성 오류나 부적절성을 감지하고 평가합니다. 예를 들어, 스타일 분석, 감성 분석, 창작 평가, 의견 분석, 목표 분석 등과 같은 일부 도구나 모델을 사용하여 LLM에서 생성된 텍스트에서 창작 환상을 감지하고 수정할 수 있습니다.

위에 언급된 환각의 정도와 영향에 따라 환각의 평가 기준을 다음 네 가지 범주로 나눌 수 있습니다.

문법 정확성: LLM에서 생성된 텍스트가 문법적으로 일치하는지 여부를 나타냅니다. 철자법, 구두점, 어순, 시제, 주어-동사 일치 등과 같은 언어 규칙 및 습관. 이 표준은 BLEU, ROUGE, BERTScore 등과 같은 일부 자동 또는 수동 문법 검사 도구 또는 방법을 통해 평가할 수 있습니다.

의미적 합리성: LLM에서 생성된 텍스트가 단어 의미, 참조, 논리, 모호성, 모순 등 언어의 의미 및 논리와 의미상 일치하는지 여부를 나타냅니다. 이 표준은 METEOR, MoverScore, BERTScore 등과 같은 일부 자동 또는 수동 의미 분석 도구 또는 방법을 통해 평가할 수 있습니다.

지식 일관성: LLM에서 생성된 텍스트가 실제 사실이나 증거와 지적으로 일치하는지 여부, 또는 사실, 증거, 참고 자료, 일치 등과 같은 입력 또는 상황 정보와 일치하는지 여부를 나타냅니다. 이 표준은 FEVER, FactCC, BARTScore 등과 같은 일부 자동 또는 수동 지식 검색 또는 검증 도구나 방법을 통해 평가할 수 있습니다.

창의적 적절성: LLM에서 생성된 텍스트가 작업이나 목표의 요구 사항을 창의적으로 충족하는지, 사용자의 선호도나 기대와 일치하는지, 사용자의 감정이나 태도와 조화를 이루는지 또는 다음과 같은지 여부를 나타냅니다. 사용자의 감정이나 태도 스타일, 감정, 의견, 목표 등 사용자의 의사소통이나 상호작용이 도움이 되는지 여부. 이 표준은 BLEURT, BARTScore, SARI 등과 같은 자동 또는 수동 생성 평가나 피드백 도구 또는 방법을 통해 평가할 수 있습니다.

4. LLM의 환각을 완화하는 방법

LLM의 환각 문제를 더 잘 해결하려면 LLM에서 발생하는 환각을 효과적으로 완화하고 줄여야 합니다. 다양한 수준과 각도에 따라 저자는 환각 완화 방법을 다음 범주로 나눕니다.

Post- Generation Refinement

Post-Generation Refinement은 LLM이 텍스트를 생성한 후 텍스트를 수정하는 것입니다. 환상을 없애거나 줄이기 위해. 이러한 유형의 방법의 장점은 LLM의 재교육이나 조정이 필요하지 않으며 모든 LLM에 직접 적용할 수 있다는 것입니다. 이러한 접근 방식의 단점은 환상이 완전히 제거되지 않거나, 새로운 환상이 도입되거나, 원본 텍스트의 정보나 창의성이 일부 손실될 수 있다는 것입니다. 이러한 유형의 방법의 대표자는 다음과 같습니다.

RARR(Refinement with Attribution and Retrieved References): (Chrysostomou and Aletras, 2021)은 LLM Fidelity에서 생성된 텍스트를 개선하기 위해 귀속 및 검색을 기반으로 한 개선 방법을 제안했습니다. 속성 모델은 LLM에서 생성된 텍스트의 각 단어가 입력 정보, LLM의 매개변수 지식 또는 LLM의 생성 전략에서 나온 것인지 식별하는 데 사용됩니다. 검색 모델을 사용하여 외부 지식 소스에서 입력 정보와 관련된 일부 참조 텍스트를 검색합니다. 마지막으로, 입력 정보와의 일관성과 신뢰성을 향상시키기 위해 속성 결과 및 검색 결과를 기반으로 LLM에서 생성된 텍스트를 수정하는 데 정제 모델이 사용됩니다.

HEWSR(고엔트로피 단어 발견 및 대체): (Zhang et al., 2021)은 LLM에서 생성된 텍스트의 환각을 줄이기 위한 엔트로피 기반 개선 방법을 제안했습니다. 첫째, 엔트로피 계산 모델은 LLM에 의해 생성된 텍스트에서 엔트로피가 높은 단어, 즉 생성 시 불확실성이 높은 단어를 식별하는 데 사용됩니다. 그런 다음 대체 모델을 사용하여 입력 정보 또는 외부 지식 소스에서 보다 적절한 단어를 선택하여 엔트로피가 높은 단어를 대체합니다. 마지막으로, 문법적, 의미적 일관성을 유지하기 위해 대체된 텍스트를 일부 조정하는 데 평활화 모델이 사용됩니다.

ChatProtect(자기 모순 탐지를 통한 채팅 보호): (Wang et al., 2021)은 LLM에서 생성된 채팅 대화의 보안을 향상하기 위해 자기 모순 탐지를 기반으로 하는 세련된 방법을 제안했습니다. 첫째, 모순 탐지 모델은 LLM에 의해 생성된 대화에서 자기 모순, 즉 이전 대화 내용과 충돌하는 내용을 식별하는 데 사용됩니다. 그런 다음 대체 모델을 사용하여 자기모순적인 답변을 미리 정의된 안전한 답변 중 보다 적절한 답변으로 대체합니다. 마지막으로 평가 모델을 사용하여 교체된 대화에 몇 가지 점수를 부여하여 안전성과 유창성을 측정합니다.

피드백과 추론을 통한 자기 개선

피드백과 추론을 통한 자기 개선은 환각을 제거하거나 줄이기 위해 LLM이 텍스트를 생성하는 과정에서 텍스트를 일부 평가하고 조정하는 것입니다. 이러한 유형의 방법의 장점은 실시간으로 환각을 모니터링하고 수정할 수 있으며 LLM의 자체 학습 및 자체 조절 기능을 향상시킬 수 있다는 것입니다. 이러한 유형의 접근 방식의 단점은 LLM에 대한 추가 교육이나 조정이 필요하거나 일부 외부 정보나 리소스가 필요할 수 있다는 것입니다. 이러한 유형의 방법의 대표적인 예는 다음과 같습니다.

자기 성찰 방법론(SRM): (Iyer et al., 2021)은 LLM에서 생성된 의학적 질문과 답변의 신뢰성을 높이기 위해 자기 피드백을 기반으로 한 완벽한 방법을 제안했습니다. 이 방법은 먼저 생성 모델을 사용하여 입력 질문과 컨텍스트를 기반으로 초기 답변을 생성합니다. 피드백 모델은 입력 질문과 맥락을 기반으로 피드백 질문을 생성하는 데 사용되며, 이는 초기 답변에서 잠재적인 환각을 감지하는 데 사용됩니다. 그런 다음 답변 모델을 사용하여 피드백 질문을 기반으로 답변을 생성하여 초기 답변의 정확성을 확인합니다. 마지막으로, 답변 결과를 바탕으로 초기 답변을 수정하는 수정 모델을 사용하여 신뢰도와 정확성을 향상시켰습니다.

구조적 비교(SC) 추론: (Yan et al., 2021)은 LLM에서 생성된 텍스트 선호도 예측의 일관성을 향상시키기 위해 구조적 비교를 기반으로 한 추론 방법을 제안했습니다. 이 방법은 생성 모델을 사용하여 입력 텍스트 쌍을 기반으로 구조화된 비교를 생성합니다. 즉, 텍스트 쌍을 다양한 측면에서 비교하고 평가합니다. 추론 모델을 사용하여 구조화된 비교, 즉 어떤 텍스트 쌍이 선호되는지를 기반으로 텍스트 선호도 예측을 생성합니다. 평가 모델을 사용하여 예측 결과에 대해 생성된 비교를 평가하여 일관성과 신뢰성을 향상시킵니다.

TWEAK(Think While Effectively Articulate Knowledge): (Qiu et al., 2021a)는 LLM에서 생성된 지식의 텍스트 충실도를 향상시키기 위해 가설 검증을 기반으로 한 추론 방법을 제안합니다. 이 방법은 생성 모델을 사용하여 입력 지식을 기반으로 초기 텍스트를 생성합니다. 그런 다음 가설 모델을 사용하여 초기 텍스트를 기반으로 몇 가지 가설을 생성합니다. 즉, 다양한 측면에서 텍스트의 미래 텍스트를 예측합니다. 그런 다음 검증 모델을 사용하여 입력된 지식을 기반으로 각 가설의 정확성을 검증합니다. 마지막으로 검증 결과를 바탕으로 초기 텍스트를 조정하는 조정 모델을 사용하여 입력 지식과의 일관성 및 신뢰성을 향상시킵니다.

새로운 디코딩 전략

새로운 디코딩 전략은 LLM이 텍스트를 생성하는 과정에서 텍스트의 확률 분포를 일부 변경하거나 최적화하여 환상을 제거하거나 줄이는 것입니다. 이러한 유형의 방법의 장점은 생성된 결과에 직접적인 영향을 미칠 수 있고 LLM의 유연성과 효율성을 향상시킬 수 있다는 것입니다. 이러한 유형의 접근 방식의 단점은 LLM에 대한 추가 교육이나 조정이 필요하거나 일부 외부 정보나 리소스가 필요할 수 있다는 것입니다. 이러한 유형의 방법의 대표자는 다음과 같습니다.

컨텍스트 인식 디코딩(CAD): (Shi et al., 2021)은 LLM에서 생성된 텍스트의 지식 충돌을 줄이기 위한 대비 기반 디코딩 전략을 제안했습니다. 이 전략은 대조 모델을 사용하여 입력 정보를 사용할 때와 사용하지 않을 때 LLM 출력의 확률 분포 차이를 계산합니다. 그런 다음 증폭 모델을 사용하여 이 차이를 증폭시켜 입력 정보와 일치하는 출력 확률이 높아지고 입력 정보와 충돌하는 출력 확률이 낮아지도록 합니다. 마지막으로 생성 모델을 사용하여 증폭된 확률 분포를 기반으로 텍스트를 생성하여 입력 정보와의 일관성과 신뢰성을 향상시킵니다.

DoLa(Contrasting Layers)에 의한 디코딩: (Chuang et al., 2021)은 LLM에서 생성된 텍스트의 지식 환상을 줄이기 위한 레이어 대비 기반 디코딩 전략을 제안했습니다. 첫째, 레이어 선택 모델은 LLM의 특정 레이어를 지식 레이어, 즉 더 많은 사실 지식을 포함하는 레이어로 선택하는 데 사용됩니다. 그런 다음 레이어 대비 모델을 사용하여 지식 레이어와 어휘 공간의 다른 레이어 간의 로그 차이를 계산합니다. 마지막으로 생성 모델을 사용하여 레이어 비교 후 확률 분포를 기반으로 텍스트를 생성하여 사실 지식과의 일관성과 신뢰성을 향상시킵니다.

지식 그래프 활용

지식 그래프 활용은 LLM이 텍스트를 생성하는 과정에서 입력 정보와 관련된 일부 지식을 제공하거나 보완하기 위해 구조화된 지식 그래프를 사용하여 환각을 제거하거나 줄이는 것입니다. 이러한 유형의 방법의 장점은 외부 지식을 효과적으로 획득하고 통합할 수 있으며 LLM의 지식 범위와 지식 일관성을 향상시킬 수 있다는 것입니다. 이러한 유형의 접근 방식의 단점은 LLM에 대한 추가 교육이나 조정이 필요하거나 일부 고품질 지식 그래프가 필요할 수 있다는 것입니다. 이러한 유형의 방법의 대표자는 다음과 같습니다.

RHO(지식 그래프의 연결된 엔터티 및 관계 술어 표현): (Ji et al., 2021a)는 LLM에서 생성된 대화를 개선하기 위해 지식 그래프를 기반으로 한 표현 방법을 제안했습니다. 응답의 충실도. 먼저, 지식 검색 모델을 사용하여 지식 그래프, 즉 일부 엔터티와 관계를 포함하는 그래프에서 입력 대화와 관련된 일부 하위 그래프를 검색합니다. 그런 다음 지식 인코딩 모델을 사용하여 하위 그래프의 엔터티와 관계를 인코딩하여 벡터 표현을 얻습니다. 그런 다음 지식 융합 모델을 사용하여 지식의 벡터 표현을 대화의 벡터 표현으로 융합하여 향상된 대화 표현을 얻습니다. 마지막으로 향상된 대화 표현을 기반으로 충실한 대화 응답을 생성하기 위해 지식 생성 모델을 사용합니다.

FLEEK(Factual Error detector and Correction with Evidence Retrieved from external Knowledge): (Bayat et al., 2021)은 LLM에서 생성된 텍스트의 사실성을 향상하기 위해 지식 그래프를 기반으로 한 검증 및 수정 방법을 제안했습니다. 이 방법은 먼저 사실 인식 모델을 사용하여 LLM에서 생성된 텍스트에서 잠재적으로 검증 가능한 사실, 즉 지식 그래프에서 증거를 찾을 수 있는 사실을 식별합니다. 그런 다음 질문 생성 모델을 사용하여 지식 그래프를 쿼리하기 위한 각 사실에 대한 질문을 생성합니다. 그런 다음 지식 검색 모델을 사용하여 지식 그래프에서 문제와 관련된 일부 증거를 검색합니다. 마지막으로, 사실 확인 및 수정 모델을 사용하여 증거를 기반으로 LLM이 생성한 텍스트의 사실을 확인하고 수정하여 사실성과 정확성을 향상시킵니다.

Faithfulness-based Loss Function

Faithfulness-based loss function은 LLM의 훈련이나 미세 조정 중에 생성된 텍스트와 입력 정보 또는 실제 레이블 사이의 측정값을 사용하는 것입니다. 환상을 제거하거나 줄이기 위한 손실 함수. 이러한 유형의 방법의 장점은 LLM의 매개변수 최적화에 직접적인 영향을 주고 LLM의 충실도와 정확성을 향상시킬 수 있다는 것입니다. 이러한 유형의 접근 방식의 단점은 LLM에 대한 추가 교육이나 조정이 필요하거나 주석이 달린 고품질 데이터가 필요할 수 있다는 것입니다. 이러한 유형의 방법의 대표자는 다음과 같습니다.

텍스트 환각 완화(THAM) 프레임워크: (Yoon et al., 2022)는 LLM에서 생성된 영상 대화에서 환각을 줄이기 위해 정보 이론에 기반한 손실 함수를 제안했습니다. 먼저, 대화의 확률 분포를 계산하기 위해 대화 언어 모델을 사용한다. 그런 다음 환각 언어 모델을 사용하여 환각의 확률 분포, 즉 입력 영상에서 얻을 수 없는 정보의 확률 분포를 계산합니다. 그리고 상호정보모델을 이용하여 대화와 환상 사이의 상호정보, 즉 대화에 담긴 환상의 정도에 대한 상호정보를 계산한다. 마지막으로 대화의 교차 엔트로피와 실제 레이블, 즉 대화의 정확도를 계산하기 위해 교차 엔트로피 모델을 사용합니다. 이 손실 함수의 목표는 상호 정보와 교차 엔트로피의 합을 최소화하여 대화의 환상과 오류를 줄이는 것입니다.

외부 지식에서 검색된 증거를 사용한 사실 오류 수정(FECK): (Ji et al., 2021b)은 LLM에서 생성된 텍스트의 사실성을 향상하기 위해 지식 증거를 기반으로 한 손실 함수를 제안했습니다. 먼저, 지식 검색 모델을 사용하여 지식 그래프, 즉 일부 엔터티와 관계를 포함하는 그래프에서 입력 텍스트와 관련된 일부 하위 그래프를 검색합니다. 그런 다음 지식 인코딩 모델을 사용하여 하위 그래프의 엔터티와 관계를 인코딩하여 벡터 표현을 얻습니다. 그런 다음 지식 정렬 모델을 사용하여 LLM에서 생성된 텍스트의 엔터티 및 관계를 지식 그래프의 엔터티 및 관계와 정렬하여 일치 정도를 얻습니다. 마지막으로 손실 함수는 지식 손실 모델을 사용하여 LLM이 생성한 텍스트의 개체 및 관계와 지식 그래프의 개체 및 관계 간의 거리, 즉 사실과의 편차를 계산합니다. 이 손실 함수의 목표는 지식 손실을 최소화하여 LLM에서 생성된 텍스트의 사실성과 정확성을 높이는 것입니다.

신속 조정

신속 조정은 환각을 제거하거나 줄이기 위해 LLM의 생성 동작을 제어하거나 안내하기 위해 특정 텍스트나 기호를 입력의 일부로 사용하는 프로세스입니다. 이러한 유형의 방법의 장점은 LLM의 매개변수 지식을 효과적으로 조정하고 안내할 수 있으며 LLM의 적응성과 유연성을 향상시킬 수 있다는 것입니다. 이러한 유형의 접근 방식의 단점은 LLM에 대한 추가 교육이나 조정이 필요하거나 고품질 프롬프트가 필요할 수 있다는 것입니다. 이러한 유형의 방법의 대표자는 다음과 같습니다.

UPRISE(Universal Prompt-based Refinement for Improving Semantic Equivalence): (Chen et al., 2021)는 생성된 텍스트의 의미를 개선하기 위해 범용 프롬프트를 기반으로 하는 미세 조정 방법을 제안했습니다. LLM 동등성 기준. 첫째, 프롬프트 생성 모델은 입력 텍스트, 즉 LLM이 의미상 동일한 텍스트를 생성하도록 안내하는 데 사용되는 일부 텍스트 또는 기호를 기반으로 일반 프롬프트를 생성하는 데 사용됩니다. 그런 다음 힌트 미세 조정 모델을 사용하여 입력 텍스트와 힌트를 기반으로 LLM의 매개 변수를 미세 조정함으로써 입력 텍스트와 의미상 동일한 텍스트를 생성하는 경향이 높아집니다. 마지막으로 이 방법은 힌트 생성 모델을 사용하여 미세 조정된 LLM의 매개변수를 기반으로 의미상 동일한 텍스트를 생성합니다.

SynTra(추상적 요약에서 환각 완화를 위한 합성 작업): (Wang et al., 2021)은 LLM에서 생성된 요약에서 환각을 줄이기 위한 합성 작업 기반 미세 조정 방법을 제안했습니다. 먼저, 입력된 텍스트를 기반으로 합성 작업, 즉 요약에서 환각을 탐지하는 문제를 생성하기 위해 합성 작업 생성 모델을 사용합니다. 그런 다음 합성 작업 미세 조정 모델을 사용하여 입력 텍스트 및 작업을 기반으로 LLM의 매개 변수를 미세 조정하여 입력 텍스트와 일치하는 요약을 생성하는 경향이 더 커집니다. 마지막으로, 미세 조정된 LLM의 매개변수를 기반으로 일관된 요약을 생성하기 위해 합성 작업 생성 모델이 사용됩니다.

5. LLM의 환각에 대한 과제와 한계

LLM의 환각 완화 기술이 어느 정도 발전했지만 여전히 추가 연구와 탐구가 필요한 몇 가지 과제와 한계가 있습니다. 다음은 몇 가지 주요 과제와 한계입니다.

환각의 정의 및 측정: 통일되고 명확한 정의와 측정이 없으면 여러 연구에서 서로 다른 표준과 측정항목을 사용하여 LLM 환각으로 생성된 텍스트를 판단하고 평가할 수 있습니다. 이로 인해 일관되지 않고 비교할 수 없는 결과가 발생하며 LLM의 환각 문제를 이해하고 해결하는 데에도 영향을 미칩니다. 따라서 LLM에서 환각을 효과적으로 감지하고 평가할 수 있도록 환각에 대한 일반적이고 신뢰할 수 있는 정의와 측정을 확립할 필요가 있습니다.

환각에 대한 데이터 및 리소스: LLM의 환각 연구 및 개발을 지원하는 고품질의 대규모 데이터 및 리소스가 부족합니다. 예를 들어, LLM에서 환각 감지 및 완화 방법을 훈련하고 테스트하기 위한 환각 주석이 포함된 일부 데이터 세트가 부족합니다. LLM에서 생성된 텍스트의 지식을 제공하고 검증하기 위한 실제 사실과 증거가 포함된 일부 지식 소스가 부족합니다. ; LLM에서 생성된 환각을 포함하는 일부 지식 소스가 부족합니다. LLM에서 생성된 텍스트에서 환각의 영향을 수집하고 분석하기 위한 사용자 피드백 및 리뷰용 플랫폼입니다. 따라서 LLM의 환각에 대한 효과적인 연구 및 개발을 촉진하려면 일부 고품질의 대규모 데이터와 리소스를 구축해야 합니다.

환각의 원인과 메커니즘: LLM이 환각을 생성하는 이유와 LLM에서 환각이 어떻게 형성되고 전파되는지 밝히고 설명하는 원인과 메커니즘에 대한 심층적이고 포괄적인 분석은 없습니다. 예를 들어, LLM의 매개변수적 지식, 비모수적 지식 및 생성 전략이 어떻게 서로 영향을 주고 상호 작용하는지, 그리고 이들이 어떻게 다양한 유형, 정도 및 효과의 환상을 불러일으키는지 불분명합니다. 따라서 LLM에서 환각을 효과적으로 예방하고 통제하려면 원인과 메커니즘에 대한 심층적이고 포괄적인 분석이 필요합니다.

환각의 해결 및 최적화: LLM에서 생성된 텍스트의 환각을 제거하거나 줄이고 LLM에서 생성된 텍스트의 품질과 효과를 향상시킬 수 있는 완벽하고 보편적인 솔루션 및 최적화 솔루션은 없습니다. 예를 들어, 일반화 능력과 창의성을 잃지 않으면서 LLM의 충실도와 정확성을 향상시키는 방법이 불분명합니다. 따라서 LLM에서 생성된 텍스트의 품질과 효과를 향상시키려면 일부 완전하고 보편적인 솔루션과 최적화 솔루션을 설계해야 합니다.

위 내용은 대규모 기계 학습의 환각 완화 기술에 대한 종합적인 연구의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!