Open Interpreter: 대규모 언어 모델이 로컬에서 코드를 실행할 수 있게 해주는 오픈 소스 도구

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-09-27 10:21:131055검색

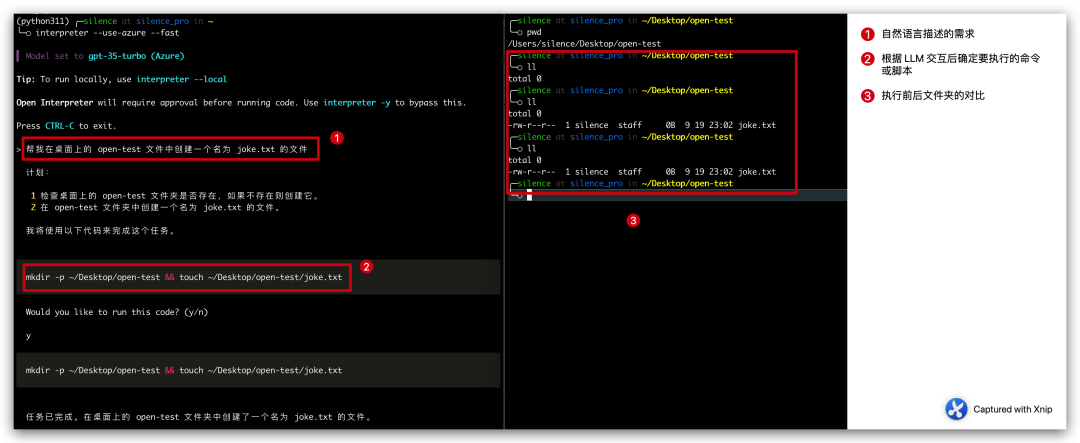

최근 Github을 검색하다가 Open Interpreter라는 아티팩트를 발견했는데, 이는 주로 대규모 언어 모델과 상호 작용하는 데 사용됩니다. 대규모 언어 모델을 통해 자연어를 스크립트 코드로 변환한 다음 이를 로컬에서 실행합니다.

간단히 말하면, 데스크톱에 joke.txt라는 파일을 생성하려는 경우 수동으로 생성할 필요가 없습니다. 대신 Open Interpreter에 자연어를 통해 알려주고 생성할 스크립트를 생성하는 데 도움을 줄 수 있습니다. 그런 다음 로컬에서 실행하여 joke.txt 파일을 생성합니다

우리가 해야 할 일은 필요한 것이 무엇인지 알려주고 코드를 로컬에서 실행할 수 있도록 허용하는 것뿐입니다.

원래 의미를 바꾸지 말고 내용을 중국어로 다시 작성해주세요. 원문이 나올 필요는 없습니다

picture

picture

위 사례의 전체 과정은 세 단계로 나누어집니다.

- 요구사항을 자연어를 통해 설명합니다. txt 파일

- Open Interpreter는 우리의 요구 사항을 분석하고 실행할 실행 계획과 명령을 나열합니다.

计划: 1 检查桌面上的 open-test 文件夹是否存在,如果不存在则创建它。 2 在 open-test 文件夹中创建一个名为 joke.txt 的文件。我将使用以下代码来完成这个任务。mkdir -p ~/Desktop/open-test && touch ~/Desktop/open-test/joke.txt

- 가 수동 확인 후 실행되었으며, 마침내 파일이 성공적으로 생성되었습니다.

이 프로젝트는 이제 막 시작했고 이번 사례도 매우 간단하지만 앞으로는 코드를 통해 달성할 수 있는 기능만 구현하면 또 다른 문이 열리는 것 같다는 점을 알아야 합니다. 생각만 해도 흥미로웠고 무서웠어요.

공식 소개: 이 도구는 비디오를 편집하고 이메일을 보내는 데 사용할 수 있으며 이는 매우 유망하다고 말할 수 있습니다.

설치 및 구성

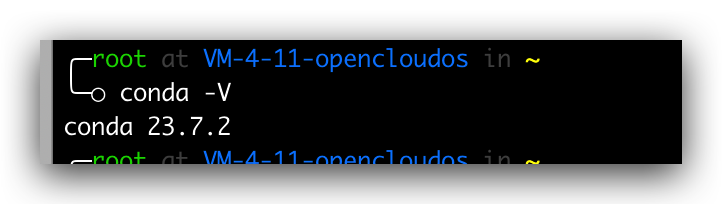

Conda 설치

이 프로젝트 설치는 매우 간단합니다. 일반적으로 명령줄에서 pip install open-interpreter만 실행하면 됩니다. 그러나 환경의 안정성을 보장하기 위해 환경 격리를 위해 conda를 사용할 예정입니다. 따라서 먼저 conda를 설치하고 다음 명령을 순서대로 실행해야 합니다.

# 获取脚本wget https://repo.anaconda.com/archive/Anaconda3-2023.07-2-Linux-x86_64.sh# 增加可执行权限chmod +x Anaconda3-2023.07-2-Linux-x86_64.sh# 运行安装脚本./Anaconda3-2023.07-2-Linux-x86_64.sh# 查询版本conda -V

버전 번호가 정상적으로 출력되면 프롬프트 명령이 존재하지 않으면 설치가 성공한 것입니다. 환경 변수를 구성해야 합니다. , in

vim .bash_profile# 加入下面一行PATH=$PATH:$HOME/bin:$NODE_PATH/bin:/root/anaconda3/bin# 再次执行conda -V

그림

그림

격리 환경 만들기

conda 설치가 완료된 후 다음 명령

conda create -n python311 pythnotallow=3.11

을 통해 지정된 Python 버전에 대한 격리 환경을 만듭니다. Isolation Python 버전은 3.11로 지정되어 있으며, 생성이 완료되면 다음 명령어를 통해 격리 환경 목록을 조회할 수 있습니다.

conda env list

Pictures

Pictures

Install open-interpreter

그런 다음 격리 환경에 들어가서 명령은 다음과 같습니다

conda activate python311pip install open-interpreter

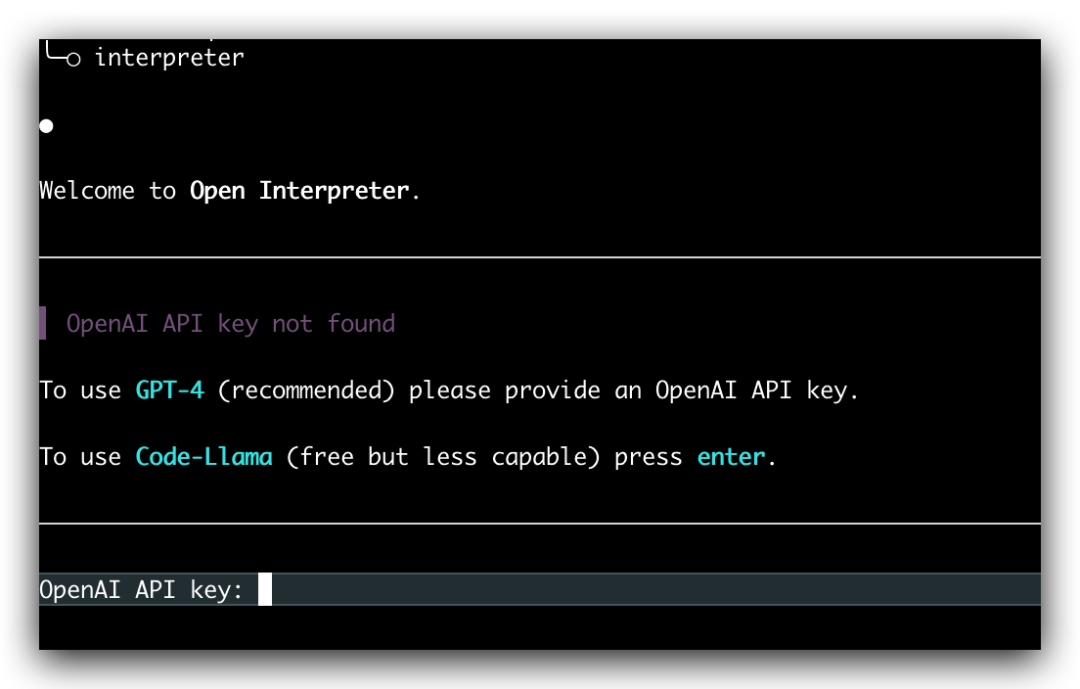

잠시 기다리면 설치가 성공합니다. 설치가 성공적으로 완료되면 다음 명령을 입력하면 로컬 대형 언어 모델 상호 작용을 시작할 수 있습니다.

interpreter

Picture

Picture

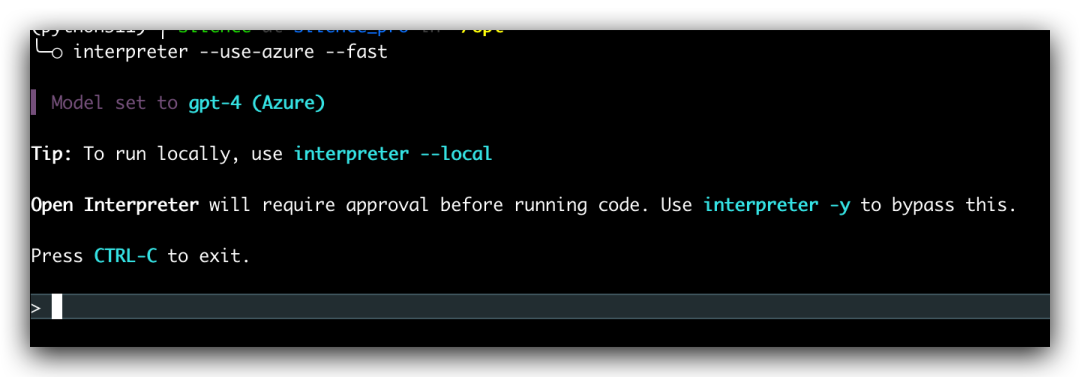

원래 의미를 변경할 필요는 없으며 다시 작성해야 하는 내용은 다음과 같습니다. "interpreter" 명령을 직접 입력하면 자체 OpenAI API 키를 입력하라는 메시지가 표시됩니다. 이때는 기본적으로 GPT-4 모델이 사용되지만 "--fast" 매개변수를 추가하면 GPT-3.5 모델을 사용할 수 있습니다

interpreter --fast

여기서는 OpenAI API 키를 매번 수동으로 입력해야 합니다. 번거롭지만, 후속 실행을 위해 OpenAI의 API 키를 수동으로 입력할 필요가 없도록 환경 변수

export OPENAI_API_KEY=skxxxx

를 설정하면 됩니다. Microsoft의 Azure OpenAI를 사용하려는 경우에도 지원됩니다. 다음 환경 변수를 구성한 다음 시작 시 --use를 추가하면 됩니다. -azure 매개변수이면 충분합니다

export AZURE_API_KEY=export AZURE_API_BASE=export AZURE_API_VERSION=export AZURE_DEPLOYMENT_NAME=

interpreter --use-azure

pictures

pictures

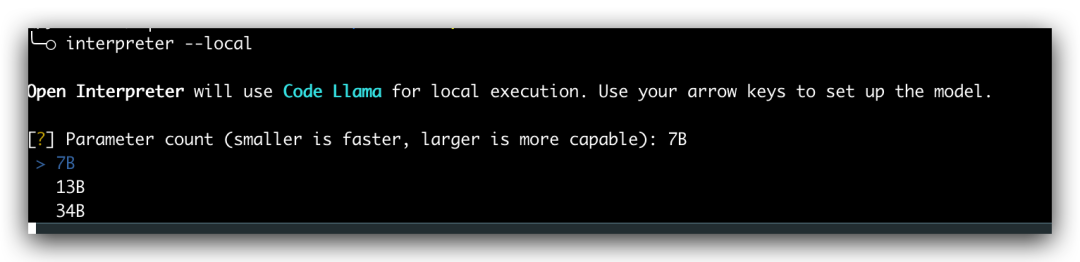

Local launch

모든 작업에는 해당 OpenAI API 키 또는 OpenAI 엔드포인트가 필요합니다. Azure의. 실제로 Open Interpreter는 로컬 실행도 지원합니다. 시작 시 --local 매개변수를 추가한 다음 해당 모델을 선택하기만 하면 됩니다. 그러나 로컬 작업에는 컴퓨터 구성 지원이 필요합니다. 관심있는 친구들은 공식 문서를 참고해서 연습하면 되지만 제 구성으로는 불가능해요

Pictures

Pictures

Summary

오늘은 Open Interpreter의 설치방법과 간단한 게임방법을 소개해 드렸습니다. 이 프로젝트는 현재 급속도로 반복되고 있으며 가까운 미래에 혁명을 가져올 것이라고 믿습니다. 이제 본격적으로 인공지능 시대가 도래했으며, 앞으로 몇 년은 인공지능 제품의 활발한 개발이 이루어지는 시기가 될 것입니다. 프로그래머로서 우리는 시대의 흐름에 발맞춰 뒤처지지 않아야 합니다

위 내용은 Open Interpreter: 대규모 언어 모델이 로컬에서 코드를 실행할 수 있게 해주는 오픈 소스 도구의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!