Amazon은 클라우드 지위를 지키기 위해 노력하고 자체 개발한 AI 칩을 업그레이드하며 채팅 로봇 Q를 출시하고 Nvidia의 차세대 슈퍼 칩을 최초로 사용합니다.

- 王林앞으로

- 2023-11-29 08:37:481265검색

Amazon은 클라우드 컴퓨팅 분야의 리더십을 방어하기 위해 모든 노력을 기울이고 있습니다. 한편으로는 자체 클라우드 칩을 업그레이드하고 인공 지능 챗봇인 Amazon 버전의 GPT를 출시했으며, 다른 한편으로는 NVIDIA와의 협력을 심화하고 NVIDIA 칩을 기반으로 한 새로운 서비스를 출시했으며 NVIDIA와 공동 개발했습니다. 슈퍼컴퓨터

AWS 부사장 데이브 브라운(Dave Brown)은 AWS가 고객에게 중요한 실제 워크로드에 자체 개발 칩 설계에 집중함으로써 고객에게 가장 발전된 클라우드 인프라를 제공할 수 있다고 말했습니다. 이번에 출시된 Graviton 4는 생성 AI에 대한 사람들의 관심이 높아짐에 따라 5년 내에 출시되는 4세대 칩 제품으로, 2세대 AI 칩 Trainium 2는 고객이 더 저렴한 비용과 더 높은 에너지 효율성으로 스스로 훈련할 수 있도록 도와줄 것입니다.

Graviton4 컴퓨팅 성능은 이전 세대에 비해 최대 30% 향상되었습니다.

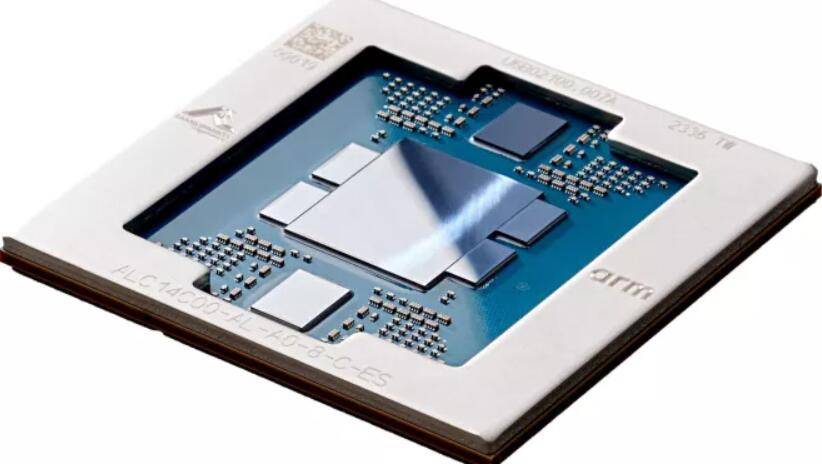

동부 표준시 기준 11월 28일 화요일, Amazon의 클라우드 컴퓨팅 사업부인 AWS는 차세대 AWS 자체 개발 칩 출시를 발표했습니다. 이 중 범용 칩 Graviton4의 컴퓨팅 성능은 이전 세대 Graviton3보다 최대 30% 향상되었으며, 코어는 50%, 메모리 대역폭은 75% 증가하여 최고의 가성비와 성능을 제공합니다. Amazon 클라우드 서버 호스팅 서비스 Amazon Elastic Compute Cloud(EC2)의 에너지 활용 효과.

Graviton4는 모든 고속 물리적 하드웨어 인터페이스를 완전히 암호화하여 보안을 향상시킵니다. AWS는 Graviton4를 메모리 최적화 Amazon EC2 R8g 인스턴스에서 사용할 수 있어 고객이 고성능 데이터베이스, 인 메모리 캐시 및 빅 데이터 분석 워크로드의 실행을 개선하는 데 도움이 될 것이라고 밝혔습니다. R8g 인스턴스는 이전 세대 R7g 인스턴스보다 최대 3배 더 많은 vCPU와 3배 더 많은 메모리를 갖춘 더 큰 인스턴스 크기를 제공합니다

앞으로 몇 달 안에 Graitons4가 탑재된 컴퓨터를 출시할 계획입니다. AWS에서는 Garviton 프로젝트가 시작된 이후 5년 동안 2백만 개 이상의 Garviton 프로세서가 생산되었으며 AWS EC2의 첫 100명의 사용자가 Graviton 사용을 선택했다고 밝혔습니다

Trainium2는 4배 더 빠르며 수조 개의 매개변수로 모델을 훈련할 수 있습니다

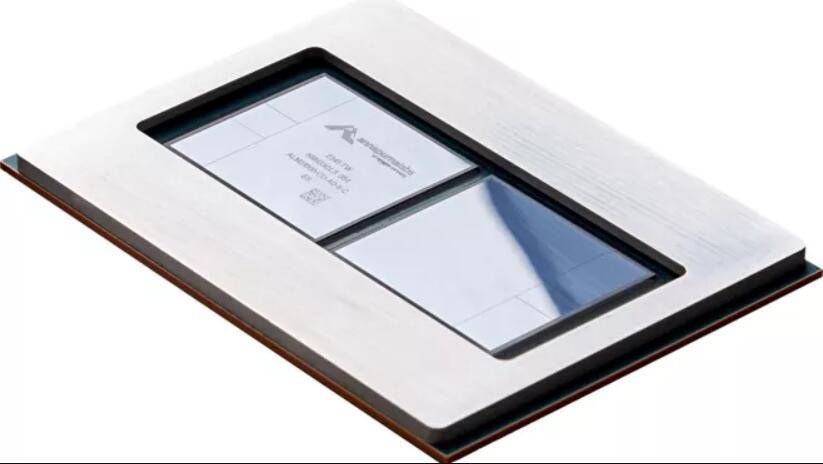

AWS는 이전 세대 Trainium1보다 4배 빠른 Trainium2라는 차세대 AI 칩을 출시했습니다. Trainium2는 EC2 UltraCluster에 최대 100,000개의 칩을 배포할 수 있어 사용자가 짧은 시간에 수조 개의 매개변수를 사용하여 기본 모델(PM) 및 대규모 언어 모델(LLM)을 교육할 수 있습니다. 이전 세대에 비해 Trainium2의 에너지 활용도는 2배 증가했습니다

Trainium2는 각각 16개의 Trainium 칩이 포함된 Amazon EC2 Trn2 인스턴스에서 사용됩니다. Trn2 인스턴스는 고객이 차세대 EC2 UltraCluster의 칩 애플리케이션 수를 최대 100,000개의 Trainium2 칩으로 확장하고 AWS EFA(Elastic Fabrication Adapters)를 통한 페타바이트 규모의 네트워크 연결을 통해 최대 65 Exach의 컴퓨팅 성능을 제공할 수 있도록 설계되었습니다.

AWS에 따르면 Trainium2는 내년부터 새로운 서비스를 지원하는 데 사용될 예정입니다

첫 번째 주요 고객인 DGX Cloud는 Grace Hopper GH200 NVL32의 업그레이드 버전을 사용합니다. 이 GPU는 가장 빠른 AI 슈퍼컴퓨터를 구동합니다

연례 컨퍼런스 re:Invent에서 AWS와 NVIDIA는 고객의 생성적 AI 혁신을 촉진하기 위해 최첨단 인프라, 소프트웨어 및 서비스를 제공하기 위한 확대된 전략적 협력을 화요일에 발표했습니다. 이번 협력에는 자체 개발한 칩뿐만 아니라 다른 분야의 협력도 포함됩니다

AWS는 클라우드에서 새로운 다중 노드 NVLink 기술 NVIDIA H200 Grace Hopper 슈퍼 칩을 사용하는 최초의 클라우드 서비스 제공업체가 될 것입니다. 즉, AWS는 Grace Hopper 업그레이드 버전의 첫 번째 중요한 고객이 될 것입니다.

NVIDIA의 H200 NVL32 다중 노드 플랫폼은 NVLink 및 NVSwitch 기술과 함께 32개의 Grace Hopper 칩을 한 번에 사용합니다. 이 플랫폼은 Amazon Network EFA에 연결된 Amazon EC2 인스턴스에서 사용되며 고급 가상화(AWS Nitro System) 및 대규모 클러스터(Amazon EC2 UltraClusters)를 통해 구동되므로 Amazon과 Nvidia 공동 고객이 배포를 수천 개로 확장할 수 있습니다. H200 칩NVIDIA와 AWS는 AWS에서 NVIDIA의 서비스형 AI 교육 DGX Cloud를 호스팅하기 위해 협력할 예정입니다. 이는 GH200 NVL32를 탑재한 최초의 DGX 클라우드가 될 것이며 개발자에게 최대 공유 메모리를 갖춘 단일 인스턴스를 제공할 것입니다. AWS의 DGX Cloud는 1조 개 이상의 매개변수를 사용하여 최첨단 생성 AI 및 대규모 언어 모델의 훈련 기능을 향상시킵니다

NVIDIA와 AWS는 세계에서 가장 빠른 GPU 기반 AI 슈퍼컴퓨터를 설계하기 위해 Ceiba라는 프로젝트에서 협력하고 있습니다. GH200 NVL32 및 Amazon EFA의 상호 연결 기술로 구동되는 이 컴퓨터는 대규모 시스템입니다. 16,384개의 GH200 슈퍼칩을 탑재하고 65엑사플롭스의 AI 처리능력을 갖췄다. NVIDIA는 이를 사용하여 차세대 생성 AI 혁신을 주도할 계획입니다

AWS는 칩과 클라우드 서비스 제공 외에도 Amazon Q라는 AI 챗봇의 미리보기 버전도 출시했습니다. Amazon Q는 생성 AI 기술을 사용하여 기업 고객의 비즈니스 요구 사항에 따라 작동하는 새로운 유형의 디지털 비서입니다. 기업 고객이 정보를 검색하고, 코드를 작성하고, 비즈니스 지표를 검토하는 데 도움이 됩니다

Q는 AWS 클라우드에서 개발자가 사용할 수 있는 AWS 내 코드 및 문서에 대한 교육을 받았습니다.

개발자는 Q를 사용하여 AWS에서 애플리케이션을 생성하고, 모범 사례를 연구하고, 오류를 수정하고, 애플리케이션에 대한 새로운 기능을 작성하는 데 도움을 받을 수 있습니다. 사용자는 대화형 Q&A를 통해 Q와 상호 작용하여 AWS 콘솔을 떠나지 않고도 새로운 지식을 배우고, 모범 사례를 연구하고, AWS에서 애플리케이션을 구축하는 방법을 이해할 수 있습니다.

Amazon은 엔터프라이즈 인텔리전스 소프트웨어, 콜센터 직원 및 물류 관리를 위한 프로그램에 Q를 추가할 예정입니다. AWS는 고객이 회사 데이터 또는 개인 프로필을 기반으로 Q를 맞춤 설정할 수 있다고 말합니다

대화형 Q&A는 현재 AWS에서 제공하는 모든 엔터프라이즈 지역에서 미리 보기로 제공됩니다

위 내용은 Amazon은 클라우드 지위를 지키기 위해 노력하고 자체 개발한 AI 칩을 업그레이드하며 채팅 로봇 Q를 출시하고 Nvidia의 차세대 슈퍼 칩을 최초로 사용합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!