신기술 출시, IDEA 연구소에서 사용자가 이미지에서 직접 '프롬프트' 프롬프트를 선택할 수 있는 T-Rex 모델 출시

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-11-24 08:10:381488검색

인기 있는 Grounded SAM에 이어 IDEA 연구소 팀이 새로운 작업으로 돌아왔습니다: 새로운 시각적 프롬프트(Visual Prompt) 모델 T-Re x, 그림을 사용하여 그림을 인식하고, 상자에서 꺼내 바로 사용하세요.  오픈 세트 감지의 새로운 세계를 열어보세요!

오픈 세트 감지의 새로운 세계를 열어보세요!

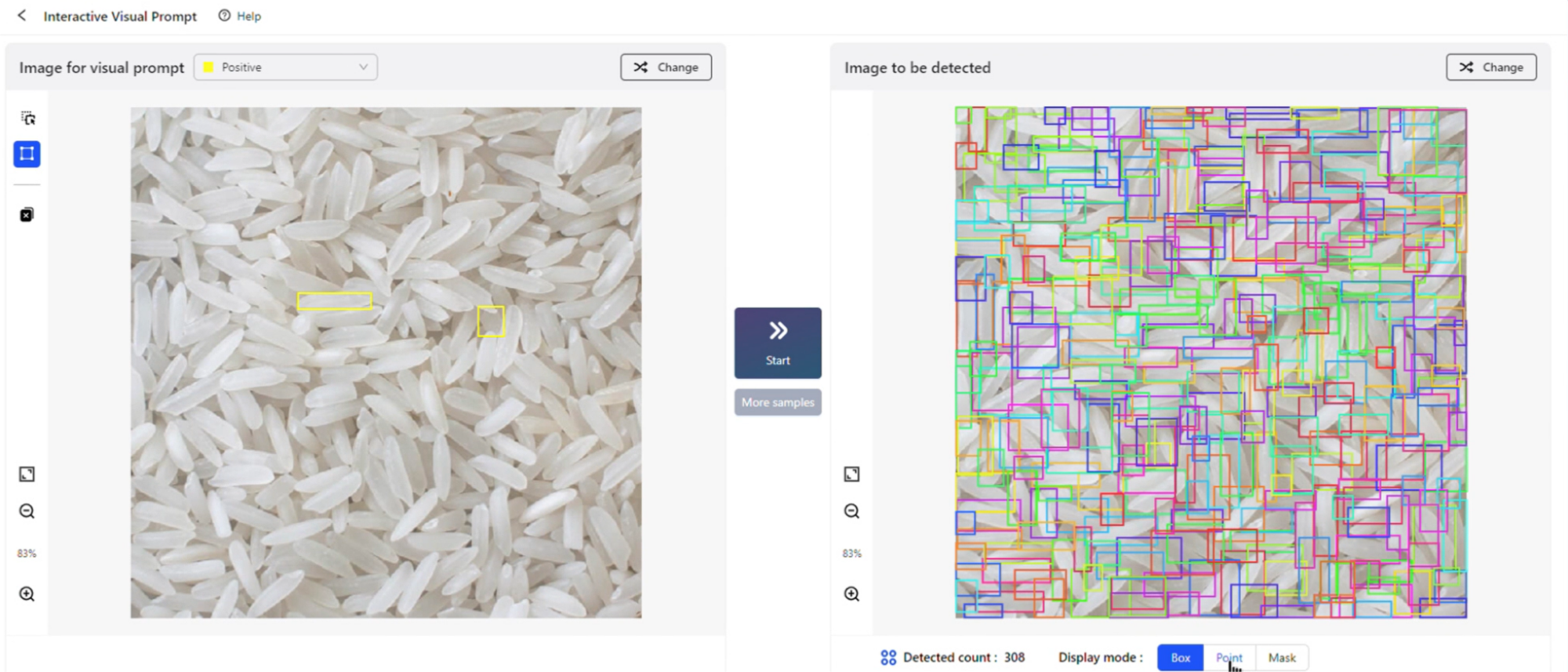

틀을 당겨서 확인하고 완성! 막 종료된 2023년 IDEA 컨퍼런스에서 IDEA 연구소 창립 회장이자 국립공정원 외국 학자인 Shen Xiangyang은 시각적 단서를 기반으로 한 새로운 표적 탐지 경험을 시연하고 새로운 모델 실험실(놀이터)을 공개했습니다. 시각적 단서 모델 T-Rex), iVP(Interactive Visual Prompt)는 현장에서 시험 클라이맥스의 물결을 일으켰습니다.

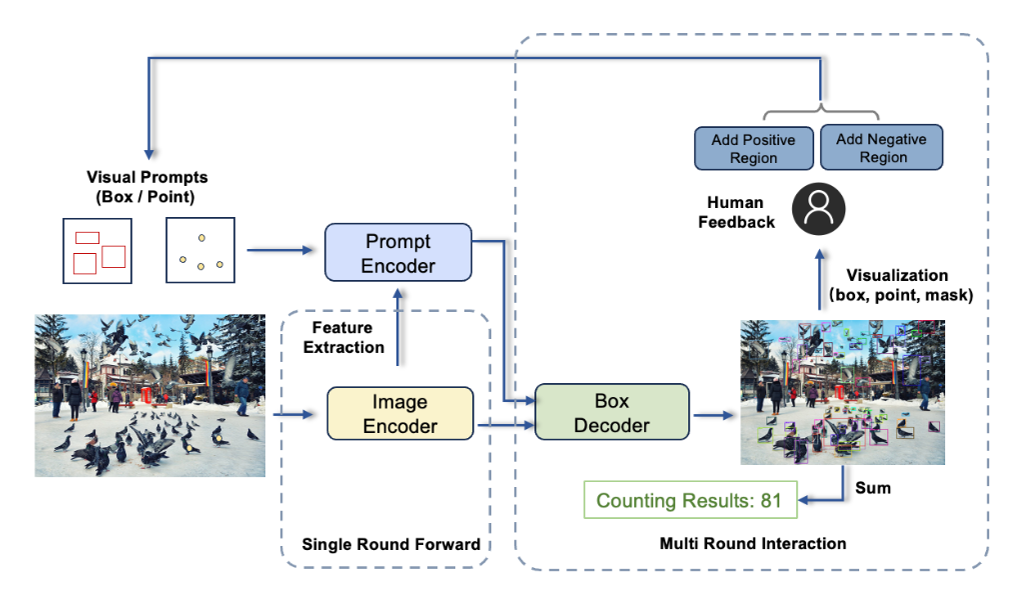

iVP에서 사용자는 "백문이 불여일견입니다"라는 프롬프트 경험을 직접 잠금 해제할 수 있습니다. 사진에 관심 대상을 표시하고 모델에 시각적 예시를 제공하면 모델이 모든 것을 감지합니다. 대상 사진의 유사한 개체. 전체 프로세스는 대화형이며 단 몇 단계만으로 쉽게 완료할 수 있습니다.

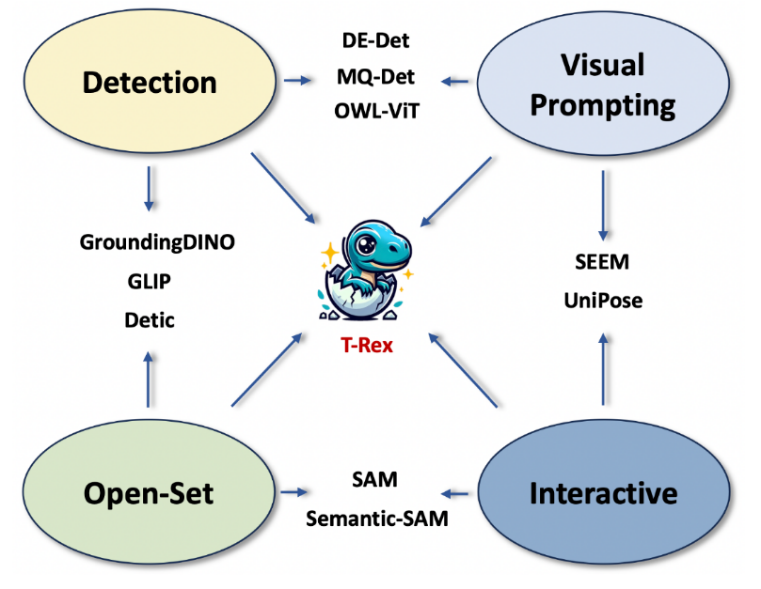

지난 4월 IDEA 연구소에서 출시한 Grounded SAM(Grounding DINO + SAM)은 Github에서 큰 인기를 끌며 현재까지 11,000개의 별을 모았습니다. 이번에 출시된 T-Rex 모델은 텍스트 프롬프트만 지원하는 Grounded SAM과 달리 강력한 상호작용 생성에 중점을 둔 시각적 프롬프트 기능을 제공합니다.

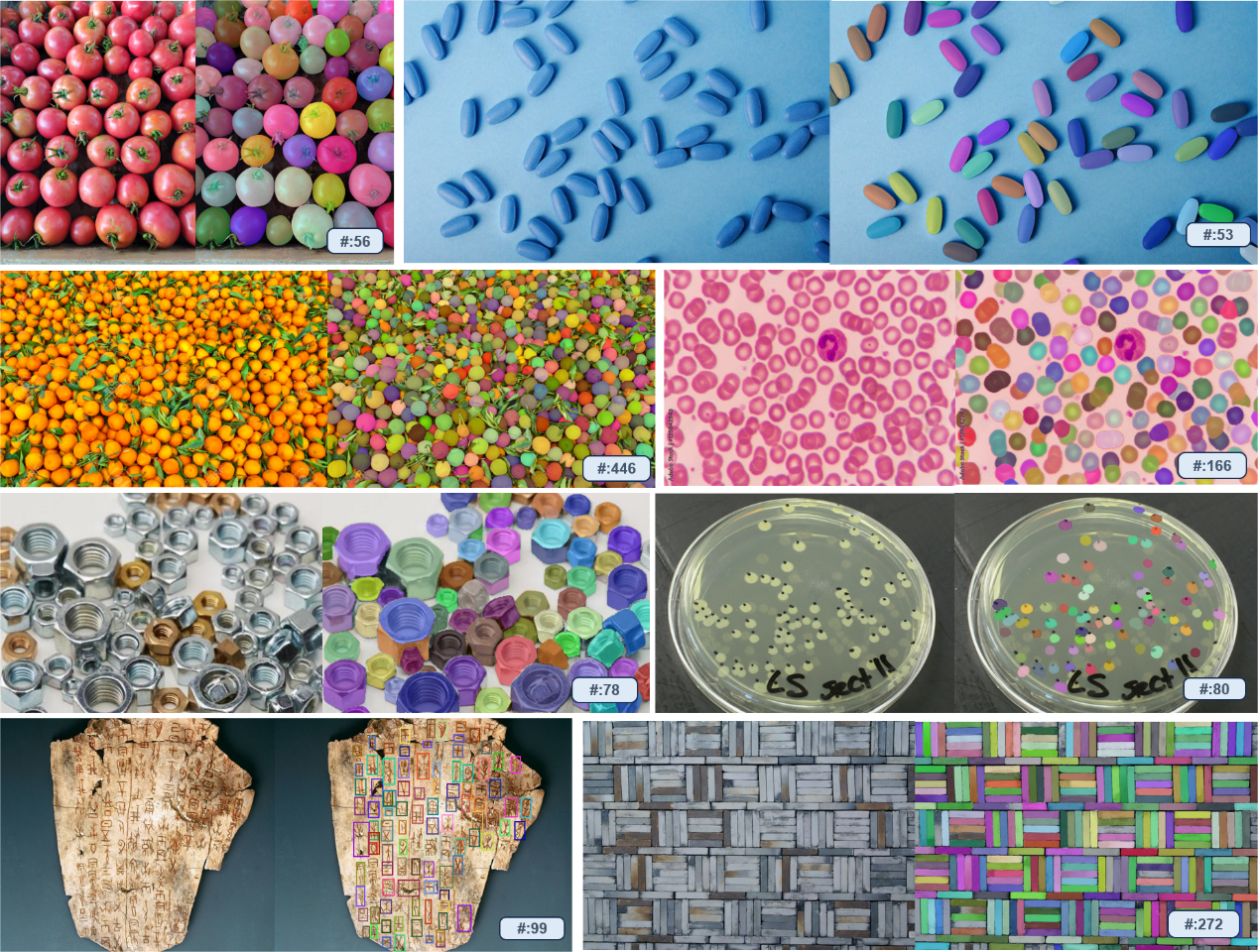

T-Rex는 강력한 기본 기능을 갖추고 있으며 재훈련이나 미세 조정 없이 훈련 단계에서 모델이 본 적이 없는 물체를 감지할 수 있습니다. 이 모델은 계산을 포함한 모든 탐지 작업에 적용할 수 있을 뿐만 아니라 지능형 대화형 주석 시나리오를 위한 새로운 솔루션을 제공합니다.

팀은 시각적 프롬프트 기술의 개발이 실제 장면의 페인 포인트 관찰에서 비롯되었다고 밝혔습니다. 일부 파트너는 시각적 모델을 사용하여 트럭에 실린 상품 수를 계산하기를 원하지만, 이 모델은 텍스트 프롬프트만으로는 각 상품을 개별적으로 식별할 수 없습니다. 그 이유는 산업현장의 사물은 일상생활에서 드물고, 말로 표현하기 어렵기 때문이다. 이 경우 시각적 단서가 분명히 더 효율적인 접근 방식입니다. 동시에 직관적인 시각적 피드백과 강력한 상호작용성은 탐지의 효율성과 정확성을 향상시키는 데 도움이 됩니다.

실제 사용 요구 사항에 대한 통찰력을 바탕으로 팀은 T-Rex를 여러 시각적 신호를 수용하고 이미지 전반에 걸쳐 메시지를 표시할 수 있는 모델로 설계했습니다. 가장 기본적인 단일 라운드 프롬프트 모드 외에도 현재 모델은 다음 세 가지 고급 모드도 지원합니다.

- 멀티 라운드 포지티브 모드: 시각적 프롬프트가 충분히 정확하지 않아 감지 누락이 발생하는 시나리오에 적합합니다. 긍정적+부정 모드: 시각적 단서가 모호하고 잘못된 감지를 유발하는 시나리오에 적합합니다.

- 교차 이미지 모드: 단일 참조 이미지가 다른 이미지의 감지를 유도하는 시나리오에 적합합니다.

- 오픈 세트: 사전 정의된 범주에 제한되지 않고 모든 객체를 감지하는 기능

- 시각적 프롬프트: 시각적 예시를 사용하여 감지 대상을 지정합니다. 희귀하고 복잡한 객체 사용의 어려움을 극복 텍스트로 완벽하게 표현된 질문은 프롬프트 효율성을 향상

- 직관적인 시각적 피드백: 경계 상자와 같은 직관적인 시각적 피드백을 제공하여 사용자가 탐지 결과를 효율적으로 평가할 수 있도록 돕습니다

- 상호작용성: 사용자가 탐지 프로세스에 편리하게 참여할 수 있습니다. 그리고 올바른 모델 결과

iVP모델 연구소: https://deepdataspace.com/playground/ivp

Github 링크: trex-counting.github.io

이 작업은 IDEA 연구소의 컴퓨터 비전 및 로봇 공학 연구 센터에서 가져온 것입니다. 팀의 이전 오픈 소스 표적 탐지 모델 DINO는 COCO 표적 탐지 순위에서 1위를 차지한 최초의 DETR 모델이었습니다. Github의 Grounding DINO는 또한 모든 물체를 탐지하고 분할할 수 있습니다. 이 팀의 작품

위 내용은 신기술 출시, IDEA 연구소에서 사용자가 이미지에서 직접 '프롬프트' 프롬프트를 선택할 수 있는 T-Rex 모델 출시의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!