Nvidia, AI 칩 H200 출시: 성능 90% 향상, Llama 2 추론 속도 2배 향상

- 王林앞으로

- 2023-11-14 12:09:541058검색

DoNews는 11월 14일 NVIDIA가 베이징 시간으로 13일 차세대 인공지능 슈퍼컴퓨터 칩을 출시했다고 보도했습니다. 이 칩은 OpenAI의 GPT-4와 같은 딥 러닝 및 대규모 언어 모델(LLM)에서 중요한 역할을 할 것입니다.

신세대 칩은 이전 세대에 비해 상당한 발전을 이루었으며 날씨 및 기후 예측, 약물 연구 및 개발, 양자 컴퓨팅과 같은 복잡한 작업을 처리하기 위해 데이터 센터 및 슈퍼컴퓨터에서 널리 사용될 것입니다

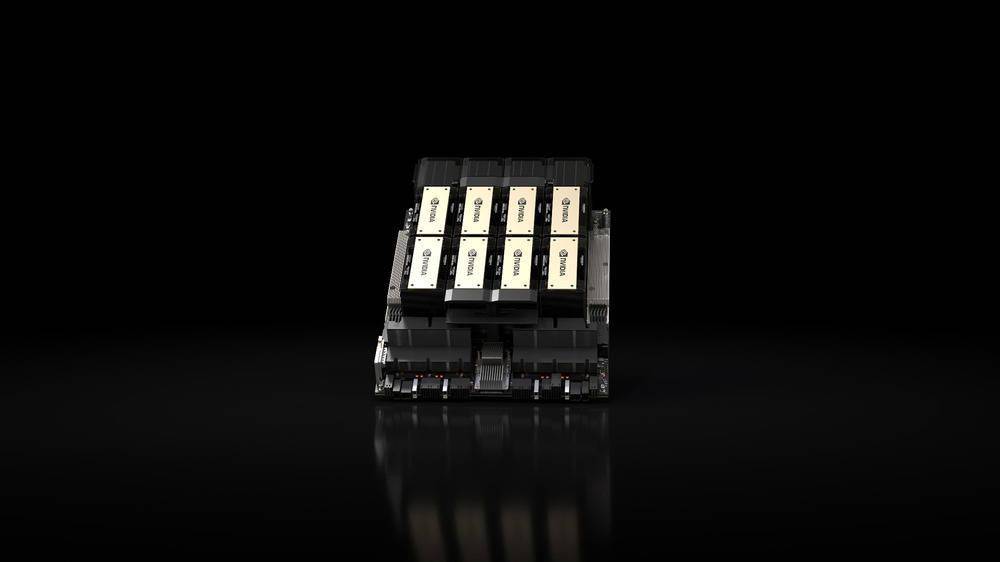

출시된 핵심 제품은 Nvidia의 "Hopper" 아키텍처를 기반으로 한 HGX H200 GPU입니다. 이는 H100 GPU의 후속 제품이자 HBM3e 메모리를 사용하는 회사 최초의 칩입니다. HBM3e 메모리는 속도가 더 빠르고 용량도 더 크기 때문에 대규모 언어 모델 애플리케이션에 매우 적합합니다

NVIDIA는 "HBM3e 기술을 통해 NVIDIA H200 메모리 속도는 초당 4.8TB에 달하고, 용량은 A100의 거의 2배인 141GB이며, 대역폭도 2.4배 증가했습니다."라고 밝혔습니다.

인공지능 분야에서 NVIDIA는 Llama 2(700억 매개변수 LLM)에서 HGX H200의 추론 속도가 H100보다 2배 빠르다고 주장합니다. HGX H200은 4방향 및 8방향 구성으로 제공되며 H100 시스템의 소프트웨어 및 하드웨어와 호환됩니다모든 유형의 데이터 센터(온프레미스, 클라우드, 하이브리드 클라우드 및 엣지)에서 사용할 수 있으며 Amazon Web Services, Google Cloud, Microsoft Azure 및 Oracle Cloud Infrastructure를 통해 배포되며 2024년 2분기에 제공될 예정입니다.

이번에 NVIDIA가 출시한 또 다른 핵심 제품은 HGX H200 GPU와 Arm 기반 NVIDIA Grace CPU를 자사의 NVLink-C2C 인터커넥트를 통해 결합한 GH200 Grace Hopper '슈퍼칩'입니다. 테라바이트급 데이터를 실행하는 복잡한 AI 및 HPC 애플리케이션을 가속화하여 세계에서 가장 어려운 문제를 해결합니다.”

GH200은 Dell, Eviden, Hewlett Packard Enterprise(HPE), Lenovo, QCT 및 Supermicro를 포함하여 "전 세계 연구 센터, 시스템 제조업체 및 클라우드 제공업체의 40개 이상의 AI 슈퍼컴퓨터"에 사용될 예정입니다.

특히 HPE의 Cray EX2500 슈퍼컴퓨터는 수만 개의 Grace Hopper 슈퍼칩 노드로 확장 가능한 4방향 GH200을 특징으로 합니다

위 내용은 Nvidia, AI 칩 H200 출시: 성능 90% 향상, Llama 2 추론 속도 2배 향상의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

성명:

이 기사는 sohu.com에서 복제됩니다. 침해가 있는 경우 admin@php.cn으로 문의하시기 바랍니다. 삭제