MiniGPT-4는 MiniGPT-v2로 업그레이드되었습니다. 다중 모드 작업은 GPT-4 없이도 완료할 수 있습니다.

- PHPz앞으로

- 2023-10-17 14:41:091428검색

몇 달 전 KAUST(사우디아라비아 King Abdullah Science and Technology University)의 여러 연구원이 유사한 GPT-4 이미지 이해 및 대화를 제공할 수 있는 MiniGPT-4 라는 프로젝트를 제안했습니다. 능력.

예를 들어 MiniGPT-4는 아래 사진의 장면에 답할 수 있습니다. "사진은 얼어붙은 호수에서 자라는 선인장을 묘사합니다. 선인장 주변에는 거대한 얼음 결정이 있고 멀리 눈 덮인 봉우리가 있습니다. ..." 그런 다음 이 시나리오가 현실 세계에서 일어날 수 있는지 묻는다면? MiniGPT-4가 내놓은 대답은 이 이미지가 현실 세계에서는 흔하지 않다는 것과 그 이유다.

최근 KAUST 팀과 Meta의 연구원들은 MiniGPT-4를 MiniGPT-v2 버전으로 업그레이드했다고 발표했습니다.

논문 주소: https://arxiv.org/pdf/2310.09478.pdf

논문 홈페이지: https://minigpt-v2.github.io/

Demo: https: //minigpt-v2.github.io/

특히 MiniGPT-v2는 다양한 시각적 언어 작업을 더 잘 처리하기 위한 통합 인터페이스 역할을 할 수 있습니다. 동시에 이 기사에서는 모델을 훈련할 때 다양한 작업에 고유한 식별 기호를 사용할 것을 권장합니다. 이러한 식별 기호는 모델이 각 작업 지시를 쉽게 구별하고 각 작업 모델의 학습 효율성을 높이는 데 도움이 됩니다.

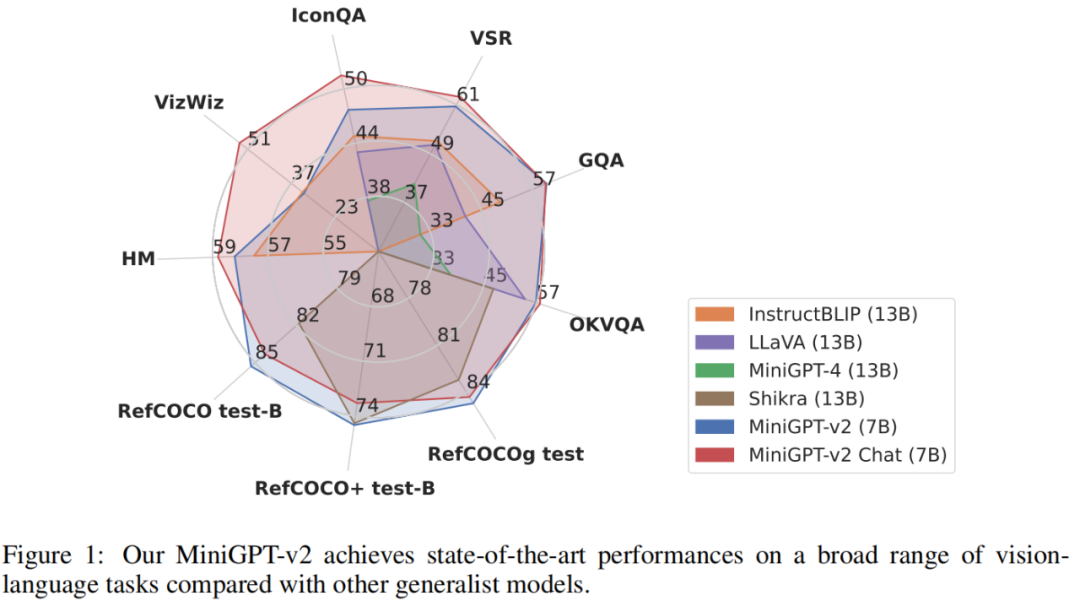

MiniGPT-v2 모델의 성능을 평가하기 위해 연구원들은 다양한 시각적 언어 작업에 대한 광범위한 실험을 수행했습니다. 결과에 따르면 MiniGPT-v2는 MiniGPT-4, InstructBLIP, LLaVA 및 Shikra와 같은 이전 비전 언어 범용 모델과 비교하여 다양한 벤치마크에서 SOTA 또는 이에 필적하는 성능을 달성한 것으로 나타났습니다. 예를 들어 MiniGPT-v2는 VSR 벤치마크에서 MiniGPT-4보다 21.3%, InstructBLIP은 11.3%, LLaVA는 11.7% 성능이 뛰어납니다.

아래에서는 MiniGPT-v2 식별 기호의 역할을 설명하기 위해 구체적인 예를 사용합니다.

예를 들어 [접지] 인식 기호를 추가하면 모델에서 공간 위치 인식이 포함된 이미지 설명을 쉽게 생성할 수 있습니다.

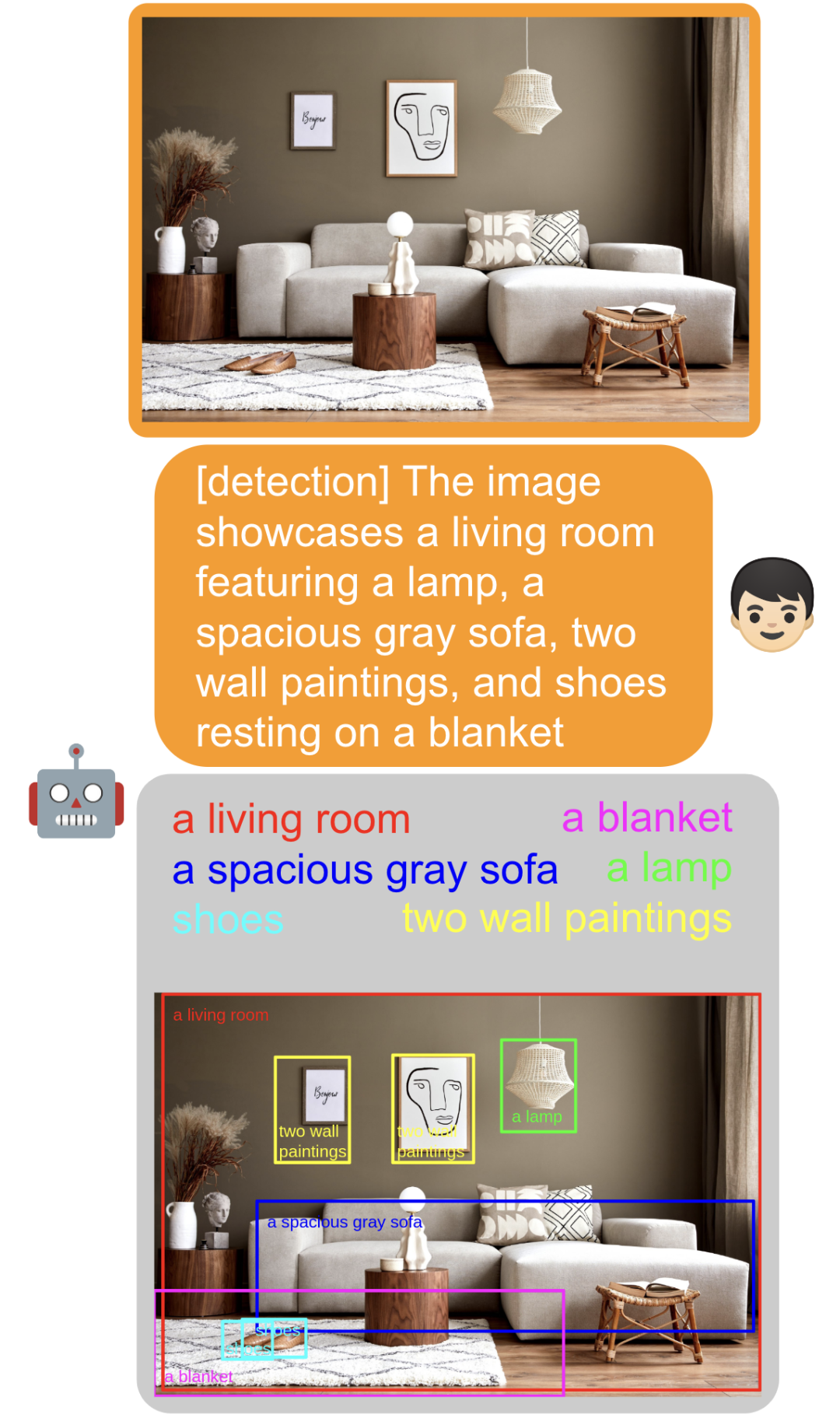

[감지] 인식 기호를 추가하면 모델에서 직접 추출할 수 있습니다. 내부의 입력 텍스트 개체를 확인하고 그림에서 개체의 공간적 위치를 찾습니다.

그림에서 개체의 프레임을 지정합니다. [식별]을 추가하면 모델이 개체의 이름을 직접 식별할 수 있습니다.

패스 추가 [참조] 및 개체에 대한 설명, 모델은 개체의 해당 공간 위치를 찾는 데 직접 도움이 될 수 있습니다.

패스 추가 [참조] 및 개체에 대한 설명, 모델은 개체의 해당 공간 위치를 찾는 데 직접 도움이 될 수 있습니다.

또한 작업을 추가하지 않고도 일치 항목을 식별하고 대화를 나눌 수도 있습니다. 사진:

모델의 공간지각력도 강해졌습니다. 사진의 왼쪽, 중간, 오른쪽에 등장하는 모델에게 직접 물어보세요:

방법 소개

MiniGPT-v2 모델 아키텍처는 아래 그림에 표시되어 있으며 시각적 백본, 선형 투영 레이어 및 대규모 언어 모델의 세 부분으로 구성됩니다.

시각적 백본: MiniGPT-v2는 EVA를 백본 모델로 사용하며 훈련 중에는 시각적 백본이 고정됩니다. 모델은 448x448의 이미지 해상도로 훈련되었으며 위치 인코딩이 삽입되어 더 높은 이미지 해상도로 확장됩니다.

선형 투영 레이어: 이 문서의 목표는 고정된 시각적 백본의 모든 시각적 토큰을 언어 모델 공간으로 투영하는 것입니다. 그러나 고해상도 이미지(예: 448x448)의 경우 모든 이미지 토큰을 투영하면 매우 긴 시퀀스 입력(예: 1024 토큰)이 발생하여 훈련 및 추론 효율성이 크게 저하됩니다. 따라서 본 논문에서는 단순히 임베딩 공간에서 4개의 인접한 시각적 토큰을 연결하고 대규모 언어 모델의 동일한 기능 공간에서 단일 임베딩으로 함께 프로젝션하여 시각적 입력 토큰의 수를 4배로 줄입니다.

대규모 언어 모델: MiniGPT-v2는 오픈 소스 LLaMA2-chat(7B)을 언어 모델의 백본으로 사용합니다. 본 연구에서는 언어 모델을 다양한 시각적 언어 입력을 위한 통합 인터페이스로 간주합니다. 이 기사에서는 LLaMA-2 언어 토큰을 직접 사용하여 다양한 시각적 언어 작업을 수행합니다. 공간 위치 생성이 필요한 기본 비전 작업의 경우 이 문서에서는 공간 위치를 나타내기 위해 경계 상자의 텍스트 표현을 생성하는 언어 모델이 직접 필요합니다.

다중 작업 지시 훈련

이 문서에서는 작업 인식 기호 명령을 사용하여 모델을 훈련하며, 이는 3단계로 나뉩니다. 훈련의 각 단계에 사용된 데이터 세트는 표 2에 나와 있습니다.

1단계: 사전 훈련. 본 논문에서는 보다 다양한 지식을 얻기 위해 약하게 레이블이 지정된 데이터 세트에 높은 샘플링 속도를 제공합니다.

2단계: 멀티태스킹 훈련. 각 작업에서 MiniGPT-v2의 성능을 향상시키기 위해 현재 단계에서는 세분화된 데이터 세트를 사용하여 모델을 훈련하는 데에만 중점을 두고 있습니다. 연구진은 GRIT-20M, LAION 등 약하게 감독되는 데이터 세트를 1단계에서 제외하고 각 작업의 빈도에 따라 데이터 샘플링 비율을 업데이트했습니다. 이 전략을 통해 모델은 고품질로 정렬된 이미지-텍스트 데이터의 우선순위를 지정하여 다양한 작업에서 뛰어난 성능을 얻을 수 있습니다.

3단계: 다중 모드 명령 튜닝. 그 후, 이 문서에서는 모델을 미세 조정하고 챗봇으로서의 대화 기능을 향상시키기 위해 더 많은 다중 모드 명령 데이터 세트를 사용하는 데 중점을 둡니다.

마지막으로 공식에서는 독자들이 테스트할 수 있는 데모도 제공합니다. 예를 들어 아래 그림의 왼쪽에는 사진을 업로드한 다음 [감지]를 선택한 다음 모델인 "빨간 풍선"을 입력합니다. 사진 속 빨간 풍선을 확인하실 수 있습니다 :

관심 있는 독자들은 논문 홈페이지에서 자세한 내용을 확인하실 수 있습니다.

위 내용은 MiniGPT-4는 MiniGPT-v2로 업그레이드되었습니다. 다중 모드 작업은 GPT-4 없이도 완료할 수 있습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!