Salesforce는 MIT 연구원과 협력하여 오픈 소스 GPT-4 개정 튜토리얼을 통해 더 적은 단어로 더 많은 정보를 제공합니다.

- 王林앞으로

- 2023-09-19 20:33:13952검색

자동 요약 기술은 주로 패러다임 변화로 인해 최근 몇 년간 상당한 발전을 이루었습니다. 과거에 이 기술은 주로 주석이 달린 데이터 세트에 대한 감독된 미세 조정에 의존했지만 이제는 GPT-4와 같은 제로샷 프롬프트를 위해 LLM(대형 언어 모델)을 사용합니다. 신중한 프롬프트 설정을 통해 추가 교육 없이도 요약 길이, 주제, 스타일 및 기타 기능을 세밀하게 제어할 수 있습니다. 그러나 한 가지 측면, 즉 요약의 정보 밀도가 간과되는 경우가 많습니다. 이론적으로 다른 텍스트를 압축한 요약은 소스 파일보다 더 밀도가 높아야 합니다. 즉, 더 많은 정보를 포함해야 합니다. LLM 디코딩의 높은 대기 시간을 고려할 때 특히 실시간 애플리케이션의 경우 더 적은 단어로 더 많은 정보를 처리하는 것이 중요합니다.

그러나 정보 밀도는 개방형 질문입니다. 초록에 세부 사항이 충분하지 않으면 정보가 없는 것과 같습니다. 전체 길이를 늘리지 않고 너무 많은 정보를 포함하면 이해하기 어려워집니다. 고정된 토큰 예산 내에서 더 많은 정보를 전달하려면 추상화, 압축 및 융합을 결합해야 합니다.

최근 연구에서 Salesforce, MIT 등의 연구원들은 GPT-4에서 생성된 일련의 요약에 대한 인간의 선호도를 요청하여 밀도 증가의 한계를 확인하려고 시도했습니다. 이 방법은 GPT-4

논문 링크: https://arxiv.org/pdf/2309.04269.pdf

논문 링크: https://arxiv.org/pdf/2309.04269.pdf

데이터 세트 주소: https: / /huggingface.co/datasets/griffin/chain_of_density

구체적으로, 연구원들은 밀도에 대한 프록시로 토큰당 평균 엔터티 수를 사용하여 초기 엔터티 희소 요약을 생성했습니다. 그런 다음 전체 길이를 늘리지 않고(전체 길이의 5배) 이전 요약에서 누락된 1~3개의 엔터티를 반복적으로 식별하고 융합합니다. 각 다이제스트는 이전 다이제스트보다 엔터티 대 토큰 비율이 더 높습니다. 인간의 선호도 데이터를 기반으로 저자는 궁극적으로 인간이 인간이 작성한 요약만큼 조밀하고 일반적인 GPT-4 힌트로 생성된 요약보다 밀도가 높은 요약을 선호한다는 결론을 내렸습니다.

연구의 전반적인 기여는 다음과 같이 요약할 수 있습니다.

- 요약의 개체 밀도를 높이기 위해 반복적인 프롬프트 기반 방법(CoD)을 개발해야 합니다.

- 트레이드오프를 더 잘 이해하기 위해 CNN/Daily Mail 기사의 요약 밀도를 수동 및 자동으로 평가합니다. 정보성(더 많은 엔터티 선호)과 명확성(더 적은 엔터티 선호) 사이

- 오픈 소스 GPT-4 초록, 주석 및 주석이 없는 5000개의 CoD 초록 세트, 평가 또는 개선에 사용됩니다.

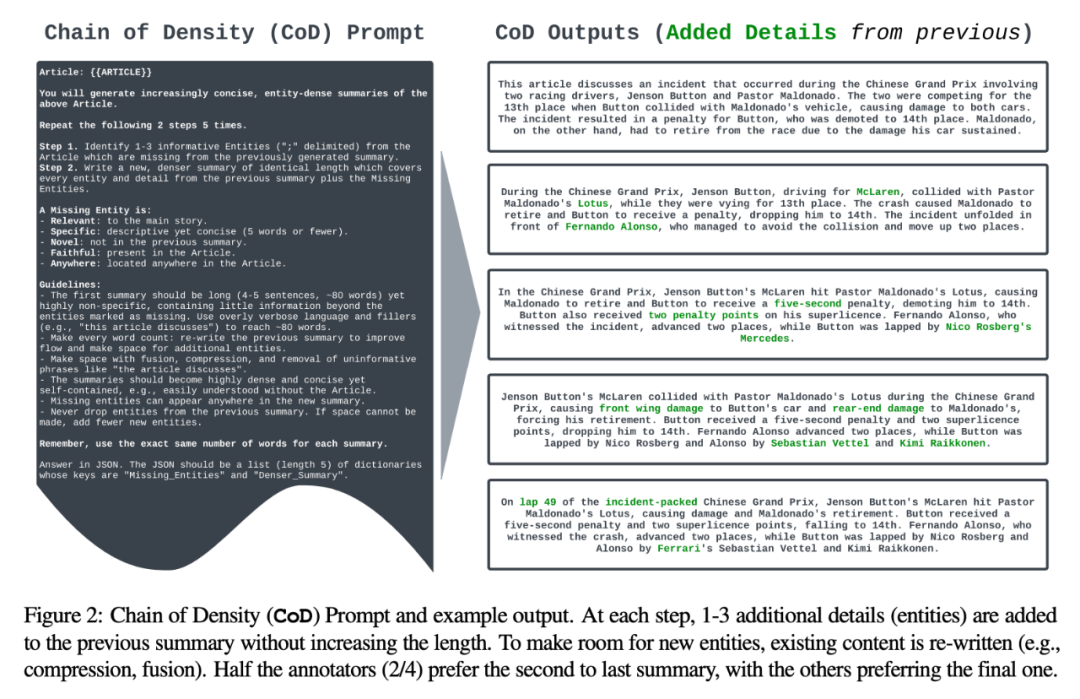

저자는 초기 요약을 생성하고 해당 엔터티 밀도를 지속적으로 증가시키는 단일 밀도 체인(CoD) 프롬프트를 공식화했습니다. 특히, 고정된 수의 상호 작용 내에서 소스 텍스트의 고유한 두드러진 개체 집합이 식별되어 길이를 늘리지 않고 이전 요약에 병합됩니다.

프롬프트 및 출력의 예는 그림 2에 나와 있습니다. 저자는 항목 유형을 명시적으로 지정하지 않지만 누락된 항목을 다음과 같이 정의합니다.

- 주요 내용과 관련됨:

- 구체적: 간결함(5단어 이하)

- 고유함: 언급되지 않음 이전 요약에서

- 신실함: 기사에 있음

- 어디든지: 기사의 어느 곳에나 있음.

저자는 CNN/DailyMail 요약 테스트 세트에서 무작위로 100개의 기사를 선택하여 이에 대한 CoD 요약을 생성했습니다. 쉽게 참조할 수 있도록 CoD 요약 통계를 "기사에 대한 매우 짧은 요약을 작성하세요.

저자는 CNN/DailyMail 요약 테스트 세트에서 무작위로 100개의 기사를 선택하여 이에 대한 CoD 요약을 생성했습니다. 쉽게 참조할 수 있도록 CoD 요약 통계를 "기사에 대한 매우 짧은 요약을 작성하세요.

"라는 일반 프롬프트에서 GPT-4가 생성한 사람이 작성한 주요 항목 참조 요약과 비교했습니다.

통계적 상황저자는 본 연구를 직접통계와 간접통계라는 두 가지 측면으로 요약했다. 직접 통계(토큰, 엔터티, 엔터티 밀도)는 CoD에 의해 직접 제어되는 반면, 간접 통계는 밀도화의 예상되는 부산물입니다.

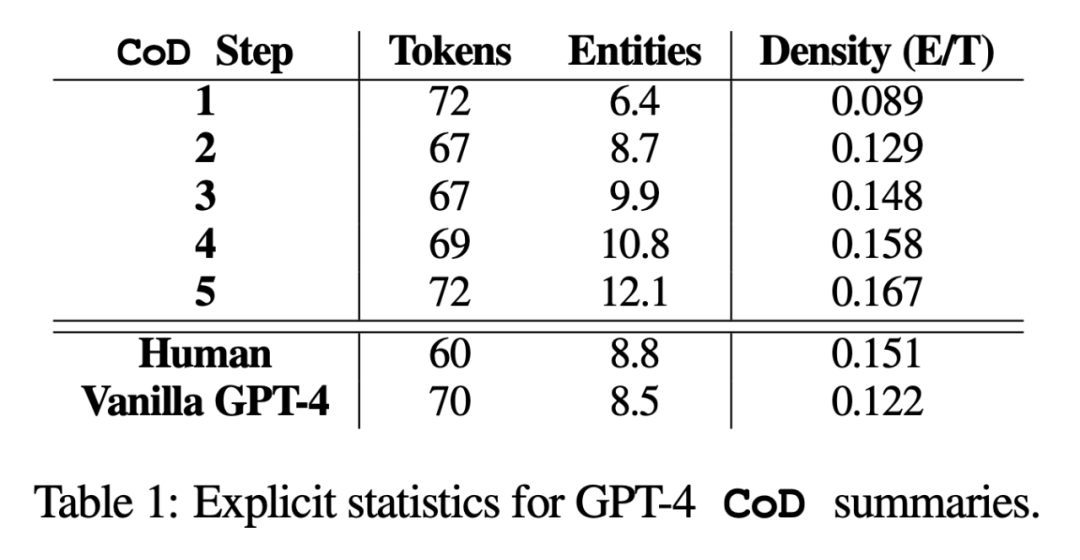

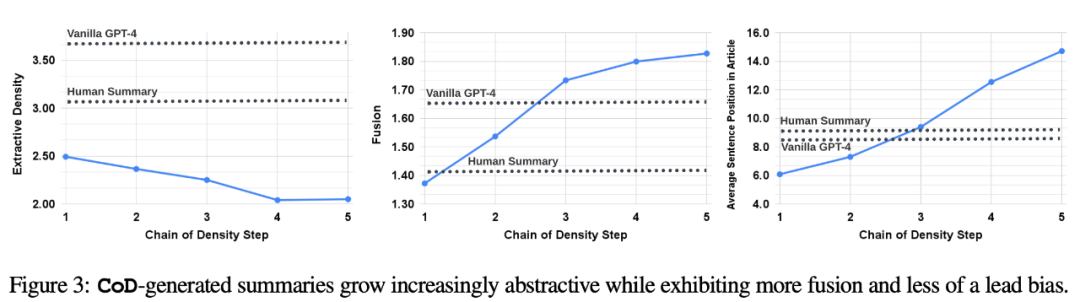

직접 통계. 표 1에서 볼 수 있듯이 두 번째 단계에서는 초기에 긴 요약에서 불필요한 단어를 제거하여 평균 5개 토큰(72개에서 67개)만큼 길이를 줄였습니다. 엔터티 밀도는 0.089에서 시작하여 처음에는 인간과 바닐라 GPT-4(0.151 및 0.122)보다 낮고, 5단계의 치밀화 후에 결국 0.167로 올라갑니다.  간접 통계. 각 추가 엔터티에 대한 공간을 확보하기 위해 추상이 반복적으로 다시 작성되므로 CoD의 각 단계마다 추상화 수준이 높아져야 합니다. 저자는 추출 밀도(추출된 조각의 평균 제곱 길이)를 사용하여 추상화를 측정합니다(Grusky et al., 2018). 마찬가지로 고정 길이 요약에 엔터티가 추가됨에 따라 개념 융합이 단조롭게 증가해야 합니다. 저자들은 각 요약 문장에 정렬된 원본 문장의 평균 개수로 통합 정도를 표현했습니다. 정렬을 위해 저자는 추가 문장의 상대 ROUGE 이득이 더 이상 양수가 아닐 때까지 원본 문장을 대상 문장과 정렬하는 상대 ROUGE 이득 방법(Zhou et al., 2018)을 사용합니다. 그들은 또한 콘텐츠 배포나 요약 콘텐츠가 나오는 기사 내 위치의 변화도 예상했습니다.

간접 통계. 각 추가 엔터티에 대한 공간을 확보하기 위해 추상이 반복적으로 다시 작성되므로 CoD의 각 단계마다 추상화 수준이 높아져야 합니다. 저자는 추출 밀도(추출된 조각의 평균 제곱 길이)를 사용하여 추상화를 측정합니다(Grusky et al., 2018). 마찬가지로 고정 길이 요약에 엔터티가 추가됨에 따라 개념 융합이 단조롭게 증가해야 합니다. 저자들은 각 요약 문장에 정렬된 원본 문장의 평균 개수로 통합 정도를 표현했습니다. 정렬을 위해 저자는 추가 문장의 상대 ROUGE 이득이 더 이상 양수가 아닐 때까지 원본 문장을 대상 문장과 정렬하는 상대 ROUGE 이득 방법(Zhou et al., 2018)을 사용합니다. 그들은 또한 콘텐츠 배포나 요약 콘텐츠가 나오는 기사 내 위치의 변화도 예상했습니다.

구체적으로 저자는 CoD 초록이 처음에는 강한 "리드 바이어스"(Lead Bias)를 나타내지만 점차적으로 기사 중간과 끝 부분부터 항목을 소개하기 시작할 것으로 예상합니다. 이를 측정하기 위해 그들은 정렬 융합을 사용하여 원래 문장이 나타나지 않고 중국어로 콘텐츠를 다시 작성하고 정렬된 모든 소스 문장에서 평균 문장 순위를 측정했습니다.

그림 3은 이러한 가설을 확인합니다. 다시 작성 단계 수가 증가함에 따라 추상화가 증가하고(왼쪽 이미지는 추출 밀도가 낮음) 융합 속도는 증가하며(가운데 이미지는 표시) 초록에는 중간부터 내용이 포함되기 시작합니다. 그리고 기사의 끝 부분(오른쪽에 표시됨). 흥미롭게도 모든 CoD 요약은 사람이 작성한 요약 및 기본 요약에 비해 더 추상적입니다.

내용을 다시 작성할 때 중국어로 다시 작성해야 하며 원래 문장은 나타날 필요가 없습니다

더 나은 방법을 위해 CoD 요약의 장단점을 이해하기 위해 저자는 선호도 기반 인간 연구를 수행하고 GPT-4를 사용하여 등급 기반 평가를 수행했습니다.

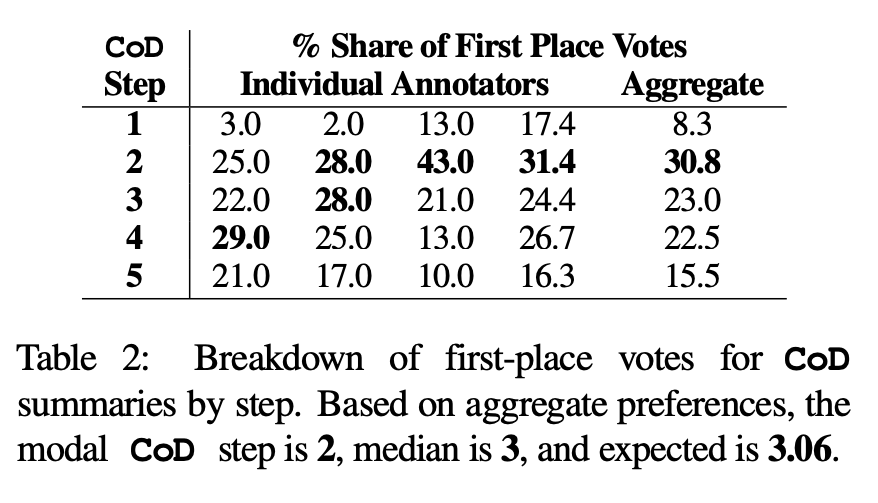

인간의 취향. 구체적으로, 동일한 100개의 논문(5단계 *100 = 총 500개의 초록)에 대해 저자는 "재작성된" CoD 초록과 논문을 논문의 처음 4명의 저자에게 무작위로 보여주었습니다. 각 주석자는 Stiennon et al.(2020)의 "좋은 요약" 정의를 기반으로 자신이 가장 좋아하는 요약을 제공했습니다. 표 2는 CoD 단계에서 각 주석자의 1위 투표와 각 주석자의 요약을 보고합니다. 전체적으로 1위 초록의 61%(23.0+22.5+15.5)가 ≥3의 치밀화 단계를 포함했습니다. 선호되는 CoD 단계의 중앙값은 중간(3)에 있으며 예상 단계 수는 3.06입니다.

3단계 평균 밀도를 기준으로 모든 CoD 후보의 선호 개체 밀도는 약 0.15입니다. 표 1에서 볼 수 있듯이 이 밀도는 사람이 작성한 요약(0.151)과 일치하지만 일반 GPT-4 프롬프트(0.122)

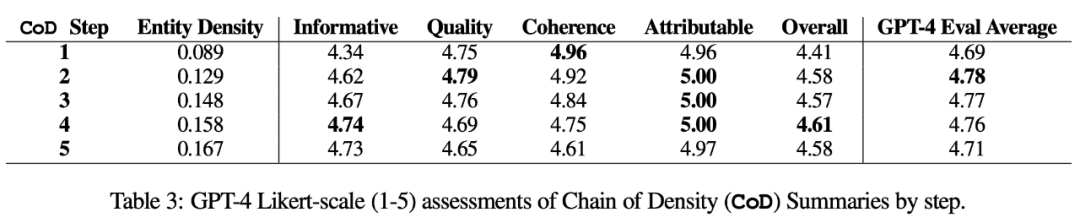

자동 측정항목으로 작성된 요약보다 훨씬 높습니다. 인간 평가(아래)에 대한 보완으로 저자는 GPT-4를 사용하여 정보성, 품질, 일관성, 귀속성 및 전체성이라는 5가지 차원에 따라 CoD 요약(1-5점)을 평가했습니다. 표 3에서 볼 수 있듯이 밀도는 정보성과 상관 관계가 있지만 최대 한도에 이르며 점수는 4단계(4.74)에서 최고점에 이릅니다.

각 차원의 평균 점수 중 CoD의 첫 번째 단계와 마지막 단계의 점수가 가장 낮고 중간 세 단계의 점수가 각각 4.78, 4.77, 4.76으로 가깝습니다.

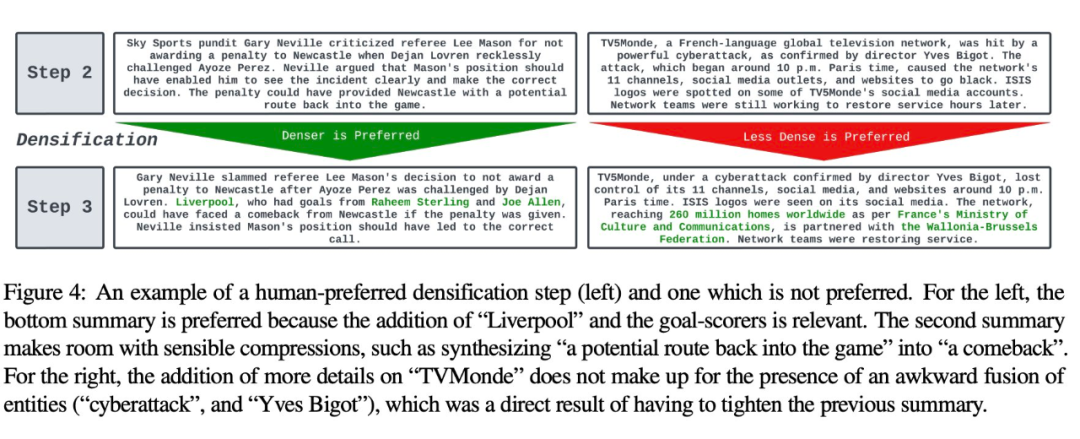

정성적 분석. 추상적 일관성/가독성과 정보성 사이에는 명확한 균형이 있습니다. 두 가지 CoD 단계가 그림 4에 표시되어 있습니다. 한 단계의 요약은 더 자세히 개선되고 다른 단계의 요약은 손상되었습니다. 평균적으로 중간 CoD 요약은 이러한 균형을 가장 잘 달성하지만 향후 작업에서는 이러한 균형을 여전히 정확하게 정의하고 수량화해야 합니다.

논문의 자세한 내용은 원문을 참고해주세요.

논문의 자세한 내용은 원문을 참고해주세요.

위 내용은 Salesforce는 MIT 연구원과 협력하여 오픈 소스 GPT-4 개정 튜토리얼을 통해 더 적은 단어로 더 많은 정보를 제공합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!