경량 시각적 네트워크의 새로운 백본: 효율적인 푸리에 연산자 토큰 믹서

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-08-17 17:57:081608검색

1. 배경

수년에 걸쳐 세 가지 시각적 백본 네트워크인 Transformer, 대형 커널 CNN 및 MLP는 주로 효율적인 글로벌 규모로 인해 광범위한 컴퓨터 비전 작업에서 큰 성공을 거두었습니다. 정보 융합

Transformer, CNN 및 MLP는 현재 세 가지 주류 신경망이며, 글로벌 토큰 융합을 달성하기 위해 각각 서로 다른 방법을 사용합니다. Transformer 네트워크에서 self-attention 메커니즘은 쿼리 키 쌍의 상관 관계를 토큰 융합의 가중치로 사용합니다. CNN은 컨볼루션 커널의 크기를 확장하여 Transformer와 유사한 성능을 달성합니다. MLP는 완전한 연결을 통해 모든 토큰 간의 또 다른 강력한 패러다임을 구현합니다. 이러한 방법은 효과적이지만 계산 복잡도(O(N^2))가 높고 저장 및 컴퓨팅 기능이 제한된 장치에 배포하기 어렵기 때문에 많은 모델의 적용 범위가 제한됩니다

2. : 경량, 글로벌, 적응형

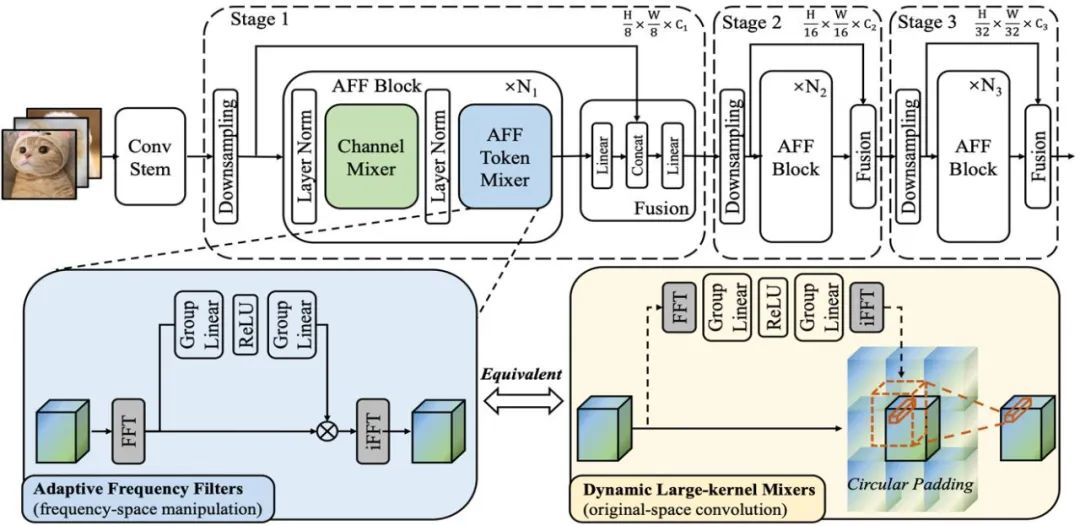

계산 비용이 많이 드는 문제를 해결하기 위해 연구원들은 적응형 푸리에 필터(AFF) 알고리즘이라는 효율적인 글로벌 토큰 융합을 개발했습니다. 이 알고리즘은 푸리에 변환을 사용하여 토큰 집합을 주파수 영역으로 변환하고, 주파수 영역에서 적응형 콘텐츠가 가능한 필터 마스크를 학습하여 주파수 영역 공간으로 변환된 토큰 집합에 대해 적응형 필터링 작업을 수행합니다

적응형 주파수 필터 : Efficient Global Token Mixers

원문에 액세스하려면 이 링크를 클릭하십시오: https://arxiv.org/abs/2307.14008

주파수 영역 컨볼루션 정리에 따르면 AFF 토큰 믹서의 수학 등가 연산은 원본 영역에서 수행되는 컨볼루션 연산으로, 푸리에 영역에서 수행되는 Hadamard 곱 연산과 동일합니다. 이는 AFF 토큰 믹서가 원본 도메인에서 동적 컨볼루션 커널을 사용하여 콘텐츠 적응형 글로벌 토큰 융합을 달성할 수 있음을 의미합니다. 해당 커널의 공간 해상도는 토큰 세트의 크기와 동일합니다(아래 그림의 오른쪽 하위 그림 참조).

동적 컨볼루션은 계산 비용이 많이 든다는 것은 잘 알려져 있습니다. 특히 공간 해상도가 큰 동적 컨볼루션 커널을 사용할 경우 이 비용은 효율적이고 가벼운 네트워크 설계에 허용되지 않는 것 같습니다. 그러나 이 글에서 제안하는 AFF 토큰 믹서는 낮은 전력 소비로 동등한 구현에서 위의 요구 사항을 동시에 충족할 수 있어 복잡성을 O(N^2)에서 O(N log N)로 줄여 계산 효율성을 크게 향상시킬 수 있습니다

개략도 1: AFF 모듈 및 AFFNet 네트워크의 구조를 보여줍니다.

3. AFFNet: 경량 시각적 네트워크의 새로운 백본

AFF 토큰 믹서를 주요 신경망 운영 연산자로 사용 연구진은 AFFNet이라는 경량 신경망 구축에 성공했습니다. 풍부한 실험 결과는 AFF Token Mixer가 시각적 의미 인식 및 조밀한 예측 작업을 포함한 광범위한 시각적 작업에서 정확성과 효율성의 탁월한 균형을 달성한다는 것을 보여줍니다.

4 실험 결과

연구원들은 AFF의 성능을 평가했습니다 시각적 의미 인식, 분할, 탐지 등 다양한 작업에 대한 Token Mixer 및 AFFNet을 현재 연구 분야에서 가장 진보된 경량 시각적 백본 네트워크와 비교합니다. 실험 결과는 모델 디자인이 다양한 시각적 작업에서 잘 수행됨을 보여줌으로써 차세대 경량 및 효율적인 토큰 융합 연산자로서 AFF Token Mixer의 잠재력을 확인시켜 줍니다

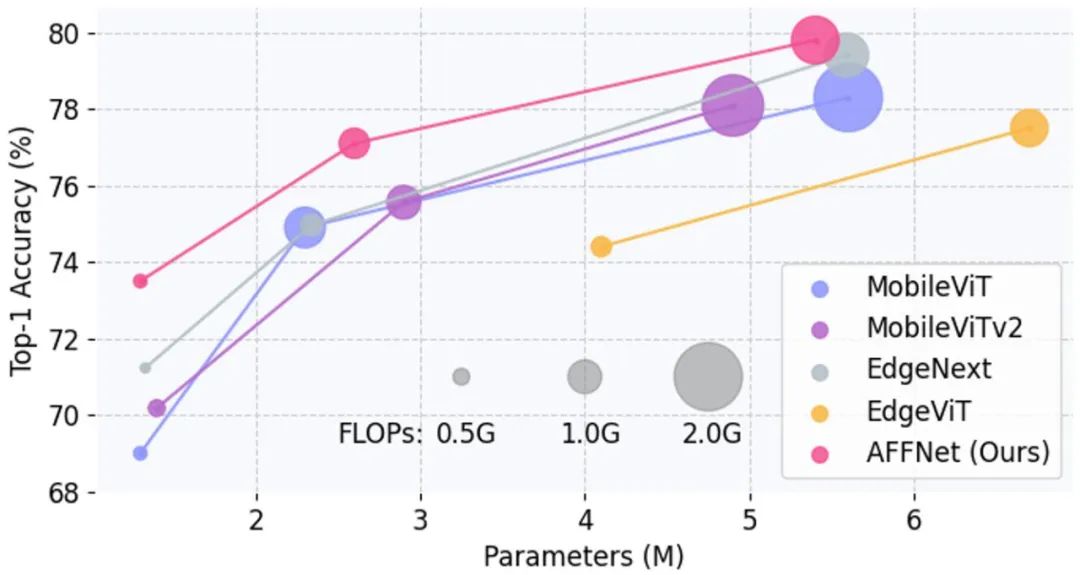

SOTA와 비교하여 그림 2는 Acc를 보여줍니다. -ImageNet-1K 데이터세트의 Param 및 Acc-FLOPs 곡선

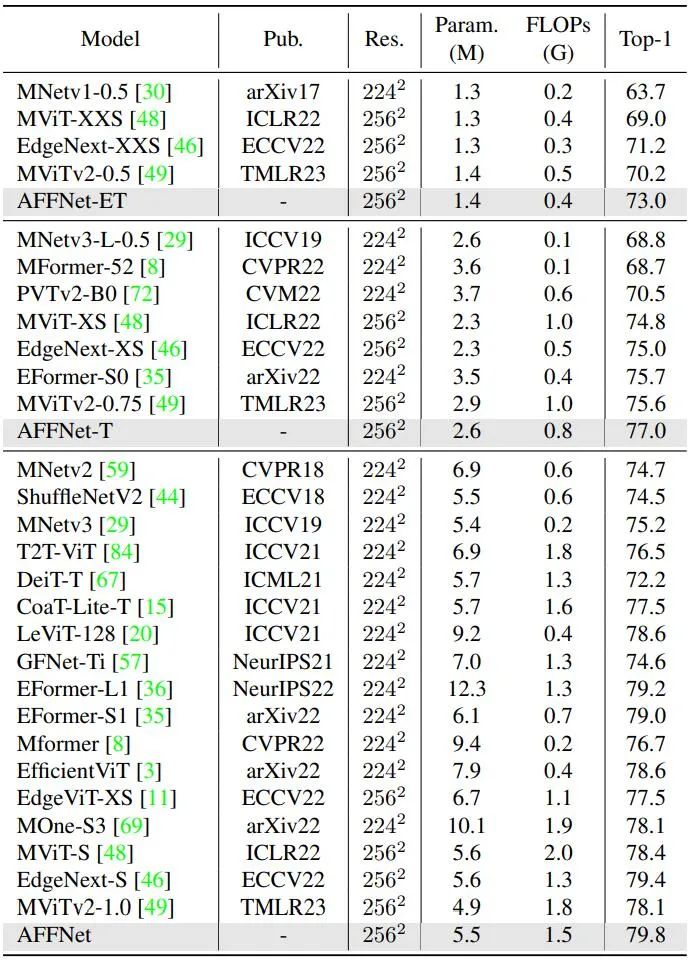

최첨단 방법의 결과를 ImageNet-1K 데이터세트와 비교, 표 1

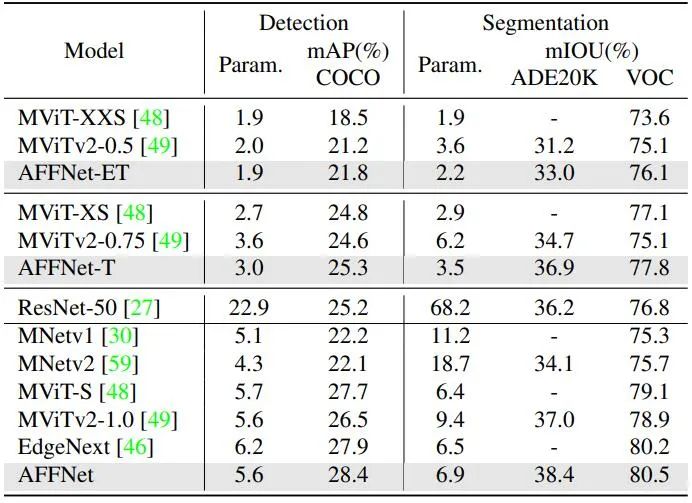

을 참조하세요. 표 2는 최첨단 기술을 사용한 시각적 감지 및 분할 작업 비교를 보여줍니다

5. 결론

이 연구는 잠재 공간의 주파수 영역 변환이 글로벌 적응형 토큰 융합에서 중요한 역할을 하며 효율적이고 저전력 등가 구현임을 증명합니다. 신경망에서 토큰 융합 연산자 설계를 위한 새로운 연구 아이디어를 제공하고, 특히 저장 및 컴퓨팅 기능이 제한적인 경우 에지 장치에 신경망 모델을 배포하기 위한 새로운 개발 공간을 제공합니다

위 내용은 경량 시각적 네트워크의 새로운 백본: 효율적인 푸리에 연산자 토큰 믹서의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!