2023-06-07 17:42:41 작성자: Li Wenwen

모든 SF 팬이라면 오랜 친구와 이야기를 나누듯 몇 마디 말만으로 성간 우주선을 발사하고 별과 바다를 정복할 수 있는 미래, 또는 창조를 할 수 있는 아이언맨의 인공 지능 집사 자비스를 갖는 미래를 갈망합니다. 단 몇 마디의 대화만으로 이루어진 세계 나노 전투복 세트. 사실, 이 사진은 우리에게서 멀지 않습니다. iPhone의 Siri만큼 우리에게 가깝습니다. 그 뒤에는 자동 음성 인식이 있습니다. 이 핵심 기술은 음성을 컴퓨터가 인식할 수 있는 텍스트나 명령으로 변환하여 편리하고 효율적이며 지능적인 인간-컴퓨터 상호 작용 경험을 제공할 수 있습니다.

딥러닝 등 AI 기술의 발전으로 음성 인식 기술은 비약적인 발전을 이루었습니다. 인식 정확도가 크게 향상되었을 뿐만 아니라 악센트, 소음, 배경음과 같은 문제를 더 잘 처리할 수 있게 되었습니다. 그러나 기술이 생활과 비즈니스에 계속 적용되면서 결국 이론 연구부터 실제 응용까지, 논문에서 제품에 이르기까지 고려해야 할 실제적인 요소가 너무 많습니다. 음성 인식을 개선하여 콘텐츠 검토 지원을 향상시키는 방법은 무엇입니까? 인식 행위 자체가 어떻게 맥락에 대한 이해를 바탕으로 인간의 뇌와 같아 더 적은 비용으로 더 정확한 답변을 줄 수 있을까요? NetEase Intelligence의 자회사 Yidun AI Lab이 새로운 접근 방식을 제시했습니다.

이둔은 또 하나의 검은 기술을 갖고, 스마트한 기업은 세계를 향해 나아갑니다!

최근 글로벌 스피치 및 음향학 컨퍼런스 ICASSP 2023에서 선정 논문 목록을 발표했으며, NetEase Intelligence Enterprise의 자회사인 Yidun AI Lab에서 제출한 논문이 성공적으로 승인되었습니다. 올해로 48회째를 맞는 ICASSP 컨퍼런스는 전염병 이후 처음으로 열리는 오프라인 컨퍼런스이기도 하다. 놀라운 6,000 +.

이러한 치열한 경쟁 속에서 NetEase Yidun AILab 팀은 음성 인식에 관한 논문에 의존합니다. "Improving CTC-based ASRModels with Gated Interplayer Collaboration(보다 강력한 모델 구조를 달성하기 위한 CTC 기반 모델 개선)" 그는 두각을 나타냈습니다. 그리스 로도스 오프라인 컨퍼런스 참석 티켓을 성공적으로 획득했습니다.

“GIC” 음성 인식이 더욱 발전하도록 도와줍니다

음성 인식은 기본적으로 음성 시퀀스를 텍스트 시퀀스로 변환하는 것입니다. 일반적으로 CTC, Attention-based 및 RNN-Transducer의 세 가지 모델이 사용됩니다. 작업을 완료하기 위해 다음과 같은 방법이 사용됩니다.

CTC: 신경망 모델을 기반으로 손실 함수를 최소화하기 위해 훈련 과정에서 역전파를 통해 모델 매개변수가 업데이트됩니다. 이 알고리즘은 의미 없는 문자나 공백 기호를 나타내기 위해 "공백 문자"를 도입합니다. CTC는 음성 인식에서 음향 특징을 텍스트로 매핑하는 등 입력 길이와 출력 길이의 차이가 큰 데이터를 처리하는 데 적합합니다. 주의 기반: 주의 메커니즘도 신경망 모델을 기반으로 하며 입력에 가중치를 부여하기 위해 "주의"라는 기술을 사용합니다. 각 시간 단계에서 모델은 현재 상태와 모든 입력을 기반으로 분산 가중치 벡터를 계산하고 이를 모든 입력에 적용하여 가중 평균을 출력으로 생성합니다.

이 방법을 사용하면 모델이 현재 예측과 관련된 일부 정보에 더 집중할 수 있습니다.RNN-Transducer: Transcriptor, 이 알고리즘은 인코더-디코더 프레임워크와 자동 회귀 모델링 아이디어를 결합하고 대상 시퀀스를 생성할 때 소스 언어 문장과 생성된 부분 대상 언어 문장 간의 상호 작용을 고려합니다. RNN-Transducer는 다른 두 방법과 달리 인코더와 디코더 단계를 명확하게 구분하지 않고 소스 언어에서 타겟 언어로 직접 변환하므로 소스 언어 문장과 생성된 부분 타겟 언어 문장 간의 상호 작용을 동시에 고려할 수 있습니다. 시간 효과.

후자의 두 가지와 비교하면 CTC

는 자연스러운 비자동 회귀 디코딩 속성을 갖고 있으며 디코딩 속도가 상대적으로 빠르지만 여전히 성능상의 단점이 있습니다. 1. CTC 알고리즘은 조건부 독립 가정을 설정합니다. 즉, CTC는 각 시간 단계의 출력이 독립적이라고 가정합니다. 이는 음성 인식 작업에 적합하지 않습니다. "ji rou"라는 발음이 발음되는 경우 예측되는 텍스트 내용은 상황에 따라 달라야 합니다. 위 문장이 "나는 먹는 것을 좋아한다"라면 "치킨"일 확률이 높아야 한다. 마찬가지로 위 문장이 "그는 팔이 있다"라면 "근육"일 확률이 높아야 한다.

CTC를 통해 훈련하면 위의 내용을 무시하고 "나는 근육을 먹는 것을 좋아합니다"와 같은 재미있는 텍스트가 출력되기 쉽습니다.2. 모델링 관점에서 Attention-based 모델과 RNN-Transducer 모델은 이전 시간 단계의 입력과 출력을 기반으로 현재 시간 단계의 출력을 예측하는 반면, CTC 모델은 입력만을 사용하여 예측합니다. 현재 출력 CTC 모델 모델링 프로세스에서 텍스트 정보는 감독 신호로만 네트워크에 다시 전달되며 모델 예측을 명시적으로 촉진하기 위해 네트워크에 대한 입력 역할을 하지 않습니다. 우리는 CTC 디코딩 효율성을 유지하면서 위의 두 가지 단점을 최대한 해결하기를 바랍니다. 따라서 우리는 CTC 모델 자체에서 시작하여 CTC 기반 모델에 텍스트 정보를 도입하는 경량 모듈을 설계하여 모델이 음향 및 텍스트 정보를 통합하고 텍스트 시퀀스 컨텍스트 간의 상호 작용을 학습하여 문제를 완화할 수 있도록 하고자 합니다. 의 조건부 독립 가정. 하지만 그 과정에서 우리는 두 가지 문제에 직면했습니다. CTC 모델(인코더 + CTC 구조)에 텍스트 정보를 어떻게 주입하나요? 텍스트 기능과 음향 기능을 적응적으로 융합하는 방법은 무엇입니까?

Gated Interlayer Collaboration(GIC) 메커니즘을 설계했습니다. GIC 모듈은 주로 임베딩 레이어(Embedding Layer)와 게이트 유닛(Gate Unit)으로 구성됩니다. 그 중 임베딩 레이어(Embedding Layer)는 각 오디오 입력 프레임에 대한 텍스트 정보를 생성하는 데 사용되고, 게이팅 유닛(Gating Unit)은 텍스트 정보와 음향 정보를 적응적으로 융합하는 데 사용된다.

마지막으로 생성된 텍스트 표현과 음향 표현은 게이팅 유닛을 통해 적응적으로 융합되어 다음 레이어에 입력되는 새로운 기능이 됩니다. 이번 새로운 기능은 텍스트 기능과 음향 기능을 결합하여 다음 단계의 Encoder 모듈이 음향 시퀀스 컨텍스트 정보와 텍스트 시퀀스 컨텍스트 정보를 학습할 수 있도록 합니다. 전체 모델의 프레임워크는 아래 그림에 나와 있습니다.

중국어와 영어 모두에서 장면 인식을 지원하며 정확도 측면에서 상당한 성능 향상을 달성했습니다.

디코딩 속도가 몇 배 향상됩니다.

3. 원래 CTC 모델과 비교하여 GIC는 여러 오픈 소스 데이터 세트

Conformer 모델에 따른 결론

Transformer 모델에 따른 결론

GIC는 CTC 모델의 성능을 크게 향상시킵니다. 원래 CTC 모델과 비교하여 GIC 모듈은 약 2M개의 추가 매개변수를 가져옵니다. 그 중 중간 레이어의 보조 CTC 손실을 계산하는 데 사용되는 선형 레이어는 마지막 레이어와 공유되며 추가 매개변수를 가져오지 않습니다. 여러 중간 레이어가 임베딩 레이어를 공유하여 대략 1.3M에 해당하는 256*5000개의 매개변수를 가져옵니다. 또한 다중 제어 게이트 장치에 필요한 추가 매개변수의 양은 256*256*2*k로 총 약 0.6M입니다.

선도적인 기술이 앞선 비즈니스를 만듭니다

논문의 GIC는 NetEase Yidun의 콘텐츠 리뷰 사업에 적용되었습니다.

따라서 음성 인식의 정확성은 오디오 콘텐츠 검토의 효율성 및 정확성과 밀접한 관련이 있으며 고객 비즈니스 운영의 안전과 안정성에 직접적인 영향을 미칩니다.

논문에 GIC를 적용하여 내용 검토에서 상당한 개선을 이루었습니다.

?

비하인드 영웅: NetEase Zhiqi Yidun AI Lab

이둔 AI 연구소 팀이 이 같은 사양으로 영예를 얻은 것은 이번이 처음이 아닙니다.

팀은 여러 AI 알고리즘 대회 챔피언십과 중요한 상을 수상했습니다.

2019년 제1회 중국 인공지능 대회, 국기 인식 트랙에서 가장 발전된 A급 인증서

2021년 제3회 중국 인공지능 대회, 비디오 딥페이크 탐지 및 오디오 딥페이크 탐지 트랙에 대한 두 가지 가장 진보된 A급 인증서 2021년 중국 인공지능 산업 발전 연합의 '혁신 스타'와 '혁신 인물' 2021년 제16회 전국 인간-컴퓨터 음성소통 학술대회(NCMMSC2021) "장단단영상 다국어 다중모달 인식대회" - 중국어 장단단영상 라이브 음성 키워드(VKW) 더블 트랙 챔피언 2021년 저장성 정부가 발행한 과학기술 진보상 1등상을 수상했습니다 2022 ICPR 멀티모달 자막 인식 대회(MSR Competition, 국내 최초 멀티모달 자막 인식 대회) 트랙 3 "비전과 오디오를 통합한 멀티모달 자막 인식 시스템" 우승 미래가 여기에 있습니다. AI 기반 iPhone의 시대가 도래했습니다. Yidun은 오늘 성공적으로 음성학 학원에 입학했으며, 미래에는 기술이 비즈니스의 모든 측면에 성과와 발전을 가져올 것이며 Yidun은 항상 여러분 곁에 있을 것입니다.

위 내용은 NetEase Yidun AI Lab 논문이 ICASSP 2023에 선정되었습니다! 블랙 기술을 통해 음성 인식이 더욱 '듣고' 정확해집니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

나는 Cursor AI와 함께 Vibe 코딩을 시도했는데 놀랍습니다!Mar 20, 2025 pm 03:34 PM

나는 Cursor AI와 함께 Vibe 코딩을 시도했는데 놀랍습니다!Mar 20, 2025 pm 03:34 PMVibe Coding은 끝없는 코드 라인 대신 자연 언어를 사용하여 애플리케이션을 생성함으로써 소프트웨어 개발의 세계를 재구성하고 있습니다. Andrej Karpathy와 같은 비전가들로부터 영감을 얻은이 혁신적인 접근 방식은 Dev가

Dall-E 3 사용 방법 : 팁, 예제 및 기능Mar 09, 2025 pm 01:00 PM

Dall-E 3 사용 방법 : 팁, 예제 및 기능Mar 09, 2025 pm 01:00 PMDall-E 3 : 생성 AI 이미지 생성 도구 생성 AI는 컨텐츠 생성에 혁명을 일으키고 있으며 OpenAi의 최신 이미지 생성 모델 인 Dall-E 3은 최전선에 있습니다. 2023 년 10 월에 출시 된이 제품은 전임자 인 Dall-E 및 Dall-E 2를 기반으로합니다.

2025 년 2 월 2 일 Genai 출시 : GPT-4.5, Grok-3 & More!Mar 22, 2025 am 10:58 AM

2025 년 2 월 2 일 Genai 출시 : GPT-4.5, Grok-3 & More!Mar 22, 2025 am 10:58 AM2025 년 2 월은 Generative AI의 또 다른 게임 변화 달이었으며, 가장 기대되는 모델 업그레이드와 획기적인 새로운 기능을 제공합니다. Xai 's Grok 3 및 Anthropic's Claude 3.7 Sonnet, Openai 's G에 이르기까지

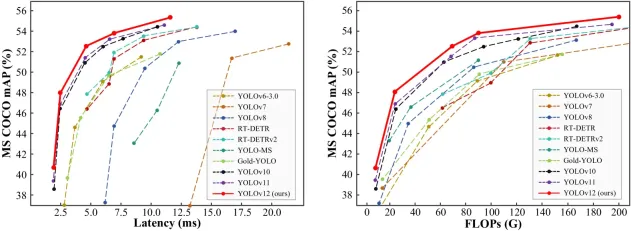

물체 감지에 Yolo V12를 사용하는 방법은 무엇입니까?Mar 22, 2025 am 11:07 AM

물체 감지에 Yolo V12를 사용하는 방법은 무엇입니까?Mar 22, 2025 am 11:07 AMYolo (한 번만 보이면)는 주요 실시간 객체 감지 프레임 워크였으며 각 반복은 이전 버전에서 개선되었습니다. 최신 버전 Yolo V12는 정확도를 크게 향상시키는 발전을 소개합니다.

Sora vs Veo 2 : 어느 것이 더 현실적인 비디오를 만드는가?Mar 10, 2025 pm 12:22 PM

Sora vs Veo 2 : 어느 것이 더 현실적인 비디오를 만드는가?Mar 10, 2025 pm 12:22 PMGoogle의 Veo 2와 Openai의 Sora : 어떤 AI 비디오 생성기가 최고를 통치합니까? 두 플랫폼 모두 인상적인 AI 비디오를 생성하지만 강점은 다른 영역에 있습니다. 다양한 프롬프트를 사용하는이 비교는 어떤 도구가 귀하의 요구에 가장 적합한지를 보여줍니다. 티

Google ' S Gencast : Gencast Mini 데모와의 일기 예보Mar 16, 2025 pm 01:46 PM

Google ' S Gencast : Gencast Mini 데모와의 일기 예보Mar 16, 2025 pm 01:46 PMGoogle Deepmind 's Gencast : 일기 예보를위한 혁신적인 AI 일기 예보는 기초 관측에서 정교한 AI 구동 예측으로 이동하여 극적인 변화를 겪었습니다. Google Deepmind의 Gencast, 획기적인

chatgpt보다 어떤 AI가 더 낫습니까?Mar 18, 2025 pm 06:05 PM

chatgpt보다 어떤 AI가 더 낫습니까?Mar 18, 2025 pm 06:05 PM이 기사에서는 AI 모델이 Lamda, Llama 및 Grok과 같은 Chatgpt를 능가하는 것에 대해 논의하여 정확성, 이해 및 산업 영향의 장점을 강조합니다. (159 자).

chatgpt 4 o를 사용할 수 있습니까?Mar 28, 2025 pm 05:29 PM

chatgpt 4 o를 사용할 수 있습니까?Mar 28, 2025 pm 05:29 PMChatGpt 4는 현재 이용 가능하고 널리 사용되며 ChatGpt 3.5와 같은 전임자와 비교하여 상황을 이해하고 일관된 응답을 생성하는 데 상당한 개선을 보여줍니다. 향후 개발에는보다 개인화 된 인터가 포함될 수 있습니다

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

VSCode Windows 64비트 다운로드

Microsoft에서 출시한 강력한 무료 IDE 편집기

맨티스BT

Mantis는 제품 결함 추적을 돕기 위해 설계된 배포하기 쉬운 웹 기반 결함 추적 도구입니다. PHP, MySQL 및 웹 서버가 필요합니다. 데모 및 호스팅 서비스를 확인해 보세요.

mPDF

mPDF는 UTF-8로 인코딩된 HTML에서 PDF 파일을 생성할 수 있는 PHP 라이브러리입니다. 원저자인 Ian Back은 자신의 웹 사이트에서 "즉시" PDF 파일을 출력하고 다양한 언어를 처리하기 위해 mPDF를 작성했습니다. HTML2FPDF와 같은 원본 스크립트보다 유니코드 글꼴을 사용할 때 속도가 느리고 더 큰 파일을 생성하지만 CSS 스타일 등을 지원하고 많은 개선 사항이 있습니다. RTL(아랍어, 히브리어), CJK(중국어, 일본어, 한국어)를 포함한 거의 모든 언어를 지원합니다. 중첩된 블록 수준 요소(예: P, DIV)를 지원합니다.

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)