집 >운영 및 유지보수 >리눅스 운영 및 유지 관리 >Linux에서 일반적으로 사용되는 nvidia-smi 명령은 무엇입니까?

Linux에서 일반적으로 사용되는 nvidia-smi 명령은 무엇입니까?

- 王林앞으로

- 2023-05-12 08:34:272924검색

소개

nvidia-smi - NVIDIA 시스템 관리 인터페이스 프로그램

nvidia smi(NVSMI라고도 함)는 Fermi 이상 아키텍처 제품군의 nvidia Tesla, Quadro, GRID 및 GeForce 장치에 대한 모니터링 및 관리 기능을 제공합니다. GeForce Titan 시리즈 장치는 대부분의 기능을 지원하며 나머지 GeForce 브랜드에 대해 제공되는 정보는 매우 제한적입니다. NVSMI는 표준 NVIDIA 드라이버가 지원하는 모든 Linux 배포판과 Windows Server 2008 R2부터 시작하는 64비트 버전의 Windows를 지원하는 크로스 플랫폼 도구입니다.

✨nvidia-smi

NVIDIA 시스템 관리 인터페이스(nvidia-smi)는 NVIDIA GPU 장치의 관리 및 모니터링을 지원하도록 설계된 NVML(NVIDIA 관리 라이브러리) 기반 명령줄 도구입니다.

이 유틸리티를 사용하면 관리자가 GPU 장치 상태를 쿼리하고 적절한 권한으로 GPU 장치 상태를 수정할 수 있습니다. Tesla, GRID, Quadro 및 Titan X 제품을 대상으로 하지만 다른 NVIDIA GPU도 지원이 제한되어 있습니다.

NVIDIA-smi는 Linux, 64비트 Windows Server 2008 R2 및 Windows 7용 NVIDIA GPU 디스플레이 드라이버와 함께 제공됩니다. Nvidia-smi는 쿼리 정보를 XML 또는 사람이 읽을 수 있는 일반 텍스트로 표준 출력이나 파일로 보고할 수 있습니다.

✨일반적으로 사용되는 nvidia-smi 명령은 모든 GPU 정보를 표시합니다.

nvidia-smi

1초마다 GPU 정보를 새로 고칩니다.

nvidia-smi -l 1

모든 현재 GPU 장치 목록을 표시합니다.

nvidia-smi -L

현재 GPU 클럭 속도, 기본 클럭 속도 및 가능한 최대 클럭 속도

nvidia-smi -q -d CLOCK

PS:

nvidia-smi 명령

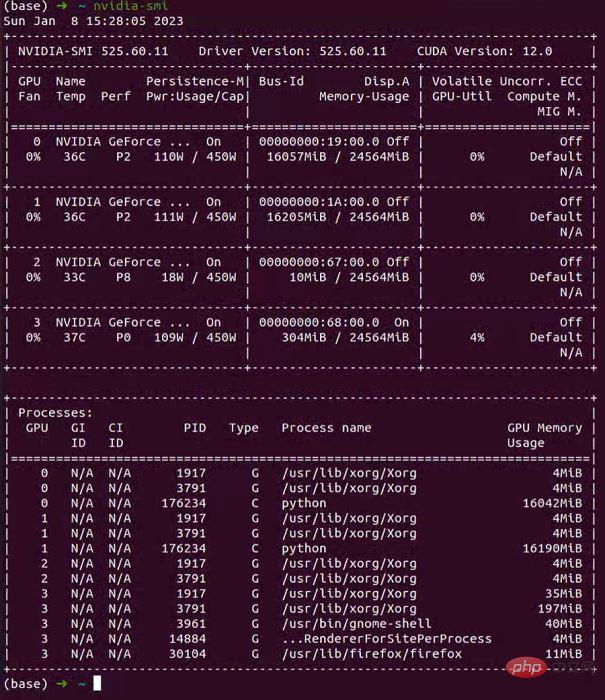

명령줄에 nvidia-smi를 직접 입력하세요. 명령은 모든 연금술사에게 익숙한 명령이어야 합니다. nvidia-smi 命令应该是各位炼丹师再熟悉不过的命令了。

注意:建议使用

watch -n 0.5 nvidia-smi참고: GPU 상태를 동적으로 관찰하려면nvidia-smi 명령을 통해 다음과 같은 정보 페이지를 얻을 수 있습니다: 🎜watch -n 0.5 nvidia-smi를 사용하는 것이 좋습니다.화 11월 9 13:47:51 2021

+------------ ---------------------------+

| NVIDIA-SMI 495.44 드라이버 버전: 495.44 CUDA 버전: 11.5 |

|------------------+--- ------+---------+

| GPU 이름 지속성-M| 버스 ID Disp.A | 휘발성 Uncorr. ECC |

| 팬 온도 성능 전력:사용량/한도| 메모리 사용량 | GPU-Util Compute M. |

| | | MIG M. |

|==============================+============ ==========+=======================|

| 0 NVIDIA GeForce ... 끄기 | 00000000:17:00.0 끄기 | 해당 없음 |

| 62% 78C P2 155W / 170W | 10123MiB / 12051MiB | 100% 기본값 |

| | | 해당 없음 |

+------------------+------------ ----------+---------+

| 1 NVIDIA GeForce ... 끄기 | 00000000:65:00.0 끄기 | 해당 없음 |

|100% 92C P2 136W / 170W | 10121MiB / 12053MiB | 99% 기본값 |

| | | 해당 없음 |

+------------------+------------ ----------+---------+

| 2 NVIDIA GeForce ... 끄기 | 00000000:B5:00.0 끄기 | 해당 없음 |

| 32% 34C P8 12W / 170W | 5MiB / 12053MiB | 0% 기본값 |

| | | 해당 없음 |

+------------------+------------ ----------+---------+

| 3 NVIDIA GeForce ... 끄기 | 00000000:B6:00.0 끄기 | 해당 없음 |

| 30% 37C P8 13W / 170W | 5MiB / 12053MiB | 0% 기본값 |

| | | 해당 없음 |

+------------------+------------ ----------+---------++-----------------------------------------------------------------------------+

| Processes: |

| GPU GI CI PID Type Process name GPU Memory |

| ID ID Usage |

|=============================================================================|

| 0 N/A N/A 1258 G /usr/lib/xorg/Xorg 6MiB |

| 0 N/A N/A 10426 C ...a3/envs/JJ_env/bin/python 10111MiB |

| 1 N/A N/A 1258 G /usr/lib/xorg/Xorg 4MiB |

| 1 N/A N/A 10427 C ...a3/envs/JJ_env/bin/python 10111MiB |

| 2 N/A N/A 1258 G /usr/lib/xorg/Xorg 4MiB |

| 3 N/A N/A 1258 G /usr/lib/xorg/Xorg 4MiB |

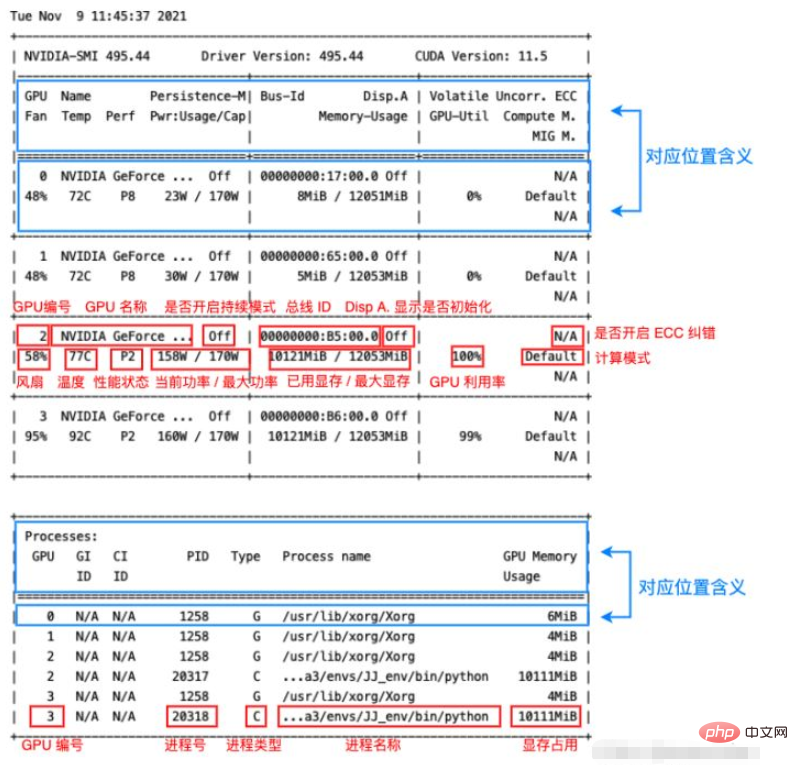

+-----------------------------------------------------------------------------+其中显存占用和 GPU 利用率当然是我们最常来查看的参数,但是在一些情况下(比如要重点监控 GPU 的散热情况时)其他参数也很有用,笔者简单总结了一下该命令输出的各个参数的含义如下图:

可以看到其中各个位置的对应含义在输出本身中其实都已经指出了(蓝框),红框则指出了输出各个部分的含义,大部分输出的作用一目了然,这里笔者将其中几个不那么直观的参数简单整理一下:

Fan:从0到100%之间变动,这个速度是计算机期望的风扇转速,实际情况下如果风扇堵转,可能打不到显示的转速。

Perf:是性能状态,从P0到P12,P0表示最大性能,P12表示状态最小性能。

Persistence-M:是持续模式的状态,持续模式虽然耗能大,但是在新的GPU应用启动时,花费的时间更少,这里显示的是off的状态。

Disp.A:Display Active,表示GPU的显示是否初始化。

Compute M:是计算模式。

Volatile Uncorr. ECC:是否开启 ECC 纠错。

type:进程类型。C 表示计算进程,G 表示图形进程,C+G 表示都有。

nvidia-smi 命令的其他参数

除了直接运行

nvidia-smi命令之外,还可以加一些参数,来查看一些本机 Nvidia GPU 的其他一些状态。下面笔者简单介绍几个常用的参数,其他的有需要可以去手册中查找:man nvidia-smi。-L

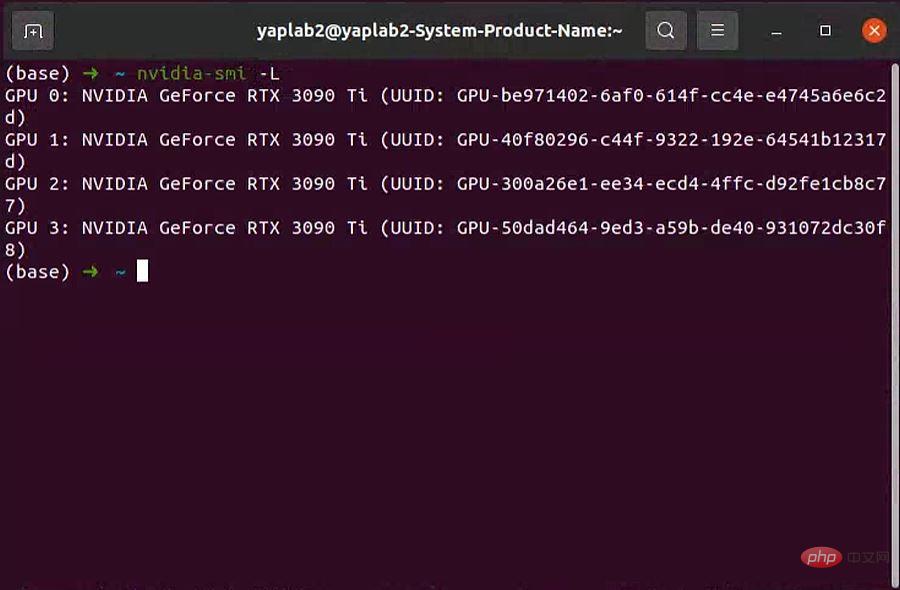

-L参数显示连接到系统的 GPU 列表。nvidia-smi -L # 输出: GPU 0: NVIDIA GeForce RTX 3060 (UUID: GPU-55275dff-****-****-****-6408855fced9) GPU 1: NVIDIA GeForce RTX 3060 (UUID: GPU-0a1e7f37-****-****-****-df9a8bce6d6b) GPU 2: NVIDIA GeForce RTX 3060 (UUID: GPU-38e2771e-****-****-****-d5cbb85c58d8) GPU 3: NVIDIA GeForce RTX 3060 (UUID: GPU-8b45b004-****-****-****-46c05975a9f0)

GPU UUID:此值是GPU的全球唯一不可变字母数字标识符。它与主板上的物理标签无关。-i

-i参数指定某个 GPU,多用于查看 GPU 信息时指定其中一个 GPU。-q

-q参数查看 GPU 的全部信息。可通过-i参数指定查看某个 GPU 的参数。如:

nvidia-smi -i 0 -q输出太长了,笔者这里就不列了,大家可以自己试一下,是很完整的信息。

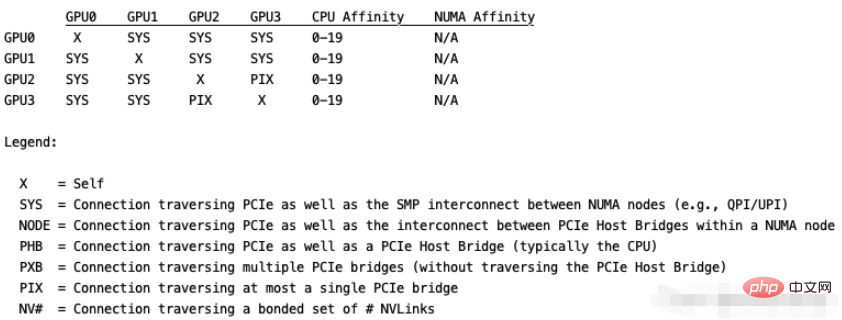

topo

topo展示多GPU系统的拓扑连接信息,通常配合-m参数即nvidia-smi topo -m,其他参数可自行查阅。输出如下,这里用代码块没法对齐,就直接贴图了:

위 내용은 Linux에서 일반적으로 사용되는 nvidia-smi 명령은 무엇입니까?의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!