트랜스포머의 선구적인 논문은 충격적인 '회전율'? 사진이 코드와 일치하지 않고, 신비한 버그가 나를 바보로 만듭니다.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-05-11 12:46:131523검색

오늘 AI서클은 충격적인 '회전율'에 충격을 받았습니다.

Google Brain NLP의 기본 작업이자 Transformer 아키텍처의 창시자인 "Attention Is All Your Need"의 다이어그램이 네티즌에 의해 코드와 일치하지 않는 것으로 나타났습니다.

문서 주소: https://arxiv.org/abs/1706.03762

트랜스포머는 2017년 출시 이후 AI 분야의 초석 왕이 되었습니다. 인기 있는 ChatGPT의 진정한 주인공도 바로 그 사람입니다.

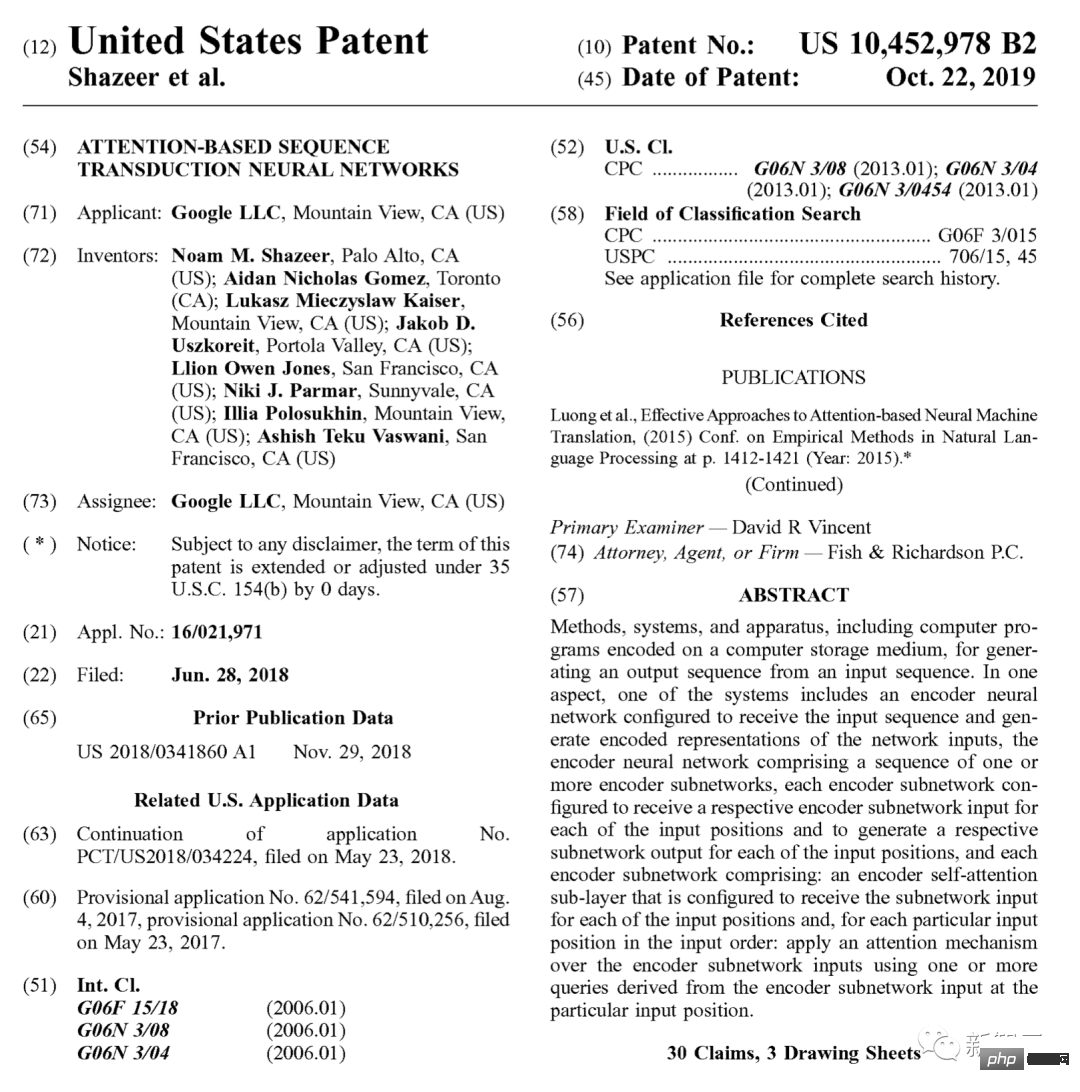

2019년에 Google은 이에 대해 특별히 특허도 출원했습니다.

원래까지 거슬러 올라가면 끝없이 흘러나오는 온갖 종류의 GPT(Generative Pre-trained Transformer)는 모두 이 17년 된 논문에서 유래되었습니다.

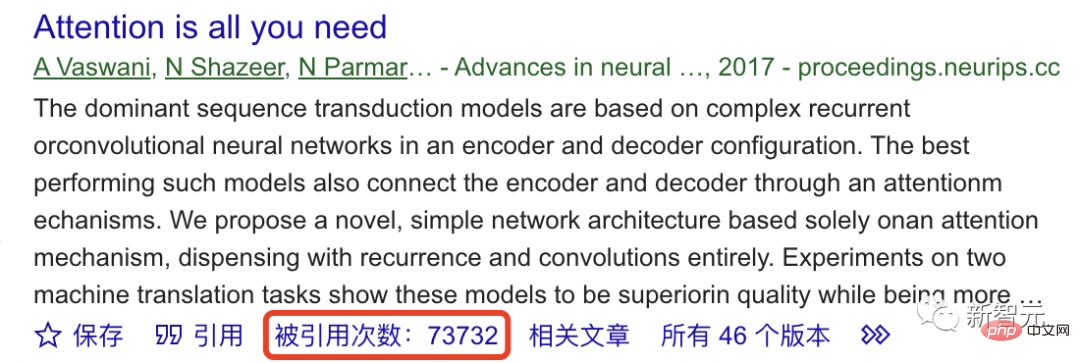

Google Scholar에 따르면 지금까지 이 기초 연구는 70,000회 이상 인용되었습니다.

그럼 ChatGPT의 초석이 안정적이지 않다는 건가요?

논문의 "창시자"로서 구조도가 실제로 잘못되었다고요?

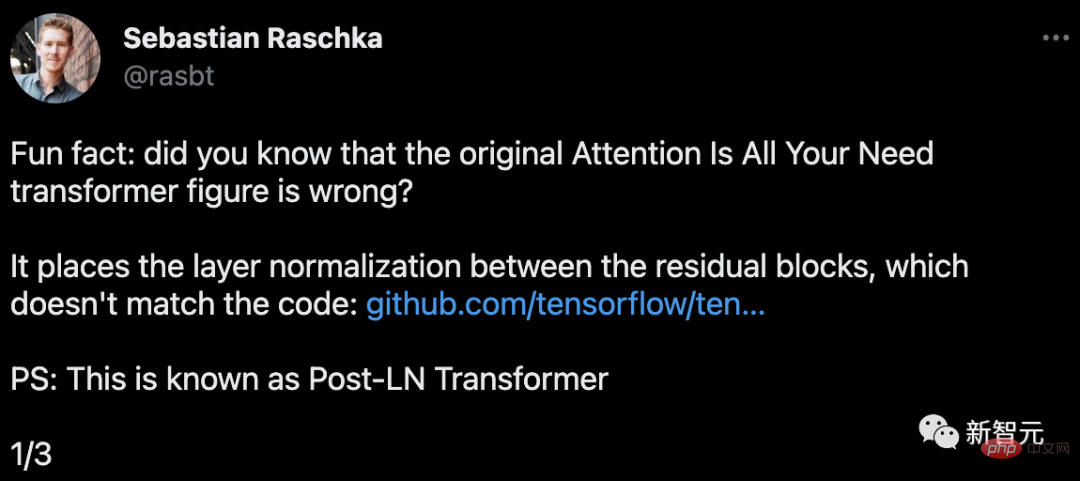

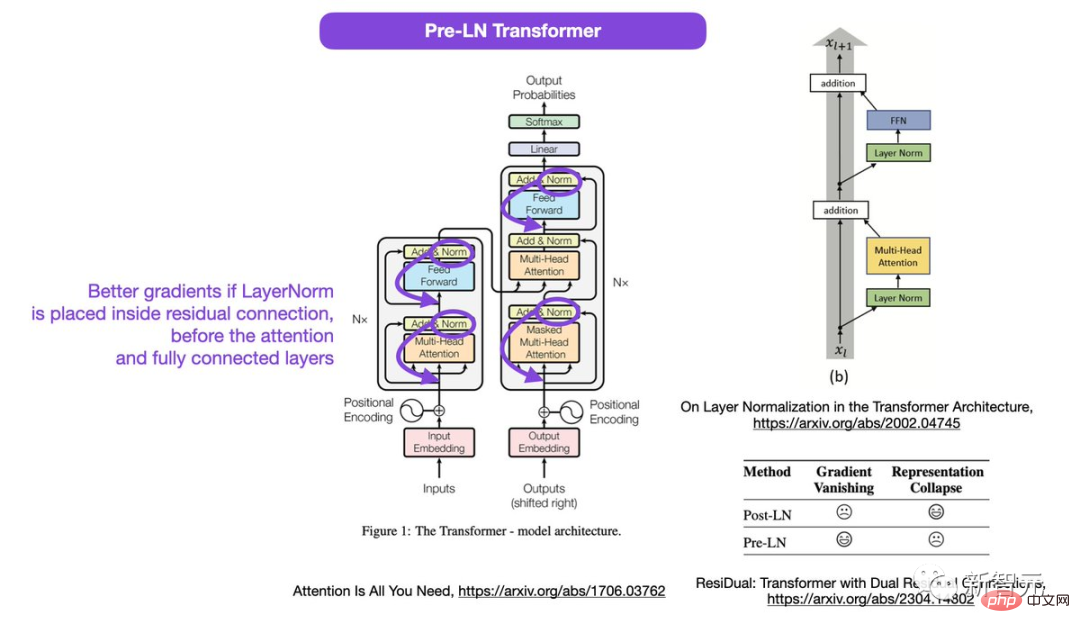

Lightning AI의 창립자이자 머신러닝 연구자인 Sebastian Raschka는 이 논문의 변환기 다이어그램이 잘못되었음을 발견했습니다.

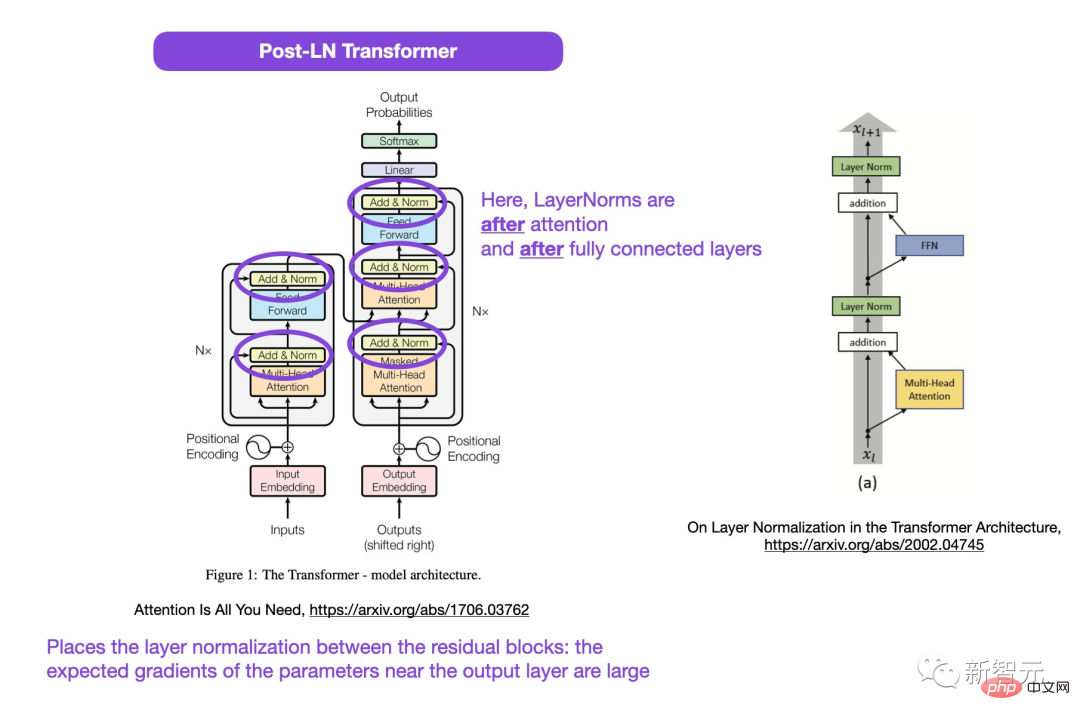

그림의 원 영역에서 LayerNorms는 주의 및 완전히 연결된 레이어 뒤에 있습니다. 잔차 블록 사이에 레이어 정규화를 배치하면 출력 레이어 근처의 매개변수에 대해 예상되는 기울기가 커집니다.

또한 이는 코드와 일치하지 않습니다.

코드 주소: https://github.com/tensorflow/tensor2tensor/commit/f5c9b17e617ea9179b7d84d36b1e8162cb369f2 5#diff-76e2b94ef16871bdbf46bf04dfe7f1477bafb884748f08197c9cf1b10a4dd78e

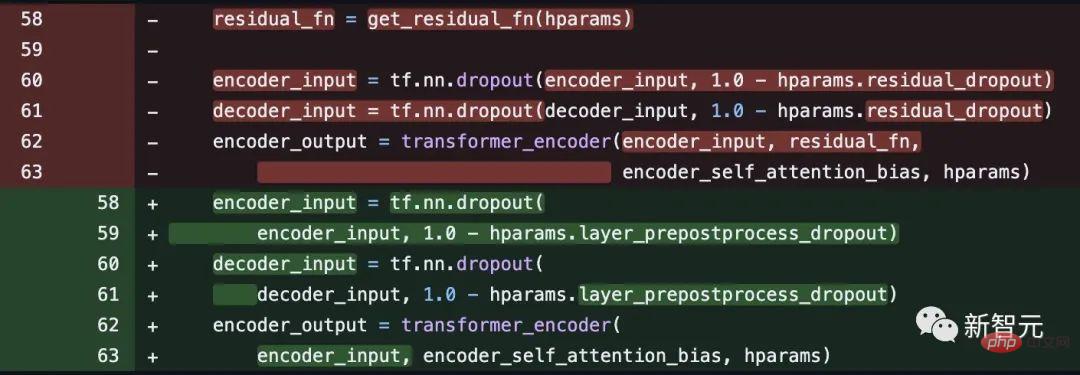

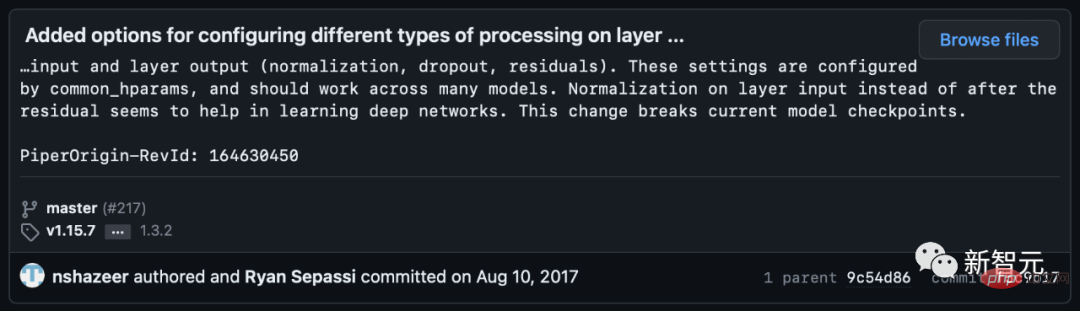

그러나 일부 네티즌들은 이를 지적했다. Noam shazeer는 몇 주 후에 코드가 수정되었습니다.

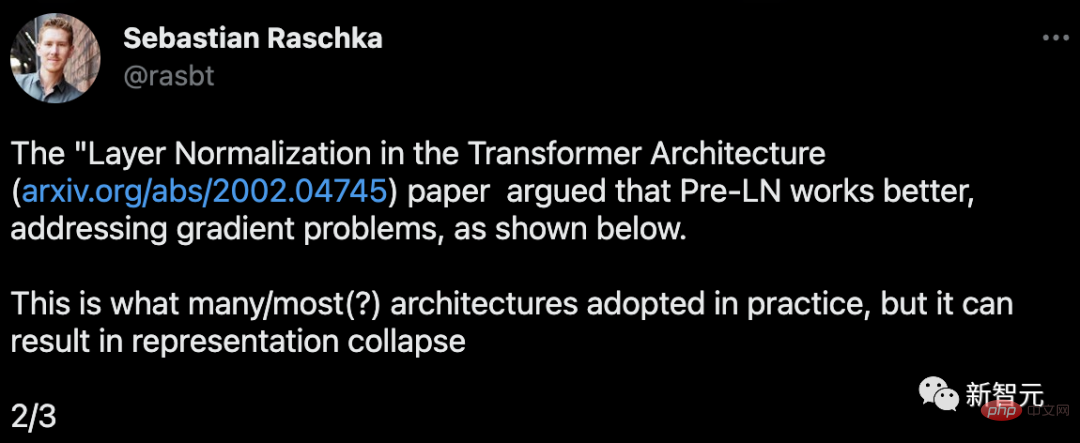

이후 Sebastian은 Layer Normalization in the Transformer Architecture 논문에서 Pre-LN이 더 나은 성능을 발휘하고 그래디언트 문제를 해결할 수 있다고 말했습니다.

이것은 많은 또는 대부분의 아키텍처가 실제로 채택하는 것이지만 표현 붕괴로 이어질 수 있습니다.

레이어 정규화가 주의 및 완전 연결 레이어 이전의 잔여 연결에 배치되면 더 나은 그라데이션이 달성됩니다.

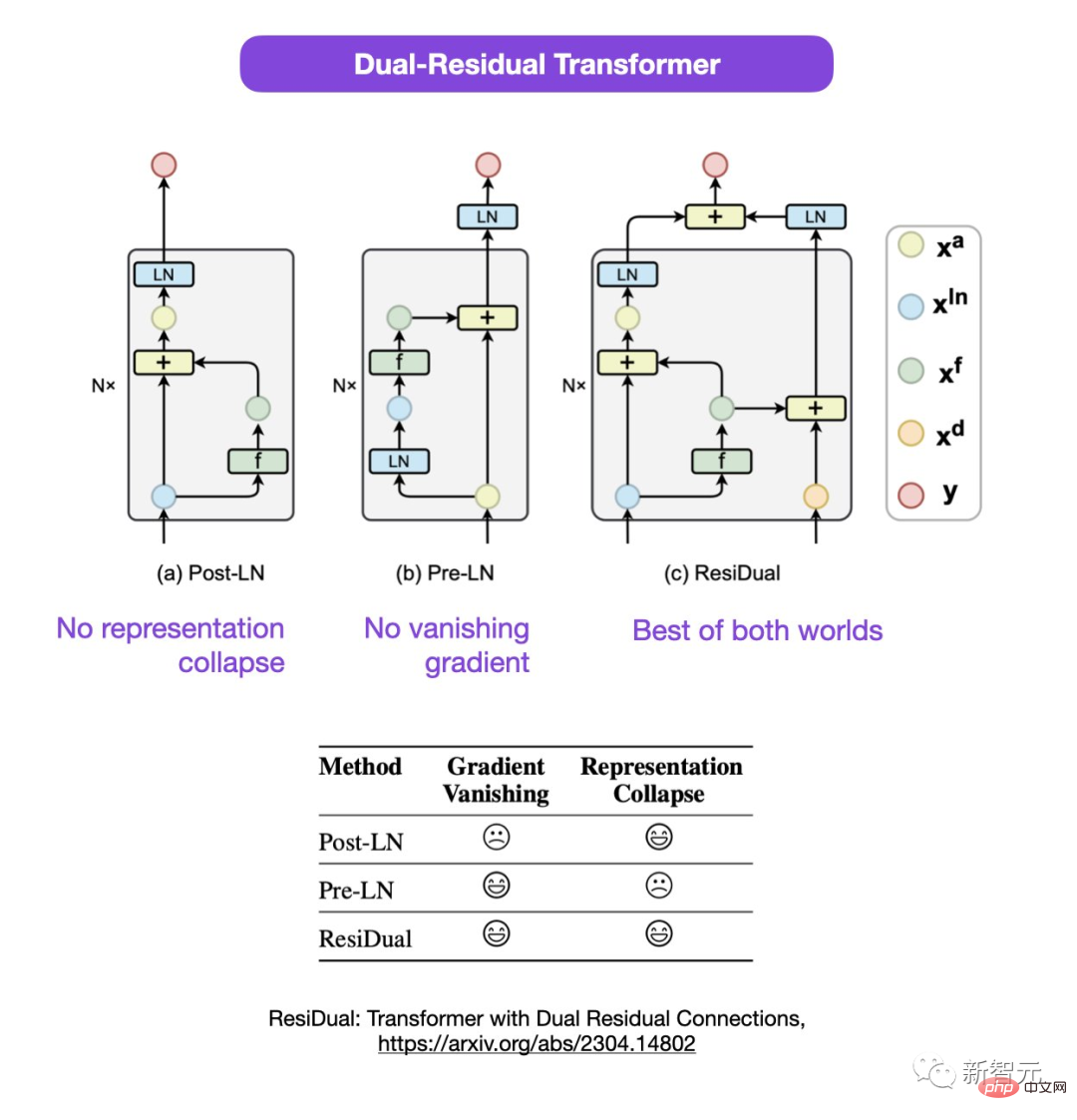

Sebastian은 Post-LN 또는 Pre-LN 사용에 대한 논의가 아직 진행 중이지만 둘을 결합하자는 새로운 논문도 있다고 제안했습니다.

논문 주소: https://arxiv.org/abs/2304.14802

이 이중 잔차 변환기에서는 표현 붕괴와 그래디언트 소멸 문제가 해결되었습니다.

네티즌들 사이에서 뜨거운 논의

논문의 의혹에 대해 일부 네티즌들은 다음과 같이 지적했습니다. 이미 PreLN과 PostLN이 중간에 있는 것 아닌가요?

세바스찬도 기분이 좀 이상하다고 대답했어요. 어쩌면 두 번째 LN이 각 변환기 블록이 아닌 마지막 출력 레이어를 참조할 수도 있지만 그 역시 확실하지 않습니다.

일부 네티즌들은 "코드나 결과가 일치하지 않는 논문을 자주 접하게 된다. 대부분은 오류로 인한 것이지만 때로는 매우 이상하기도 하다. 그리고 이 논문은 널리 유포됐다"고 말했다. 오랜만인데 왜 이런 질문이 이전에 제기되지 않았는지 정말 이상합니다.”

Sebastian은 공평하게 말하면 원본 코드는 그림과 일치하지만 그들은 코드 2017년에 버전이 수정되었으나 사진은 업데이트되지 않았습니다. 그래서 이것은 혼란스럽습니다.

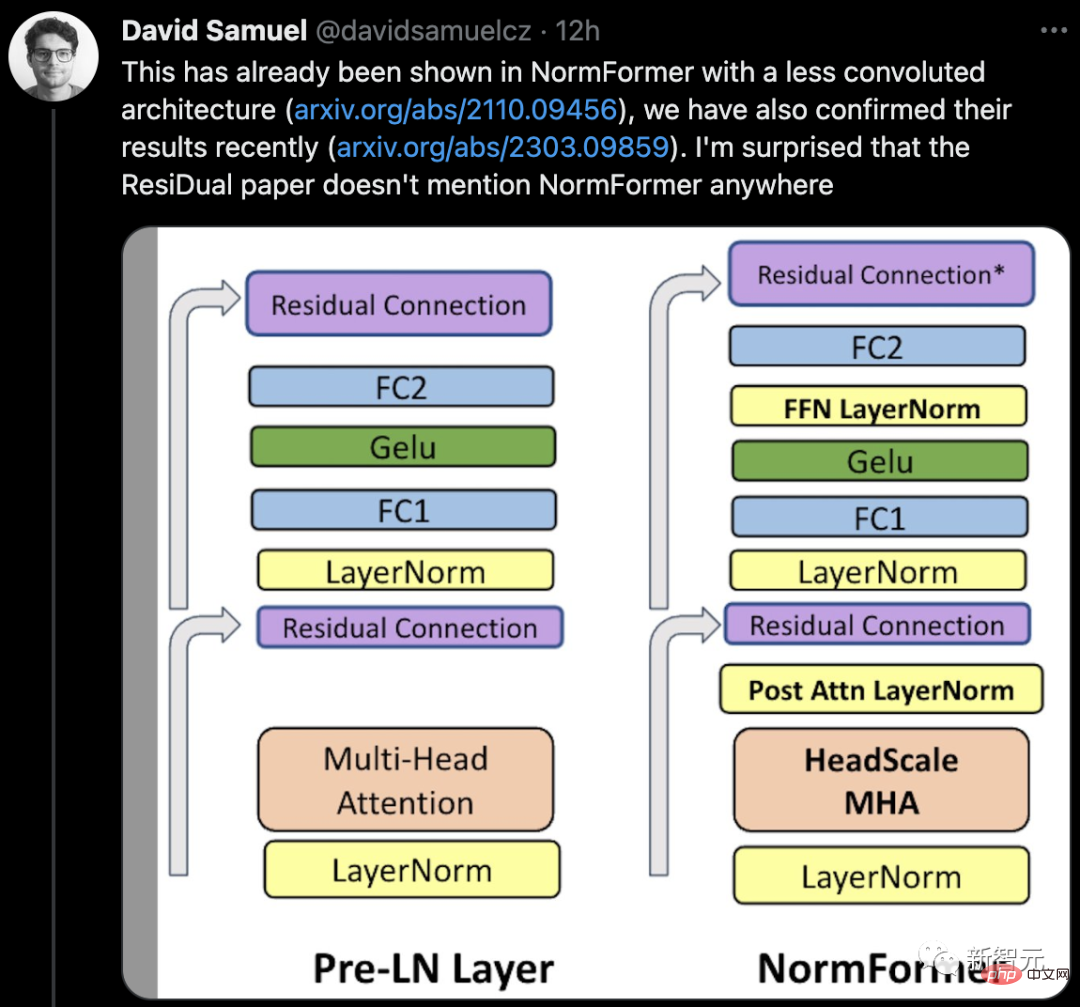

일부 네티즌들은 이미 NormFormer에 덜 복잡한 아키텍처를 보여주는 논문이 있다고 말했고, 그의 팀은 최근 그 결과를 확인했습니다. ResiDual 논문에서는 어디에서도 NormFormer를 언급하지 않고 있는데 이는 놀랍습니다.

동시에 댓글란에는 트랜스포머에서 사용한 LN이 CNN에서 사용한 방식과 다르다는 것을 확인하는 네티즌들이 계속해서 등장했습니다.

그럼 정말 신문에 허점이 있는 걸까요, 아니면 본인의 사건인 걸까요?

기다려 다음에 무슨 일이 일어나는지 지켜보겠습니다.

위 내용은 트랜스포머의 선구적인 논문은 충격적인 '회전율'? 사진이 코드와 일치하지 않고, 신비한 버그가 나를 바보로 만듭니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!