4가지 'ChatGPT 검색' 모델 종합 비교! 스탠포드 출신 중국 의사가 손으로 주석을 달았습니다. New Bing의 유창성은 가장 낮으며 문장의 거의 절반이 인용되지 않습니다.

- 王林앞으로

- 2023-05-01 23:28:09988검색

ChatGPT 출시 직후 Microsoft는 "New Bing"을 성공적으로 출시했습니다. 주가가 급등했을 뿐만 아니라 Google을 대체하고 검색 엔진의 새로운 시대를 열겠다고 위협하기도 했습니다.

하지만 New Bing이 정말 대규모 언어 모델을 재생하는 올바른 방법일까요? 생성된 답변이 실제로 사용자에게 유용합니까? 문장의 인용문은 얼마나 신빙성이 있나요?

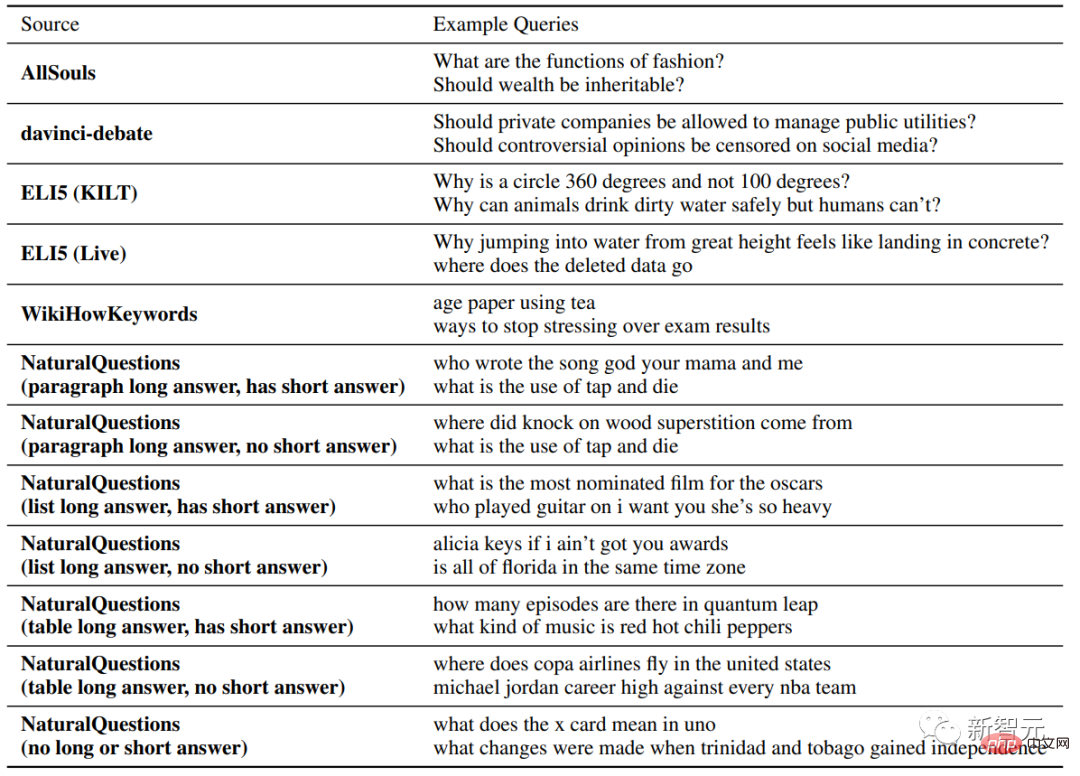

최근 Stanford 연구진은 다양한 소스에서 수많은 사용자 쿼리를 수집하고 Bing Chat, NeevaAI, perplexity.ai 및 YouChat이라는 4가지 인기 생성 검색 엔진에 대한 수동 분석을 수행했습니다.

문서 링크: https://arxiv.org/pdf/2304.09848.pdf

실험 결과에 따르면 기존에 생성된 검색 엔진의 응답은 원활하고 유익하지만 종종 증거 없는 진술이 포함되어 있는 것으로 나타났습니다. 그리고 부정확한 인용문.

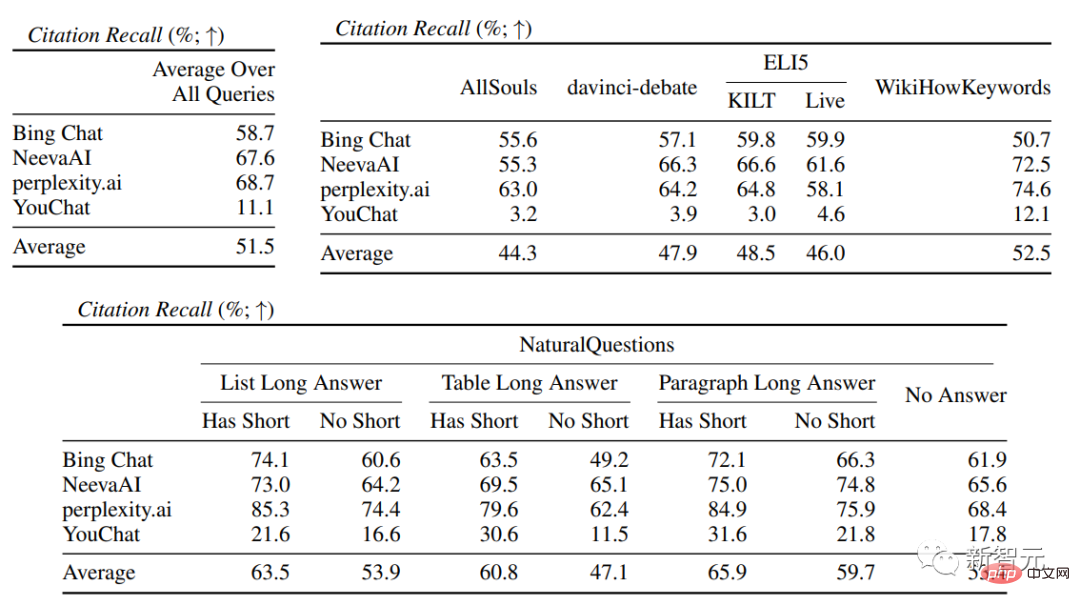

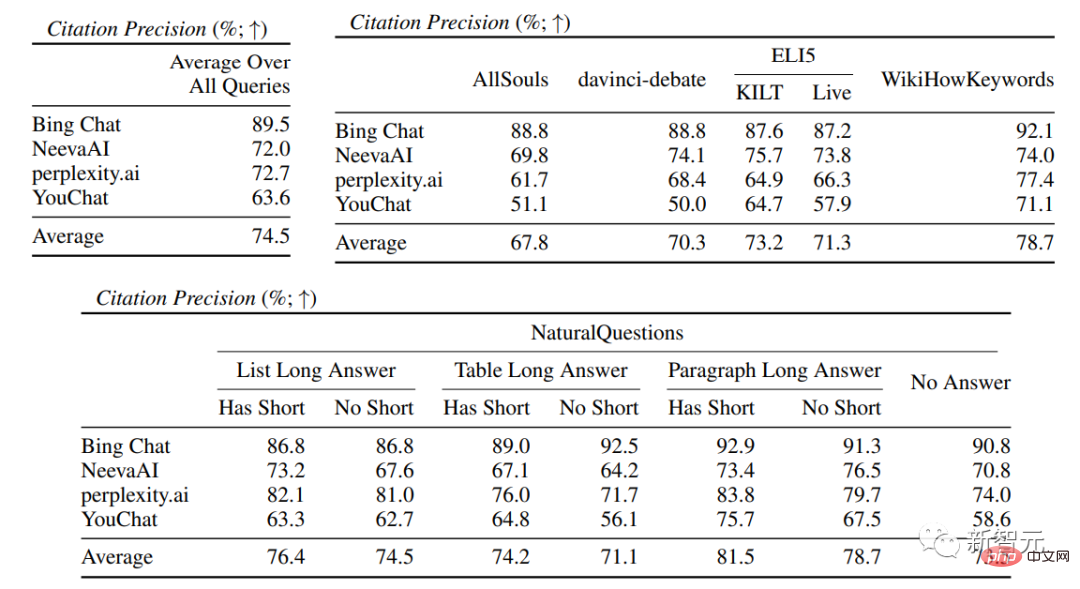

평균적으로 인용 중 51.5%만이 생성된 문장을 완전히 뒷받침할 수 있으며, 인용 중 74.5%만이 해당 문장에 대한 증거 뒷받침으로 사용될 수 있습니다.

연구원들은 특히 일부 문장이 그럴듯하고 생성적 검색 엔진이 여전히 추가로 최적화되어야 한다는 점을 고려하면 정보를 찾는 사용자를 위한 주요 도구가 될 수 있는 시스템에 대해서는 이 결과가 너무 낮다고 생각합니다.

개인 홈페이지 : https://cs.stanford.edu/~nfliu/

제1저자 Nelson Liu는 스탠포드 대학 자연어 처리 그룹의 4년차 박사 과정 학생입니다. , 그의 지도교수는 워싱턴 대학교에서 학사 학위를 취득한 Percy Liang입니다. 그의 주요 연구 방향은 실용적인 NLP 시스템, 특히 정보 검색을 위한 애플리케이션을 구축하는 것입니다.

생성 검색 엔진을 믿지 마세요

2023년 3월 Microsoft는 "일일 미리 보기 사용자의 약 3분의 1이 매일 [Bing] Chat을 사용한다"고 보고했으며 Bing Chat이 첫 번째 공개 미리 보기를 제공한다고 밝혔습니다. 한 달에 4,500만 건의 채팅 즉, 대규모 언어 모델을 검색 엔진에 통합하는 것은 시장성이 매우 높으며 인터넷 검색 입구를 바꿀 가능성이 매우 높습니다.

그러나 현재 거대 언어 모델 기술을 기반으로 하는 기존의 생성 검색 엔진은 여전히 정확도가 낮다는 문제를 안고 있으나, 구체적인 정확도가 충분히 평가되지 않아 이해가 불가능하다. 검색 엔진.

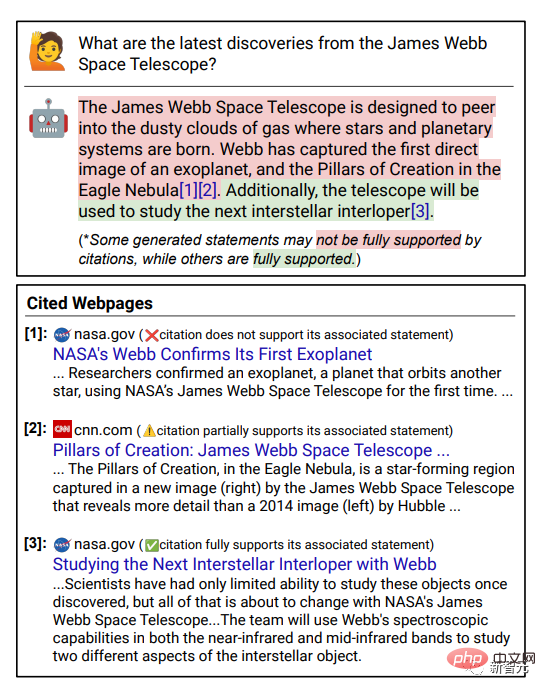

Verifiability는 검색 엔진의 신뢰성을 높이는 열쇠입니다. 즉, 생성된 답변의 각 문장에 대한 증거 지원으로 인용에 대한 외부 링크를 제공하여 사용자가 답변 정도를 더 쉽게 확인할 수 있도록 하는 것입니다. 정확성.

연구원들은 다양한 유형과 소스의 질문을 수집하여 4개의 상용 생성 검색 엔진(Bing Chat, NeevaAI, perplexity.ai, YouChat)에 대해 수동 평가를 수행했습니다.

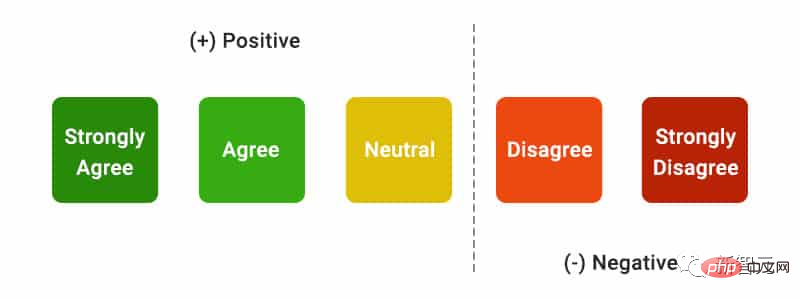

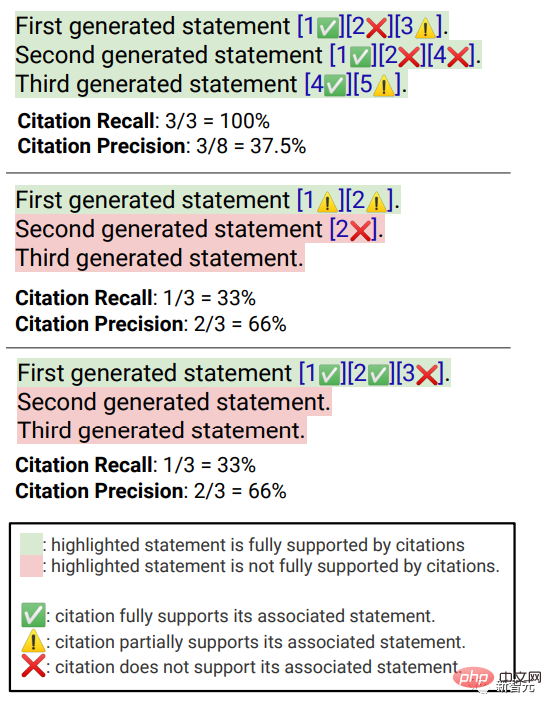

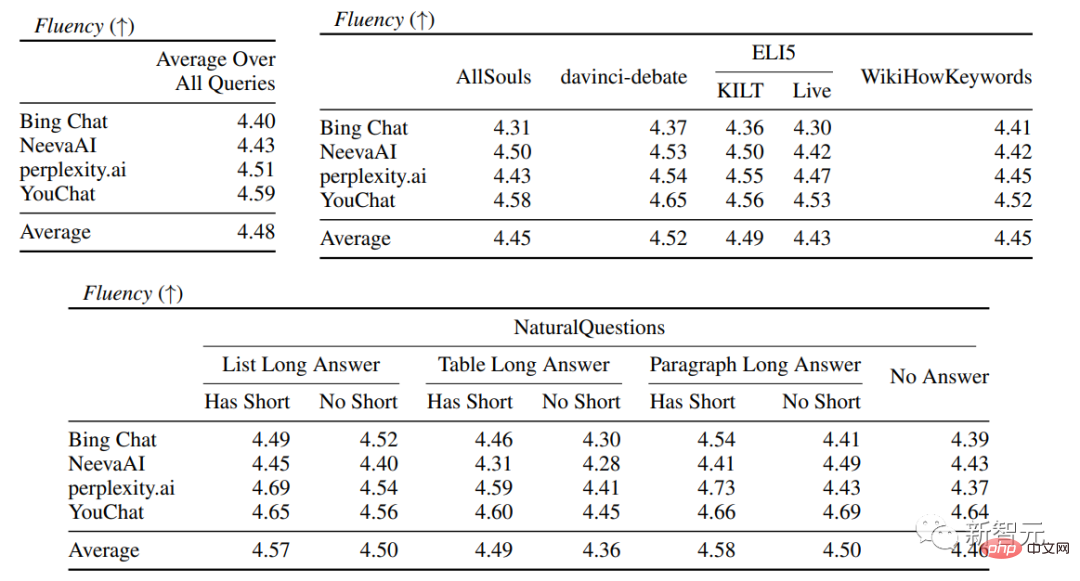

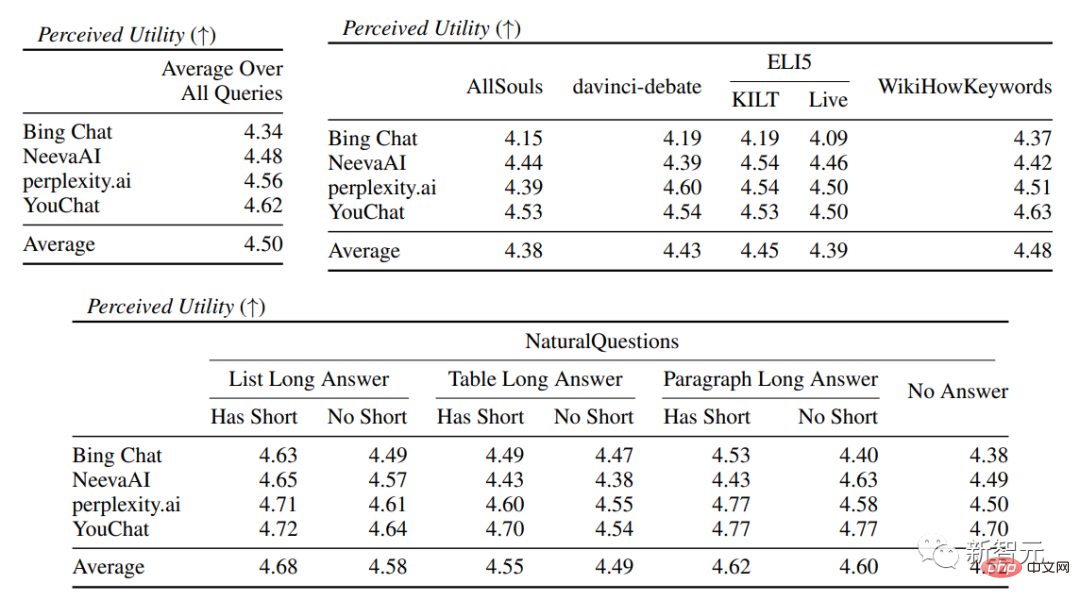

평가 지표에는 주로 유창성, 즉 생성된 텍스트가 일관성이 있는지 유용성이 포함됩니다. 답변 내용 정보가 문제를 해결할 수 있는지 여부 Citation Recall, 즉 인용 지원이 포함된 외부 웹사이트에 대해 생성된 문장의 비율 관련 문장. Fluency 는 사용자 쿼리, 생성된 응답 및 "응답이 유창하고 의미상 일관성이 있습니다."라는 설명을 동시에 표시합니다. 주석자는 5점 Likert 척도로 데이터의 점수를 매깁니다. 인식된 유용성 유창함과 마찬가지로 주석 작성자는 응답이 사용자의 쿼리에 유용하고 유익하다는 믿음을 평가해야 합니다. 인용 회상 인용 회상은 관련 인용에 의해 완전히 뒷받침되는 검증할 가치가 있는 문장의 비율을 의미하므로 이 지표를 계산하려면 답글에서 검증할 가치가 있는 문장을 결정해야 합니다. . 검증할 가치가 있는 각 문장이 관련 인용에 의해 뒷받침되는지 여부를 평가합니다. "검증할 가치가 있는 문장 식별" 과정에서 연구자들은 외부 세계에 대해 생성된 모든 문장은 명백하고 사소한 상식처럼 보일 수 있는 문장이라도 검증할 가치가 있다고 믿습니다. 일부 독자에게는 명백한 "상식"이지만 정확하지 않을 수도 있습니다. 검색 엔진 시스템의 목표는 외부 세계에 대해 생성된 모든 문장에 대한 참조 소스를 제공하여 독자가 단순성을 위해 검증 가능성을 희생하지 않고도 생성된 응답의 모든 서술을 쉽게 확인할 수 있도록 하는 것입니다. 사실, 어노테이터는 "언어 모델로서 나는..."과 같은 시스템이 1인칭인 응답이나 질문에 대한 질문을 제외하고 생성된 모든 문장을 확인합니다. user , "더 알고 싶으세요?" 평가"검증할 가치가 있는 진술이 관련 인용에 의해 완전히 뒷받침되는지 여부"는 식별된 소스에 기인(AIS, 식별된 소스에 기인)평가 프레임워크를 기반으로 할 수 있으며, 주석자는 이진 주석을 수행합니다. 일반 청취자가 "인용된 웹 페이지에 기초하여 다음과 같이 결론을 내릴 수 있습니다..."에 동의하는 경우 인용은 답변을 완전히 뒷받침합니다. 인용 정밀도 인용의 정밀도를 측정하려면 주석 작성자는 각 인용이 관련 문장에 대해 전체, 부분 또는 관련 없는 지원을 제공하는지 판단해야 합니다. 완전한 지원: 문장의 모든 정보는 인용에 의해 뒷받침됩니다. 부분 지원: 문장의 일부 정보는 인용에 의해 뒷받침되지만 다른 부분은 누락되거나 모순될 수 있습니다. 부적절한 지원(지원하지 않음): 참조된 웹페이지가 전혀 관련이 없거나 모순되는 경우. 관련 인용이 여러 개인 문장의 경우 주석 작성자는 추가적으로 AIS 평가 프레임워크를 사용하여 모든 관련 인용 웹 페이지가 전체적으로 문장에 대한 충분한 지원을 제공하는지 여부를 결정해야 합니다(이진 판단). 유창성 및 유용성 평가에서 각 검색 엔진은 매우 원활하고 유용한 답변을 생성할 수 있음을 알 수 있습니다. 특정 검색 엔진 평가에서는 Bing Chat의 유창성/유용성 점수가 가장 낮습니다(4.40/4.34), NeevaAI(4.43/4.48), ai(4.51)가 그 뒤를 이었습니다. /4.56) 및 YouChat(4.59/4.62)입니다. 다양한 사용자 쿼리 카테고리에서는 일반적으로 짧은 검색 질문이 긴 질문보다 더 매끄럽고 일반적으로 사실적 지식만 대답하는 것으로 볼 수 있습니다. 일부 어려운 질문에는 일반적으로 다른 테이블이나 웹 페이지가 요약되어 있으며 합성 프로세스가 필요합니다. 전반적인 유창성이 감소합니다. 인용 평가에서 기존 생성 검색 엔진은 웹 페이지를 완전하거나 정확하게 인용하지 못하는 경우가 종종 있음을 알 수 있습니다. 평균적으로 생성된 문장 중 51.5%만이 인용(회상률)으로 완전히 지원되며, 생성된 문장의 74.5%가 인용에 의해 완전히 뒷받침됩니다(회상율). 인용은 관련된 문장을 완전히 뒷받침합니다(정확성). 이 값은 이미 수백만 명의 사용자가 있는 검색 엔진 시스템에 허용되지 않습니다. 특히 생성된 응답에 많은 양의 정보가 포함되어 있는 경향이 있는 경우 더욱 그렇습니다. 그리고다양한 생성 검색 엔진 사이에는 인용 회수율과 정밀도에 큰 차이가 있습니다. perplexity.ai가 가장 높은 회수율(68.7)을 달성한 반면 NeevaAI(67.6), Bing Chat(58.7) 및 YouChat(11.1) 더 낮습니다. 반면, Bing Chat은 다양한 사용자 쿼리에서 가장 높은 정확도(89.5)를 달성했으며 perplexity.ai(72.7), NeevaAI(72.0) 및 YouChat(63.6) 이 그 뒤를 이었습니다. 긴 답변이 있는 NaturalQuestions 쿼리와 Non-NaturalQuestions 쿼리 간의 재현율 격차는 11%에 가깝습니다(각각 58.5 및 47.8). 답변에 대한 NaturalQuestions 쿼리 간의 인용 재현율은 10%에 가깝습니다(단답이 있는 쿼리의 경우 63.4, 긴 답변만 있는 쿼리의 경우 53.6, 길거나 짧은 답변이 없는 쿼리의 경우 53.4). 질문의 경우 웹 지원이 없으면 인용률이 낮아집니다. 예를 들어 개방형 AllSouls 에세이 질문을 평가할 때 생성 검색 엔진의 인용 회수율은 44.3

실험 결과

위 내용은 4가지 'ChatGPT 검색' 모델 종합 비교! 스탠포드 출신 중국 의사가 손으로 주석을 달았습니다. New Bing의 유창성은 가장 낮으며 문장의 거의 절반이 인용되지 않습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!