연구에 따르면 데이터 소스는 여전히 AI의 주요 병목 현상입니다.

- 王林앞으로

- 2023-04-28 11:49:061299검색

데이터는 기계의 생명선입니다. 그것이 없으면 AI와 관련된 어떤 것도 만들 수 없습니다. 이번 주에 발표된 Appen의 AI 및 기계 학습 현황 보고서에 따르면 많은 조직이 여전히 AI 및 기계 학습 이니셔티브를 유지하기 위해 양질의 깨끗한 데이터를 얻기 위해 고군분투하고 있습니다.

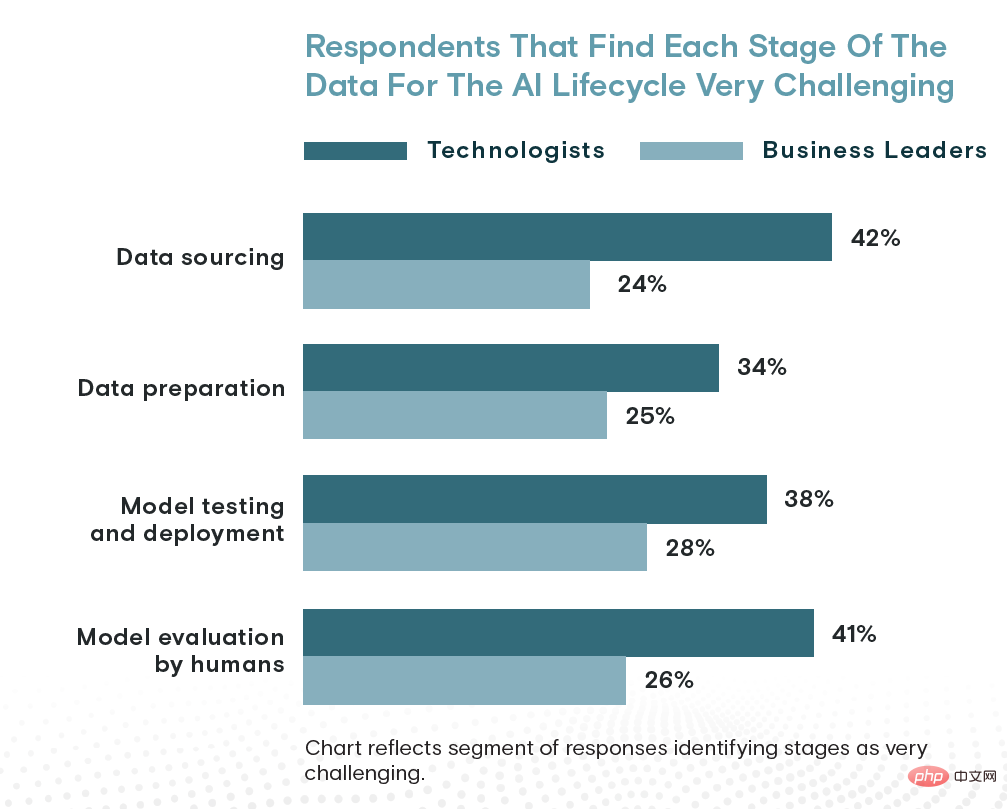

인공지능에 대한 Appen의 조사에 따르면 인공지능의 4단계(데이터 조달, 데이터 준비, 모델 훈련 및 배포, 인간 주도 모델 평가) 중에서 데이터 조달은 가장 많은 리소스를 소비하고 가장 많은 시간이 소요되며 가장 도전적인. 504명의 비즈니스 리더와 기술 전문가.

Harris Poll이 IT를 포함하여 실시한 Appen의 설문 조사에 따르면 평균적으로 데이터 조달은 조직 AI 예산의 34%를 소비하고, 데이터 준비와 모델 테스트 및 배포는 각각 24%, 모델 평가는 15%를 차지합니다. 미국, 영국, 아일랜드, 독일 출신의 의사 결정자, 비즈니스 리더, 관리자, 기술 실무자들이 모였습니다.

시간 측면에서 데이터 조달은 조직 시간의 약 26%를 소비하는 반면, 데이터 준비와 모델 테스트, 배포 및 모델 평가는 각각 24%와 23%를 차지합니다. 마지막으로, 기술자의 42%는 모델 평가(41%), 모델 테스트 및 배포(38%), 데이터 준비(34%)에 비해 데이터 소싱을 AI 수명주기의 가장 어려운 단계로 간주합니다.

기술 전문가에 따르면 데이터 소싱은 인공지능이 직면한 가장 큰 과제입니다. 하지만 비즈니스 리더들은 상황을 다르게 봅니다…

어려움에도 불구하고 조직은 이를 실현하고 있습니다. Appen에 따르면 응답자의 5분의 4(81%)가 AI 이니셔티브를 지원하기에 충분한 데이터를 보유하고 있다고 확신한다고 말했습니다. 아마도 이러한 성공의 열쇠는 바로 대다수(88%)가 Appen과 같은 외부 AI 교육 데이터 제공업체를 사용하여 데이터를 늘리고 있다는 것입니다.

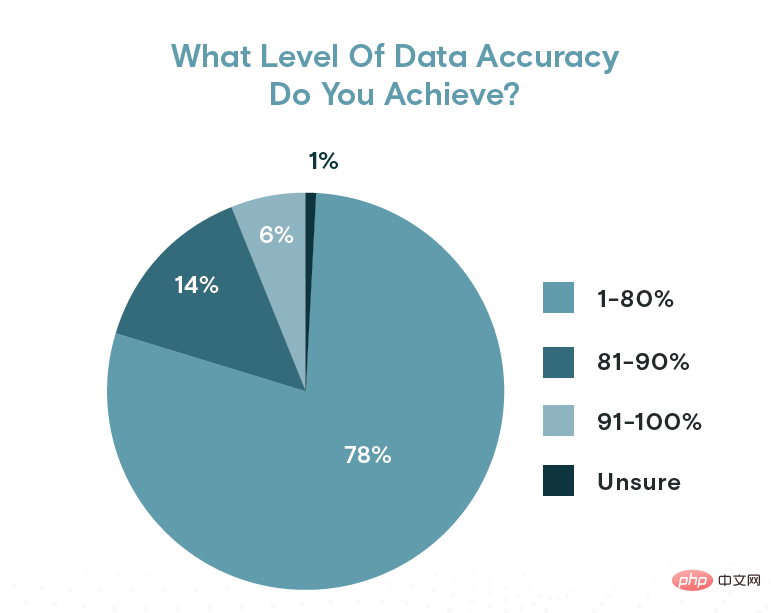

그러나 데이터의 정확성은 의심스럽습니다. Appen은 응답자의 20%만이 80% 이상의 데이터 정확도를 보고한 것으로 나타났습니다. 단지 6%(약 10명 중 1명)만이 자신의 데이터가 90% 정확하거나 더 좋다고 답했습니다. 즉, 80% 이상의 조직에서 데이터 5개 중 1개에는 오류가 포함되어 있습니다.

Appen의 설문 조사에 따르면 이를 염두에 두고 거의 절반(46%)의 응답자가 데이터 정확성이 "그러나 수정할 수 있다"는 데 동의하는 것은 놀라운 일이 아닐 것입니다. 2%만이 데이터 정확성이 크게 필요하지 않다고 답했고, 51%는 데이터 정확성이 매우 중요하다고 동의했습니다.

데이터 품질의 중요성에 대한 Appen CTO Wilson Pang의 의견은 데이터 품질이 중요하지 않다고 생각하는 고객의 48%와 일치하는 것으로 보입니다.

보고서에서 Pang은 “품질이 풍부한 데이터로 인해 더 나은 모델 출력과 일관된 처리 및 의사 결정이 이루어지기 때문에 데이터 정확도는 AI 및 ML 모델의 성공에 매우 중요합니다.”라고 말했습니다. “좋은 결과를 얻으려면 데이터 세트가 정확하고 포괄적이며 확장 가능해야 합니다.”

Appen 응답자의 90% 이상이 사전 레이블이 지정된 데이터를 사용한다고 말했습니다.

Pang은 최근 인터뷰에서 딥 러닝의 부상에 대해 말했습니다. 데이터 중심 AI는 AI 성공의 원동력을 우수한 데이터 과학 및 기계 학습 모델링에서 우수한 데이터 수집, 관리 및 라벨링으로 전환했습니다. 이는 AI 실무자가 사전 훈련된 대규모 언어 또는 컴퓨터 비전 모델을 활용하고 자체 데이터로 소규모 레이어 세트를 재교육하는 오늘날의 전이 학습 기술의 경우 특히 그렇습니다.

더 나은 데이터는 불필요한 편견이 AI 모델에 스며드는 것을 방지하고 일반적으로 AI 결과가 좋지 않은 것을 방지하는 데 도움이 될 수 있습니다. Appen의 AI 수석 이사인 Ilia Shifrin은 특히 대규모 언어 모델의 경우에 그렇습니다.

Shifrin은 보고서에서 “다국어 웹 크롤러 데이터에 대해 훈련된 대규모 언어 모델(LLM)이 증가하면서 기업은 또 다른 과제에 직면하게 되었습니다.”라고 말했습니다. "이러한 모델은 학습 자료의 인종, 성별, 종교적 편견뿐만 아니라 풍부한 독성 언어로 인해 종종 나쁜 행동을 나타냅니다.

웹 데이터의 편견은 몇 가지 해결 방법이 있지만 몇 가지 까다로운 문제를 야기합니다. 학습 데이터 및 모델 출력 필터링, 인간 피드백 및 테스트를 통한 학습) 그러나 "인간 중심" LLM 벤치마크 및 모델 평가 방법에 대한 좋은 표준을 확립하려면 더 많은 연구가 필요하다고 Shifrin은 말했습니다.

Appen에 따르면 데이터 관리는 AI가 직면한 가장 큰 장애물로 남아 있습니다. 조사 결과, AI 사이클에 속한 사람들 중 41%가 데이터 관리가 가장 큰 병목 현상이라고 생각하는 것으로 나타났습니다. 데이터 부족은 4위로 30%가 AI 성공의 가장 큰 장애물로 꼽았습니다.

하지만 좋은 소식이 있습니다. 조직에서 데이터를 관리하고 준비하는 데 소요되는 시간이 감소 추세에 있다는 것입니다. Appen은 작년 보고서의 53%에 비해 올해는 47%를 조금 넘는 수준이라고 말했습니다.

데이터 정확도 수준은 일부 조직이 원하는 만큼 높지 않을 수 있습니다

“대부분의 응답자가 외부 데이터 제공업체를 사용하는 상황에서 데이터 소싱 및 준비를 아웃소싱함으로써 데이터 과학자가 적절하게 관리하는 데 걸리는 시간을 절약하고 있다고 추론할 수 있습니다. , 데이터를 정리하고 라벨링하는 데 시간이 필요합니다."라고 데이터 라벨링 회사는 말했습니다.

그러나 데이터의 상대적으로 높은 오류율로 판단할 때 조직은 데이터 소싱 및 준비 프로세스(내부 또는 외부)를 축소해서는 안 됩니다. AI 프로세스를 구축하고 유지하는 데는 경쟁적인 요구 사항이 많이 있습니다. 자격을 갖춘 데이터 전문가를 고용하는 것이 Appen이 파악한 또 다른 주요 요구 사항이었습니다. 그러나 데이터 관리에 상당한 진전이 있을 때까지 조직은 팀에 계속해서 데이터 품질의 중요성을 강조하도록 압력을 가해야 합니다.

또한 설문 조사에 따르면 조직의 93%가 윤리적 AI가 AI 프로젝트의 "기초"가 되어야 한다는 데 강력하게 또는 어느 정도 동의하는 것으로 나타났습니다. Appen CEO인 Mark Brayan은 좋은 시작이었지만 아직 해야 할 일이 더 많다고 말했습니다. Brayan은 보도 자료에서 "문제는 많은 사람들이 열악한 데이터 세트로 훌륭한 AI를 구축하려는 과제에 직면하고 있으며 이는 목표 달성에 심각한 장애물이 된다는 것입니다."라고 말했습니다.

Appen의 보고서에 따르면 사내에서 맞춤 수집된 데이터는 AI에 사용되는 조직의 데이터 세트의 대부분으로 남아 있으며 전체 데이터의 38%~42%를 차지합니다. 합성 데이터는 놀라울 정도로 강력한 성능을 발휘하여 조직 데이터의 24~38%를 차지했으며, 사전 레이블이 지정된 데이터(일반적으로 데이터 서비스 제공업체에서 제공)는 데이터의 23~31%를 차지했습니다.

특히 합성 데이터는 민감한 AI 프로젝트에서 편향 발생률을 줄일 수 있는 잠재력을 가지고 있으며, Appen 응답자의 97%는 "포괄적인 교육 데이터 세트를 개발할 때" 합성 데이터를 사용한다고 답했습니다.

보고서의 다른 흥미로운 결과는 다음과 같습니다.

- 77%의 조직이 월별 또는 분기별로 모델을 재교육합니다.

- 55%의 미국 조직이 경쟁사보다 앞서 있다고 주장하는 반면, 유럽의 44%는

- 2021년 인공지능 현황 보고서의 51%와 비교하여 조직은 AI의 "광범위한" 출시를 보고합니다.

- 7%의 조직이 AI 예산이 500만 달러를 초과한다고 보고했습니다. 이는 작년의 9%와 비교됩니다.

위 내용은 연구에 따르면 데이터 소스는 여전히 AI의 주요 병목 현상입니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!