Google과 MIT는 통합 프레임워크 MAGE를 제안합니다. 표현 학습은 MAE를 능가하고 비지도 이미지 생성은 Latent Diffusion을 능가합니다.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-04-14 20:28:011272검색

인식과 생성은 인공지능 분야의 두 가지 핵심 작업이며, 이를 하나의 시스템으로 통합할 수 있다면 이 두 작업은 상호보완적이어야 합니다. 실제로 자연어 처리에서 BERT[1]와 같은 모델은 고품질 텍스트를 생성할 수 있을 뿐만 아니라 텍스트에서 특징을 추출할 수도 있습니다.

그러나 컴퓨터 비전 분야에서 현재 이미지 생성 모델과 인식 모델의 대부분은 이 두 작업의 시너지 효과를 충분히 활용하지 못한 채 별도로 학습됩니다. 이는 주로 이미지 생성 모델과 이미지 인식 모델이 본질적인 구조적 차이를 가지고 있다는 사실에 기인합니다. 이미지 생성의 입력은 저차원 특징 또는 노이즈이고 출력은 대조적으로 고차원 원본 이미지입니다. 이미지 인식의 입력은 고차원 원본 이미지인 반면 출력은 저차원 특징입니다.

최근 MIT와 Google Research의 연구진은 이미지 의미 마스킹 기반의 표현 학습 방법을 제안했는데, 이는 최초로 통합 프레임워크에서 이미지 생성 및 표현 학습을 달성했으며, 여러 데이터 세트에서 좋은 성능을 발휘하여 SOTA 성능을 달성했습니다. 연구 논문은 CVPR 2023에 승인되었으며, 관련 코드와 사전 학습된 모델은 오픈 소스로 제공됩니다.

- 논문 주소: https://arxiv.org/abs/2211.09117

- 코드 주소: https://github.com/LTH14/mage

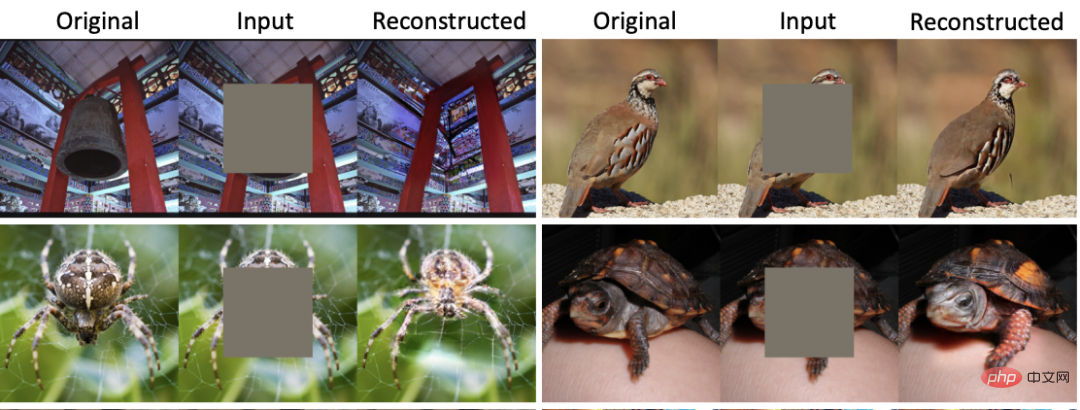

CVPR 2022에서 MAE [2]는 이미지 마스크(MIM) 기반의 표현 학습 방법을 제안했으며 여러 하위 작업에서 매우 좋은 결과를 얻었습니다. 최대 75%의 마스킹 비율로 MAE는 원본 이미지의 의미와 거의 일치하는 이미지를 재구성할 수 있으므로 네트워크가 이미지의 특징을 자가 지도 학습할 수 있습니다. 그러나 그림 1과 같이 MAE를 통해 재구성된 이미지는 원본 이미지와 유사한 의미 정보를 갖고 있음에도 불구하고 심각한 흐려짐(blurring) 및 왜곡 문제가 발생한다. 모든 MIM 기반 표현 학습 방법에서도 비슷한 문제가 발생합니다. 동시에 확산 모델이든 GAN이든 현재 생성 모델에는 고품질 이미지 특징을 추출하는 기능이 부족합니다.

그림 1: MAE와 MAGE 재구성의 비교

방법 개요

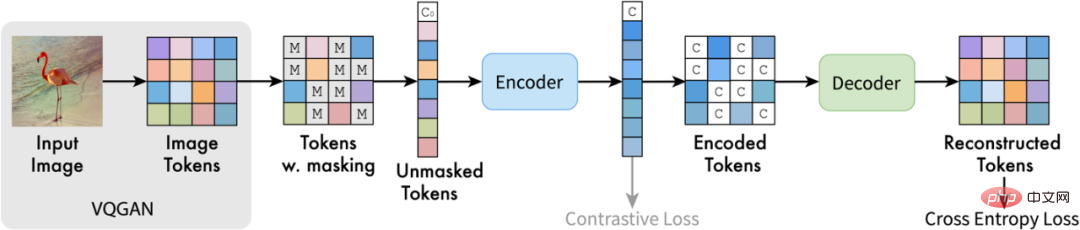

위의 문제에 대해 이 기사의 저자는 MAGE(Masked Generative Encoder)를 제안했습니다. , 통합된 이미지 생성 및 특징 추출 모델을 달성했습니다. MIM이 이미지에 직접 작용하는 마스킹 방식과 달리, MAGE는 이미지 의미 기호 기반의 마스킹된 이미지 토큰 모델링 방법을 제안합니다. 그림에서 볼 수 있듯이 MAGE는 먼저 VQGAN [3] 인코더를 사용하여 원본 이미지를 개별 의미 기호로 변환합니다. 이후 MAGE는 이를 무작위로 마스크하고 변환기 기반 인코더-디코더 구조를 사용하여 마스크를 재구성합니다. 재구성된 의미 기호는 VQGAN 디코더를 통해 원본 이미지를 생성하는 데 사용될 수 있습니다. 훈련에서 다양한 마스킹 비율을 사용함으로써 MAGE는 생성 모델(거의 100% 마스킹 비율)과 표현 학습(50%-80% 마스킹 비율)을 모두 훈련할 수 있습니다. 그림 1에서 볼 수 있듯이 MAGE를 통해 재구성된 이미지는 원본 이미지와 일치하는 의미 정보를 가질 뿐만 아니라 생성된 이미지의 다양성과 진정성을 동시에 보장할 수 있습니다.

그림 2: MAGE 구조 다이어그램

실험 결과

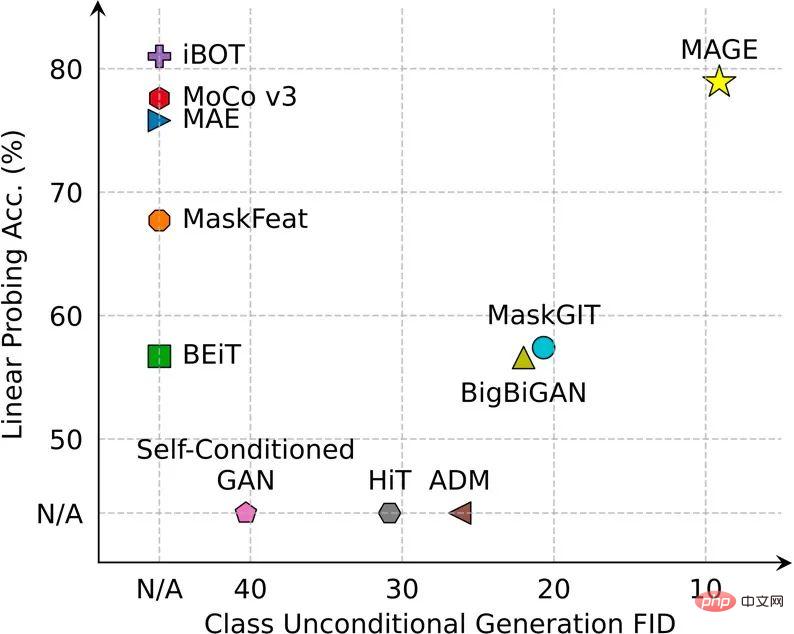

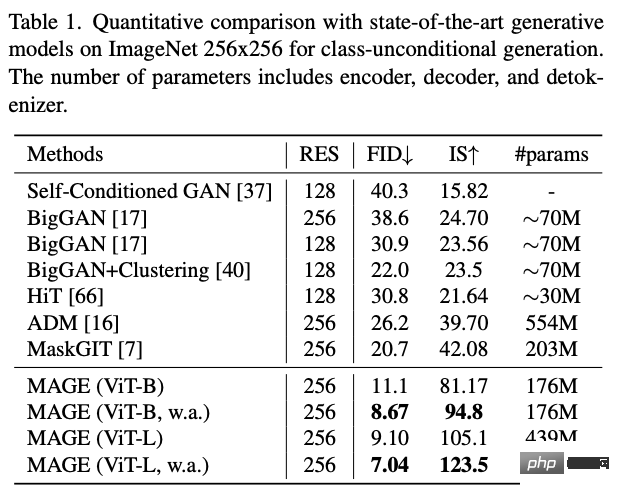

MAGE는 여러 이미지 생성 및 이미지 인식 작업에서 SOTA에 도달하거나 초과했습니다.

ImageNet의 비지도 이미지 생성 작업에서 MAGE의 FID는 이전 > 20에서 7.04로 감소하여 감독 이미지 생성 수준에도 도달했습니다(ImageNet의 감독 잠재 확산 FID는 3.60입니다).

그림 3: MAGE 비지도 이미지 생성 예

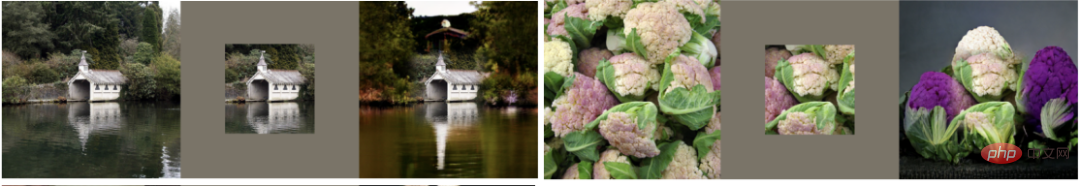

MAGE는 이미지 인페인팅, 아웃페인팅, 자르기 등 다양한 이미지 편집 작업도 수행할 수 있습니다.

그림 4: MAGE 이미지 편집 예

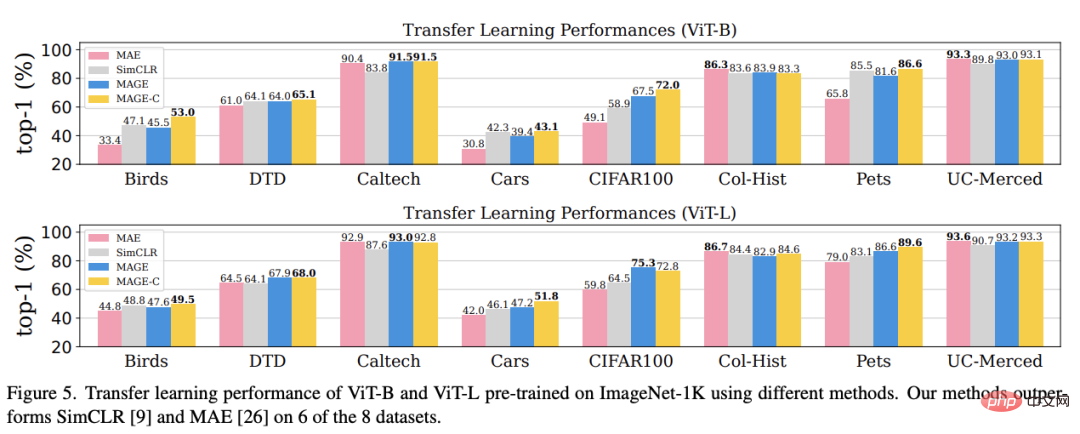

표현 학습 측면에서 MAGE는 ImageNet 선형 프로빙 및 소수 샘플 작업 중 학습, 전이 학습 등 현재 MIM 방법에 비해 크게 개선되었으며 현재 최적의 자기 지도 학습 방법 수준에 도달하거나 초과할 수 있습니다.

결론

본 논문은 이미지 생성과 표현 학습을 통합하는 것을 목표로 합니다. 이를 위해 본 논문의 저자는 이미지 의미 마스킹 기반의 자기지도 학습 프레임워크인 MAGE를 제안합니다. 이 프레임워크는 간단하고 효율적이며 처음으로 이미지 생성 및 표현 학습 모두에서 SOTA 성능에 도달하거나 초과합니다. 관심 있는 독자는 논문의 원본을 보고 더 많은 연구 세부 사항을 알아볼 수 있습니다.

위 내용은 Google과 MIT는 통합 프레임워크 MAGE를 제안합니다. 표현 학습은 MAE를 능가하고 비지도 이미지 생성은 Latent Diffusion을 능가합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!