저장 및 전송 효율성을 향상시키는 방법은 무엇입니까? 매개변수 집약적인 마스크 네트워크는 상당한 효과를 발휘합니다.

- 王林앞으로

- 2023-04-12 17:10:031336검색

최근에는 보다 복잡한 작업을 처리하기 위해 신경망의 규모가 커지고 있으며, 신경망을 어떻게 효율적으로 저장하고 전송할 것인지가 매우 중요해졌습니다. 한편, LTH(복권 가설)의 제안을 통해 최근 무작위 희소 신경망이 강력한 잠재력을 보여주었습니다. 이 잠재력을 사용하여 네트워크의 저장 및 전송 효율성을 향상시키는 방법도 연구해 볼 가치가 있습니다.

Northeastern University와 Rochester Institute of Technology의 연구원들은 PEMN(매개변수 효율적인 마스킹 네트워크)을 제안했습니다. 저자는 먼저 제한된 수의 난수로 생성된 확률론적 네트워크의 표현 기능을 탐색합니다. 실험에 따르면 네트워크가 제한된 수의 난수로 생성되더라도 다양한 하위 네트워크 구조를 선택하여 여전히 좋은 표현 기능을 가지고 있는 것으로 나타났습니다.

이 탐색 실험을 통해 저자는 자연스럽게 제한된 수의 난수를 프로토타입으로 사용하고 마스크 세트와 결합하여 신경망을 표현하자고 제안했습니다. 제한된 수의 난수와 바이너리 마스크는 저장 공간을 거의 차지하지 않기 때문에 저자는 이를 활용하여 네트워크 압축에 대한 새로운 아이디어를 제안합니다. 이 기사는 NeurIPS 2022에 채택되었습니다. 코드는 오픈소스로 공개되었습니다.

- 문서 주소: https://arxiv.org/abs/2210.06699

- 문서 코드: https://github.com/yueb17/PEMN

1. 관련 연구

MIT 연구진은 복권 가설(ICLR'19)을 제안했습니다. 무작위로 초기화된 네트워크에는 단독으로 훈련했을 때 좋은 결과를 얻는 복권 하위 네트워크(당첨 티켓)가 있습니다. 복권 가설은 확률적 희소 네트워크의 훈련 가능성을 탐구합니다. Uber 연구진은 Supermask(NeurIPS'19)를 제안했습니다. 무작위로 초기화된 네트워크에는 훈련 없이 직접 추론에 사용할 수 있는 하위 네트워크가 있습니다. Supermask는 확률론적 희소 네트워크의 유용성을 탐구합니다. 워싱턴 대학의 연구원들은 역전파를 통해 하위 네트워크의 마스크를 학습하는 Edge-Popup(CVPR'20)을 제안했습니다. 이는 무작위 희소 네트워크의 유용성을 크게 향상시킵니다.

2. 연구 동기/과정

위의 관련 연구에서는 유용성이 표현 능력으로도 이해될 수 있는 훈련 가능성 및 유용성과 같은 다양한 각도에서 무작위 희소 네트워크의 잠재력을 탐구했습니다. 이 연구에서 저자는 난수로부터 생성된 신경망이 훈련 가중치 없이 얼마나 잘 표현될 수 있는지에 관심이 있습니다. 이 문제를 탐구한 후 저자는 PEMN(Parameter-Efficient Masking Networks)을 제안했습니다. 당연히 저자는 PEMN을 사용하여 네트워크 압축에 대한 새로운 아이디어를 제공하고 PEMN의 잠재적인 응용 시나리오를 탐색하는 예제 역할을 합니다.

3. 난수로 구성된 신경망의 표현 능력 탐색

랜덤 네트워크가 주어지면 저자는 표현 능력을 탐색하기 위해 하위 네트워크를 선택하기 위해 Edge-Popup 알고리즘을 선택합니다. 차이점은 전체 네트워크를 무작위로 초기화하는 대신 저자는 프로토타입을 사용하여 무작위 네트워크를 구축하는 세 가지 매개변수 집약적인 네트워크 생성 전략을 제안합니다.

- One-layer: 네트워크에서 반복되는 구조의 가중치를 프로토타입으로 선택하여 동일한 구조로 다른 네트워크 레이어를 채웁니다.

- 최대 레이어 패딩(MP): 매개변수 수가 가장 많은 네트워크 레이어를 프로토타입으로 선택하고 해당 매개변수 양을 잘라서 다른 네트워크 레이어를 채웁니다.

- 랜덤 벡터 패딩(RP): 특정 길이의 랜덤 벡터를 프로토타입으로 선택하고 복사하여 네트워크 전체를 채웁니다.

세 가지 다른 무작위 네트워크 생성 전략은 네트워크의 고유 값 수를 점차적으로 줄입니다. 서로 다른 전략으로 얻은 무작위 네트워크를 기반으로 하위 네트워크를 선택하여 제한된 수의 난수를 탐색합니다. 생성된 무작위 네트워크의

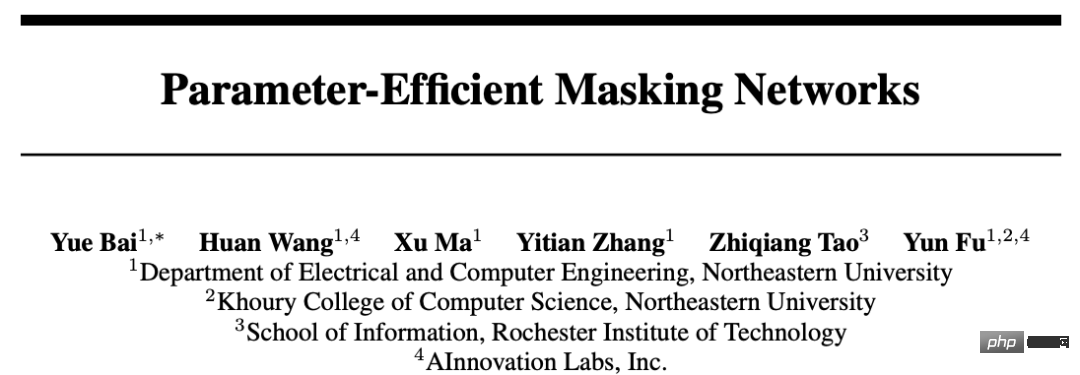

위 그림은 ConvMixer와 ViT 네트워크를 이용한 CIFAR10 이미지 분류 실험 결과를 보여줍니다. Y축은 정확도이고, X축은 다양한 전략을 사용하여 얻은 무작위 네트워크입니다. 다음과 같이

실험 결과에 따르면, 무작위 네트워크에 매우 제한된 수의 비반복 난수(예: PR_1e-3)만 있어도 선택한 하위 네트워크의 표현 능력을 잘 유지할 수 있음을 관찰했습니다. . 지금까지 저자는 다양한 난수 네트워크 생성 전략을 통해 제한된 수의 난수로 구성된 신경망의 표현 능력을 탐색했으며, 반복되지 않는 난수가 매우 제한되어 있어도 해당 난수 네트워크가 여전히 표현할 수 있음을 관찰했습니다. 데이터 잘.

동시에 이러한 무작위 네트워크 생성 전략을 기반으로 하고 획득한 하위 네트워크 마스크를 결합하여 저자는 PEMN(Parameter-Efficient Masking Networks)이라는 새로운 신경망 유형을 제안했습니다.

4. 새로운 네트워크 압축 아이디어

이 기사에서는 PEMN의 잠재적인 응용을 확장하기 위한 예로 신경망 압축을 선택합니다. 특히, 이 기사에서 제안된 다양한 무작위 네트워크 생성 전략은 프로토타입을 효율적으로 사용하여 완전한 무작위 네트워크, 특히 가장 세분화된 무작위 벡터 패딩(RP) 전략을 나타낼 수 있습니다.

저자는 RP 전략의 무작위 벡터 프로토타입과 해당 하위 네트워크 마스크 세트를 사용하여 무작위 네트워크를 나타냅니다. 프로토타입은 부동 소수점 형식으로 저장해야 하고 마스크는 이진 형식으로만 저장하면 됩니다. RP의 프로토타입 길이가 매우 짧을 수 있기 때문에(반복되지 않는 제한된 수의 난수는 여전히 강력한 표현 능력을 갖기 때문에) 신경망을 표현하는 오버헤드는 매우 작아질 것입니다. 제한된 길이. 임의의 벡터와 이진 형식의 마스크 세트. 본 논문에서는 서브네트워크의 부동 소수점 값을 저장하는 기존의 희소 네트워크와 비교하여 신경망을 효율적으로 저장하고 전송하기 위한 새로운 네트워크 압축 아이디어를 제안합니다.

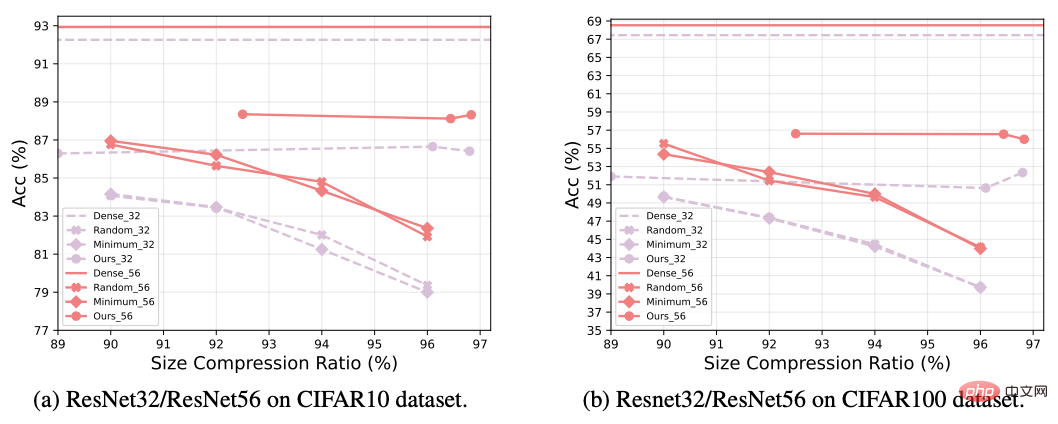

위 그림에서 저자는 PEMN을 사용하여 네트워크를 압축하고 이를 기존 네트워크 가지치기 방법과 비교합니다. 실험에서는 ResNet 네트워크를 사용하여 CIFAR 데이터 세트에 대한 이미지 분류 작업을 수행합니다. 새로운 압축 방식은 일반적으로 기존 네트워크 가지치기보다 더 나은 성능을 발휘합니다. 특히 매우 높은 압축률에서 PEMN은 여전히 우수한 정확도를 유지할 수 있습니다.

5. 결론

이 논문은 최근 무작위 네트워크가 보여준 잠재력에 영감을 받아 무작위 신경망을 구축하기 위한 다양한 매개변수 집약적 전략을 제안하고, 반복되지 않는 제한된 숫자만 있을 때 생성되는 방법을 탐색합니다. 무작위 신경망의 표현 가능성과 PEMN(Parameter-Efficient Masking Networks)이 제안되었습니다. 저자는 PEMN을 네트워크 압축 시나리오에 적용하여 실제 애플리케이션에서의 잠재력을 탐색하고 네트워크 압축에 대한 새로운 아이디어를 제공합니다. 저자는 무작위 네트워크에 매우 제한된 수의 반복되지 않는 난수가 있는 경우에도 하위 네트워크 선택을 통해 여전히 우수한 표현 기능을 가지고 있음을 보여주는 광범위한 실험을 제공합니다. 또한 기존 프루닝 알고리즘과 비교하여 실험을 통해 새로 제안된 방법이 더 나은 네트워크 압축 효과를 달성할 수 있음을 보여줌으로써 이 시나리오에서 PEMN의 적용 가능성을 검증했습니다.

위 내용은 저장 및 전송 효율성을 향상시키는 방법은 무엇입니까? 매개변수 집약적인 마스크 네트워크는 상당한 효과를 발휘합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!