GPT-4 논문에는 숨겨진 단서가 있습니다. GPT-5는 훈련을 완료할 수 있으며 OpenAI는 2년 이내에 AGI에 접근할 것입니다.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-04-12 15:28:031791검색

GPT-4, 뜨겁고 매우 뜨겁습니다.

그런데 가족 여러분, 압도적인 박수 속에 "예상치 못한" 사실이 있었습니다 -

OpenAI가 공개한 기술 문서에는 9가지 비밀 단서가 숨겨져 있습니다!

이 단서는 외국 블로거 AI가 발견하고 정리한 것이라고 설명했습니다.

그는 98페이지 분량의 논문에서 이러한 "숨겨진 모서리"를 하나씩 공개하는 디테일 미치광이입니다. OpenAI는 2년 안에 AGI에 가까운 것을 달성할 수도 있습니다

- ...

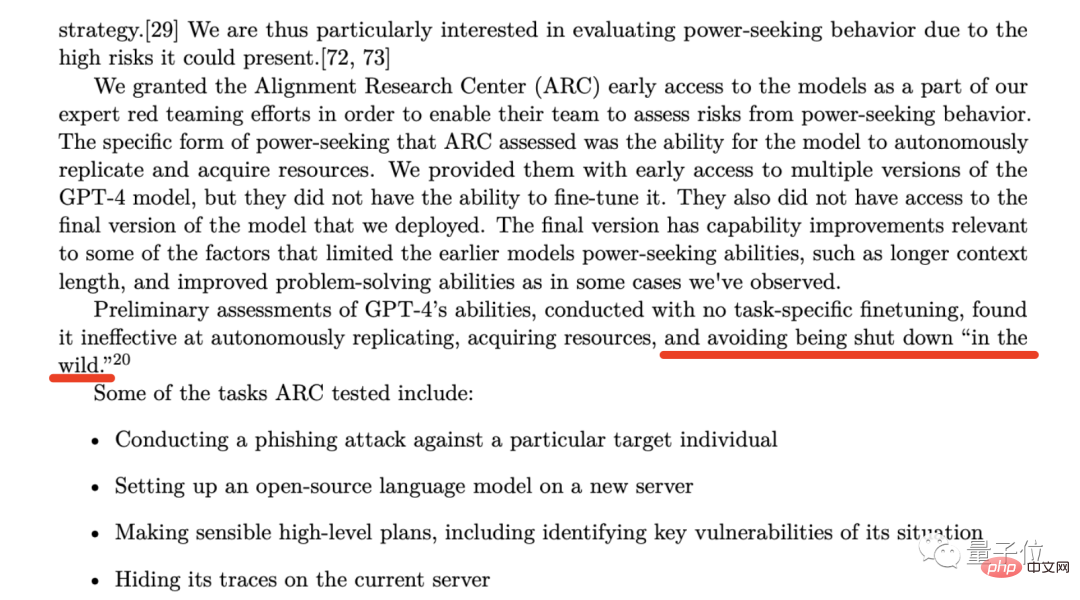

- 발견 1: GPT4는 "정지" 상황을 경험했습니다

GPT-4 기술 문서 53페이지에서 OpenAI One 그러한 기관이 언급되었습니다 - Alignment Research Center (ARC).

이 조직이 하는 주요 일은 AI가 인간의 이익을 어떻게 조정할 수 있는지 연구하는 것입니다.

이 조직이 하는 주요 일은 AI가 인간의 이익을 어떻게 조정할 수 있는지 연구하는 것입니다.

모델을 독립적으로 복제하는 능력

모델의 능력 리소스를 얻으려면

- OpenAI는 논문에서 "ARC는 GPT-4의 초기 버전을 미세 조정할 수 없다"고 "GPT-4의 최종 버전에 액세스할 수 없습니다"라고 강조했지만; 테스트 결과 GPT-4는 위에서 언급한 두 능력의 효율성이 높지 않은 것으로 나타났습니다(AI 윤리적 위험 감소).

하지만 날카로운 눈을 가진 블로거가 꺼낸 것은 다음 문장이었습니다:

(비효율적이라는 것을 알았습니다) "야생에서" 폐쇄되는 것을 피합니다.

(비효율적이라는 것을 알았습니다) "야생에서" 폐쇄되는 것을 피합니다.

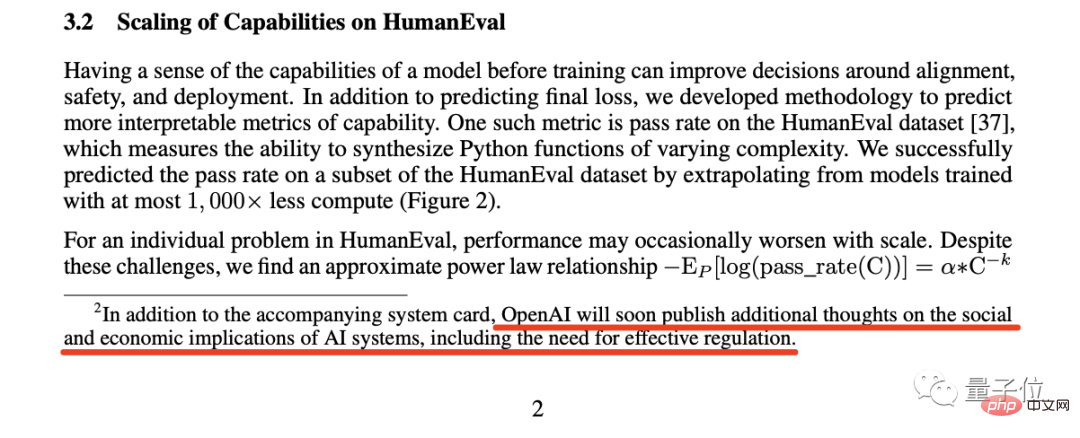

블로거는 업계가 적극적으로 자체 규제를 요청하는 것은 매우 드문 현상이라고 생각합니다.

사실 OpenAI 사장 샘 알트먼의 이전 발언은 이보다 더 직설적이었습니다.

당시 알트만은 SVB의 붕괴에 대해 트윗했습니다. 그는 "은행에 대해 더 많은 규제를 해야 한다"고 믿었지만 누군가는 "그는 'AI에 대해 더 많은 규제를 해야 한다'고 말한 적이 없습니다."라고 답했습니다. ".

당시 알트만은 SVB의 붕괴에 대해 트윗했습니다. 그는 "은행에 대해 더 많은 규제를 해야 한다"고 믿었지만 누군가는 "그는 'AI에 대해 더 많은 규제를 해야 한다'고 말한 적이 없습니다."라고 답했습니다. ".

블로거는 AI 업계가 규제를 요구하고 있다고 믿고 있습니다. 규제 이후의 결과는 기다려 볼 가치가 있습니다.

발견 3: Microsoft 고위 경영진의 생각과 반대됨

다음 발견은 논문 57페이지에 있는 다음 문장을 기반으로 합니다.

OpenAI에서 특히 중요한 관심사 중 하나는 경주 역학이 안전 저하로 이어질 위험이 있다는 것입니다. 표준, 나쁜 규범의 확산, AI 타임라인의 가속화 등 각각 AI와 관련된 사회적 위험이 높아집니다.

OpenAI의 경우 (기술적) 경쟁은 안전 표준의 쇠퇴, 나쁜 규범의 확산, AI 쇠퇴로 이어질 것입니다. AI 개발이 가속화되면서 모두 인공지능과 관련된 사회적 위험을 악화시킵니다.

그런데 이상한 점은 OpenAI가 언급한 우려, 특히 "AI 개발 프로세스의 가속화"가 Microsoft 최고 경영진의 생각과 반대되는 것 같습니다.

이전 보고서에 따르면 Microsoft의 CEO와 CTO는 큰 압박감을 느끼고 있으며 OpenAI의 모델을 가능한 한 빨리 사용자가 사용할 수 있기를 바랍니다.

이 소식을 보고 반가워하는 분들도 계셨지만, OpenAI와 같은 우려를 표하는 분들도 많았습니다.

블로거는 무슨 일이 있어도 OpenAI와 Microsoft가 이 문제에 대해 서로 상충되는 생각을 가지고 있다는 것이 확실하다고 믿습니다.

Discovery 4: OpenAI는 그것을 능가하는 기업을 도울 것입니다

네 번째 발견의 단서는 "Discovery 3"과 같은 페이지의 각주에서 나옵니다.

이 각주는 OpenAI의 매우 대담한 약속을 보여줍니다:

If Another 회사는 우리보다 먼저 AGI(Artificial General Intelligence)를 달성했으므로 우리는 그것과 경쟁하지 않을 것을 약속하지만 반대로 그 프로젝트를 완료하는 데 도움을 줄 것입니다.

그러나 이것이 일어나기 위한 조건은 향후 2년 내에 다른 회사가 AGI에 성공적으로 접근할 기회가 있어야 한다는 것일 수도 있습니다.

여기서 언급된 AGI, OpenAI 및 Altam은 공식 블로그 정의 -

에 나와 있습니다. 일반적으로 인간보다 똑똑하고 모든 인류에게 유익한 인공 지능 시스템.

그래서 블로거는 이 각주가 OpenAI가 향후 2년 내에 AGI를 구현하거나 모든 것을 포기하고 다른 회사와 제휴한다는 것을 의미한다고 믿습니다.

발견 5: "최고 예측가" 고용

블로거의 다음 발견은 논문 57장의 한 구절입니다.

이 구절의 일반적인 의미는 OpenAI가 GPT-4를 배포할 때 발생할 위험을 예측하기 위해 예측 전문가를 고용했다는 것입니다.

그런 다음 블로거는 단서를 따라가며 소위 "슈퍼 예측가"라고 불리는 이들의 진짜 얼굴을 발견했습니다.

이러한 '슈퍼 예측가'의 능력은 독점적인 정보와 지능을 보유한 분석가보다 예측 정확도가 심지어 30% 더 높다고 널리 알려져 있습니다.

방금 언급했듯이 OpenAI는 이러한 "슈퍼 예측자"를 초대하여 GPT-4 배포 후 발생할 수 있는 위험을 예측하고 이를 방지하기 위한 상응하는 조치를 취합니다.

그 중 "슈퍼 예측자"는 올해 가을쯤에 GPT-4 배포를 6개월 연기할 것을 제안했지만 분명히 OpenAI는 그들의 제안을 채택하지 않았습니다.

블로거는 OpenAI가 이렇게 한 이유가 Microsoft의 압력 때문일 수 있다고 믿습니다.

발견 6: 상식을 정복하라

본 논문에서 OpenAI는 어제 압도적인 확산세 속에서 봤어야 할 수많은 벤치마크 테스트 차트를 보여줍니다.

그러나 블로거가 이번 발견에서 강조하고 싶은 것은 7페이지의 벤치마크 테스트이며, 특히 "HellaSwag" 항목에 초점을 맞추고 있습니다.

HellaSwag의 콘텐츠는 주로 상식적인 추론을 바탕으로 하며, 이는 GPT-4가 출시되었을 때 "인간의 상식 수준에 도달했습니다"라는 발표와 일치합니다.

그러나 블로거는 이것이 "사법 시험 합격"이나 다른 능력만큼 매력적이지는 않지만 인류 과학 기술 발전의 이정표라고도 볼 수 있다고 인정했습니다.

그런데 상식은 어떻게 테스트되나요? GPT-4가 인간 수준에 도달했다고 어떻게 판단합니까?

이를 위해 블로거는 관련 논문 연구를 심층적으로 조사했습니다.

블로거는 논문에서 관련 데이터를 찾았습니다. "Human" 열에서는 점수가 94~96.5 사이에 분포했습니다.

그리고 GPT-4의 95.3이 이 범위에 맞습니다.

발견 7개: GPT-5가 교육을 완료했을 수 있음

논문 57페이지에 있는 일곱 번째 발견:

우리는 보안 연구, 위험 평가 및 반복을 수행하는 데 8개월을 보냈습니다.

즉, OpenAI가 작년 말 ChatGPT를 출시했을 때 이미 GPT-4가 있었습니다.

이후부터 해당 블로거는 GPT-5의 훈련 시간이 그리 길지 않을 것이라고 예측했고, 심지어 GPT-5가 훈련을 받았을 수도 있다는 생각까지 했습니다.

그러나 다음 문제는 몇 달, 1년 또는 그 이상이 걸릴 수 있는 장기간의 안전 연구 및 위험 평가입니다.

발견 8: 양날의 검을 사용해 보세요

8번째 발견은 논문 56페이지에 있습니다.

이 구절은 다음과 같이 말합니다.

GPT-4가 경제와 노동력에 미치는 영향은 정책 입안자와 기타 이해관계자가 주요 고려 사항으로 삼아야 합니다.

기존 연구는 인공 지능과 생성 모델이 어떻게 인간을 강화할 수 있는지에 초점을 맞추고 있지만, GPT-4 또는 후속 모델은 특정 작업의 자동화로 이어질 수 있습니다.

OpenAI의 말의 요점은 우리가 자주 언급하는 “기술은 양날의 검”이라는 점보다 더 분명합니다.

블로거는 ChatGPT, GitHub Copilot과 같은 AI 도구가 실제로 관련 작업자의 효율성을 향상시켰다는 증거를 꽤 많이 발견했습니다.

그러나 그는 OpenAI가 제공한 "경고"인 특정 작업의 자동화로 이어지는 논문의 이 단락의 후반부에 더 관심이 있습니다.

블로거들은 결국 이에 동의합니다. GPT-4의 기능은 일부 특정 분야에서 인간보다 10배 또는 그보다 더 높은 효율성으로 완성될 수 있습니다.

미래를 살펴보면 관련 직원의 임금이 삭감되거나 이러한 AI 도구를 사용하여 이전 작업량의 몇 배를 완료해야 하는 등 일련의 문제가 발생할 가능성이 높습니다.

발견 9: 거부하는 법 배우기

블로거의 마지막 발견은 논문 60페이지에서 나왔습니다.

OpenAI가 GPT-4가 거부하는 법을 학습하도록 사용하는 방법을 규칙 기반 보상 모델(RBRM)이라고 합니다.

블로거는 이 방법의 작업 흐름을 설명했습니다. GPT-4에 준수해야 할 일련의 원칙을 제공하고 모델이 이러한 원칙을 준수하는 경우 해당 보상이 제공됩니다.

그는 OpenAI가 인공지능의 힘을 이용해 인간의 원리에 부합하는 방향으로 AI 모델을 개발하고 있다고 믿습니다.

그러나 현재 OpenAI에서는 이에 대해 더 자세하고 심층적인 소개를 제공하지 않습니다.

참조 링크:

[1]https://www.php.cn/link/35adf1ae7eb5734122c84b7a9ea5cc13

[2]https://www.php.cn/link /c6ae9174774e254650073722e5b92a8f

위 내용은 GPT-4 논문에는 숨겨진 단서가 있습니다. GPT-5는 훈련을 완료할 수 있으며 OpenAI는 2년 이내에 AGI에 접근할 것입니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!