다운스트림 교육 없이 Tip-Adapter는 CLIP 이미지 분류 정확도를 크게 향상시킵니다.

- 王林앞으로

- 2023-04-12 15:25:261266검색

- 문서 링크: https://arxiv.org/pdf/2207.09519.pdf

- 코드 링크: https://github.com/gaopengcuhk/Tip-Adapter

하나. 연구 배경

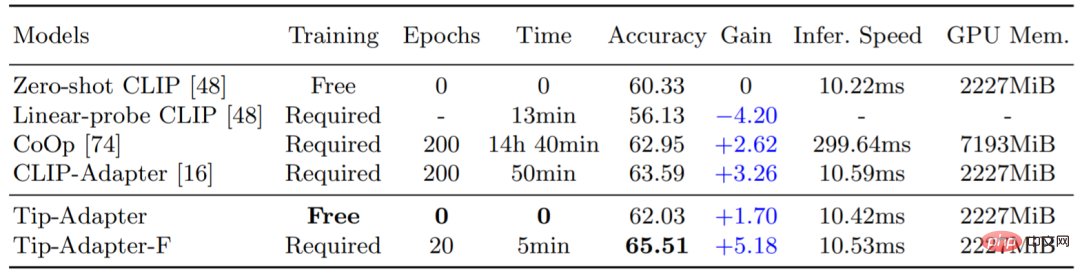

CLIP(Contrastive Image Language Pre-training Model)는 최근 강력한 시각적 도메인 전송 기능을 입증했으며 새로운 다운스트림 데이터 세트에서 제로샷 이미지 인식을 수행할 수 있습니다. CLIP의 마이그레이션 성능을 더욱 향상시키기 위해 기존 방법은 다운스트림 데이터 세트에 대한 소량의 훈련 데이터를 제공하는 CoOp 및 CLIP-Adapter와 같은 소수 설정을 사용하므로 CLIP이 다양한 시각적 시나리오에 대해 더 나은 결정을 내릴 수 있습니다. . 그러나 이 추가 교육 단계는 상당한 시간과 공간 리소스 오버헤드를 가져오며 이는 CLIP 고유의 빠른 지식 전달 기능에 어느 정도 영향을 미칩니다. 따라서 우리는 추가적인 다운스트림 학습이 필요하지 않고 CLIP의 정확도를 크게 향상시킬 수 있는 몇 장의 이미지 분류 방법인 Tip-Adapter를 제안합니다. 이를 바탕으로 우리는 적은 양의 미세 조정만으로 최첨단 성능을 달성할 수 있는 솔루션인 Tip-Adapter-F를 제안하여 효율성과 성능 간의 최상의 절충안을 달성했습니다. 아래 표 1에서 볼 수 있듯이 Tip-Adapter는 훈련 시간이 필요하지 않으므로 ImageNet 데이터 세트의 CLIP을 +1.7% 정확도(Accuracy)로 향상시킬 수 있는 반면 Tip-Adapter-F는 훈련 시간의 1/10만 필요합니다. 이전 솔루션(Epochs, Time) 중 최고의 분류 성능을 얻을 수 있습니다.

표 1: ImageNet 데이터세트에 대한 다양한 체계의 16샷 이미지 분류 정확도 및 학습 시간 비교

II. 연구 방법

1.Tip-Adapter

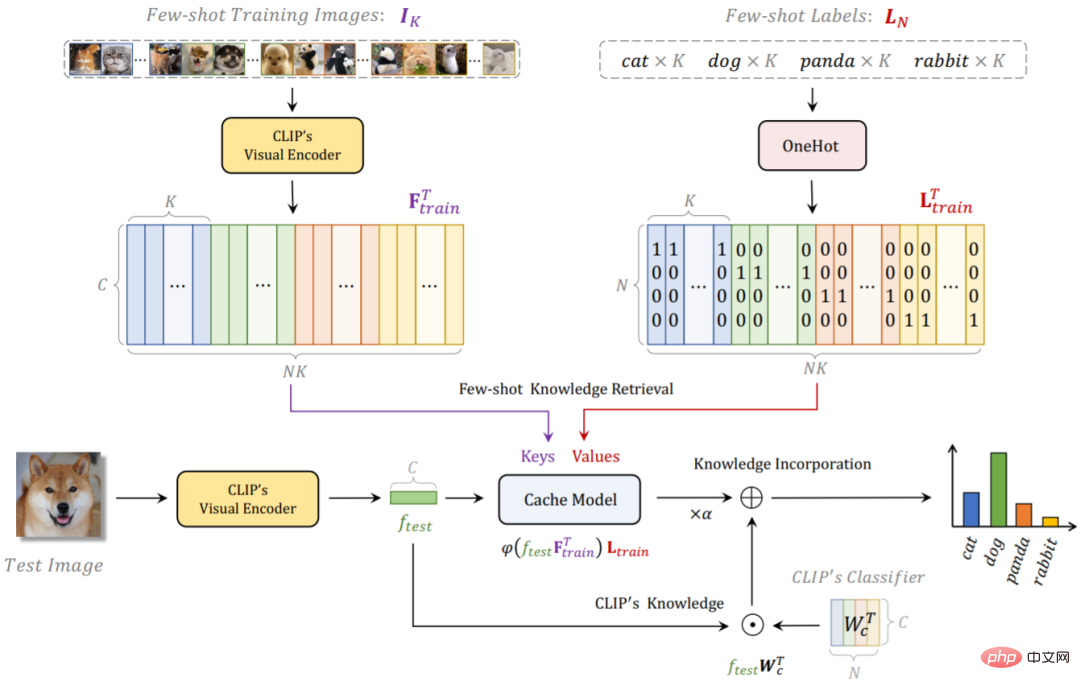

Tip-Adapter의 전체 네트워크 구조는 아래 그림 1과 같습니다. 주어진 Few-Shot 훈련 데이터 세트와 레이블에 대해 CLIP을 사용하여 비훈련 솔루션 Cache를 구축합니다. 테스트 중에 다운스트림 훈련 데이터의 분류 지식을 저장하는 모델, Tip-Adapter는 캐시 모델의 예측과 원본 CLIP의 예측을 선형적으로 추가하여 더 강력한 최종 분류 결과를 얻습니다.

자세히 말하면 CLIP 사전 훈련된 시각적 인코더(Visual Encoder)를 사용하여 Few-shot 훈련 세트의 모든 이미지 특징을 캐시 모델의 키로 추출하고 해당 이미지 레이블을 하나로 변환합니다. 캐시 모델의 값으로 핫 인코딩 형식. 이 Key-Value Cache 모델 구축 방법은 사전 훈련된 Visual Encoder를 사용하고, Few-shot 훈련 세트에 각 카테고리(1~16개 샷)에 대한 적은 수의 이미지만 포함되어 있으므로 훈련 오버헤드가 필요하지 않습니다. 캐시 모델은 추가 그래픽 메모리 오버헤드도 거의 차지하지 않습니다. 표 1의 GPU 메모리 표시기를 참조하세요.

테스트 이미지의 경우 먼저 CLIP의 Visual Encoder를 사용하여 기능을 가져온 다음 기능을 쿼리로 처리하여 캐시 모델의 다운스트림 소수 데이터에 대한 지식 검색을 수행합니다. Key는 CLIP의 Visual Encoder에서도 추출되므로 테스트 이미지 기능 Query와 동일한 원점을 가지므로 Key-Query 인접 행렬을 얻기 위해 이들 간의 코사인 유사성을 직접 계산할 수 있습니다. 가치에. 따라서 캐시 모델을 검색하여 얻은 이 테스트 이미지에 대한 분류 예측을 얻기 위해 값의 가중 합을 계산할 수 있습니다. 또한 테스트 이미지 특징을 CLIP의 Textual Encoder 텍스트 특징과 일치시켜 CLIP의 제로샷 예측을 얻을 수도 있습니다. 두 가지의 합에 선형 가중치를 적용하여 CLIP에서 사전 훈련된 이미지 언어 대조 지식과 새로운 다운스트림 데이터 세트의 소수 지식을 모두 포함하는 최종 분류 예측을 얻으므로 보다 정확한 예측을 달성할 수 있습니다. 강력한 이미지 분류 정확도.

Tip-Adapter의 네트워크 구조를 기반으로 Cache Model의 Keys 부분을 학습 매개변수로 변환할 수 있으며, 이 솔루션은 Tip-Adapter-F입니다. 이미 구축된 캐시 모델의 도움으로 Tip-Adapter-F는 표 1에 표시된 것처럼 더 높은 성능을 달성하기 위해 기존 CLIP-Adapter의 훈련 라운드와 시간의 10분의 1만 필요합니다.

그림 1: Tip-Adapter와 Tip-Adapter-F의 네트워크 흐름도

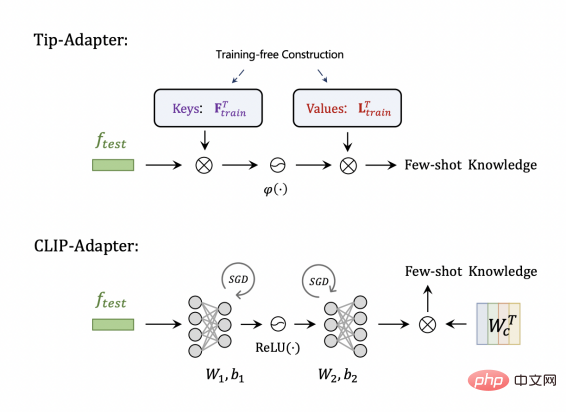

2. Tip-Adapter와 기존 솔루션의 차이점 및 연관성

CLIP- Adapter 비교 , 그림 2에서 볼 수 있듯이 Tip-Adapter에 저장된 키와 값은 실제로 CLIP-Adapter의 어댑터 구조의 두 선형 레이어에 해당할 수 있지만 전자는 구축하는 데 교육이 필요하지 않으며 후자는 무작위입니다. 그런 다음 최적의 매개 변수를 학습하려면 훈련이 필요합니다.

그림 2: Tip-Adapter와 CLIP-Adapter 비교

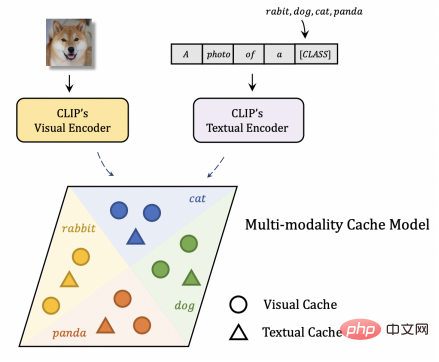

캐시 모델 구축을 위한 기존의 다른 솔루션과 비교하면 그림 3과 같이 Tip-Adapter의 캐시 모델을 볼 수 있습니다. 캐시는 다중 모드의 시각적 언어입니다. CLIP의 Textual Encoder에서 출력되는 기능은 텍스트의 Key-Value로 간주될 수 있으므로 이미지 기능을 쿼리로 테스트하는 것과 동일하므로 시각적 캐시와 텍스트 캐시에서만 지식을 검색하는 기존 솔루션과 비교됩니다. 시각적 캐시, Tip-Adapter는 다중 모드 지식을 활용하여 더 강력한 인식 성능을 얻을 수 있습니다.

그림 3: 캐시 모델 구축을 위한 다른 솔루션과 팁 어댑터 비교

3. 실험 결과

1. ImageNet의 분류 정확도

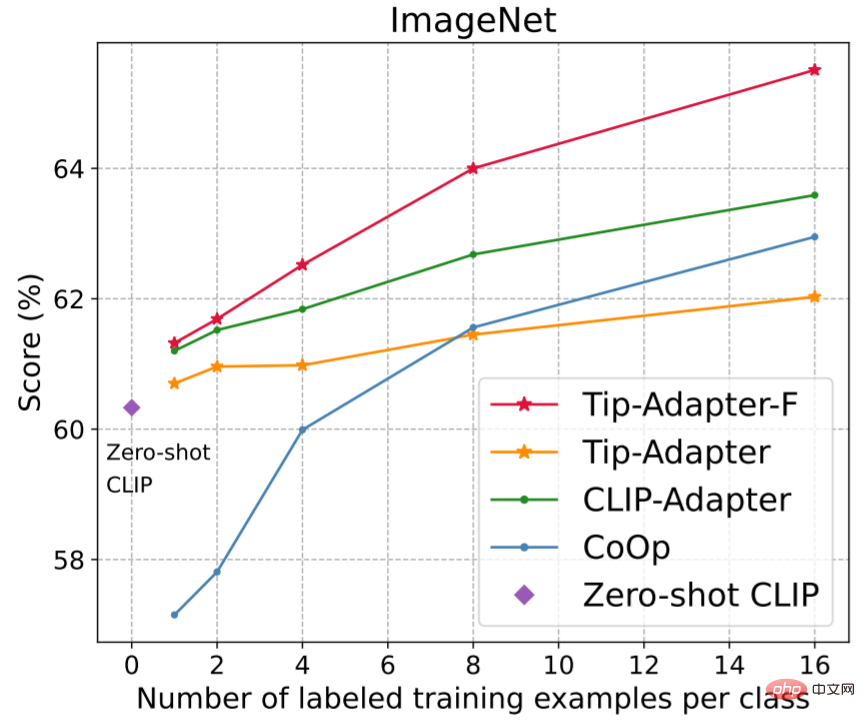

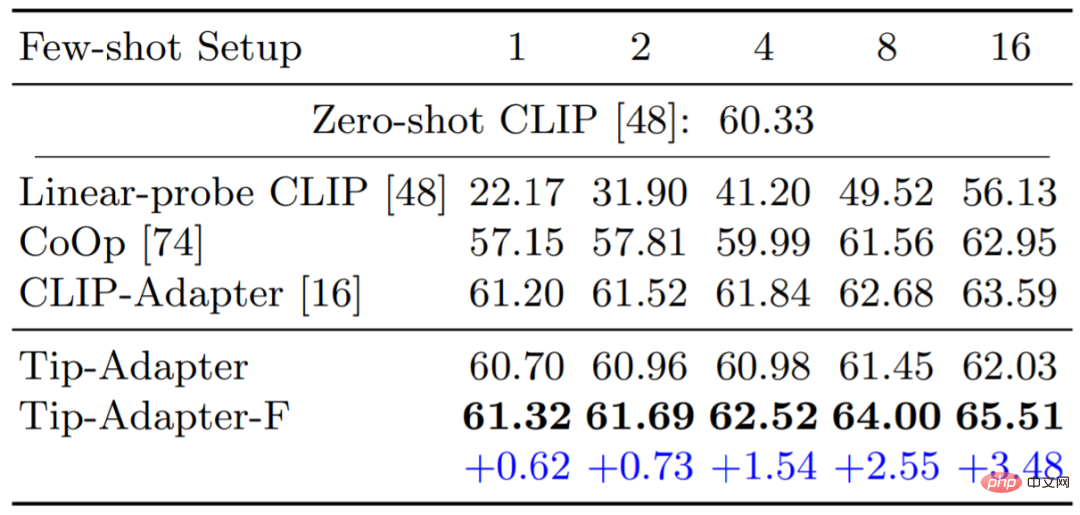

그림 4와 표 2는 1, 2, 4, 8, 16샷 이미지 분류 정확도를 Tip-Adapter, Tip-Adapter-F와 비교합니다. 3은 16샷 ImageNet 데이터 세트에서 다양한 CLIP을 사용하여 Visual Encoder의 정확도를 비교합니다. 두 가지 솔루션 모두 리소스 오버헤드가 거의 없이 뛰어난 성능을 달성하는 것을 볼 수 있습니다.

그림 4 및 표 2: ImageNet 데이터세트에 대한 다양한 방법의 1~16샷 이미지 분류 정확도 비교

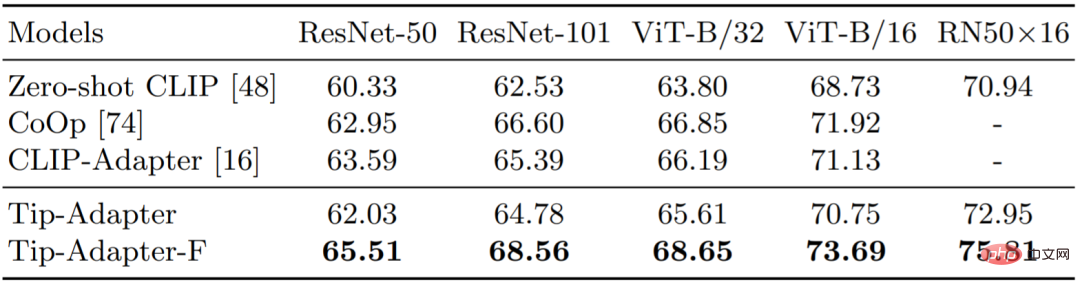

5:16 - Shot ImageNet에서 다른 CLIP을 사용하는 Visual Encoder의 이미지 분류 정확도 비교

2. 또 다른 10개의 이미지 분류 데이터 세트에서

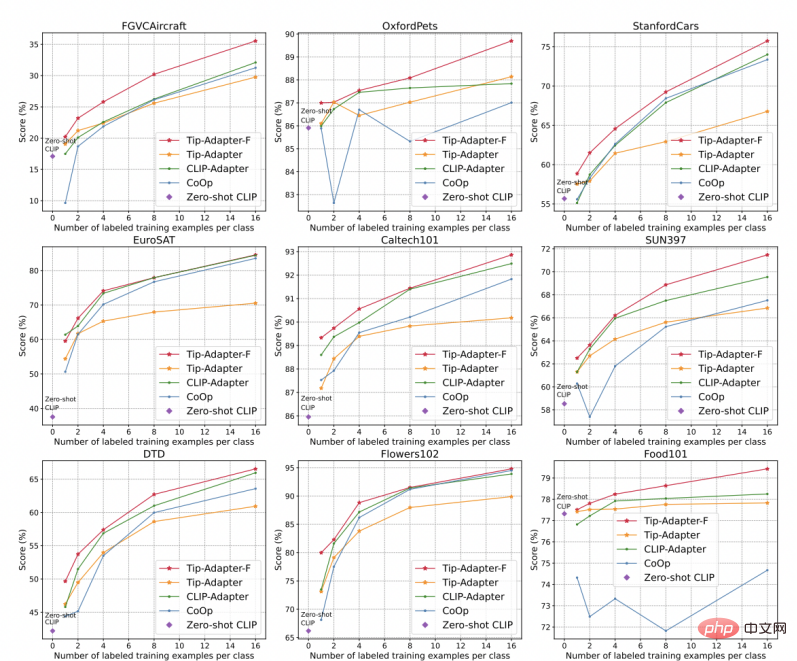

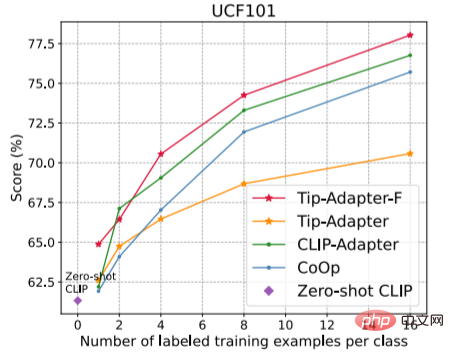

그림 5와 같이 우리는 또 다른 10개의 이미지 분류 데이터 세트의 정확도를 제공합니다. 결과는 StandfordCars, UCF101, Caltech101, Flowers102, SUN397, DTD, EuroSAT, FGVCAircraft, OxfordPets 및 Food101입니다. 그림에서 볼 수 있듯이 당사의 Tip-Adapter-F는 모두 가장 높은 인식 정확도를 달성했습니다.

그림 5: 다른 10개 데이터 세트에 대한 다양한 방법의 1~16샷 이미지 분류 정확도 비교

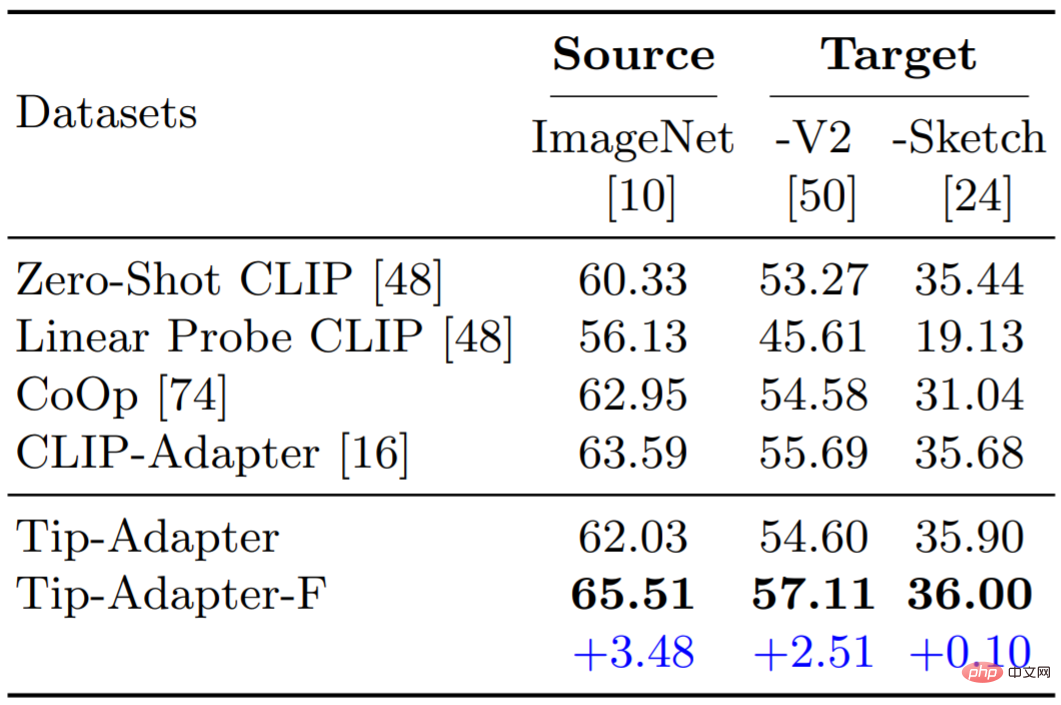

3. 도메인 일반화 능력 평가

도메인 일반화에서 Tip-Adapter와 Tip-Adapter-F의 성능을 테스트했습니다. 표 6에서 볼 수 있듯이 두 가지 방식 모두 강력한 견고성과 기능 전송 기능을 보여줍니다.

넷. 결론

본 논문에서는 다운스트림 소수 이미지 분류를 위해 CLIP을 사용하기 위한 교육이 필요 없는 솔루션인 Tip-Adapter를 제안합니다. Tip-Adapter는 테스트 이미지 Query에 대한 지식 검색 데이터베이스로 Key-Value Cache Model을 구축하고, Cache Model의 예측과 CLIP의 Zero-shot 예측을 융합하여 보다 강력한 인식 성능을 얻습니다. Tip-Adapter가 사전 훈련된 모델의 효율적인 마이그레이션에 대한 후속 작업에 더 많은 영감을 줄 수 있기를 바랍니다.

위 내용은 다운스트림 교육 없이 Tip-Adapter는 CLIP 이미지 분류 정확도를 크게 향상시킵니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!