OpenAI 연구원: 데이터가 부족할 때 지도 학습을 구현하는 방법

- 王林앞으로

- 2023-04-12 08:58:091254검색

이 기사는 Lei Feng.com에서 복제되었습니다. 재인쇄가 필요한 경우 Lei Feng.com 공식 웹사이트로 이동하여 승인을 신청하세요.

실제 애플리케이션에서는 데이터를 쉽게 얻을 수 있지만 레이블이 지정된 데이터는 드뭅니다.

일반적으로 지도 학습 작업이 레이블이 지정된 데이터가 부족한 문제에 직면하면 다음 네 가지 솔루션을 고려할 수 있습니다.

1. 사전 학습 + 미세 조정: 먼저 대규모 비지도 학습을 학습합니다. 다운스트림 작업에 레이블이 지정된 작은 샘플 세트를 사용하기 전에 강력한 작업 독립적 모델의 사전 교육(예: 자기 지도 학습을 통해 자유 텍스트에 대한 언어 모델 사전 교육 또는 레이블이 없는 이미지에 대한 비전 모델 사전 교육)에 대한 데이터 코퍼스 모델.

2. 준지도 학습: 레이블이 지정된 샘플과 레이블이 지정되지 않은 샘플에서 동시에 학습하는 방법으로 연구자들은 시각적 작업에 대한 많은 연구를 수행했습니다.

3. 능동적인 학습: 라벨링 비용이 높더라도 비용 예산이 제한되어 있어도 최대한 많은 라벨 데이터를 수집하기를 바랍니다. 능동적 학습은 라벨이 지정되지 않은 가장 가치 있는 샘플을 선택하는 방법을 학습하고 후속 수집 프로세스에서 이러한 데이터를 수집하여 제한된 예산 내에서 모델이 원하는 효과를 최대한 달성하도록 돕습니다.

4. 사전 훈련 + 데이터 세트 자동 생성: 강력한 사전 훈련 모델이 제공되면 모델을 사용하여 훨씬 더 많은 레이블이 지정된 샘플을 자동으로 생성할 수 있습니다. 퓨샷 학습의 성공에 힘입어 이 방법은 특히 언어 영역에서 널리 사용됩니다.

이 기사는 준지도 학습 방법을 포괄적으로 소개합니다. 저자는 OpenAI 연구원 Lilian Weng입니다. 블로그 주소: https://lilianweng.github.io/

1 준지도 학습이란 무엇인가요?

반지도 학습은 레이블이 지정된 데이터와 레이블이 지정되지 않은 데이터를 모두 사용하여 모델을 교육합니다. 흥미롭게도 준지도 학습에 관한 기존 문헌의 대부분은 비전 작업에 중점을 두고 있습니다. 사전 훈련 + 미세 조정 방법은 언어 작업에서 보다 일반적인 패러다임입니다. 이 글에서 언급된 모든 방법의 손실은 두 부분으로 구성됩니다:  . 감독 손실

. 감독 손실 은 모든 샘플에 라벨이 붙은 샘플을 사용하면 계산하기가 매우 쉽습니다. 우리는 감독되지 않은 손실을 설계하는 방법에 집중해야 합니다

은 모든 샘플에 라벨이 붙은 샘플을 사용하면 계산하기가 매우 쉽습니다. 우리는 감독되지 않은 손실을 설계하는 방법에 집중해야 합니다 . 가중치 항

. 가중치 항  은 일반적으로 기울기 함수를 사용하도록 선택됩니다. 여기서 t는 훈련 횟수가 증가함에 따라

은 일반적으로 기울기 함수를 사용하도록 선택됩니다. 여기서 t는 훈련 횟수가 증가함에 따라  의 비율이 증가합니다. 면책 조항: 이 문서에서는 모든 준지도 방법을 다루지는 않지만 모델 아키텍처 튜닝에만 중점을 둡니다. 준지도 학습에서 생성 모델 및 그래프 기반 방법을 사용하는 방법에 대한 자세한 내용은 "An Review of Deep Semi-Supervised Learning" 논문을 참조할 수 있습니다.

의 비율이 증가합니다. 면책 조항: 이 문서에서는 모든 준지도 방법을 다루지는 않지만 모델 아키텍처 튜닝에만 중점을 둡니다. 준지도 학습에서 생성 모델 및 그래프 기반 방법을 사용하는 방법에 대한 자세한 내용은 "An Review of Deep Semi-Supervised Learning" 논문을 참조할 수 있습니다.

2 기호 설명표

symbol |

meaning |

|

고유 태그 수. |

|

레이블 데이터 세트. 여기서 |

|

레이블이 지정되지 않은 데이터세트입니다. |

|

레이블이 지정된 샘플과 레이블이 지정되지 않은 샘플을 포함한 전체 데이터 세트입니다. |

|

라벨이 없는 샘플이나 라벨이 붙은 샘플을 나타낼 수 있습니다. |

|

향상된 라벨이 없는 샘플 또는 라벨이 붙은 샘플. |

|

i번째 샘플. |

|

은 각각 손실, 감독 손실 및 감독되지 않은 손실을 나타냅니다. | 훈련 단계 수에 따라 감독되지 않은 체중 감소 증가 증가로.

|

|

|

가중치 θ을 사용하여 생성된 신경망은 훈련될 것으로 예상되는 모델입니다. |

|

논리함수 f의 출력값으로 구성된 벡터. |

|

예상 라벨 배포. 평균 제곱 오차, 교차 엔트로피, KL 발산 등과 같은 두 분포 간의 거리 함수입니다. |

|

Teacher 모델 가중치에 대한 이동 평균 가중 하이퍼 매개변수입니다. |

|

α는 혼합 표본의 계수, |

|

예측 분포의 온도를 높입니다. . |

|

적격화된 예측 결과에 대한 신뢰도 임계값을 선택하세요. |

3 가정

기존 연구 문헌에서는 준지도 학습 방법의 특정 설계 결정을 지원하기 위해 다음 가정이 논의되었습니다.

가정 1: 부드러움 가정

두 개의 데이터 샘플이 특징 공간의 고밀도 영역에서 가까운 경우 해당 레이블은 동일하거나 매우 유사해야 합니다.

가정 2: 군집 가정

특징 공간에는 조밀한 영역과 희박한 영역이 모두 있습니다. 촘촘하게 그룹화된 데이터 포인트는 자연스럽게 클러스터를 형성합니다. 동일한 클러스터의 샘플에는 동일한 레이블이 있어야 합니다. 이는 가정 1의 작은 확장입니다.

가정 3: 저밀도 분리 가정

클래스 간의 결정 경계는 희박한 저밀도 영역에 위치하는 경향이 있습니다. 그렇지 않으면 결정 경계가 높아질 것이기 때문입니다. 밀도 클러스터링은 이에 상응하는 두 개의 클래스로 나뉩니다. 그러면 가정 1과 가정 2가 모두 실패하게 됩니다.

가정 4: 다양체 가정

고차원 데이터는 저차원 다양체에 위치하는 경향이 있습니다. 실제 데이터는 매우 높은 차원(예: 실제 개체/장면의 이미지)에서 관찰될 수 있지만 실제로는 낮은 차원의 다양체로 캡처할 수 있으며 데이터의 특정 속성을 캡처하고 일부 유사한 데이터 포인트를 밀접하게 그룹화합니다. (예를 들어 실제 객체/장면의 이미지는 모든 픽셀 조합의 균일한 분포에서 파생되지 않습니다.) 이를 통해 모델은 레이블이 지정되지 않은 데이터 포인트 간의 유사성을 발견하고 평가하는 보다 효율적인 표현 방법을 학습할 수 있습니다. 이는 표현 학습의 기초이기도 합니다. 이 가정에 대한 자세한 설명은 "반지도 학습에서 널리 사용되는 가정을 이해하는 방법" 기사를 참조하세요.

링크: https://stats.stackexchange.com/questions/66939/what-is-the-manifold-assumption-in-semi-supervised-learning

4 일관성 정규화 )

일관성 일관성 훈련이라고도 하는 정규화는 동일한 입력이 주어지면 신경망의 무작위성(예: Dropout 알고리즘 사용) 또는 데이터 확대 변환이 모델 예측을 변경하지 않는다고 가정합니다. 이 섹션의 각 방법에는 일관성 정규화 손실이 있습니다.  . SimCLR, BYOL 및 SimCSE와 같은 여러 자기 지도 학습 방법이 이 아이디어를 채택했습니다. 동일한 샘플의 서로 다른 향상된 버전은 동일한 표현을 생성합니다. 언어 모델링의 크로스 뷰 학습과 자기 지도 학습의 멀티 뷰 학습에 대한 연구 동기는 동일합니다.

. SimCLR, BYOL 및 SimCSE와 같은 여러 자기 지도 학습 방법이 이 아이디어를 채택했습니다. 동일한 샘플의 서로 다른 향상된 버전은 동일한 표현을 생성합니다. 언어 모델링의 크로스 뷰 학습과 자기 지도 학습의 멀티 뷰 학습에 대한 연구 동기는 동일합니다.

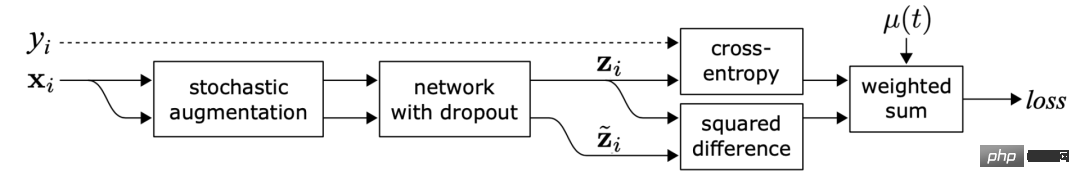

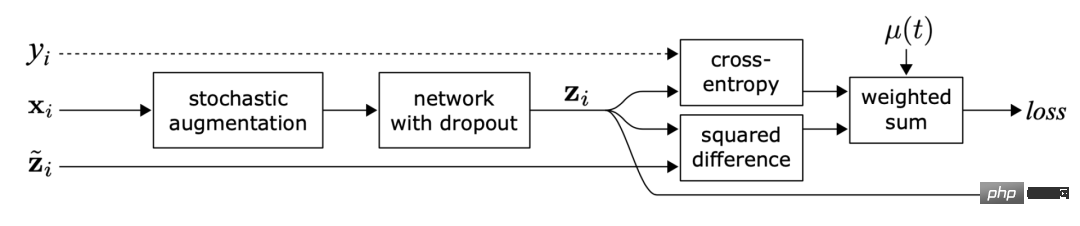

(1).Π model

그림 1: Π-모델 개요. 동일한 입력을 서로 다른 무작위 향상 및 드롭아웃 마스크로 교란하여 두 가지 버전을 생성하고 네트워크를 통해 두 개의 출력을 얻습니다. Π 모델은 두 출력이 일치한다고 예측합니다. (이미지 출처: 2017년에 출판된 Laine과 Aila의 논문 "Sequential Integration of Semi-supervised Learning")

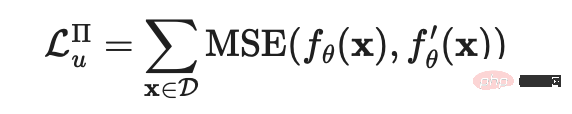

Sajjadi et al.은 2016년에 출판된 "Regularization With Stochastic Transformations and Perturbations for Deep Semi-Supervised Learning" 논문에서 비지도 학습 손실을 제안했습니다. 이는 무작위 변환(예: 드롭아웃)을 통해 동일한 데이터 포인트의 두 가지 버전을 생성할 수 있습니다. , 무작위 최대 풀링) 네트워크를 통과한 후 두 출력 결과 간의 차이를 최소화합니다. 레이블이 명시적으로 사용되지 않으므로 레이블이 지정되지 않은 데이터 세트에 이 손실이 적용될 수 있습니다. Laine과 Aila는 나중에 2017년에 출판된 "Temporal Ensembling for Semi-Supervised Learning" 논문에서 이 처리 방법에 Π 모델이라는 이름을 부여했습니다.  그 중

그 중  은 동일한 신경망에 적용되는 서로 다른 무작위 강화 또는 드롭아웃 마스크의 값을 나타냅니다. 이 손실은 전체 데이터 세트를 사용합니다.

은 동일한 신경망에 적용되는 서로 다른 무작위 강화 또는 드롭아웃 마스크의 값을 나타냅니다. 이 손실은 전체 데이터 세트를 사용합니다.

(2) 시간 통합(Temporal ensembling)

그림 2: 타이밍 통합 개요. 학습 목표는 각 샘플의 지수 이동 평균(EMA)에 대한 레이블 예측을 수행하는 것입니다. (이미지 출처: Laine과 Aila의 2017년 논문 "Sequential Integration of Semi-supervised Learning")

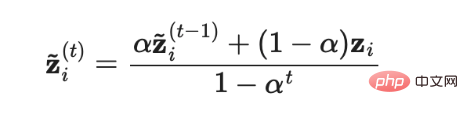

Π 모델에서는 각 샘플이 신경망을 두 번 통과해야 하므로 계산 비용이 두 배로 늘어납니다. 비용을 줄이기 위해 시간 앙상블 모델은 각 훈련 샘플 에 대한 실시간 모델 예측의 지수 이동 평균(EMA)을 학습 목표로 지속적으로 사용하며, EMA는 각 반복에서 한 번만 계산하고 업데이트하면 됩니다. . 순차 통합 모델의 출력

에 대한 실시간 모델 예측의 지수 이동 평균(EMA)을 학습 목표로 지속적으로 사용하며, EMA는 각 반복에서 한 번만 계산하고 업데이트하면 됩니다. . 순차 통합 모델의 출력  은 0으로 초기화되므로 이러한 시작 편향을 수정하기 위해

은 0으로 초기화되므로 이러한 시작 편향을 수정하기 위해  로 나누어 정규화합니다. Adam 옵티마이저도 같은 이유로 이러한 편향 보정 항을 가지고 있습니다.

로 나누어 정규화합니다. Adam 옵티마이저도 같은 이유로 이러한 편향 보정 항을 가지고 있습니다.  여기서

여기서  는 t번째 반복의 앙상블 예측이고

는 t번째 반복의 앙상블 예측이고  는 현재 라운드의 모델 예측입니다.

는 현재 라운드의 모델 예측입니다.  =0이므로 편향 수정 후

=0이므로 편향 수정 후  는 첫 번째 반복의 모델 예측 값

는 첫 번째 반복의 모델 예측 값  과 정확히 동일합니다.

과 정확히 동일합니다.

(3) 평균 교사

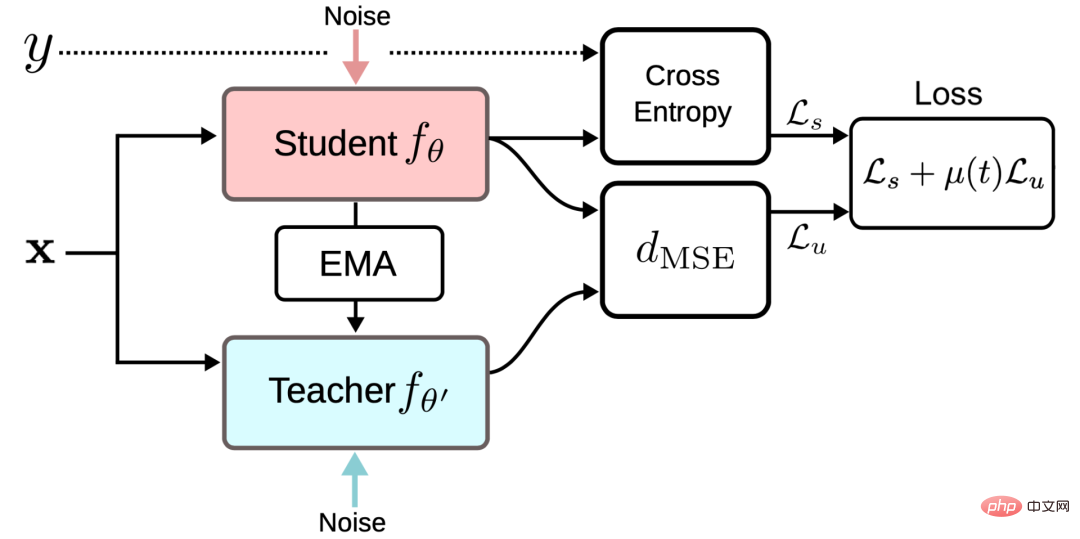

그림 3: 평균 교사 프레임워크 개요(이미지 출처: Tarvaninen 및 Valpola의 2017년 논문 "The Mean Teacher Model Is Better 예시 모델: 가중 평균 일관성 객관적 최적화) 준지도 딥러닝 결과》)

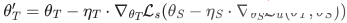

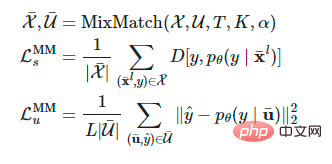

시간적 앙상블 모델은 학습 목표로 각 훈련 샘플에 대한 레이블 예측의 지수 이동 평균을 추적합니다. 그러나 이 레이블 예측은 각 반복에서만 변경되므로 훈련 데이터 세트가 클 경우 이 접근 방식이 번거로워집니다. 느린 목표 업데이트 속도 문제를 극복하기 위해 Tarvaninen과 Valpola는 2017년에 "평균 교사가 더 나은 역할 모델: 가중 평균 일관성 목표 최적화 준지도 딥러닝 결과"라는 논문을 발표했습니다. 평균 일관성 목표는 준지도 딥러닝 결과를 향상시킵니다), 모델 출력 대신 모델 가중치의 이동 평균을 추적하여 목표를 업데이트하는 Mean Teacher 알고리즘이 제안됩니다. 가중치가 θ인 원래 모델을 Student 모델이라고 하며, 가중치가 여러 개의 연속 Student 모델 θ′의 이동 평균 가중치인 모델을 Mean Teacher 모델이라고 합니다.

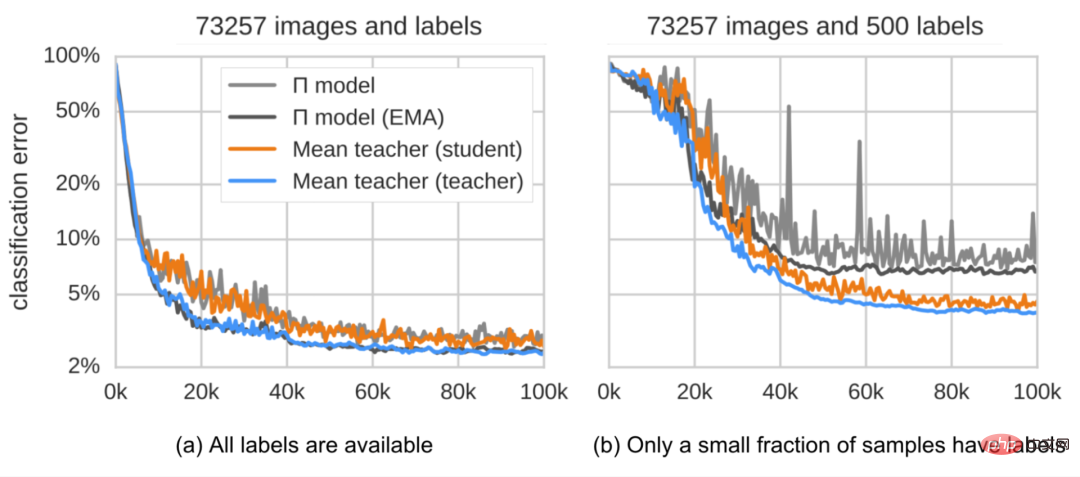

일관성 정규화 손실은 Student 모델과 Teacher 모델의 예측 간의 거리를 말하며, 이 차이를 최소화해야 합니다. Mean Teacher 모델은 Student 모델보다 더 정확한 예측을 제공할 수 있습니다. 이 결론은 그림 4와 같은 경험적 실험에서 확인되었습니다.

그림 4: SVHN 데이터 세트에서 Π 모델과 Mean Teacher 모델의 분류 오류. 평균 교사 모델(주황색 선으로 표시)은 학생 모델(파란색 선으로 표시)보다 성능이 더 좋습니다. (이미지 출처: Tarvaninen 및 Valpola의 2017년 논문 "The Mean Teacher Model is a Better-Performing Exemplar Model: Weighted Average Consistency Objective Optimization Semi-Supervised Deep Learning Results")

절제 연구에 따르면:

- 모델이 좋은 성능을 얻으려면 입력 향상 방법(예: 입력 이미지의 무작위 뒤집기, 가우시안 노이즈) 또는 Student 모델의 드롭아웃 처리가 필요합니다. 교사 모드에는 드롭아웃 처리가 필요하지 않습니다.

- 성능은 지수 이동 평균의 붕괴 하이퍼파라미터 β에 민감합니다. 더 나은 전략은 성장 단계에서 더 작은 β=0.99를 사용하고 학생 모델의 개선이 느려지는 후기 단계에서 더 큰 β=0.999를 사용하는 것입니다.

- 일관성 비용 함수의 평균 제곱 오차(MSE)가 KL 발산과 같은 다른 비용 함수보다 더 좋은 성능을 보이는 것으로 나타났습니다.

(4) 시끄러운 샘플을 학습 대상으로 사용

최근의 몇몇 일관성 훈련 방법은 레이블이 지정되지 않은 원본 샘플과 이에 대응하는 향상된 버전 간의 예측 차이를 최소화하는 방법을 학습합니다. 이 아이디어는 Π 모델과 매우 유사하지만 일관성 정규화 손실은 레이블이 없는 데이터에서만 작동합니다.

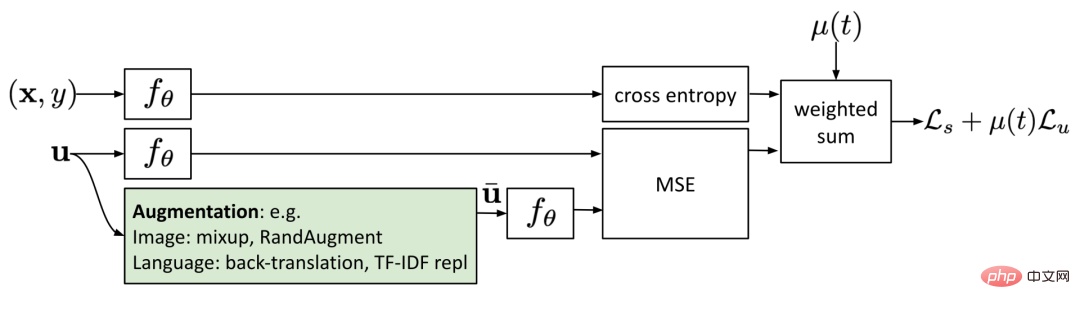

그림 5: 잡음이 있는 샘플을 사용한 일관성 훈련

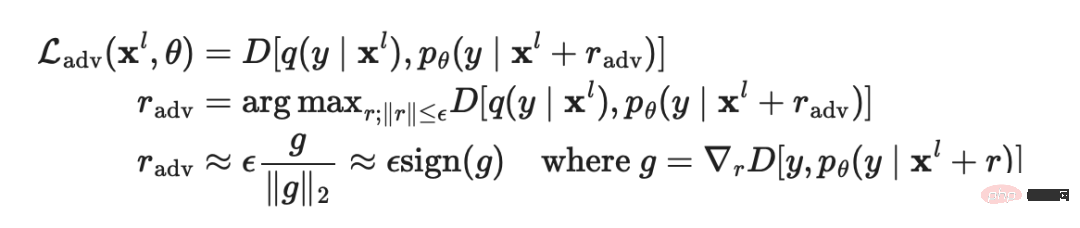

Goodfellow 등이 2014년에 발표한 "Explaining and Harnessing Adversarial 예제" 논문에서 적대적 훈련은 적대적 노이즈를 대상에 적용합니다. 이러한 적대적 공격에 강력하도록 모델을 입력하고 훈련시킵니다.

지도 학습에서 이 방법의 적용 공식은 다음과 같습니다.

여기서  는 실측 레이블에 근접한 원-핫 인코딩인 실제 분포이고,

는 실측 레이블에 근접한 원-핫 인코딩인 실제 분포이고,  는 모델 예측이고,

는 모델 예측이고,  는 두 분포 간의 차이를 계산하는 거리 함수입니다. Miyato 등은 2018년에 출판된 "Virtual Adversarial Training: A Regularization Method for Supervised and Semi-Supervised Learning"(Virtual Adversarial Training, VAT) 논문에서 가상 적대적 훈련을 제안했습니다. 준지도 학습 분야.

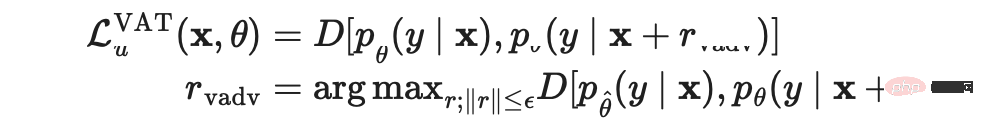

는 두 분포 간의 차이를 계산하는 거리 함수입니다. Miyato 등은 2018년에 출판된 "Virtual Adversarial Training: A Regularization Method for Supervised and Semi-Supervised Learning"(Virtual Adversarial Training, VAT) 논문에서 가상 적대적 훈련을 제안했습니다. 준지도 학습 분야.  는 알 수 없으므로 VAT는 현재 가중치가

는 알 수 없으므로 VAT는 현재 가중치가  로 설정된 경우 알 수 없는 항을 원래 입력에 대한 현재 모델의 예측으로 대체합니다.

로 설정된 경우 알 수 없는 항을 원래 입력에 대한 현재 모델의 예측으로 대체합니다.  는 모델 가중치의 고정 값이므로

는 모델 가중치의 고정 값이므로  에서는 그라데이션 업데이트가 수행되지 않습니다.

에서는 그라데이션 업데이트가 수행되지 않습니다.

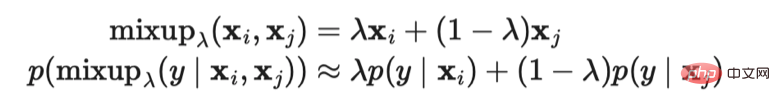

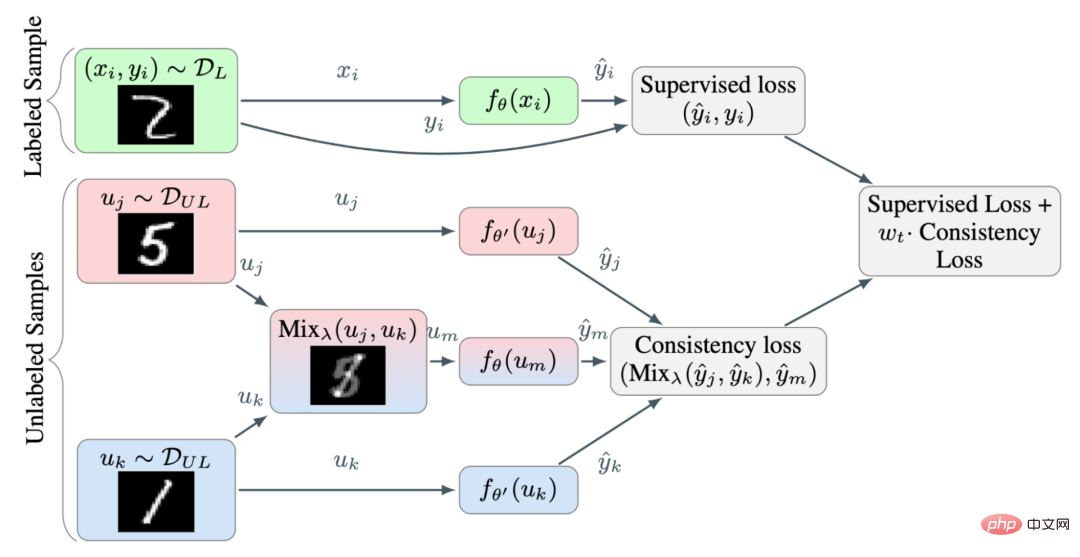

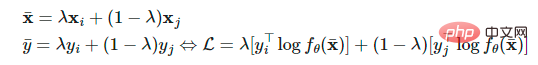

VAT 손실은 라벨이 붙은 샘플과 라벨이 붙지 않은 샘플 모두에 적용됩니다. 각 데이터 포인트에서 현재 모델 예측 다양체의 음의 평활도를 계산합니다. 이 손실을 최적화하면 예측 매니폴드가 더 부드러워질 수 있습니다. Verma 등은 2019년 논문 "반 지도 학습을 위한 보간 일관성 훈련(Interpolation Consistency Training for Semi-Supervised Learning)"에서 더 많은 데이터 포인트의 보간을 추가하여 모델 예측과 해당 레이블의 보간이 다음과 같이 되도록 데이터 세트를 강화합니다. 가능한 한 일관되게. Hongyi Zhang 등은 2018년 논문 "Mixup: Beyond Empirical Risk Minimization"에서 단순 가중 합을 통해 두 이미지를 혼합하는 MixUp 방법을 제안했습니다. 보간 일관성 훈련은 이 아이디어를 기반으로 하며 예측 모델이 해당 입력의 예측 보간과 일치하도록 혼합 샘플에 대한 레이블을 생성할 수 있도록 합니다.

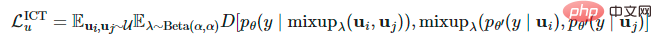

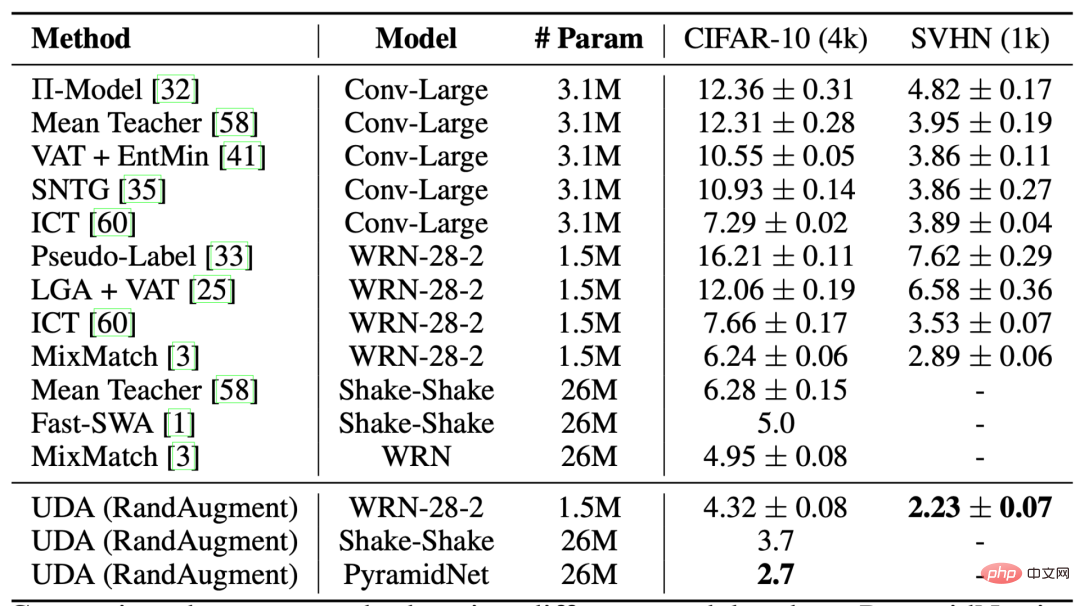

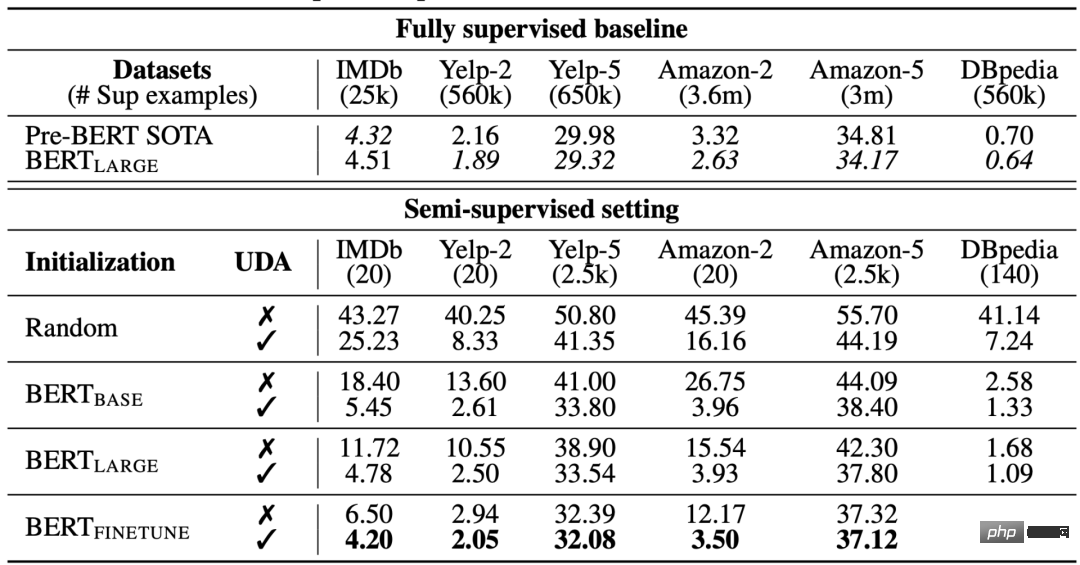

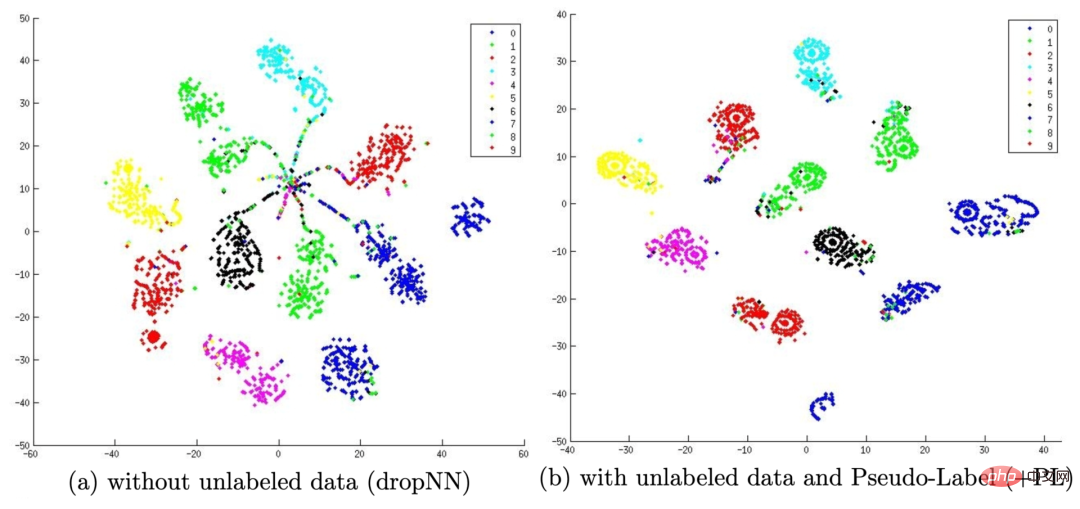

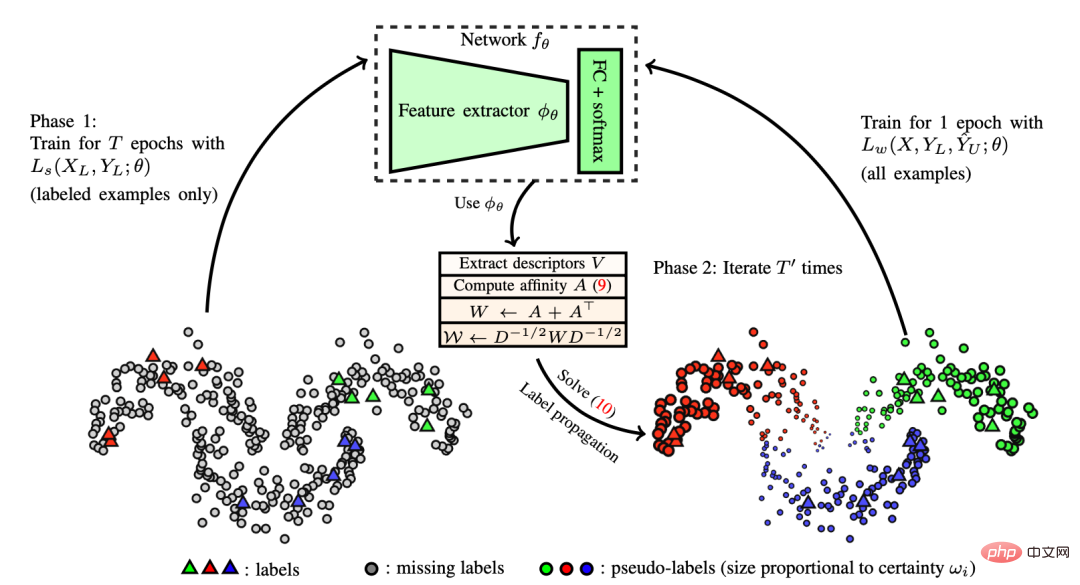

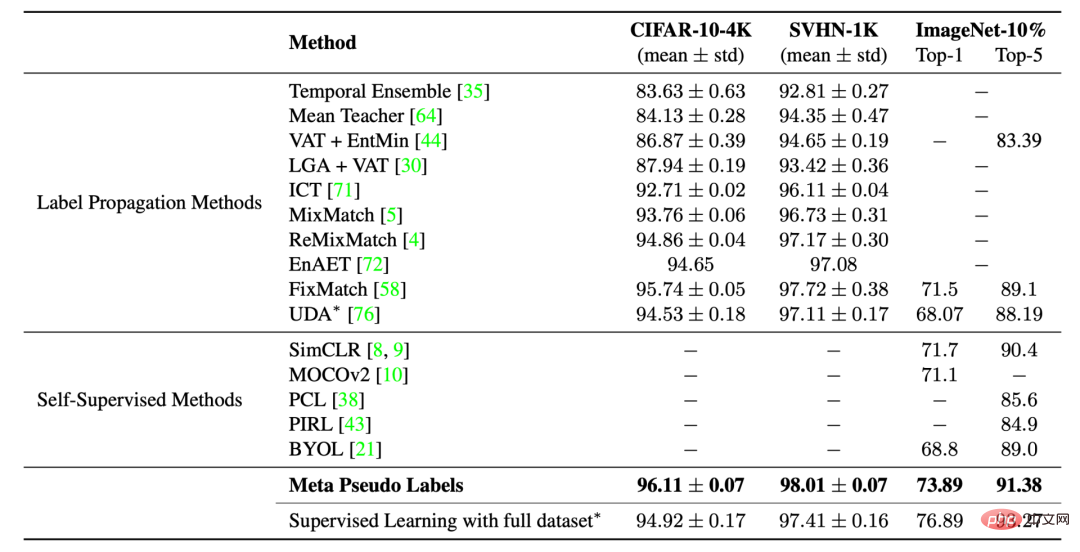

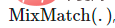

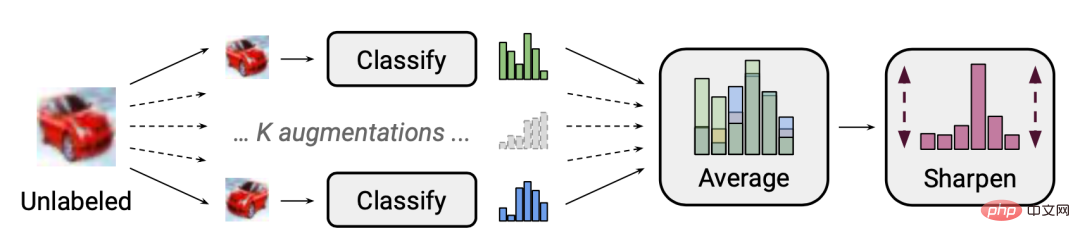

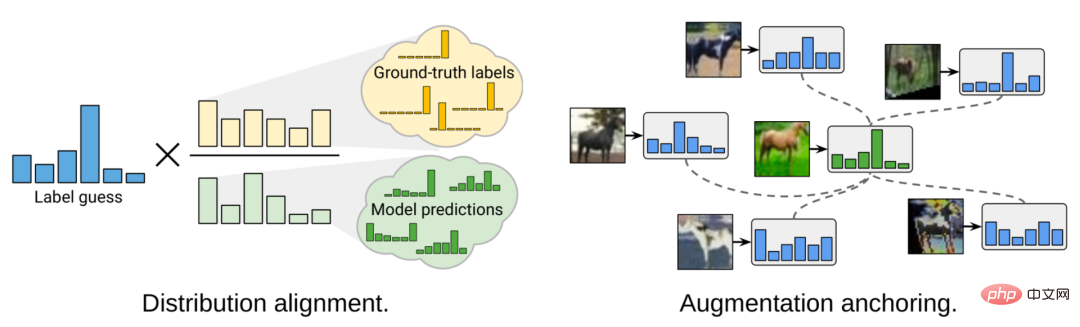

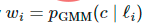

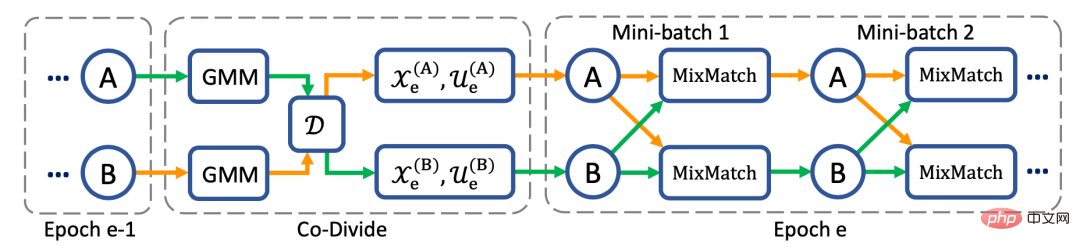

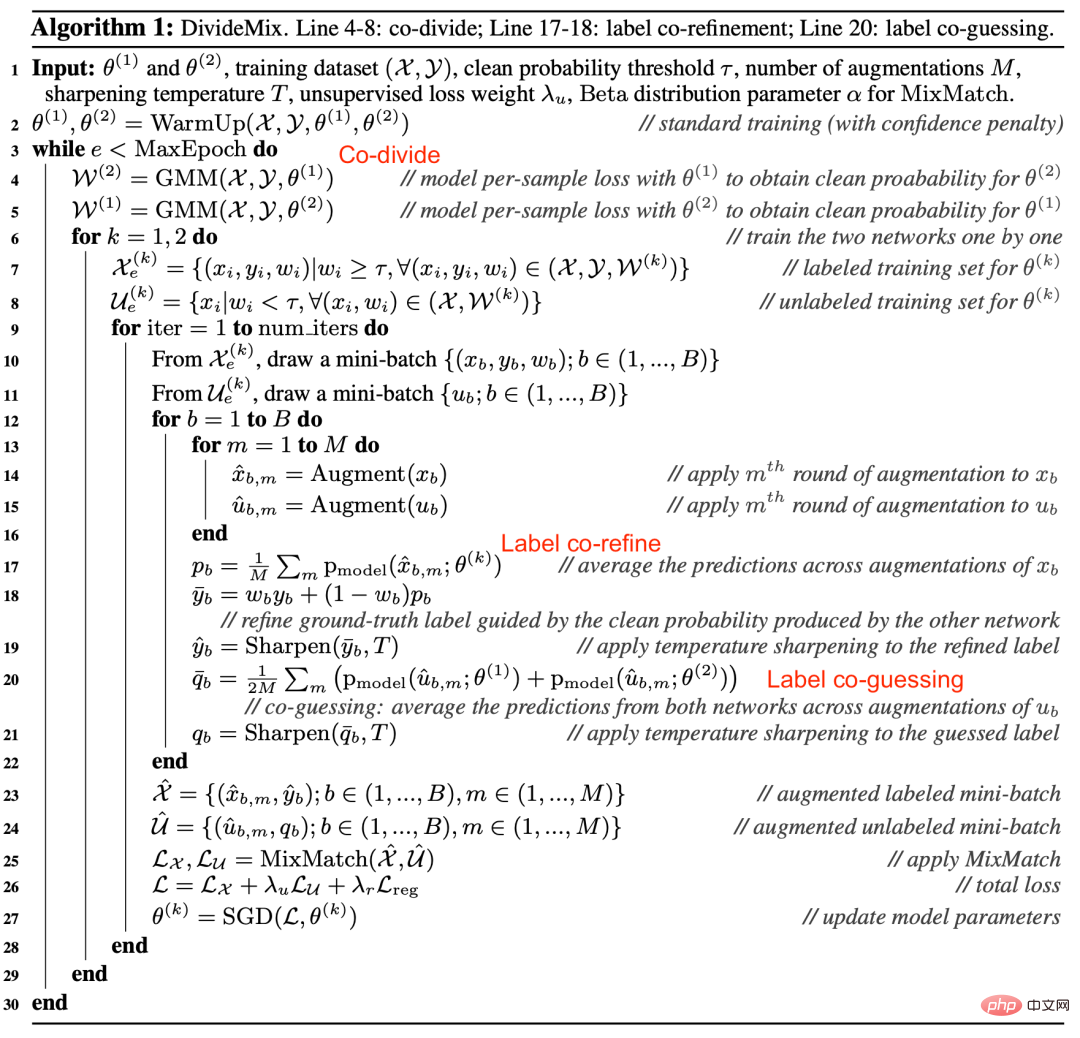

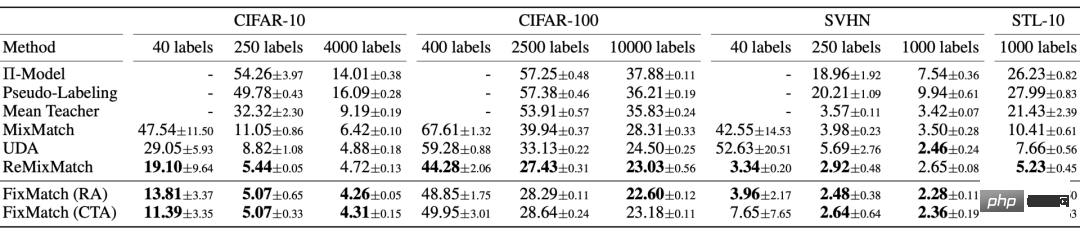

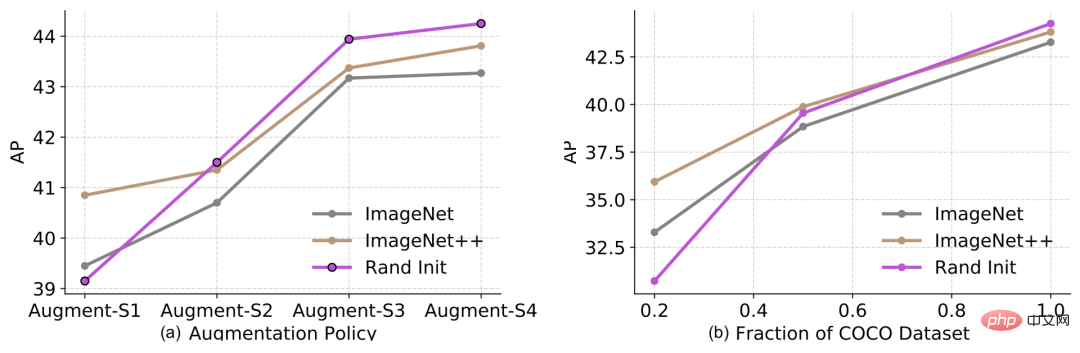

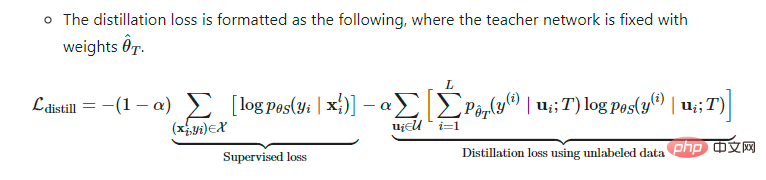

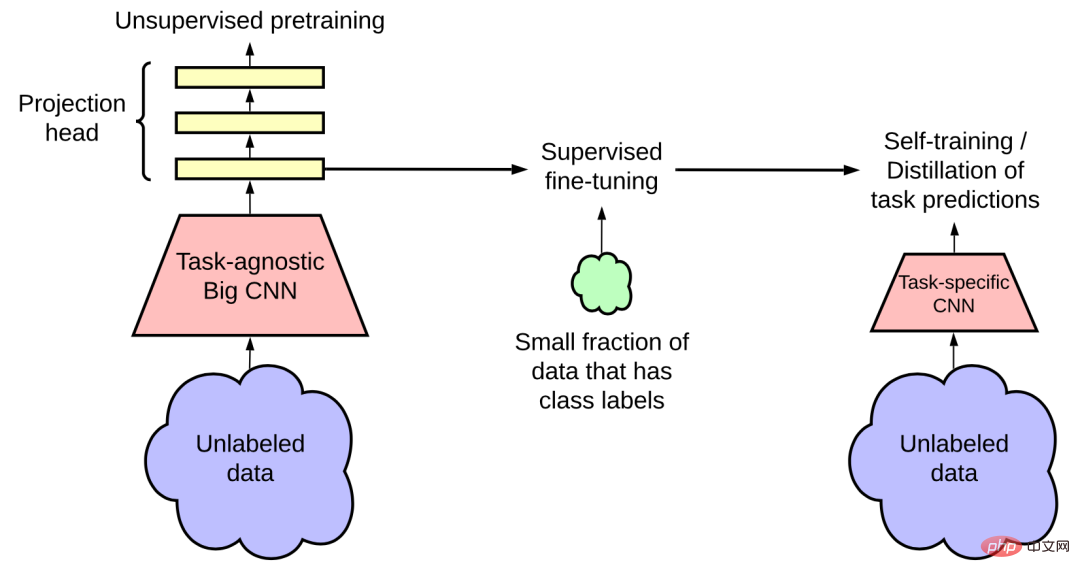

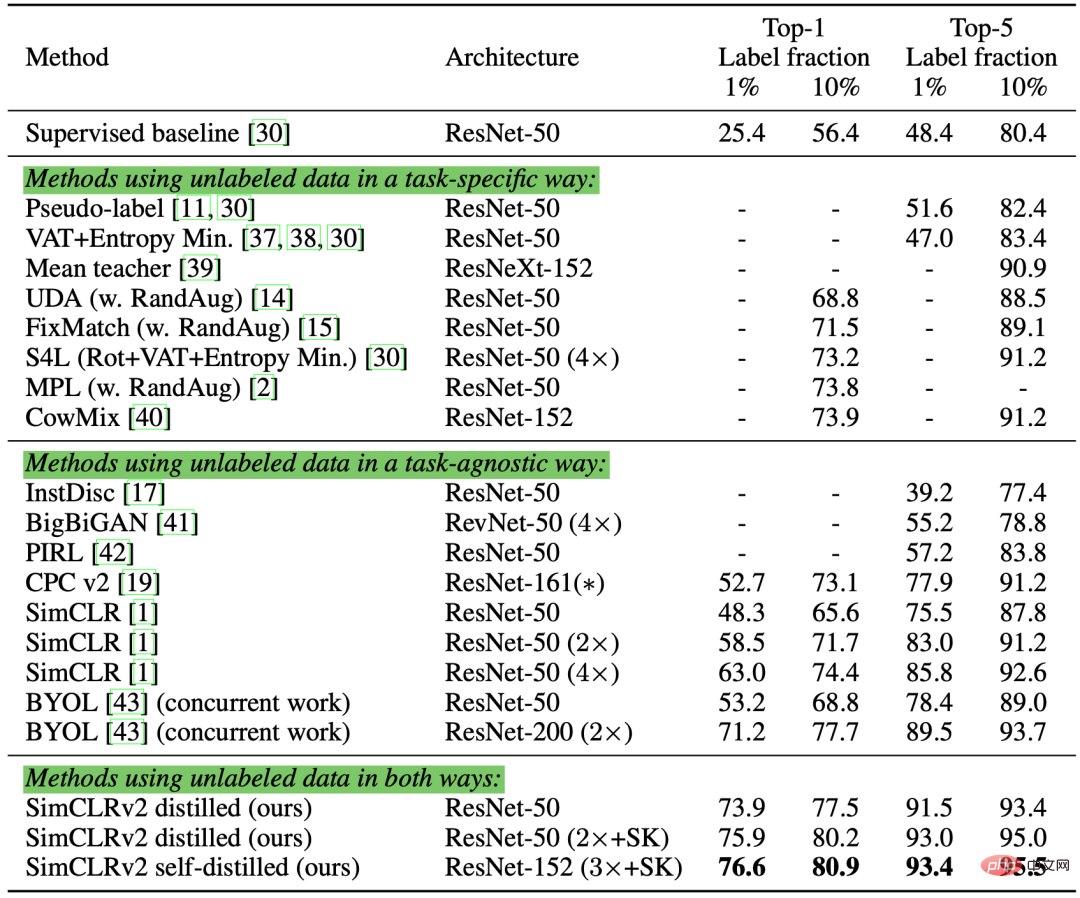

여기서 그림 6: 보간 일관성 훈련 개요. MixUp 메서드를 사용하면 보간 레이블을 학습 대상으로 사용하여 더 많은 보간 샘플을 생성할 수 있습니다. (이미지 출처: Verma et al.의 2019년 논문 "반 지도 학습을 위한 보간 일관성 훈련") 임의로 선택된 두 개의 레이블이 없는 샘플이 서로 다른 카테고리에 속할 확률은 매우 높기 때문에(예를 들어 ImageNet 대상 범주의 경우 1000), 따라서 레이블이 지정되지 않은 두 개의 무작위 샘플 사이에 Mixup 메서드를 적용하면 결정 경계 근처에서 보간이 생성될 가능성이 높습니다. 저밀도 분리 가설에 따르면 결정 경계는 종종 저밀도 영역에 위치합니다. 여기서 이미지 필드의 경우 UDA는 2019년 논문 "RandAugment: 검색 공간을 줄이기 위한 실용적인 자동화된 데이터 증대 방법"에서 Cubuk 등이 제안한 RandAugment 방법을 사용합니다(RandAugment: Practical Automated Data Augmentation with 제한된 검색 공간에서 제안됨). 학습이나 최적화 없이 Python 이미지 처리 라이브러리 PIL에서 사용할 수 있는 증대 작업을 균일하게 샘플링하므로 AutoAugment 방법을 사용하는 것보다 훨씬 저렴합니다. 그림 7: CIFAR-10 분류의 다양한 준지도 학습 방법 비교. RandAugment 처리 없이 50,000개 샘플을 훈련할 때 전체 감독 하에 있는 Wide-ResNet-28-2 및 PyramidNet+ShakeDrop의 오류율은 각각 **5.4** 및 **2.7**입니다. 언어 분야의 경우 UDA는 TF-IDF를 기반으로 역번역과 단어 대체의 조합을 사용합니다. 역번역은 높은 수준의 의미를 유지하지만 특정 단어 자체는 유지하지 않는 반면, TF-IDF 기반 단어 대체는 TF-IDF 점수가 낮고 정보가 없는 단어를 제거합니다. 언어 작업에 대한 실험에서 연구자들은 UDA가 전이 학습 및 표현 학습을 보완한다는 것을 발견했습니다. 예를 들어 도메인의 레이블이 없는 데이터(예: 그림 8의 그림 8: 다양한 텍스트 분류 작업에 대해 다양한 초기화 설정을 사용하는 비지도 데이터 향상 방법 비교. (이미지 출처: Xie et al.의 2020년 논문 "일관성 훈련을 위한 비지도 데이터 증강") 여기서 Lee et al.의 2013년 논문 "Pseudo-Label: The Simple and Efficient Semi-Supervised Pseudo-labeling은 Learning Method for Deep Neural Networks에서 제안되었으며, 이는 라벨이 지정되지 않은 샘플에 의사 라벨을 할당하는 것입니다. 현재 모델에서 예측한 최대 소프트맥스 확률을 기반으로 한 다음 완전히 감독되는 설정에서 레이블이 지정된 샘플과 레이블이 지정되지 않은 샘플에 대해 동시에 모델을 교육합니다. 의사 태그가 작동하는 이유는 무엇인가요? 의사 라벨링은 실제로 엔트로피 정규화와 동일합니다. 이는 라벨이 지정되지 않은 데이터의 클래스 확률에 대한 조건부 엔트로피를 최소화하여 클래스 간 저밀도 분리를 달성합니다. 즉, 예측된 클래스 확률은 실제로 클래스 중첩을 계산하고, 엔트로피를 최소화하는 것은 클래스 중첩을 줄여 밀도 분리를 줄이는 것과 동일합니다. 그림 9: (a)는 600개의 레이블이 지정된 데이터만 사용하여 모델을 학습시킨 후 MINIST 테스트 세트에 대한 테스트 출력의 t-SNE 시각화 결과를 보여주고, (b)는 600개의 레이블이 지정된 데이터를 사용하여 학습한 후를 보여줍니다. 레이블이 지정되지 않은 데이터의 60,000개의 의사 레이블이 있는 모델, 테스트 출력의 t-SNE 시각화 결과는 MINIST 테스트 세트에서 테스트됩니다. 의사 라벨은 학습된 임베딩 공간을 통해 더 나은 분리를 달성할 수 있습니다. (이미지 출처: Lee et al.의 2013년 논문 "Pseudo Labels: A Simple and Efficient Semi-supervised Learning Method for Deep Neural Networks") 의사 라벨을 사용한 훈련은 당연히 반복 프로세스입니다. 여기서 의사 라벨을 생성하는 모델을 Teacher 모델, 학습을 위해 의사 라벨을 사용하는 모델을 Student 모델이라고 합니다. Iscen et al.은 2019년에 발표된 논문 "Label Propagation for Deep Semi-supervised Learning"에서 라벨 전파 개념을 제안했습니다. 기능 임베딩. 그런 다음 의사 레이블은 그래프의 쌍별 유사성 점수에 비례하는 전파 가중치를 사용하여 알려진 샘플에서 레이블이 지정되지 않은 샘플로 "확산"됩니다. 개념적으로는 k-NN 분류기와 유사하지만 둘 다 대규모 데이터 세트에 잘 확장되지 않는 문제가 있습니다. 그림 10: 레이블 전파 작동 방식에 대한 개략도. (이미지 출처: Iscen et al.이 2019년에 출판한 "Label Propagation for Deep Semi-supervised Learning" 논문) Self-training은 새로운 개념이 아닙니다, Scudder et al. 1965년에 발표된 "일부 적응형 패턴 인식 기계의 오류 확률"이라는 논문에서 Nigram & Ghani et al.은 CIKM 2000에서 "협업 훈련의 효과 및 적용 가능성 분석"이라는 논문을 발표했습니다. 공동 훈련'은 모두 이 개념을 포함합니다. 레이블이 지정되지 않은 모든 샘플이 레이블과 일치할 때까지 다음 두 단계를 차례로 수행하는 반복 알고리즘입니다. Xie et al.이 2020년에 발표한 "Self-training with Noisy Student presents ImageNet classification" 논문에서는 self-training을 딥러닝에 적용하여 좋은 결과를 얻었습니다. ImageNet 분류 작업에서 연구원들은 먼저 EfficientNet 모델을 Teacher 모델로 훈련하여 레이블이 지정되지 않은 3억 개의 이미지에 대한 의사 레이블을 생성한 다음 실제 레이블이 있는 이미지와 의사 레이블 이미지를 학습하기 위해 더 큰 EfficientNet 모델을 Student 모델로 훈련했습니다. 실험 설정에서 핵심 요소는 Student 모델을 훈련하는 동안 잡음을 추가하는 반면 Teacher 모델은 의사 라벨 생성 과정에서 잡음을 추가하지 않습니다. 따라서 해당 방법을 "Noisy Student"라고 하며, 무작위 깊이, 드롭아웃 및 RandAugment 방법을 사용하여 Student 모델에 노이즈를 추가합니다. Student 모델은 주로 노이즈 추가의 이점으로 인해 Teacher 모델보다 더 나은 성능을 발휘합니다. 추가된 노이즈는 레이블이 지정된 데이터와 레이블이 지정되지 않은 데이터 모두에 대해 모델에서 생성된 결정 경계를 매끄럽게 만드는 복합 효과를 갖습니다. 학생 모델 자가 훈련을 위한 기타 중요한 기술 설정은 다음과 같습니다. Student 모델에 노이즈를 추가하면 모델이 적대적인 최적화 견고성을 대상으로 하지 않습니다. Du 등은 언어 분야의 자가 훈련 문제 해결을 목표로 2020년 논문 "Self-training Improves Pre-training for Natural Language Understanding"에서 SentAugment 방법을 제안했지만, 부족하다는 문제는 없습니다. 도메인의 데이터에 라벨을 붙입니다. 이는 문장 벡터를 사용하여 대규모 말뭉치에서 레이블이 지정되지 않은 도메인 내 샘플을 찾고 검색된 문장을 자체 학습에 사용합니다. 확증 편향은 Teacher 모델이 충분히 성숙되지 않았기 때문에 잘못된 의사 라벨을 제공하는 문제입니다. 잘못된 레이블에 과적합하면 더 나은 학생 모델이 생성되지 않을 수 있습니다. 확증 편향을 줄이기 위해 Eric Arazo 등은 "Pseudo-Labeling and 확증 편향 in Deep Semi-Supervised Learning"이라는 논문에서 두 가지 새로운 방법을 제안했습니다. 하나는 소프트 라벨을 사용하는 Mixup 방법입니다. 라벨링된 샘플이 너무 적다면 Mixup 방법을 사용하는 것만으로는 충분하지 않습니다. 따라서 논문의 저자는 각 미니 배치의 최소 라벨 샘플 수를 설정하기 위해 라벨 샘플을 오버샘플링했습니다. 이는 라벨이 붙은 샘플의 무게 보상보다 더 효과적입니다. 실제로는 더 불안정한 덜 빈번하고 큰 업데이트보다는 더 자주 업데이트되기 때문입니다. 일관성 정규화와 마찬가지로 데이터 증대 및 드롭아웃 방법도 의사 레이블 역할을 하는 데 중요합니다. Hieu Pham et al.은 2021년 논문 "Meta Pseudo Labels"에서 메타 의사 레이블을 제안했으며, 레이블 데이터 세트에 대한 성능에 대한 Student 모델의 피드백을 기반으로 Teacher 모델을 지속적으로 조정했습니다. Teacher 모델과 Student 모델은 동시에 훈련되고, Teacher 모델은 더 나은 의사 레이블을 생성하는 방법을 학습하고, Student 모델은 의사 레이블에서 학습합니다. Teacher 모델과 Student 모델의 가중치를 각각 하지만 위 방정식을 최적화하는 것은 쉬운 일이 아닙니다. MAML(Model-Agnostic Meta-Learnin)의 아이디어를 빌려, 다단계 연성 의사 레이블을 사용하기 때문에 위 목적 함수는 미분 함수입니다. 그러나 hard pseudo label을 사용하면 미분할 수 없는 함수이므로 REINFORCE와 같은 강화학습 방법이 필요하다. 최적화 프로세스는 두 모델을 번갈아가며 수행됩니다. 그림 11: 이미지 분류 작업에서 메타 의사 라벨링과 기타 준지도 또는 자체 감독 학습 방법의 성능 비교. (이미지 출처: Hieu Pham et al.의 2021년 논문 "Meta Pseudo Labels") 는 Consistency Regularization과 Pseudo Labels의 두 가지 방법을 결합하여 Semi-supervised에 적용할 수 있습니다. 학습. Berthelot et al.이 2019년 논문 "MixMatch: A Holistic Approach to Semi-Supervised Learning"에서 제안한 MixMatch 방법은 레이블이 지정되지 않은 데이터를 사용하는 준지도 학습에 적용되는 전체적인 접근 방식입니다. 다음 방법을 통합하여: 레이블이 있는 데이터 여기서 그림 12: MixMatch의 "레이블 추측" 프로세스: K개의 증가된 레이블이 없는 샘플의 평균을 내고, 예측된 한계 분포를 수정하고, 마지막으로 분포를 선명하게 합니다. (이미지 출처: Berthelot et al.의 2019년 논문 "MixMatch: A Holistic Method for Semi-supervised Learning") 본 논문의 절제 연구에 따르면 레이블이 없는 데이터의 MixUp 향상이 특히 중요합니다. 유사 라벨 분포에서 온도 선명화를 제거하면 성능에 심각한 영향을 미칠 수 있습니다. 레이블 추측의 경우 레이블이 지정되지 않은 데이터의 여러 증강 버전의 평균을 계산하는 것도 필수적입니다. 2020년 논문 "ReMixMatch: Semi-Supervised Learning with Distribution Alignment and Augmentation Anchoring"(ReMixMatch: Semi-Supervised Learning with Distribution Alignment and Augmentation Anchoring)에서 Berthelot et al.은 다음 두 가지 새로운 메커니즘을 도입하여 ReMixMatch 방법을 추가로 제안했습니다. MixMatch 방법을 개선하려면: 그림 13: ReMixMatch 방법에 의한 MixMatch 방법의 두 가지 개선 사항을 보여줍니다. (이미지 출처: Berthelot et al.의 2020년 논문 "ReMixMatch: 분포 정렬 및 향상된 앵커링을 사용한 준지도 학습") 1. 이 방법을 사용하면 한계 분포 한계 분포가 일관되지 않은 경우 엔트로피 최소화는 유용한 목표가 아니라는 점에 유의해야 합니다. 더욱이, 레이블이 있는 데이터와 레이블이 없는 데이터의 클래스 분포가 서로 일치한다는 가정은 실제로 너무 절대적이며 실제 환경에서 반드시 정확하지 않을 수도 있습니다. 2.증대 앵커링. 레이블이 지정되지 않은 샘플이 주어지면 약하게 향상된 "고정" 버전이 먼저 생성된 다음 CTAugment(Control Theory Augment) 방법을 사용하여 K개의 강력하게 향상된 버전의 평균을 계산합니다. CTAugment는 네트워크 허용 범위 내에서 예측이 유지되는 향상된 버전의 토크백 모델만 샘플링합니다. ReMixMatch 손실은 다음 항목으로 구성됩니다. Junnan Li et al.은 2020년 논문 "DivideMix: Learning with Noisy Labels as Semi-supervised Learning"에서 DivideMix 방법을 제안했습니다. 이는 준지도 학습과 시끄러운 레이블을 사용한 학습을 결합합니다( 시끄러운 레이블로 학습하기, LNL). GMM(가우스 혼합 모델)을 통해 각 샘플의 손실 분포를 모델링합니다. GMM은 훈련 데이터를 깨끗한 샘플이 포함된 레이블이 지정된 데이터 세트와 잡음이 있는 샘플이 포함된 레이블이 없는 데이터 세트로 동적으로 나눕니다. Arazo et al.이 2019년 논문 "비지도 라벨 노이즈 모델링 및 손실 수정"(비지도 라벨 노이즈 모델링 및 손실 수정)에서 제안한 아이디어에 따라 각 샘플 이진 가우스 혼합 모델에 교차 엔트로피 손실을 적용합니다. . 깨끗한 샘플은 시끄러운 샘플보다 손실이 더 빨리 낮아질 것으로 예상됩니다. 평균이 더 작은 가우스 혼합 모델은 깨끗한 레이블의 클러스터링에 해당하며 여기서는 c로 표시됩니다. 가우스 혼합 모델의 사후 확률 데이터 클러스터링 과정을 공동 분할이라고 합니다. 확증 편향을 피하기 위해 DividImax 방법은 두 개의 교차 네트워크를 동시에 교육합니다. 여기서 각 네트워크는 Double Q-Learning의 작동 방식과 유사하게 다른 네트워크의 데이터 세트 중 별도의 부분을 사용합니다. 그림 14: DivideMix는 확증 편향을 줄이기 위해 두 개의 네트워크를 독립적으로 교육합니다. 두 네트워크는 공동 파티셔닝, 공동 개선 및 공동 추측을 동시에 실행합니다. (이미지 출처: Junnan Li et al.의 2020년 논문 "DivideMix: 세미 지도 학습을 구현하기 위한 노이즈 레이블 학습 사용") MixMatch와 비교하여 DivideMix에는 노이즈 샘플 처리를 위한 추가 co- 분할 단계가 있습니다. 훈련 중에 다음과 같은 개선 사항을 적용했습니다. 라벨 공동 개선: 정답 라벨 레이블 공동 추측: 레이블이 지정되지 않은 데이터 샘플에 대한 두 모델의 예측을 평균화합니다. 그림 15: DivideMix 알고리즘. (이미지 출처: Junnan Li et al.의 2020년 논문 "DivideMix: Using Noisy Label Learning to Implement Semi-Supervised Learning") Sohn et al.의 2020년 논문 "FixMatch: 일관성 사용 "FixMatch: 일관성 및 신뢰도로 준지도 학습 단순화"에서 제안된 FixMatch 방법은 약한 향상 방법을 통해 레이블이 지정되지 않은 샘플에 의사 레이블을 생성하고 높은 신뢰도 예측만 유지합니다. 여기에서 약한 강화와 높은 신뢰도 필터링은 모두 고품질의 신뢰할 수 있는 의사 라벨 타겟을 생성하는 데 도움이 됩니다. 그런 다음 FixMatch는 크게 향상된 샘플을 통해 이러한 의사 레이블을 예측합니다. 그림 16: FixMatch 방법의 작동 방식을 보여주는 그림입니다. (이미지 출처: Sohn et al.의 2020년 논문 "FixMatch: Simplifying semi-supervised learning using Consistency and Confidential") 여기서 그림 17: 이미지 분류 작업에 대한 FixMatch 및 기타 여러 준지도 학습 방법의 성능. (이미지 출처: Sohn et al.의 2020년 논문 "FixMatch: Simplifying semi-supervised learning using Consistency and Confidential") FixMatch의 절제 연구에 따르면, 이 접근 방식은 자기 지도 학습을 통해 대규모 비지도 데이터 모음에서 작업 독립적 모델을 사전 학습한 다음 작은 레이블이 지정된 데이터 세트를 사용하여 다운스트림 작업에 대해 모델을 학습합니다. . 특히 언어 작업에서 일반적인 패러다임인 미세 조정. 연구에 따르면 준지도 학습과 사전 학습을 결합하면 모델이 추가적인 이점을 얻을 수 있는 것으로 나타났습니다. Zoph et al.의 2020년 논문 "사전 훈련 및 자가 훈련 재고"에서는 사전 훈련보다 자가 훈련이 얼마나 더 효과적인지 연구했습니다. 그들의 실험 설정은 COCO 결과를 개선하기 위해 사전 훈련 또는 자체 훈련에 ImageNet을 사용하는 것입니다. 자가 학습을 위해 ImageNet을 사용하는 경우 레이블을 삭제하고 ImageNet 샘플을 레이블이 없는 데이터 포인트로만 사용한다는 점에 유의하는 것이 중요합니다. He Kaiming과 다른 사람들은 2018년 논문 "Rethinking ImageNet Pre-training"에서 다운스트림 작업(예: 대상 감지)이 매우 다른 경우 ImageNet 분류 사전 훈련의 효과가 그리 좋지 않음을 입증했습니다. 그림 18: (a) 데이터 확대 결과(약한 것에서 강한 것까지) 및 (b) 레이블 데이터 세트 크기가 객체 감지 성능에 미치는 영향. 범례에서: "Rand Init"는 임의 가중치로 초기화된 모델을 나타냅니다. 'ImageNet'은 ImageNet 데이터세트에서 84.5%의 Top-1 정확도로 사전 훈련된 모델을 사용하여 초기화됩니다. 1 ImageNet 데이터 세트에서 84.5%의 정확도 -1은 86.9%의 정확도로 사전 훈련된 모델로 초기화됩니다. (이미지 출처: Zoph et al.의 2020년 논문 "Rethinking Pre-training and Self-Training") 이 실험에서 일련의 흥미로운 결과를 얻었습니다. 2020년 논문 "Big Self-Supervised Models are Strong Semi-Supervised Learners"(Big Self-Supervised Models are Strong Semi-Supervised Learners)에서 Ting Chen 외 연구진은 3단계 절차를 제안했습니다. 절차) 방법: 자기 지도 사전 훈련, 감독 미세 조정 및 자기 훈련의 장점을 결합합니다. 1. 대규모 모델을 훈련하려면 비지도 또는 하위 감독 방법을 사용합니다. 큰(깊고 넓은) 신경망을 사용하는 것이 중요한 일부 레이블이 있는 예제에서 모델을 미세 조정하는 것은 레이블이 지정된 예제가 적을수록 모델이 클수록 성능이 향상되기 때문입니다. 3. 자체 학습에 의사 레이블을 사용하여 레이블이 없는 예를 추출합니다. a. 이 작업별 사용에는 학습된 표현의 추가 용량이 필요하지 않기 때문에 큰 모델에 대한 지식을 작은 모델로 증류할 수 있습니다. b. 증류 손실 공식은 다음과 같습니다. 여기서 Teacher 네트워크는 고정되고 가중치는 그림 19: 준지도 학습 프레임워크는 작업에 구애받지 않는 비지도 사전 학습(왼쪽) 및 작업별 자가 학습 및 증류(오른쪽)를 통해 라벨 프리를 사용합니다. 데이터 코퍼스. (이미지 출처: Ting Chen et al.의 2020년 논문 "대규모 자기 지도 모델은 강력한 준지도 학습자입니다") 논문의 저자는 ImageNet 분류 작업에 대한 실험을 수행했습니다. 자기 감독 사전 학습에서는 SimCLR을 직접적으로 개선한 SimCLRv2를 사용합니다. 실증적 연구에서 관찰한 결과 Zoph et al.이 2020년에 제안한 결과 중 일부가 확인되었습니다. 그림 20: ImageNet 분류에 대한 SimCLRv2 + 준감독 증류의 성능 비교. (이미지 출처: Ting Chen et al.의 2020년 논문 "Large-scale self-supervised models are Powerful semi-supervised learners") 최근의 준지도 학습 방법을 요약하면 다양한 방법이 목표를 가지고 있음을 알 수 있습니다. 확증 편향 감소: 인용하려면 다음을 표시하세요. 는 평균 교사 모델 값.

는 평균 교사 모델 값.

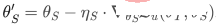

는 θ의 이동 평균을 나타냅니다. VAT와 유사하게 Xie 등이 2020년 논문 "일관성 훈련을 위한 비지도 데이터 확대"에서 제안한 UDA(비지도 데이터 증강)는 레이블이 지정되지 않은 샘플을 제공하는 방법을 학습합니다. 증강 샘플에서 예측한 것과 동일한 출력입니다. UDA는 특히 일관된 훈련을 통해 소음의 "품질"이 준지도 학습 성능에 어떤 영향을 미치는지 연구하는 데 중점을 둡니다. 의미 있고 효율적인 노이즈 샘플을 생성하려면 고급 데이터 증대 방법을 사용하는 것이 중요합니다. 좋은 데이터 증대 방법은 목표로 삼은 유도 바이어스를 사용하여 효율적이고(즉, 라벨을 변경하지 않음) 다양한 노이즈를 생성할 수 있어야 합니다.

는 θ의 이동 평균을 나타냅니다. VAT와 유사하게 Xie 등이 2020년 논문 "일관성 훈련을 위한 비지도 데이터 확대"에서 제안한 UDA(비지도 데이터 증강)는 레이블이 지정되지 않은 샘플을 제공하는 방법을 학습합니다. 증강 샘플에서 예측한 것과 동일한 출력입니다. UDA는 특히 일관된 훈련을 통해 소음의 "품질"이 준지도 학습 성능에 어떤 영향을 미치는지 연구하는 데 중점을 둡니다. 의미 있고 효율적인 노이즈 샘플을 생성하려면 고급 데이터 증대 방법을 사용하는 것이 중요합니다. 좋은 데이터 증대 방법은 목표로 삼은 유도 바이어스를 사용하여 효율적이고(즉, 라벨을 변경하지 않음) 다양한 노이즈를 생성할 수 있어야 합니다.

)에 대한 BERT 모델을 미세 조정하면 성능이 더욱 향상될 수 있습니다.

)에 대한 BERT 모델을 미세 조정하면 성능이 더욱 향상될 수 있습니다.

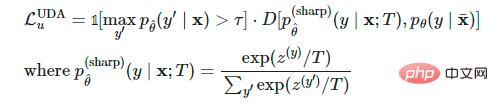

을 계산할 때 UDA는 다음 세 가지 훈련 기술을 사용하여 결과를 최적화할 수 있습니다.

을 계산할 때 UDA는 다음 세 가지 훈련 기술을 사용하여 결과를 최적화할 수 있습니다.

보다 낮으면 마스킹됩니다.

보다 낮으면 마스킹됩니다.

을 사용하여 예측 확률 분포를 선명하게 합니다.

을 사용하여 예측 확률 분포를 선명하게 합니다.

는 모델 가중치의 고정 값이며 VAT의

는 모델 가중치의 고정 값이며 VAT의  과 동일하므로 그라데이션 업데이트가 없습니다.

과 동일하므로 그라데이션 업데이트가 없습니다.  는 향상된 데이터 포인트,

는 향상된 데이터 포인트,  는 예측 신뢰도 임계값입니다.

는 예측 신뢰도 임계값입니다.  는 샤프닝 온도 분포입니다.

는 샤프닝 온도 분포입니다. 5 의사 라벨링

(1) 라벨 전파

(2) Self-Training

(3) 확증 편향(Confirmation Bias) 줄이기

두 개의 샘플과 그에 상응하는 실제 라벨과 의사 라벨

두 개의 샘플과 그에 상응하는 실제 라벨과 의사 라벨 이 주어지면 보간 라벨 방정식은 소프트맥스 출력의 교차 엔트로피 손실로 변환될 수 있습니다.

이 주어지면 보간 라벨 방정식은 소프트맥스 출력의 교차 엔트로피 손실로 변환될 수 있습니다.

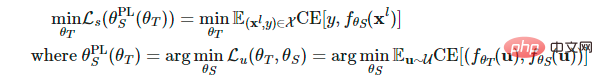

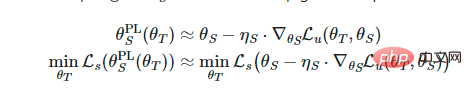

및

및  로 설정합니다. 레이블이 지정된 샘플에서 Student 모델의 손실은

로 설정합니다. 레이블이 지정된 샘플에서 Student 모델의 손실은

의 함수로 정의되며 이에 따라 Teacher 모델을 최적화하여 이 손실을 최소화하는 경향이 있습니다. .

의 함수로 정의되며 이에 따라 Teacher 모델을 최적화하여 이 손실을 최소화하는 경향이 있습니다. .

계산을 수행하면서

계산을 수행하면서  에 대해 1단계 그래디언트 업데이트를 수행하는 것과 유사합니다.

에 대해 1단계 그래디언트 업데이트를 수행하는 것과 유사합니다.

가 주어지면 함수

가 주어지면 함수  를 통해 의사 레이블을 생성하고 1단계 확률적 경사 하강법을 사용하여 최적화

를 통해 의사 레이블을 생성하고 1단계 확률적 경사 하강법을 사용하여 최적화  할 수 있습니다:

할 수 있습니다:  .

.  학생 모델의 업데이트를 재사용하여 최적화합니다

학생 모델의 업데이트를 재사용하여 최적화합니다  :

:  . 또한 UDA 개체는 일관적인 정규화를 통합하기 위해 Teacher 모델에 적용됩니다.

. 또한 UDA 개체는 일관적인 정규화를 통합하기 위해 Teacher 모델에 적용됩니다.

6 Consistency Regularization + Pseudo Labels

(1) MixMatch

와 레이블이 없는 데이터

와 레이블이 없는 데이터 의 배치가 주어지면 향상된 버전은

의 배치가 주어지면 향상된 버전은  작업을 통해 얻어지며,

작업을 통해 얻어지며,  및

및  는 각각 향상된 샘플과 레이블이 없는 샘플에 대한 예측 레이블을 나타냅니다.

는 각각 향상된 샘플과 레이블이 없는 샘플에 대한 예측 레이블을 나타냅니다.

는 추측된 라벨 중복을 줄이는 데 사용되는 선명화 온도입니다. K는 라벨이 지정되지 않은 각 샘플에 대해 생성된 향상된 버전의 수입니다. 각각의

는 추측된 라벨 중복을 줄이는 데 사용되는 선명화 온도입니다. K는 라벨이 지정되지 않은 각 샘플에 대해 생성된 향상된 버전의 수입니다. 각각의  에 대해 MixMatch는 K개의 향상된 버전을 생성하고,

에 대해 MixMatch는 K개의 향상된 버전을 생성하고,  는 k를 1로, ....,

는 k를 1로, ....,  의 K개의 향상된 버전을 생성하고, 모델은 평균

의 K개의 향상된 버전을 생성하고, 모델은 평균  을 기반으로 의사 라벨을 추측합니다.

을 기반으로 의사 라벨을 추측합니다.

가 실제 라벨의 한계 분포에 가까워집니다.

가 실제 라벨의 한계 분포에 가까워집니다.  를 정답 레이블의 클래스 분포로 설정하고

를 정답 레이블의 클래스 분포로 설정하고  를 레이블이 지정되지 않은 데이터에 대한 예측 클래스 분포의 이동 평균으로 설정합니다. 레이블이 지정되지 않은 샘플

를 레이블이 지정되지 않은 데이터에 대한 예측 클래스 분포의 이동 평균으로 설정합니다. 레이블이 지정되지 않은 샘플  에 대한 모델의 예측은 실제 주변 분포와 일치하도록

에 대한 모델의 예측은 실제 주변 분포와 일치하도록  로 정규화됩니다.

로 정규화됩니다.

(2) DivideMix

(즉, 샘플이 깨끗한 샘플 집합에 속할 확률)이 임계값보다 크면 샘플은 깨끗한 샘플로 간주되고, 그렇지 않으면 노이즈 샘플로 간주됩니다.

(즉, 샘플이 깨끗한 샘플 집합에 속할 확률)이 임계값보다 크면 샘플은 깨끗한 샘플로 간주되고, 그렇지 않으면 노이즈 샘플로 간주됩니다.

을 네트워크 예측

을 네트워크 예측  과 선형적으로 결합합니다. 여기서

과 선형적으로 결합합니다. 여기서  는 다른 네트워크가 깨끗한 데이터 세트

는 다른 네트워크가 깨끗한 데이터 세트  조건,

조건,  여러 향상된 버전의 평균을 생성할 확률입니다.

여러 향상된 버전의 평균을 생성할 확률입니다.

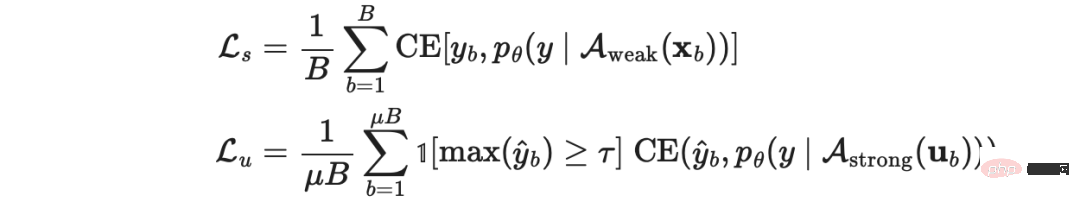

(3) FixMatch

는 라벨이 지정되지 않은 샘플의 의사 라벨입니다.

는 라벨이 지정되지 않은 샘플의 의사 라벨입니다.  및

및  의 상대적인 크기의 하이퍼파라미터입니다. 약한 향상

의 상대적인 크기의 하이퍼파라미터입니다. 약한 향상 : 표준 번역 및 변환 향상. 강력한 향상

: 표준 번역 및 변환 향상. 강력한 향상 : AutoAugment, Cutout, RandAugment 및 CTAugment와 같은 데이터 향상 방법.

: AutoAugment, Cutout, RandAugment 및 CTAugment와 같은 데이터 향상 방법.

7 강력한 사전 학습과 결합

입니다.

입니다.

위 내용은 OpenAI 연구원: 데이터가 부족할 때 지도 학습을 구현하는 방법의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

는 실제 레이블의 원-핫 표현입니다.

는 실제 레이블의 원-핫 표현입니다.

입니다.

입니다.