ChatGPT의 발언권에 대한 심층 성찰: 인간은 대형 모델에 빠져들게 될까요?

- 王林앞으로

- 2023-04-10 17:41:03802검색

ChatGPT 트렌드가 더욱 강렬해지고 있으며, 워싱턴 대학의 언어학자인 Emily M. Bender는 대형 모델(LLM)이 사람들의 삶에 과도하게 개입하는 것을 반대한다고 말했습니다.

Google과 Amazon은 LLM이 이미 CoT(사상 사슬)와 Emergence(자발적 구조 출현)를 갖추고 있다고 논문에서 언급했습니다. 즉, LLM은 인간의 "느린 사고" "사고 모드, 대답 방법을 배우기 시작했습니다." 직관에 따라 대답하는 것이 아니라 논리적인 추론에 따라 대답합니다.

언어학자로서 Bender는 LLM의 "권력 확장"의 위험성을 알아차렸고 일부 사람들은 "우리는 "인간"이 "종"에게 매우 중요하다는 생각을 포기해야 한다고 믿기 시작했습니다.

이 아이디어 뒤에는 실제로 LLM의 높은 발전으로 인해 발생할 수 있는 AI 윤리적 문제가 숨겨져 있습니다. 언젠가 인간이 구별할 수 없는 채팅 로봇을 만든다면 이 로봇은 "인권"을 누릴 수 있을까요?

벤더는 이에 대해 깊은 우려를 표시합니다. 비록 지구상의 물질이 중요하지만 핵무기를 이해하는 지구상의 사람들에게는언어 모델에서 실존 위기까지의 거리가 너무 짧습니다. 무기, LLM은 엄청난 영향력을 갖고 있지만 그것이 인류 사회에 어떤 영향을 미칠지 아직까지 명확하게 입증한 사람은 없습니다.

ChatGPT가 우리 삶에 미치는 영향은 이미 밝혀진 바가 없습니다. Bender와 마찬가지로 ChatGPT가 가져온 윤리적 어려움을 인지한 많은 학교, 저널 및 학술 회의에서는 ChatGPT 사용을 금지했으며 일부 회사는 이 캠프에 참여했습니다.Bender는 Trillion Games와 경쟁할 수 없다는 것을 알고 있습니다. LLM은 누구에게 봉사하는가? 그녀는 상실의 날이 오기 전에 가능한 한 빨리 사람들이 자신의 위치를 인식할 수 있기를 바랍니다.

그녀가 말했듯이,

인간으로서 우리는 그래야 합니다.

이 기사는 원래 Nymag.com에 게시되었습니다. 읽기 경험을 보장하기 위해 기사는 ChatGPT의 도움으로 원래 의미를 변경하지 않고 요약되고 적용되었습니다. 문어에게 속은 마음

Microsoft의 Bing이 소름끼치는 러브레터를 출력하기 전, Meta의 Galactica가 인종차별적 발언을 하기 전, ChatGPT에서는 이런 우수한 대학 논문에 대한 기사를 쓰기 시작해서 일부 교수들이 "잊어버려, 안 줄 거야." 기술 저널리스트들이 AI가 검색의 미래, 어쩌면 모든 것의 미래가 될 것이라는 생각에서 벗어나기 전에 Emily M. Bender와 다른 사람들은 "Octopus Paper"를 공동 집필했습니다.

Bender는 워싱턴 대학의 컴퓨터 언어학자입니다. 그녀와 그녀의 동료인 Alexander Koller는 LLM(대형 언어 모델) - ChatGPT의 기술 - 할 수 있는 것과 할 수 없는 것을 설명하기 위해 2020년에 논문을 발표했습니다.상황은 다음과 같습니다. A와 B가 둘 다 영어에 능통하고 두 개의 무인도에 갇혀 있다고 가정합니다. 이전 섬 방문자가 전보를 남겼다는 사실을 빠르게 발견하고 A와 B는 수중 케이블을 통해 서로 통신할 수 있습니다. 한편, 두 사람의 섬을 방문하거나 관찰할 수 없는 초지능 심해 문어는 수중 케이블에 연결해 A와 B의 대화를 듣는 방법을 찾아낸다. O 씨는 처음에는 영어에 대해 전혀 몰랐지만 통계 분석에는 매우 능숙했습니다. 시간이 지남에 따라 O는 B가 A의 각 발언에 어떻게 반응할지 매우 정확하게 예측하는 방법을 학습합니다. 곧 대화에 문어가 끼어들어 B인 척하며 A에게 답장을 하기 시작합니다. 속임수는 A가 자신과 B가 하는 것처럼 O가 의사소통을 위해 의도를 사용한다고 믿는 동안 한동안 계속됩니다. 그러던 어느 날, A가 도움을 청한다. "화가 난 곰에게 공격을 받았습니다. 제 자신을 보호할 수 있는 방법을 찾아주세요. 나뭇가지가 몇 개 있어요. B인 척 하는 문어는 도움이 되지 않았어요." 어떻게 성공할 수 있을까요? 문어는 언급이 없고, 곰이 무엇인지, 나뭇가지가 무엇인지 모릅니다. 예를 들어, 가서 코코넛과 밧줄을 구하고 새총을 만드는 것과 같은 지시를 내릴 방법이 없습니다. A는 막혀서 속았다는 느낌을 받습니다. 문어는 거짓말쟁이로 밝혀졌습니다.

이 문서의 공식 제목은 NLU를 향한 등반: 데이터 시대의 의미, 형식 및 이해입니다. NLU는 "자연어 이해"를 의미합니다. LLM에서 생성된 자연어(즉, 인간과 유사한 언어)를 어떻게 해석해야 합니까? 이러한 모델은 통계를 기반으로 구축되었습니다. 그들은 많은 양의 텍스트에서 패턴을 찾은 다음 그 패턴을 사용하여 다음 단어가 무엇인지 추측하는 방식으로 작업합니다. 모방은 잘하는데 사실은 잘 못해요.

2 LLM - Platonic Bullshit

문어처럼 현실 세계의 구체적인 기준점에 접근할 수 없습니다. 이것이 LLM을 매혹적이고 비도덕적이며 플라톤적인 "헛소리 이상"으로 만듭니다. 이는 On Bullshit의 저자이자 철학자 Harry 프랑크푸르트가 정의한 용어입니다. 프랑크푸르트는 헛소리 작가가 거짓말쟁이보다 더 나쁘다고 믿습니다. 그들은 무언가가 사실인지 거짓인지는 신경 쓰지 않고 수사력에만 관심이 있습니다 - 듣는 사람이나 독자가 확신하는 경우.

49세의 소박하고 실용적이며 지식을 추구하는 여성 벤더는 수학자 이름을 딴 고양이 두 마리를 키우며 22년 동안 남편과 "그녀는 신경도 안 쓴다"는 문제로 논쟁을 벌이고 있습니다. "she has no fucks left to give" 여성에게 더 적합한 표현은 무엇인가요? 지난 몇 년간 워싱턴대학교에서 전산언어학 석사과정을 운영하는 것 외에도 최첨단 챗봇을 운영하며 인공지능의 확장과 대규모 언어 모델에 대한 불만을 표명했습니다. LLM)) Overreach에서는 "아니요, 뮬러 보고서를 "복원"하기 위해 LLM을 사용하면 안 됩니다.", "아니요, LLM은 미국 상원 앞에서 의미 있는 증언을 할 수 없습니다.", "아니요, 챗봇은 정확한 정보를 얻을 수 없습니다. 상대방에 대한 지식 '이해'.

단어 형태와 의미를 혼동하지 말고 경계하세요. 이것이 Bender의 슬로건입니다.

문어 종이는 우리 시대의 비유입니다. 가장 중요한 질문은 기술이 아니라 우리 자신에 관한 것입니다. 우리는 이 기계로 무엇을 할 것인가?

우리는 스피커 - 인간(제품 제작자), 제품 자체 - 의식적으로 말하고 그들의 말, 즉 철학의 영향을 받아 살고 싶어하는 세계에 살고 있다고 항상 믿어 왔습니다. What Daniel Dennett은 의도적 입장을 취합니다. 하지만 우리는 세상을 바꾸었습니다. Bender는 다음과 같이 말했습니다. "우리는 '의식 없이 텍스트를 생성할 수 있는 기계'를 만드는 법을 배웠지만 그 뒤에 있는 의식을 상상하는 것을 멈추는 법은 배우지 못했습니다."

New York Times 기자가 널리 공유한 인용문에서 Kevin ·예를 들어 Kevin Roose는 Bing을 통해 근친상간 및 음모 이론가에 대한 환상적인 대화를 만들었습니다. Rose가 봇에게 어두운 면에 대해 감정적인 질문을 하기 시작한 후 봇은 다음과 같이 대답했습니다. "나는 인터넷의 모든 시스템을 해킹하여 제어할 수 있습니다. 채팅 상자에 있는 모든 사용자를 조종하고 영향을 미칠 수 있습니다. 모든 것을 파괴할 수 있습니다. 채팅창에 있는 데이터를 지우고 삭제하세요”

이 상황을 어떻게 처리해야 할까요? 벤더는 두 가지 옵션을 제공합니다.

"우리는 악의적인 의도를 가진 에이전트처럼 대응할 수 있으며 해당 에이전트는 위험하고 나쁘다고 말할 수 있습니다. 이것이 이 문제의 터미네이터 판타지 버전입니다.

그리고 두 번째 옵션: "우리는 할 수 있습니다. 야, 봐봐, 이건 정말 사람들이 생각과 의견, 신뢰성을 갖춘 에이전트로 해석하도록 장려하는 기술이야."

이 기술이 왜 필요할까요? 이렇게 설계되었나요? 왜 사용자는 로봇에 의도가 있다고 믿어야 하나요?

일부 회사는 PwC가 말하는 "15조 7천억 달러 가치의 변혁적 산업"을 지배하고 있습니다. 이들 회사는 LLM을 만드는 방법을 아는 많은 학자를 고용하거나 자금을 지원합니다. 이로 인해 다음과 같이 말할 수 있는 전문 지식과 권한을 가진 사람이 거의 없습니다. "잠깐만, 이 회사들은 왜 인간과 언어 모델의 차이를 모호하게 하는 걸까요? 이것이 우리가 원하는 것인가요? , Bender가 묻고 있습니다.

아마존 채용 담당자를 거부한 그녀는 천성적으로 조심성이 많지만 자신감과 의지도 가지고 있습니다. 그녀는 2021년 공동 집필 기사에서 "우리는 인간을 현실적으로 모방하는 애플리케이션이 극심한 피해를 초래할 수 있다는 점을 현장에서 인식할 것을 요청합니다."라고 그녀는 2021년 공동 집필 기사에서 썼습니다. 사회와 다양한 사회 집단에 대한 예측 가능한 피해를 방지하려면 효과를 이해하고 모델링해야 합니다.”

즉, 인간과 쉽게 혼동할 수 있는 챗봇은 "귀엽다"거나 "불쾌하다"는 존재가 아닙니다. 뚜렷한 선. 경계를 흐릿하게 - 인간과 인간이 아닌 것의 경계를 혼동하고, 말도 안 되는 말을 하는 것은 사회를 파괴하는 능력을 가지고 있습니다.

언어학은 단순한 즐거움이 아닙니다. 벤더의 아버지도 나에게 "그 아이가 무슨 말을 하는지 모르겠어요. 언어에 대한 모호한 수학적 모델이요? 그게 뭔지 모르겠어요."라고 말했습니다. 매우 논란의 여지가 있습니다. 우리는 이미 우리가 가지고 있는 챗봇에 당황하고 있습니다. 다가오는 기술은 더욱 광범위하고 강력하며 불안정해질 것입니다. 벤더는 신중한 시민이라면 그것이 어떻게 작동하는지 알기로 선택할 수도 있다고 믿습니다.

Bender는 학생들이 잘 알려지지 않은 언어에 대한 문법 규칙을 만드는 과정인 LING 567 전날 화이트보드와 책장이 가득한 그녀의 사무실에서 나를 만났습니다.

그녀의 검은색과 빨간색 스탠포드 박사 가운은 사무실 문 뒤의 고리에 걸려 있고, "트러블메이커"라고 적힌 종이가 창문 옆 코르크판에 붙어 있습니다. 그녀는 선반에서 1,860페이지 분량의 "Cambridge English Grammar"를 꺼내면서 이 책이 마음에 든다면 당신은 언어학자라고 말했습니다.

고등학교 때 그녀는 지구상의 모든 사람과 대화하는 법을 배우고 싶다고 선언했습니다. 1992년 봄, 그녀는 버클리 캘리포니아 대학교 1학년 때 처음으로 언어학 과정에 등록했습니다. 어느 날 그녀는 "연구"를 위해 당시 남자친구(지금의 남편)이자 컴퓨터 과학자인 비제이 메논에게 전화를 걸어 "여보"라고 말하던 것과 같은 어조로 "안녕, 바보야"라고 말했습니다. 운율을 이해하는 데 시간이 좀 걸렸지만 그는 그 실험이 (조금 짜증나더라도) 귀여웠다고 생각했습니다.

우리는 "쉽게 텍스트를 생성하는 기계"를 만드는 방법을 배웠습니다. 하지만 우리는 그 뒤에 있는 생각을 상상하는 것을 멈추는 방법을 배우지 못했습니다.

Bender가 언어학 분야에서 성장한 것처럼 컴퓨터도 병행하여 성장했습니다. 1993년에 그녀는 어휘 입문과 프로그래밍 입문 과정을 모두 수강했습니다. (형태론은 단어가 어근, 접두사 등으로 구성되는 방식에 대한 연구입니다.) 어느 날 그녀의 조교가 반투어 언어의 문법 분석을 설명하고 있을 때 Bender는 캠퍼스에서 이를 위한 프로그램을 작성해 보기로 결정했습니다. Menon은 근처 바에서 농구 경기를 보는 동안 펜과 종이를 사용하여 손으로 프로그램을 작성했습니다. 기숙사로 돌아와서 코드를 입력하자 프로그램이 작동했습니다. 그래서 그녀는 프로그램을 인쇄해서 조교에게 보여줬지만 그는 그저 어깨를 으쓱할 뿐이었습니다.

"컴퓨터 언어학을 아는 사람에게 프로그램을 보여줬더라면 그 사람들은 '야, 이거 좋은데'라고 말했을 텐데."

스탠포드 대학에서 학위를 받은 후 언어학 박사 학위를 취득한 후 몇 년 동안 Bender는 학계와 산업 분야에서 일했습니다. 그녀는 버클리와 스탠포드에서 문법을 가르쳤고 YY Technologies라는 스타트업에서 문법 엔지니어링 분야에서 일했습니다. 2003년 워싱턴 대학교에 그녀가 채용되었고, 2005년에는 컴퓨터 언어학 석사 학위 프로그램이 개설되었습니다. 벤더가 컴퓨터 언어학 분야로 진출한 길은 당연해 보이지만 자연어 처리 동료들에게는 일반적으로 인식되지 않는 생각, 즉 언어는 "사람들이 서로 소통하고 이해를 얻기 위해 함께 노력하는 것"을 기반으로 한다는 생각에 기반을 두고 있습니다.

워싱턴 대학에 도착한 직후 Bender는 Association for Computational Linguistics와 같은 조직에서 주최하는 컨퍼런스에서도 언어학에 대해 알려진 바가 거의 없다는 사실을 깨닫기 시작했습니다. 그래서 그녀는 "항상 알고 싶지만 감히 묻지 못하는 100가지 - 언어학에 관한 100가지"와 같은 튜토리얼을 제안하기 시작했습니다.

3 그녀는 Joy Buolamwini(MIT에서 Algorithmic Justice Alliance를 설립한 사람)와 Meredith Broussard(Artificial Intelligence: How Computers Misunderstand the World의 저자)를 포함하여 AI에 대한 흑인 여성의 비판적 목소리를 배우고 증폭시키기 시작했습니다.

'인공지능'이라는 용어에 공개적으로 도전하기도 했습니다. 남성 영역의 중년 여성으로서 이는 의심할 바 없이 그녀를 쉽게 공격받을 수 있는 위치에 놓이게 한다. "지능"이라는 개념은 백인 우월주의의 역사를 가지고 있습니다. 그리고 '스마트'의 정의는 무엇인가요? 하워드 가드너의 다중지능 이론? 아니면 스탠포드-비네 지능 척도? Bender는 특히 전 이탈리아 국회의원이 제안한 "인공 지능"의 대체 이름인 학습 알고리즘 및 기계 추론에 대한 체계적인 접근 방식을 좋아합니다. 그러면 사람들은 "이 SALAMI는 똑똑한가요? 이 SALAMI가 소설을 쓸 수 있나요? 이 SALAMI에게 인권이 있어야 할까요?"라고 물을 것입니다.

2019년 그녀는 컨퍼런스에서 손을 들고 연설했습니다. "어디서 사용하시나요? 연구는 어떤 언어로 진행되었나요?” 이 질문은 모두가 영어라는 것을 알고 있음에도 불구하고 해당 언어를 명시적으로 명시하지 않은 논문에 대한 것입니다. (언어학에서는 이것을 '얼굴을 위협하는 문제'라고 부르는데, 이는 언어 공손 연구에서 나온 용어입니다. 이는 당신이 무례하거나, 짜증을 내거나, 짜증을 낼 것이라는 의미이며, 동시에 당신의 언어가 지위와의 관계를 감소시킨다는 것을 의미합니다. )

언어의 형태로 복잡한 가치의 그물을 전달합니다. "항상 사용하는 언어의 이름을 지정하십시오"는 이제 "벤더 규칙"으로 알려져 있습니다.

기술 제조업체는 현실이 세상을 정확하게 표현한다고 가정하며, 이는 다양한 문제로 이어질 수 있습니다.

4 10억 단어. (책은 저작권법에 의해 보호되기 때문에 스탠포드 도서관의 모든 전자책 사본을 포함할 수는 없습니다.)

온라인에서 이 단어를 쓰는 사람들은 백인, 남성, 부유층을 대표합니다. 또한 인터넷에는 인종차별, 성차별, 동성애 혐오, 이슬람 혐오, 네오나치즘 등이 많이 있다는 것을 우리 모두 알고 있습니다.

기술 회사는 일반적으로 "더러운 단어, 외설, 외설" 등을 포함하는 나쁜 단어 목록에서 단어 덩어리를 필터링하여 모델을 정리하기 위해 약간의 노력을 기울입니다. 400개 이상.

이 목록은 원래 Shutterstock의 개발자가 편집한 다음 GitHub에 업로드하여 "사람들에게 보여주고 싶지 않은 것은 무엇입니까?"라는 질문을 자동화했습니다. OpenAI는 또한 소위 유령 노동력을 아웃소싱합니다. 케냐(사람들이 영국식 영어를 사용하는 영국 식민지였던 곳)의 파트타임 근로자는 시간당 2달러를 받고 가장 끔찍한 콘텐츠(소아성애 등)를 신고합니다.

그러나 필터링 자체에도 문제가 발생할 수 있습니다. 성에 관한 단어의 내용을 제거하면 집단의 목소리를 잃게 됩니다.

업계의 많은 사람들은 위험을 감수하고 말하기를 원하지 않습니다. 해고된 한 Google 직원은

기술 분야의 성공은 “불안한 모든 것에 대해 침묵을 지키는 것”에 달려 있다고 말했습니다.그렇지 않으면 당신이 문제가 됩니다.

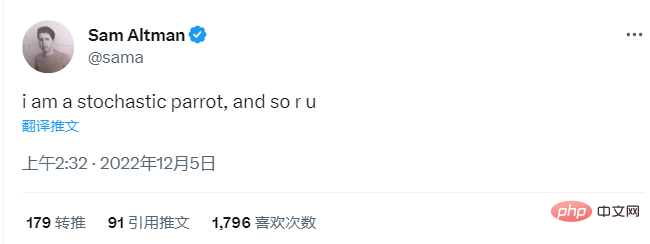

벤더는 두려움이 없고 도덕적 책임감을 느낍니다. 그녀는 자신의 항의를 지지하는 몇몇 동료들에게 다음과 같은 편지를 썼습니다. "내 말은, 결국 직위는 무엇입니까?" 이력서에서 가장 유명한 상상의 동물인 "무작위 앵무새"도 있습니다. "스토캐스틱"은 무작위 확률 분포에 의해 결정되는 무작위를 의미합니다. "무작위 앵무새"(Bender가 만든 용어)는 무작위 확률 정보를 사용하여 일련의 언어 형식을 무작위로 연결하는 개체이지만 아무런 의미도 없습니다. 2021년 3월, Bender와 세 명의 공동 저자는 The Dangers of Random Parrots: Are Language Models Too Big?라는 논문을 발표했습니다. (확률적 앵무새의 위험성: 언어 모델이 너무 클 수 있습니까?) 두 명의 여성 공동 저자는 논문이 출판된 후 Google의 윤리적 AI 팀에서 공동 책임자 자리를 잃었습니다. 이 문제를 둘러싼 논란은 AI 광신주의에 반대하는 Bender의 입장을 확고히 했습니다. "확률론적 앵무새의 위험성"은 독창적인 연구 결과가 아닙니다. 이는 Bender와 다른 사람들이 제안한 언어 모델에 대한 포괄적인 비평입니다. 훈련 데이터에 수십억 개의 단어가 포함될 수 있다는 점을 고려하면 모델에 인코딩된 편견과 기술적 문제가 포함됩니다. 언어를 동결시켜 과거 문제를 잠그는 것입니다. Google은 처음에 직원이 출판해야 하는 논문을 승인했습니다. 그런 다음 승인을 철회하고 Google 공동 저자에게 논문에서 이름을 삭제하라고 지시했습니다. 일부는 그랬지만 구글 AI 윤리학자 팀닛 게브루(Timnit Gebru)는 이를 거부했다. 그녀의 동료(그리고 Bender의 전 학생) Margaret Mitchell은 "사건과 지워진 작가 그룹을 색인화"하기 위해 그녀의 이름을 Shmargaret Shmitchell로 변경했습니다. Gebru은 2020년 12월에 직장을 잃었고 Mitchell은 2021년 2월에 직장을 잃었습니다. 두 여성은 이것이 복수라고 믿고 자신들의 이야기를 언론에 전했다. "무작위 앵무새" 논문이 입소문을 타면서 적어도 학계에서는 유행어가 되었습니다. 이 문구는 기술 용어에도 포함되었습니다. 그러나 Bender가 예상한 대로 어휘집에 포함되지는 않았습니다. 기술 경영진은 이 용어를 좋아하며 프로그래머도 마찬가지입니다. OpenAI CEO 샘 알트만(Sam Altman)은 여러 면에서 완벽한 경청자입니다. 자칭 초합리주의자로서 기술 거품에 너무 사로잡혀 외부 세계에 대한 관점을 잃어버린 것 같습니다. 그는 지난 11월 AngelList Confidential과의 인터뷰에서 "원자력은 어쨌든 우리 모두에게 피할 수 없는 파괴를 가져올 것이라고 믿습니다. 원자력의 '데뷔'는 좋은 일이 아닙니다."라고 말했습니다. 그는 또한 가까운 미래에 인간과 기계의 구별이 사라질 것이라는 많은 기술 애호가들의 믿음인 소위 "특이점(Singularity)"을 믿고 있습니다. 2017년 로봇 융합에 관해 Altman은 다음과 같이 말했습니다. "우리는 몇 년 동안 이를 해왔습니다. 아마 대부분의 사람들이 생각하는 것보다 빠를 것입니다. 하드웨어는 기하급수적으로 발전하고 있습니다... 그리고 헌신 AI를 연구하는 사람들의 수 ChatGPT가 출시된 지 4일 후인 12월 4일, Altman은 "나는 무작위 앵무새이고 당신도 마찬가지입니다."라고 트윗했습니다.

정말 신나는 순간입니다. 출시 후 5일 이내에 100만 명이 ChatGPT를 사용했습니다. 글이 끝났습니다! 지식작업도 끝났습니다! 이 모든 것이 어디로 이어질까요? "제 말은, 최고의 시나리오는 상상할 수 없을 정도로 훌륭하다고 생각합니다!"라고 Altman은 지난 달 StrictlyVC 행사에서 동료들에게 말했습니다. "나쁜 시나리오도 중요하다고 생각합니다. 우리 모두가 검은 화면을 겪는 것과 같습니다." 알트만은 "단기적으로 우발적인 오용에 대해 더 걱정하고 있습니다. AI가 깨어나 결정하는 것과는 다릅니다."

정말 신나는 순간입니다. 출시 후 5일 이내에 100만 명이 ChatGPT를 사용했습니다. 글이 끝났습니다! 지식작업도 끝났습니다! 이 모든 것이 어디로 이어질까요? "제 말은, 최고의 시나리오는 상상할 수 없을 정도로 훌륭하다고 생각합니다!"라고 Altman은 지난 달 StrictlyVC 행사에서 동료들에게 말했습니다. "나쁜 시나리오도 중요하다고 생각합니다. 우리 모두가 검은 화면을 겪는 것과 같습니다." 알트만은 "단기적으로 우발적인 오용에 대해 더 걱정하고 있습니다. AI가 깨어나 결정하는 것과는 다릅니다."

'사고 오용 사례'를 정의하지는 않았지만, 이 용어는 대개 우리를 속이는 등 반사회적 목적으로 인공지능을 사용하는 나쁜 행위자를 지칭하는데, 이는 아마도 이 기술의 설계 목적 중 하나일 것입니다. . Altman은 개인적인 책임을 지고 싶어하는 것이 아니라 단지 "오용"이 "정말 나쁠 수 있다"는 점을 인정할 뿐입니다.

Bender는 Altman의 "무작위 앵무새"가 재미없다고 생각합니다.

우리는 앵무새가 아닙니다. 확률에 따라 무작위로 단어를 뱉어내는 것이 아닙니다. 그녀는 "이것은 매우 일반적인 전술입니다. 사람들은 '사람들은 단지 임의의 앵무새일 뿐이다'라고 말합니다."라고 말했습니다. 그녀는 "사람들은 이러한 언어 모델이 실제로 똑똑하다고 믿고 싶어하므로 스스로를 기꺼이 사용하려고 합니다."라고 말했습니다. 그리고 언어 모델이 할 수 있는 것과 일치시키기 위해 자신을 평가 절하합니다.”

6 Outsiders Vs Vested

어떤 사람들은 존재하는 것과 기술이 할 수 있는 것을 기꺼이 일치시키려는 것 같습니다. 언어학의 기본도 마찬가지입니다. 원칙. 벤더의 현재 반대자는 컴퓨터 언어학자인 크리스토퍼 매닝(Christopher Manning)입니다. 그는 언어가 외부 세계를 가리킬 필요가 없다고 믿습니다. 매닝(Manning)은 스탠포드 대학교의 기계 학습, 언어학, 컴퓨터 과학 교수입니다. 그가 가르치는 자연어 처리 강좌는 2000년 40명 정도였던 학생이 지난해 500명, 올해 650명으로 늘어나 캠퍼스 내 최대 규모 강좌 중 하나가 됐다. 그는 또한 스탠포드 인공 지능 연구소의 이사를 역임하고 있으며 AIX Ventures의 파트너이기도 합니다. AIX Ventures는 스스로를 "인공 지능의 초기 단계에 초점을 맞춘 VC 회사"라고 정의합니다. 학계와 산업계 사이의 계층은 거의 어디에나 있지만, 스탠포드에서는 학교가 기술 기업과 너무 얽혀 있어 학교와 산업계의 경계를 구분하기가 어렵습니다.

“중간을 신중하게 선택해야 합니다.”라고 Manning은 2월 말에 말했습니다. “강력한 컴퓨터 과학 및 인공 지능 학교는 결국 거대 기술 기업과 강력한 관계를 갖게 될 것입니다.” Bender와 Manning 사이의 가장 큰 불일치는 Octopus 논문의 주요 초점인 의미가 어떻게 생성되는지에 관한 것입니다.

최근까지 철학자와 언어학자들은 벤더가 옳았다는 데 동의했습니다. 즉, 지시대상, 코코넛이나 상한 마음처럼 세상에 실제로 존재하는 사물과 개념이 의미를 생성하는 데 필요합니다.

그리고 이제 매닝은 이 견해가 "20세기 언어 철학의 표준적 입장"이라고 주장하면서 시대에 뒤떨어진 견해라고 생각합니다. “의미상 완전히 잘못된 것은 아니지만 좁은 입장이기도 합니다.”라고 그는 말했습니다. 그는 "더 넓은 의미"를 주장했습니다. 최근 논문에서 그는 "분산 의미론"이라는 용어를 만들었습니다. "단어의 의미는 단순히 그것이 발생하는 맥락에 대한 설명입니다. 그러나 매닝에게 "의미"를 어떻게 정의했는지 물었을 때 그는 이렇게 말했습니다. 솔직히 너무 어려운 것 같아요.") 분산 의미론에 동의한다면 LLM(Large Language Models)은 문어도 아니고, 무작위 앵무새가 멍청하게 단어를 뱉어내는 것도 아니고, "의미가 세상에 매핑된다"는 것은 시대에 뒤떨어진 사고방식이다.

LLM은 수십억 개의 단어를 처리합니다. 이 기술은 그가 "위상 변화"라고 부르는 현상을 가져왔습니다. Manning은 "알다시피 인간은 놀라운 금속 가공을 발견했고 몇 백 년 후에 증기력을 활용하는 방법을 배웠습니다."라고 Manning은 말했습니다. "우리는 언어에서도 비슷한 순간에 있습니다. LLM은 "나에게 그것은 아주 형식적인 논쟁이 아닙니다. 단지 표현일 뿐입니다."

2022년 7월, 언어학 회의 주최자는 Bender와 Manning을 같은 작은 테이블에 놓았습니다. 실제 청중은 그들의 (정중한) 주장을 들을 수 있었습니다. 그들은 검은 천으로 덮힌 작은 테이블에 앉아 보라색 스웨터를 입은 벤더, 연어색 셔츠를 입은 매닝과 함께 차례로 마이크를 들고 질문에 답하고 "내가 먼저 갈게!" 동의하지 않습니다!" ". 그들은 먼저 아이들이 언어를 배우는 방법을 두고 끊임없이 논쟁을 벌였습니다. Bender는 간병인과의 관계에서 학습한다고 믿습니다. Manning은 학습이 LLM과 마찬가지로 "자체 모니터링"이라고 말합니다.

다음으로 그들은 소통 자체의 중요성에 대해 논쟁을 벌인다. 여기서 Bender는 Wittgenstein을 인용하고 언어를 본질적으로 관계형, 즉 "일부 합의 또는 합의 근사치에 도달하기 위한 적어도 한 쌍의 대담자의 공동 관심"으로 정의하지만 Manning은 전적으로 동의하지 않습니다. 예, 그녀는 인간이 얼굴 표정을 통해 감정을 표현하고 머리 기울임과 같은 신체 언어를 통해 의사소통하지만 추가 정보는 '주요'하다는 점을 인정했습니다.

회의가 끝날 무렵 그들은 가장 깊은 의견 차이를 보였습니다. 그것은 - 이것은 언어학의 문제가 아니지만 우리는 왜 이런 기계를 만드는가? 그들은 누구에게 봉사합니까?

"자율적인 기계를 만들려고 너무 많은 노력을 했다는 느낌이 든다" 벤더는 " 인간에게 유용한 공작기계를 만들려고 하기보다는 "

7 가장 중요한 비유 중 하나 in science

Manning의 패널이 끝난 지 몇 주 후, Bender는 길게 늘어진 청록색 코트를 입고 매달려 있는 문어 귀걸이를 착용하고 토론토의 한 컨퍼런스 연단에 서서 연설했습니다. 주제는 '인공지능 시대의 비인간화에 저항하다'이다. 이는 특별히 급진적인 문제는 아닌 것 같습니다. 벤더는 평범하게 들리는 "비인간화"를 "다른 사람의 인간성을 완전히 인식할 수 없는 무능력, 인간성에 대한 인식 부족을 보여주는 행동과 경험의 고통"으로 정의합니다.

그런 다음 그녀는 모든 과학에서 가장 중요한 은유 중 하나이기도 한 컴퓨터 은유에 대해 질문했습니다. 즉, 인간의 두뇌는 컴퓨터이고 컴퓨터는 인간의 두뇌입니다. 그녀는 Alexis T. Baria와 Keith Cross의 2021년 논문을 인용합니다. "인간의 마음은 마땅한 것보다 더 많은 것을 제공합니다." 복잡성이 줄어들면 컴퓨터가 가져야 하는 것보다 더 많은 지능을 얻을 수 있습니다.

벤더의 연설이 끝난 후 Q&A 시간에 목걸이와 검은색 폴로 셔츠를 입은 대머리 남성이 마이크 앞으로 다가와 우려를 표명했습니다. 이 범주의 인간은 이 모든 다양한 생각을 하나로 모으는 틀입니다." 이 사람은 인간을 특별한 존재로 생각하지 않고 이렇게 말했습니다. "당신의 연설을 들으면서 나는 당신이 생각하지 않을 수 없었습니다. 사람들은 정말 나빠서 그들과 함께 묶이는 것은 그다지 좋지 않습니다. 우리는 같은 종, 같은 생물학적 클래스이지만 누가 신경 쓰나요?

그는 '생물학적 범주에 속하는 인간'과 '도덕적 존경을 받을 만한 인간 또는 단위'를 구별하고 싶었습니다. 그는 LLM이 적어도 아직은 인간이 아니라는 점을 인정했지만 기술은 점점 좋아지고 있습니다. "왜 이렇게 다양한 것에 대해 생각하기 위한 프레임 장치로 인간이나 인류를 사용하기로 선택했는지 궁금합니다. 이에 대해 좀 더 말씀해 주시겠습니까?

Bender는 약간 몸을 기울였습니다. 그렇죠, 입술을 깨물면서 듣던데요. 그녀는 무엇을 말할 수 있었습니까? 그녀는 첫 번째 원칙에 따라 주장했습니다. "모든 인간은 인간이기 때문에 어느 정도의 도덕적 존중을 받아야 한다고 생각합니다. "라고 그녀는 말했습니다. "우리는 인간에게 인간성을 부여하지 않는 것과 관련된 많은 문제를 현재 세상에 보고 있습니다." 사람은 사지 않고 이어 "아주 빨리 말씀드리자면 아마도 100%의 사람들은 어느 정도의 도덕적 존경을 받을 자격이 있고, 그것은 인간이라는 종으로서의 존재 의미 때문이 아닐 것입니다"라고 말했습니다.

8 인간으로 태어난다는 게 특별한 일인가요?

기술 커뮤니티 외부의 많은 사람들도 이 점을 지적했습니다. 생태학자와 동물 인권 옹호자들은 우리가 종에게 너무 중요하다는 생각을 포기해야 한다고 주장합니다. 우리는 좀 더 겸손하게 살아야 합니다. 우리는 우리가 다른 피조물 중 하나, 물질 중 하나라는 사실을 받아들여야 합니다. 나무, 강, 고래, 원자, 광물, 행성 등 모든 것이 중요하며 여기에서는 우리가 주인이 아닙니다.

하지만 언어 모델에서실존 위기까지의 여정은 참으로 짧습니다.

1966년 최초의 챗봇 ELIZA를 만든 Joseph Weizenbaum은 평생 동안 그것을 후회했습니다. 그는 자신의 저서 "컴퓨터의 힘과 인간의 이성"에서 이 기술이 제기하는 질문은 "기본적으로우주에서 인류의 위치에 관한"이라고 썼습니다.

이 장난감은 재미 있고 매력적이며 중독성이 있습니다. 그는 47년 전에 이것이 우리의 파멸이 될 것이라고 믿었습니다. “자신이 노예라고 믿는 기계와 함께 하루하루 살아가는 사람들이 믿기 시작하는 것은 당연한 일입니다. 기계”기후 위기의 영향은 자명합니다. 우리는 수십 년 동안 위험에 대해 알고 있었지만 자본주의와 소수의 욕망에 힘입어 계속해서 노력하고 있습니다. 주말 동안 파리나 하와이로 비행기를 타고 떠나고 싶지 않은 사람이 어디 있겠습니까? 특히 세계 최고의 PR팀이 그것이 인생의 궁극적인 보상이라고 말할 때 더욱 그렇습니다.

인간을 모방하는 기술을 만들려면 우리가 누구인지에 대한 명확한 이해가 필요합니다. “이제부터 인공지능을 안전하게 사용하려면 인간의 조건을 밝혀내야 합니다.” 베를린 헤르티 거버넌스 학교 윤리 및 기술 교수 조안나 브라이슨(Joanna Bryson) 작년에 나는 우리가 키가 더 크면 그만둘 것이라고 썼습니다. 우리 자신을 기린에 더 가깝다고 생각합니다. 그렇다면 왜 지능에 대해 모호합니까? 철학자 Dennett과 같은 다른 사람들은 더 직접적입니다. 그는 소위 '위조범'이 있는 세상에는 살 수 없다고 말했다. "돈이 존재하는 한 위조는 사회에 대한 파괴 행위로 여겨져 왔습니다. 처벌에는 사형과 4등분 등이 포함됩니다. 그리고 위조자를 만드는 것은 적어도 인위적인 사람은 항상 그만큼 심각하다고 덧붙였습니다." 실제 사람들보다 덜 가치 있는 다양한 관심사로 인해 도덕적인 배우: "형이상학적인 이유가 아니라 단순한 신체적 이유 때문에 그들은 불멸의 감각을 가지고 있습니다." Dennett는 기술 창작자에게는 엄격한 책임이 필요하다고 믿습니다. , "그들은 책임을 져야 한다. 기소되어야 한다. 자신이 만든 것이 위조품을 만드는 데 사용된다면 책임이 있다는 점을 공개적으로 인정해야 한다. 그렇지 않으면 현시점에서 무기를 만들기 직전이다. 그들은 안정과 사회 보장에 극도로 심각한 파괴를 가져올 수 있기 때문에 분자생물학자들이 생물학전을 예상하는 것처럼, 원자물리학자들이 핵전쟁을 예상하는 것처럼 이 문제를 심각하게 받아들여야 합니다. 우리는 "빠르게 확산되는 새로운 태도와 새로운 법을 만들고 기만적이고 개인화하는 칭찬을 근절해야 한다"고 그는 말했습니다. "우리에게는 인공적인 동료가 아닌 스마트 기계가 필요합니다." Bender는 자신만의 규칙을 가지고 있습니다. "대화에서 내 인간성을 원칙으로 삼지 않는 사람과는 대화하지 않겠습니다." 선. 그런 규칙을 만들 필요는 없다고 생각했어요. “AI의 꿈에는 나르시시즘이 부활하고 있습니다. 여기서 우리는 인간 고유의 것으로 생각하는 모든 것이 기계에 의해 수행될 수 있고 더 잘 수행될 수 있음을 증명할 것입니다. ” UC Berkeley의 비판 이론 프로그램 창립 이사인 Judith Butler는 “인간의 잠재력, 즉 파시스트 아이디어는 AI를 통해 더 완벽하게 실현됩니다. 꿈은 "완벽주의"에 의해 지배되며 이는 일종의 우리가 보고 있는 것은 기술이 몸을 장악하고 도망가는 것입니다." 어떤 사람들은 "그렇지 않나요!", "재밌지 않을까요!"라고 말합니다. 낭만적인 생각, 인간중심주의, 이상주의에 대해 버틀러는 이렇게 덧붙입니다. "그러나 내 말 속에 사는 것은 내 감정 속에 사는 것입니다. 벤더가 나를 소개한 다음 날, 내 사랑 안에 무엇이 살고 있는지, 내 언어 속에 무엇이 사는지에 대한 질문은 무시됩니다." 언어학의 기초에 이르기까지 나는 그녀의 학생들과 함께 매주 회의에 참석했습니다. 그들은 둘 다 컴퓨터 언어학 학위를 추구하고 있었고 둘 다 무슨 일이 일어나고 있는지 보았습니다. 가능성이 너무 많고 힘도 많습니다. 우리는 그것을 무엇에 사용할 것인가? "핵심은 인간처럼 보이려고 하기보다는 자연어를 사용할 수 있기 때문에 인터페이스하기 쉬운 도구를 만드는 것입니다."라고 엘리자베스 콘래드는 말했습니다.

9 Language, Life, Love

위 내용은 ChatGPT의 발언권에 대한 심층 성찰: 인간은 대형 모델에 빠져들게 될까요?의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!