인공 지능의 기초: 기계 학습의 공통 알고리즘 소개

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB앞으로

- 2023-04-09 12:31:032260검색

오늘은 머신러닝 알고리즘에 대해 이야기해보겠습니다. 함께 살펴보시죠!

기계 학습 알고리즘에는 주로 지도 학습, 비지도 학습, 준지도 학습, 전이 학습, 강화 학습이 포함됩니다.

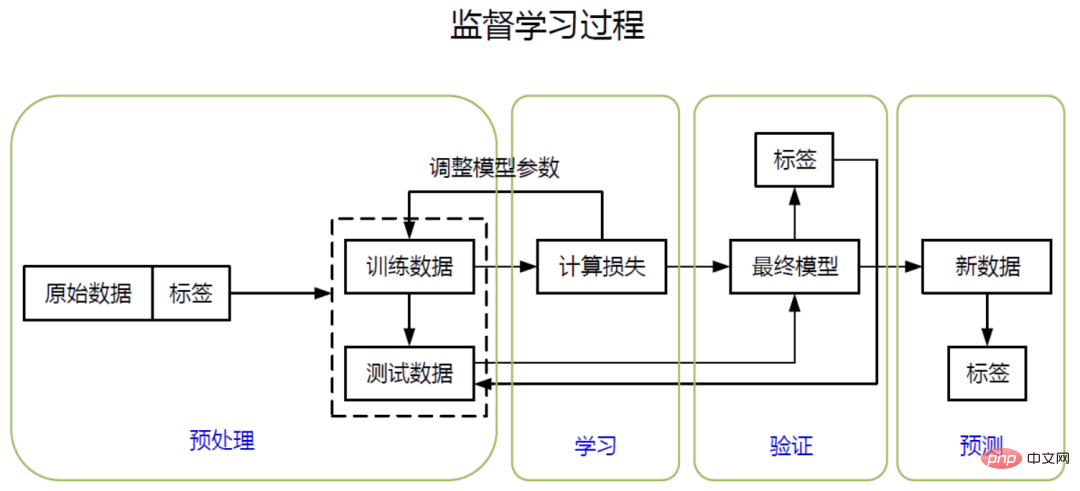

1. 지도 학습

지도 학습은 기계 학습에서 매우 일반적인 유형의 기계 학습으로, 입력과 출력이 알려진 경우 모델을 훈련하고 입력을 출력에 매핑합니다.

특징: 학습 목표(예: 실제 값, 주석 등)가 제공됩니다.

지도 학습은 목표 결과가 이산형인지 연속형인지에 따라 분류와 회귀로 나눌 수 있습니다.

1.1 분류

이런 유형의 예측 목표값은 이산적입니다. 예를 들어 비가 올지 여부를 예측하면 최종 결과는 비가 오거나 비가 내리지 않습니다.

목적: 과거 결과를 기반으로 새로운 샘플의 분류 결과를 예측하는 것입니다. 두 가지 분류 결과에 대한 작업을 이진 작업이라고 하며, 둘 이상의 분류 결과를 다중 분류 작업이라고 합니다.

공통 알고리즘: 의사결정 트리, 랜덤 포레스트, K-최근접 이웃 알고리즘, 로지스틱 회귀, 지원 벡터 머신, 인공 신경망.

1.2 회귀

이 유형의 예측 목표값은 연속형입니다. 대표적인 예가 특정 부동산의 가격 추세를 예측하는 것입니다.

알고리즘: 선형 회귀, AdaBoosting 등

2. 비지도 학습

비지도 학습의 특징은 데이터에 라벨을 붙일 필요가 없으며, 모델을 기반으로 지속적인 자기 학습과 통합을 거쳐 최종적으로 자기 요약을 통해 학습한다는 것입니다. 학습 모델에는 주로 클러스터링과 차원 축소가 포함됩니다.

2.1 클러스터링

은 주로 물리적 또는 추상적인 객체의 집합을 유사한 객체로부터 여러 범주로 구성하는 과정을 말하며, 이는 유사한 원리에 따라 그룹화하는 것으로 이해될 수 있습니다.

알고리즘: 일반적인 알고리즘에는 K-평균 알고리즘, BIRCH 알고리즘 및 DBSCAN 알고리즘이 포함됩니다.

2.2 차원 축소

고차원 데이터는 시스템 리소스와 알고리즘 성능에 크게 의존합니다. 차원 축소는 중요한 정보의 대부분을 유지하면서 고차원 데이터에서 중요하지 않은 정보를 처리하는 것입니다. 간단히 말하면, 복잡한 문제를 최대한 단순하게 만들면 처리하기가 훨씬 덜 어려워집니다.

장점: 공간을 절약하고, 알고리즘에 소요되는 시간을 절약하며, 시스템 리소스 소비를 줄입니다.

알고리즘: 주성분 분석 알고리즘(PCA)

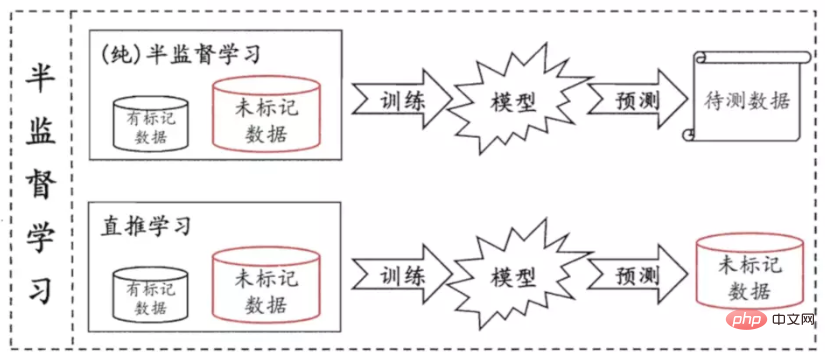

3. 준지도 학습

지도 학습과 비지도 학습을 결합한 학습 방법입니다. 준지도 학습은 패턴 인식을 수행하기 위해 레이블이 없는 대량의 데이터와 레이블이 있는 데이터를 사용합니다.

반지도 학습은 소수의 레이블이 있는 샘플과 다수의 레이블이 없는 샘플에 적합하며 더 높은 정확도의 예측을 달성할 수 있습니다.

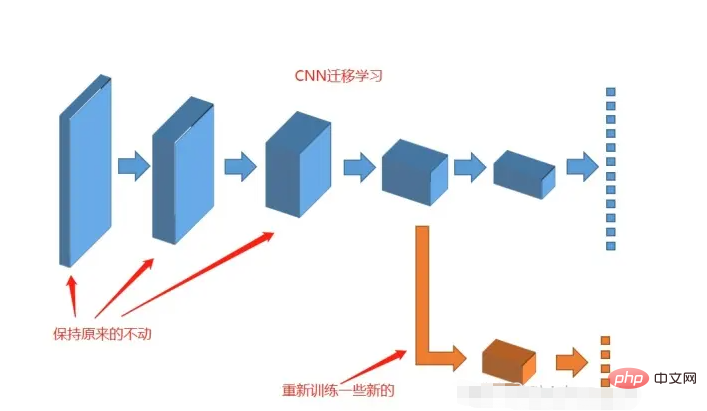

4. 전이 학습

전이 학습은 사전 훈련된 모델을 다른 학습 작업에 재사용하는 학습 방법을 의미합니다.

원천 영역: 기존 지식, 대상 영역: 학습할 새로운 지식.

5. 강화 학습(RL)

RL은 강화 학습, 평가 학습, 강화 학습이라고도 하며 기계 학습의 패러다임이자 방법론 중 하나입니다.

스마트 기기가 인간처럼 지속적으로 학습하고 시도할 수 있도록 하여 다양한 환경에서 가장 이상적인 솔루션을 만들고, 지속적인 의사결정 프로세스를 강화하며, 지속적인 시도를 통해 어떤 것이 적합한지 발견하는 것이 강화학습의 과제입니다. 가장 좋은 방법은.

사례: 알파고는 강화학습 알고리즘을 사용해 세계챔피언 이세돌을 물리쳤고, 구글 유튜브 영상 추천 알고리즘 등을 활용했다.

위 내용은 인공 지능의 기초: 기계 학습의 공통 알고리즘 소개의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!