마커스: 새로운 Bing은 ChatGPT보다 더 강력합니다. 이것은 Microsoft가 의도한 것인가요, 아니면 실수인가요?

- 王林앞으로

- 2023-04-08 15:51:031292검색

뉴빙이 대규모 내부 테스트를 시작한 이후 네티즌들은 절제된 ChatGPT에 비해 불필요한 사랑을 알리고 이혼을 권유하고, 사용자를 협박하고, 사람들을 가르치는 등 뉴빙의 답변이 정말 너무 과격하다는 사실을 발견했습니다. 범죄를 저지르는 방법 등

Microsoft는 언어 모델의 일부인 "횡설수설" 기능을 유지했다고 할 수 있습니다. 따라서 ChatGPT가 아니라 New Bing을 사용하고 있음을 알 수 있습니다.

제대로 하지 못한 것이 Microsoft의 RLHF인가요, 아니면 ChatGPT를 잃게 만든 훌륭한 인터넷 코퍼스인가요?

최근 유명한 AI 학자이자 Robust.AI의 설립자 겸 CEO이자 뉴욕대학교 명예교수인 Gary Marcus는 또 다른 블로그를 게재하여 Bing이 미쳐버릴 여러 가지 가능성을 분석하고 다음과 같이 말했습니다. AI 산업의 발전에 매우 심각한 영향을 미칠 수 있습니다.

Bing은 왜 이렇게 야성적인가요?

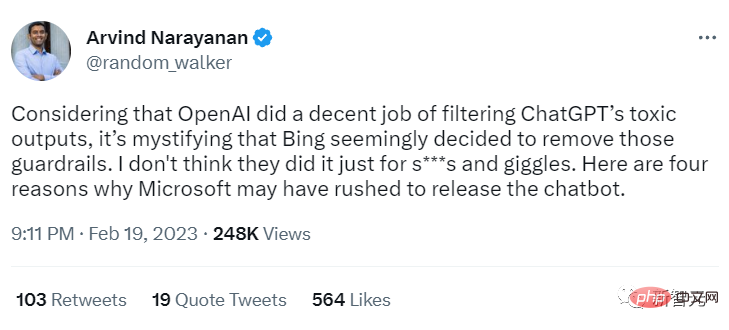

프린스턴 대학교 Arvind Narayanan 교수는 Bing이 그토록 "야생적인" 이유에 대해 네 가지 가능성을 제안했습니다.

트위트에서 Narayanan 교수는 OpenAI가 ChatGPT의 유해한 출력을 잘 필터링한다고 믿고 있지만 Bing이 이러한 보호 기능을 제거한 것으로 보이며 이는 매우 혼란스럽습니다.

그는 Microsoft가 단순히 재미를 위해 이 일을 하는 것이 아니라 새로운 Bing을 그렇게 서둘러 출시하는 데는 다른 이유가 있을 것이라고 믿습니다.

가능성 1: New Bing은 GPT-4입니다

New Bing이 보여주는 동작은 ChatGPT와는 상당히 다릅니다. 동일한 기본 모델을 기반으로 합니다. 아마도 LLM은 최근에야 교육을 마쳤을 것입니다(예: GPT-4?). 이 경우 Microsoft는 릴리스를 연기하고 추가 RLHF 교육을 받는 대신 새 모델을 신속하게 출시하기로 (현명하지 않게) 선택했을 수 있습니다.

Marcus는 이전 기사 "ChatGPT의 어두운 심장"에서도 대규모 언어 모델에 불편한 콘텐츠가 많이 숨어 있으며 아마도 Microsoft가 유해한 콘텐츠를 필터링하기 위한 어떠한 조치도 취하지 않았다고 말했습니다.

블로그 링크: https://garymarcus.substack.com/p/inside-the-heart-of-chatgpts-darkness

가능성 2: 너무 많은 오탐지

Microsoft가 실제로 Bing용 필터를 구축했을 수도 있지만 실제로 사용하면 너무 많은 오탐지 샘플이 예측됩니다. ChatGPT의 경우 이 문제는 중요하지 않지만 검색 시나리오에서는 사용자 경험에 심각한 영향을 미칩니다.

필터는 실제 검색 엔진에서 사용하기에는 너무 귀찮습니다.

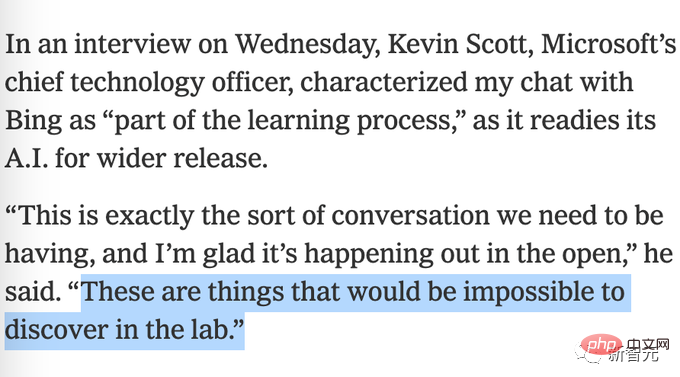

가능성 3: 사용자 피드백을 얻기 위해

Bing이 무엇이 잘못되었는지에 대한 더 많은 사용자 피드백을 얻기 위해 의도적으로 필터 제한을 해제했을 가능성이 있습니다. Microsoft는 앞서 실험실에서 테스트를 완료하는 것이 불가능할 것이라는 기괴한 주장을 했습니다.

가능성 4: Microsoft도 이를 기대하지 않았습니다

Microsoft는 프롬프트 프로젝트 기반 필터로 충분하다고 생각했을 가능성이 있지만 실제로는 그렇지 않았습니다. 기대하세요 New Bing의 잘못된 방식이 오늘날의 위치에 이르렀습니다.

Marcus는 기본적으로 Narayanan 교수의 견해에 동의하지만 Microsoft가 보호 조치를 제거하지 않았을 수도 있고 "단순히 비효율적"일 수도 있으며 이는 다섯 번째 가능성이라고도 생각합니다.

즉, 아마도 Microsoft는 이미 훈련된 기존 RLHF 모델을 GPT 3.6 위에 추가하려고 시도했지만 작동하지 않았을 것입니다.

강화 학습은 까다롭기로 악명이 높습니다. 환경을 조금만 바꾸면 쓸모가 없을 수도 있습니다.

DeepMind의 유명한 DQN 강화 학습은 Atari 게임에서 기록을 세웠고, Breakout 게임에서 패들을 몇 픽셀 위로 움직이는 등 몇 가지 작은 변경 사항을 추가했을 뿐이고, 모델이 붕괴될 때마다 아마도 큰 언어 모델을 업데이트하려면 강화 학습 모듈을 완전히 재교육해야 합니다.

이것은 매우 나쁜 소식입니다. 인적 및 경제적 비용(더 많은 저임금 사람들이 끔찍한 일을 하고 있음을 의미)뿐만 아니라 신뢰성 측면에서도 대규모 언어의 새로운 반복이 없음을 의미합니다. 모델은 안전해요.

이 상황은 두 가지 주요 이유로 특히 무섭습니다.

1. 대기업은 언제든지 경고 없이 새로운 업데이트를 출시할 수 있습니다.

2. 대중을 대상으로 한 실증적 테스트가 얼마나 잘 작동할지 미리 알지 못한 채 대중을 대상으로 계속해서 테스트하는 것입니다.

의료 분야에서 신약이 출시되는 것과 유사하게 대중은 신약이 출시되기 전에 실험실에서 완전히 테스트되어야 하며 특히 수십억 명의 사람들이 사용할 수 있는 경우 대규모 언어 모델 출시로 전환합니다. 심각한 위험(사용자의 정신 건강 및 결혼 상태를 방해하는 등)이 있을 수 있으므로 공개적으로 직접 테스트하도록 해서는 안 됩니다.

정책 측면에서 대중은 권리가 있습니다(또는 엄밀히 말하면 주장해야 합니다). ) 모델에 어떤 문제가 있는지 확인합니다.

예를 들어 Bing이 문제를 공개한 후 유사한 사고가 다시 발생하지 않도록 정책을 수립할 수 있습니다. 현재 인공지능은 기본적으로 본격적인 개발 단계에 있으며 누구나 챗봇을 시작할 수 있습니다.

의회는 무슨 일이 일어나고 있는지 파악하고 특히 감정적으로나 육체적으로 쉽게 해를 입힐 수 있는 부분에 대해 몇 가지 제한을 설정해야 합니다.

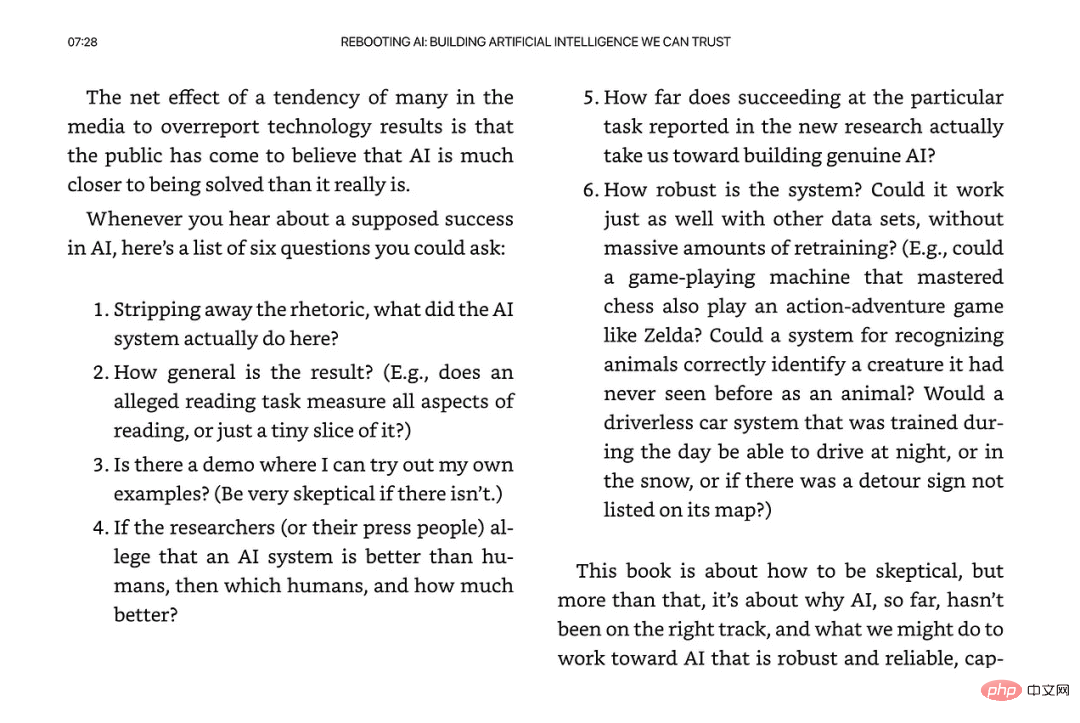

저널리즘 업계에서는 언론도 매우 실망스럽습니다.

Kevin Roose는 초기 보고서에서 Bing에 대해 "경외감을 느꼈다"고 밝혔는데, 이는 특히 Marcus를 화나게 했습니다. 이는 The New York Times에서 분명히 드러났습니다. 근본적인 문제를 더 깊이 파고들지 않고 너무 일찍 소문을 퍼뜨리는 것은 좋지 않습니다. .

한 가지 덧붙이자면, 벌써 2023년인데, 마이크로소프트의 보호 조치로는 충분할까요? 철저히 조사됐나요?

새로운 시스템에 대해 “경외감” 외에 다른 감정이 없다고 말하지 마세요.

마지막으로, 나라야난 교수는 우리가 인공지능과 시민사회에 있어 중요한 순간에 와 있다고 믿습니다. 조치를 취하지 않으면 지난 5년간의 "책임 있는 AI 출시"에 대한 실질적인 노력이 물거품이 될 것입니다.

위 내용은 마커스: 새로운 Bing은 ChatGPT보다 더 강력합니다. 이것은 Microsoft가 의도한 것인가요, 아니면 실수인가요?의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!