LATS : 추천 시스템을위한 Llamaindex가있는 AI 에이전트

- Joseph Gordon-Levitt원래의

- 2025-03-08 10:23:11499검색

(이 기사는 데이터 과학 블로그의 일부입니다.)

목차 :

- 반응 에이전트가

- 를 설명했습니다

-

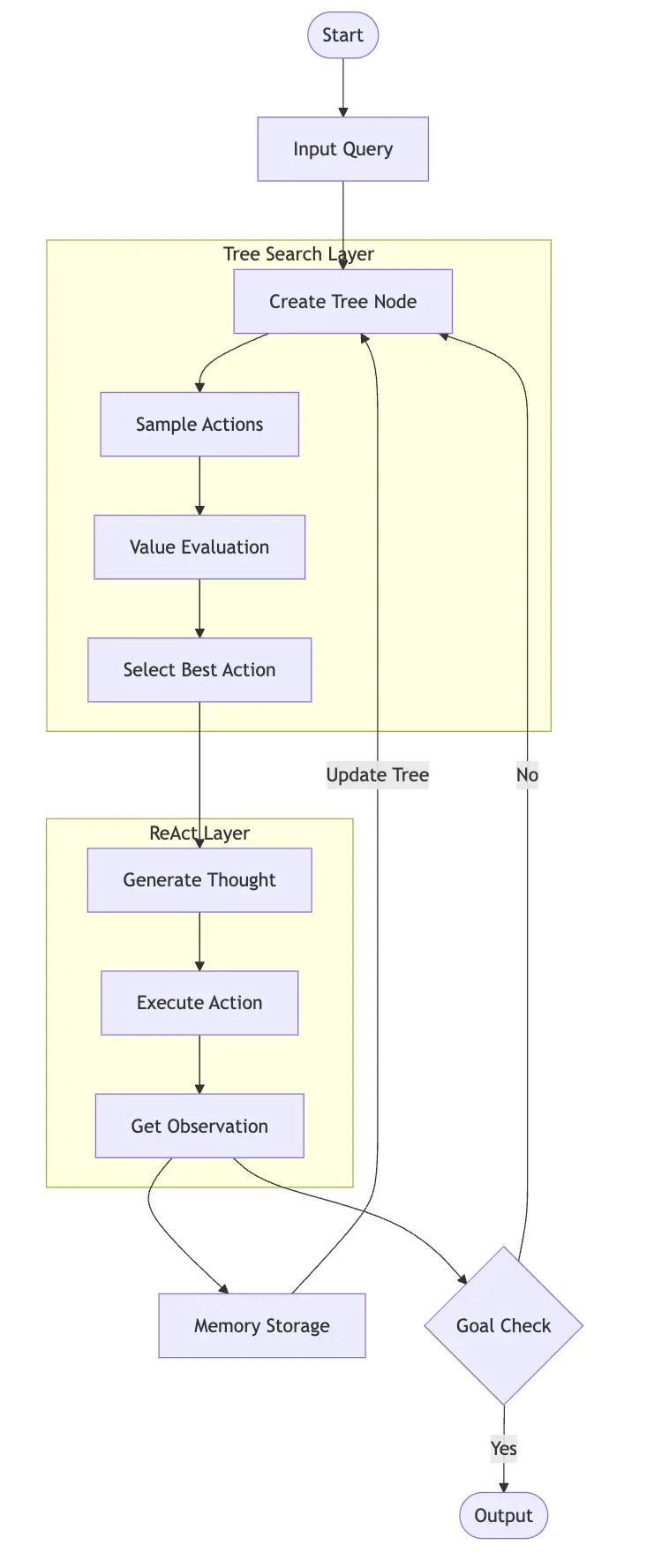

React (추론 연기)는 언어 모델이주기적인 사고, 행동 및 관찰 과정을 통해 작업을 해결할 수 있도록하는 프레임 워크입니다. 조수 생각이 큰 소리로 생각하고, 행동을 취하고, 피드백에서 배우는 것을 상상해보십시오. 사이클은 다음과 같습니다. - 생각 : 현재 상황 분석 행동 :

- 분석을 기반으로 행동 과정 선택.

환경에서 피드백을 수집합니다 반복 : 피드백을 사용하여 후속 생각을 알리십시오 이 구조화 된 접근 방식을 사용하면 언어 모델이 복잡한 문제를 해결하고, 정보에 입각 한 결정을 내리고, 결과에 따라 전략을 조정할 수 있습니다. 예를 들어, 다단계 수학적 문제에서 모델은 관련 개념을 식별하고, 공식을 적용하고, 결과의 논리를 평가하며, 그에 따라 접근 방식을 조정할 수 있습니다. 이것은 인간의 문제 해결을 반영하여보다 신뢰할 수있는 결과를 초래합니다

(이전에 보장 : llamaindex 및 gemini를 사용한 React Agent의 구현) 언어 에이전트 트리 검색 에이전트 이해

비용 고려 사항 : LATS를 고용 할 때

- 대량의 반복적 인 작업이 관련되어 있습니다 (예 : 콘텐츠 중재)

llamaindex 및 lats 가있는 추천 시스템 구축

LATS 및 LLAMAINDEX를 사용하여 추천 시스템을 구축하겠습니다

1 단계 : 환경 설정

llamaindex 및 lats 가있는 추천 시스템 구축

LATS 및 LLAMAINDEX를 사용하여 추천 시스템을 구축하겠습니다

1 단계 : 환경 설정

2 단계 : 구성 및 API 설정

Sambanova LLM API 키를 설정하십시오 () :

!pip install llama-index-agent-lats llama-index-core llama-index-readers-file duckduckgo-search llama-index-llms-sambanovasystems

import nest_asyncio; nest_asyncio.apply()

3 단계 : 도구 검색 정의 (Duckduckgo)

4 단계 : Llamaindex 에이전트 러너 - Lats

<your-api-key></your-api-key> 5 단계 : 실행 에이전트

import os os.environ["SAMBANOVA_API_KEY"] = "<your-api-key>" from llama_index.core import Settings from llama_index.llms.sambanovasystems import SambaNovaCloud llm = SambaNovaCloud(model="Meta-Llama-3.1-70B-Instruct", context_window=100000, max_tokens=1024, temperature=0.7, top_k=1, top_p=0.01) Settings.llm = llm</your-api-key>6 단계 : 오류 처리

( 사용 예) -이 섹션에서는 에이전트가 "아직도 생각하고있다"고 반환하는 케이스를 처리하는 방법을 제공합니다. 코드는 원래 입력에 제공됩니다

결론

from duckduckgo_search import DDGS

from llama_index.core.tools import FunctionTool

def search(query:str) -> str:

"""Searches DuckDuckGo for the given query."""

req = DDGS()

response = req.text(query,max_results=4)

context = ""

for result in response:

context += result['body']

return context

search_tool = FunctionTool.from_defaults(fn=search)

FAQ 섹션은 원래 입력에 제공됩니다.

위 내용은 LATS : 추천 시스템을위한 Llamaindex가있는 AI 에이전트의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!