를 사용하는 것을 설명합니다.

tiktoken tiktoken

AI의 자연 언어를 번역하는 초기 단계 인

가역성 :  원본 텍스트는 토큰에서 완벽하게 재구성 할 수 있습니다.

다목적 성 :

원본 텍스트는 토큰에서 완벽하게 재구성 할 수 있습니다.

다목적 성 :

토큰 화 된 버전은 일반적으로 원본보다 짧습니다. 각 토큰은 약 4 바이트를 나타냅니다 서브 워드 인식 : 공통 단어 부분 (예 : "ing")을 식별하고 활용하여 문법적 이해를 향상시킵니다.

: OpenAi의 빠른 BPE 알고리즘는 OpenAi의 고속 BPE 알고리즘입니다 (GitHub에 따르면 비슷한 오픈 소스 대안보다 3-6 배 빠릅니다). 오픈 소스 버전은 Python을 포함한 다양한 라이브러리에서 제공됩니다.

라이브러리는 여러 모델에 맞게 여러 인코딩 방법을 지원합니다.

사용 또는

- :

!pip install openai tiktoken3 단계 : 텍스트를 인코딩

encoding = tiktoken.get_encoding("cl100k_base") # Or: encoding = tiktoken.encoding_for_model("gpt-4")

tiktoken 결론

decode 는 GPT 비용 추정에서 추측을 제거합니다. 토큰 화 및 BPE를 이해하고 를 사용하면 GPT API 호출 비용을 정확하게 예측하고 관리하여 사용 및 예산을 최적화 할 수 있습니다. 임베딩 및 OpenAI API 사용으로 더 깊은 다이빙을하려면 DataCAMP의 리소스 (원본에 제공된 링크)를 탐색하십시오.

위 내용은 Python의 Tiktoken 라이브러리를 사용하여 GPT 비용 추정의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

7 강력한 AI 프롬프트 모든 프로젝트 관리자가 지금 마스터 해야하는 경우May 08, 2025 am 11:39 AM

7 강력한 AI 프롬프트 모든 프로젝트 관리자가 지금 마스터 해야하는 경우May 08, 2025 am 11:39 AMChatgpt와 같은 챗봇에서 예시 된 Generative AI는 프로젝트 관리자에게 워크 플로를 간소화하고 프로젝트가 일정과 예산 내에서 유지되도록 강력한 도구를 제공합니다. 그러나 올바른 프롬프트를 제작하는 데 효과적으로 사용됩니다. 정확하고 세부 사항

AI 자체의 도움이되는 도움을 통해 애매한 AGI의 잘못 정의 된 의미 정의May 08, 2025 am 11:37 AM

AI 자체의 도움이되는 도움을 통해 애매한 AGI의 잘못 정의 된 의미 정의May 08, 2025 am 11:37 AM인공 일반 지능 (AGI)을 정의하는 과제는 중요합니다. AGI 진보에 대한 주장에는 종종 정의 된 연구 방향에 맞게 정의 된 정의와 함께 명확한 벤치 마크가 부족합니다. 이 기사는 정의에 대한 새로운 접근법을 탐구합니다

IBM은 2025 년이 생성 AI에서 Watsonx.data의 역할을 보여줍니다May 08, 2025 am 11:32 AM

IBM은 2025 년이 생성 AI에서 Watsonx.data의 역할을 보여줍니다May 08, 2025 am 11:32 AMIBM WATSONX.DATA : 엔터프라이즈 AI 데이터 스택을 간소화합니다 IBM은 Watsonx.data를 정확하고 확장 가능한 생성 AI 솔루션의 전달을 가속화하기위한 기업을위한 중추 플랫폼으로 위치합니다. 이것은 불만을 단순화하여 달성됩니다

휴머노이드 로봇 기계의 부상이 가까워지고 있습니다.May 08, 2025 am 11:29 AM

휴머노이드 로봇 기계의 부상이 가까워지고 있습니다.May 08, 2025 am 11:29 AMAI와 재료 과학의 혁신으로 인해 로봇 공학의 급속한 발전은 새로운 휴머노이드 로봇 시대를 안내 할 준비가되어 있습니다. 수년 동안 산업 자동화는 주요 초점 이었지만 로봇의 기능은 빠르게 exp입니다.

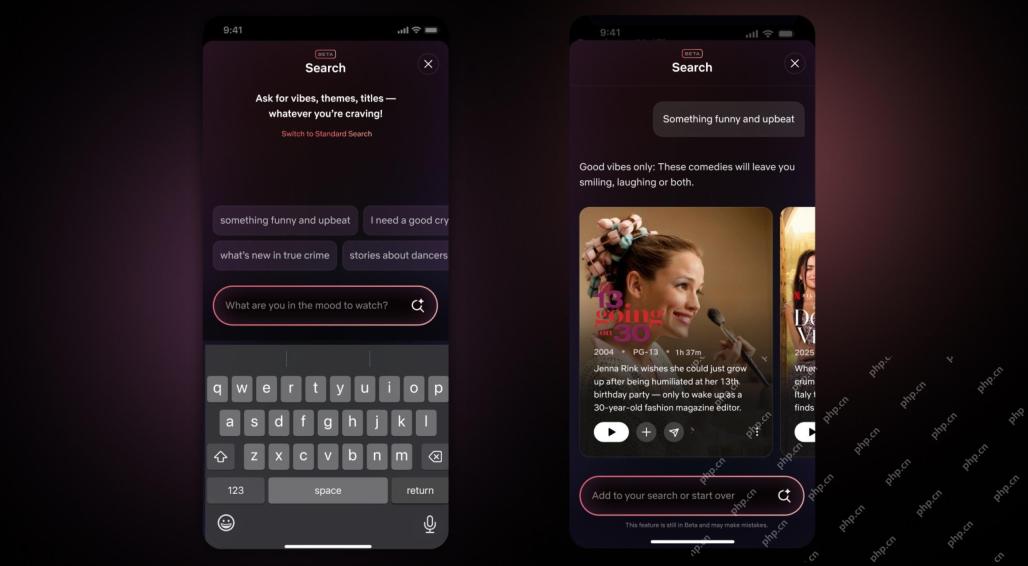

Netflix Revamps Interface-AI 검색 도구와 Tiktok와 같은 디자인 데뷔May 08, 2025 am 11:25 AM

Netflix Revamps Interface-AI 검색 도구와 Tiktok와 같은 디자인 데뷔May 08, 2025 am 11:25 AM10 년 만에 Netflix 인터페이스의 가장 큰 업데이트 : 더 똑똑하고 개인화 된 다양한 콘텐츠 수용 Netflix는 10 년 만에 사용자 인터페이스의 최대 개정을 발표했으며, 새로운 모습뿐만 아니라 각 쇼에 대한 더 많은 정보를 추가하고, "주변"및보다 유연한 구조와 같은 모호한 개념을 이해할 수있는 더 스마트 한 AI 검색 도구를 소개하여 비디오 게임, 라이브 이벤트, 스포츠 이벤트 및 기타 새로운 유형의 컨텐츠를 더 잘 보여줍니다. 트렌드를 따라 잡기 위해 모바일의 새로운 수직 비디오 구성 요소를 사용하면 팬이 트레일러와 클립을 쉽게 스크롤하거나 전체 쇼를 보거나 다른 사람들과 콘텐츠를 공유 할 수 있습니다. 이것은 무한한 스크롤과 매우 성공적인 짧은 비디오 웹 사이트 ti를 상기시킵니다.

AGI보다 오래 전에 : 당신에게 도전 할 3 개의 AI 이정표May 08, 2025 am 11:24 AM

AGI보다 오래 전에 : 당신에게 도전 할 3 개의 AI 이정표May 08, 2025 am 11:24 AM인공 지능에서 일반 정보 (AGI)에 대한 논의가 커지면 인공 지능이 인간 지능을 능가 할 때 어떤 일이 발생하는지 생각해 보았습니다. 이 순간이 가까운지 또는 멀리 떨어져 있는지 여부는 당신이 물어 보는 사람에 달려 있지만, 그것이 우리가 집중해야 할 가장 중요한 이정표라고 생각하지 않습니다. 어떤 초기 AI 이정표가 모든 사람에게 영향을 미칩니 까? 어떤 이정표가 달성 되었습니까? 내가 생각한 세 가지가 있습니다. 인공 지능은 인간의 약점을 능가합니다 2022 년 영화 "Social Dilemma"에서 Humane Technology Center의 Tristan Harris는 인공 지능이 인간의 약점을 능가했다고 지적했다. 이것이 무엇을 의미합니까? 이것은 인공 지능이 인간을 사용할 수 있음을 의미합니다.

TransUnion의 플랫폼 변환 및 AI 야망에 대한 Venkat AchantaMay 08, 2025 am 11:23 AM

TransUnion의 플랫폼 변환 및 AI 야망에 대한 Venkat AchantaMay 08, 2025 am 11:23 AMTransUnion의 CTO 인 Ranganath Achanta는 2021 년 후반 Neustar 인수 후 회사에 합류 한 이후 상당한 기술 변화를 주도했습니다. 다양한 부서의 7,000 명 이상의 직원들에 대한 그의 리더십

AI에 대한 신뢰가 높아지면 생산성이 뒤 따릅니다May 08, 2025 am 11:11 AM

AI에 대한 신뢰가 높아지면 생산성이 뒤 따릅니다May 08, 2025 am 11:11 AM신뢰 구축은 비즈니스에서 성공적인 AI 채택을 위해 가장 중요합니다. 이것은 비즈니스 프로세스 내에서 인적 요소를 고려할 때 특히 사실입니다. 다른 사람과 마찬가지로 직원은 AI와 그 구현에 대한 우려를 주었다. Deloitte 연구원은 SC입니다

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

SublimeText3 Linux 새 버전

SublimeText3 Linux 최신 버전

Dreamweaver Mac版

시각적 웹 개발 도구

에디트플러스 중국어 크랙 버전

작은 크기, 구문 강조, 코드 프롬프트 기능을 지원하지 않음

ZendStudio 13.5.1 맥

강력한 PHP 통합 개발 환경

맨티스BT

Mantis는 제품 결함 추적을 돕기 위해 설계된 배포하기 쉬운 웹 기반 결함 추적 도구입니다. PHP, MySQL 및 웹 서버가 필요합니다. 데모 및 호스팅 서비스를 확인해 보세요.