데이터 엔지니어링 ETL 파이프라인 구축을 위한 실무 가이드입니다. 이 가이드는 저장, 처리, 자동화, 모니터링을 다루는 데이터 엔지니어링 기본 사항을 이해하고 구현하는 실무적인 접근 방식을 제공합니다.

데이터 엔지니어링이란 무엇인가요?

데이터 엔지니어링은 원시 데이터를 분석 및 의사 결정을 위한 귀중한 통찰력으로 변환하기 위해 데이터 워크플로를 구성, 처리 및 자동화하는 데 중점을 둡니다. 이 가이드에서는 다음 내용을 다룹니다.

- 데이터 저장: 데이터가 저장되는 위치와 방법을 정의합니다.

- 데이터 처리: 원시 데이터를 정리하고 변환하는 기술

- 워크플로 자동화: 원활하고 효율적인 워크플로 실행을 구현합니다.

- 시스템 모니터링: 전체 데이터 파이프라인의 신뢰성과 원활한 작동을 보장합니다.

각 스테이지를 살펴볼까요!

개발 환경 설정

시작하기 전에 다음 사항을 확인하세요.

-

환경 설정:

- Unix 기반 시스템(macOS) 또는 Linux용 Windows 하위 시스템(WSL)

- Python 3.11(또는 그 이상)이 설치되어 있습니다.

- PostgreSQL 데이터베이스가 로컬에 설치되어 실행 중입니다.

-

전제 조건:

- 기본적인 명령줄 숙련도.

- Python 프로그래밍의 기초 지식

- 소프트웨어 설치 및 구성을 위한 관리 권한

-

건축 개요:

다이어그램은 파이프라인 구성 요소 간의 상호 작용을 보여줍니다. 이 모듈식 설계는 워크플로 조정을 위한 Airflow, 분산 데이터 처리를 위한 Spark, 구조화된 데이터 저장을 위한 PostgreSQL 등 각 도구의 장점을 활용합니다.

-

필요한 도구 설치:

- PostgreSQL:

brew update brew install postgresql

- PySpark:

brew install apache-spark

- 공기 흐름:

python -m venv airflow_env source airflow_env/bin/activate # macOS/Linux pip install "apache-airflow[postgres]==" --constraint "https://raw.githubusercontent.com/apache/airflow/constraints-2.10.4/constraints-3.11.txt" airflow db migrate

- PostgreSQL:

환경이 준비되었으니 각 구성 요소를 살펴보겠습니다.

1. 데이터 스토리지: 데이터베이스 및 파일 시스템

데이터 스토리지는 모든 데이터 엔지니어링 파이프라인의 기초입니다. 두 가지 기본 카테고리를 고려해 보겠습니다.

-

데이터베이스: 검색, 복제, 인덱싱과 같은 기능을 통해 효율적으로 구성된 데이터 스토리지입니다. 예는 다음과 같습니다.

- SQL 데이터베이스: 구조화된 데이터용(예: PostgreSQL, MySQL)

- NoSQL 데이터베이스: 스키마 없는 데이터(예: MongoDB, Redis)용.

- 파일 시스템: 구조화되지 않은 데이터에 적합하며 데이터베이스보다 적은 기능을 제공합니다.

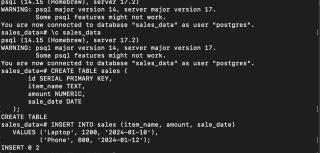

PostgreSQL 설정

- PostgreSQL 서비스 시작:

brew update brew install postgresql

- 데이터베이스 생성, 연결 및 테이블 생성:

brew install apache-spark

- 샘플 데이터 삽입:

python -m venv airflow_env source airflow_env/bin/activate # macOS/Linux pip install "apache-airflow[postgres]==" --constraint "https://raw.githubusercontent.com/apache/airflow/constraints-2.10.4/constraints-3.11.txt" airflow db migrate

이제 데이터가 PostgreSQL에 안전하게 저장되었습니다.

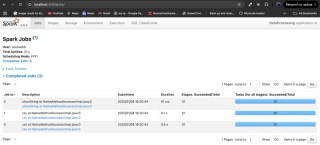

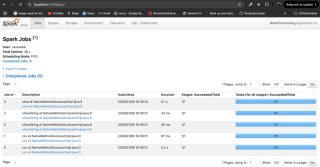

2. 데이터 처리: PySpark 및 분산 컴퓨팅

데이터 처리 프레임워크는 원시 데이터를 실행 가능한 통찰력으로 변환합니다. 분산 컴퓨팅 기능을 갖춘 Apache Spark가 인기 있는 선택입니다.

-

처리 모드:

- 일괄 처리: 고정된 크기의 일괄 처리로 데이터를 처리합니다.

- 스트림 처리: 실시간으로 데이터를 처리합니다.

- 공용 도구: Apache Spark, Flink, Kafka, Hive

PySpark를 사용한 데이터 처리

- Java 및 PySpark 설치:

brew services start postgresql

- CSV 파일에서 데이터 로드:

다음 데이터를 사용하여 sales.csv 파일을 만듭니다.

CREATE DATABASE sales_data;

\c sales_data

CREATE TABLE sales (

id SERIAL PRIMARY KEY,

item_name TEXT,

amount NUMERIC,

sale_date DATE

);

다음 Python 스크립트를 사용하여 데이터를 로드하고 처리합니다.

INSERT INTO sales (item_name, amount, sale_date)

VALUES ('Laptop', 1200, '2024-01-10'),

('Phone', 800, '2024-01-12');

- 고가치 매출 필터링:

brew install openjdk@11 && brew install apache-spark

-

Postgres DB 드라이버 설정: 필요한 경우 PostgreSQL JDBC 드라이버를 다운로드하고 아래 스크립트에서 경로를 업데이트하세요.

-

처리된 데이터를 PostgreSQL에 저장:

brew update brew install postgresql

Spark를 이용한 데이터 처리가 완료되었습니다.

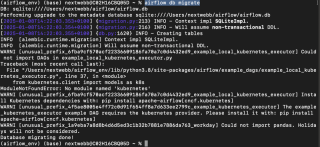

3. 워크플로우 자동화: Airflow

자동화는 예약 및 종속성 정의를 사용하여 워크플로 관리를 간소화합니다. Airflow, Oozie 및 Luigi와 같은 도구가 이를 용이하게 합니다.

Airflow를 통한 ETL 자동화

- 공기 흐름 초기화:

brew install apache-spark

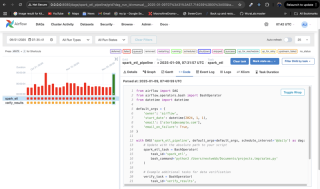

- 워크플로(DAG) 만들기:

python -m venv airflow_env source airflow_env/bin/activate # macOS/Linux pip install "apache-airflow[postgres]==" --constraint "https://raw.githubusercontent.com/apache/airflow/constraints-2.10.4/constraints-3.11.txt" airflow db migrate

이 DAG는 매일 실행되고 PySpark 스크립트를 실행하며 확인 단계를 포함합니다. 실패 시 이메일 알림이 전송됩니다.

-

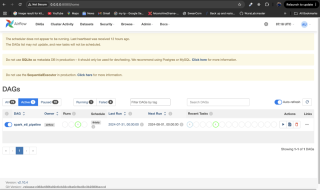

워크플로 모니터링: Airflow의

dags/디렉터리에 DAG 파일을 배치하고 Airflow 서비스를 다시 시작한 다음http://localhost:8080에서 Airflow UI를 통해 모니터링합니다.

4. 시스템 모니터링

모니터링을 통해 파이프라인 안정성이 보장됩니다. Airflow의 경고 또는 Grafana 및 Prometheus와 같은 도구와의 통합은 효과적인 모니터링 전략입니다. Airflow UI를 사용하여 작업 상태 및 로그를 확인하세요.

결론

데이터 저장소를 설정하고, PySpark를 사용하여 데이터를 처리하고, Airflow를 사용하여 워크플로를 자동화하고, 시스템을 모니터링하는 방법을 배웠습니다. 데이터 엔지니어링은 중요한 분야이며, 이 가이드는 추가 탐색을 위한 강력한 기반을 제공합니다. 더 자세한 정보를 보려면 제공된 참고 자료를 참조하세요.

위 내용은 데이터 엔지니어링 기초: 실습 가이드의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

Linux 터미널에서 Python 버전을 볼 때 발생하는 권한 문제를 해결하는 방법은 무엇입니까?Apr 01, 2025 pm 05:09 PM

Linux 터미널에서 Python 버전을 볼 때 발생하는 권한 문제를 해결하는 방법은 무엇입니까?Apr 01, 2025 pm 05:09 PMLinux 터미널에서 Python 버전을 보려고 할 때 Linux 터미널에서 Python 버전을 볼 때 권한 문제에 대한 솔루션 ... Python을 입력하십시오 ...

HTML을 구문 분석하기 위해 아름다운 수프를 어떻게 사용합니까?Mar 10, 2025 pm 06:54 PM

HTML을 구문 분석하기 위해 아름다운 수프를 어떻게 사용합니까?Mar 10, 2025 pm 06:54 PM이 기사에서는 HTML을 구문 분석하기 위해 파이썬 라이브러리 인 아름다운 수프를 사용하는 방법을 설명합니다. 데이터 추출, 다양한 HTML 구조 및 오류 처리 및 대안 (SEL과 같은 Find (), find_all (), select () 및 get_text ()와 같은 일반적인 방법을 자세히 설명합니다.

파이썬 객체의 직렬화 및 사제화 : 1 부Mar 08, 2025 am 09:39 AM

파이썬 객체의 직렬화 및 사제화 : 1 부Mar 08, 2025 am 09:39 AM파이썬 객체의 직렬화 및 사막화는 사소한 프로그램의 주요 측면입니다. 무언가를 Python 파일에 저장하면 구성 파일을 읽거나 HTTP 요청에 응답하는 경우 객체 직렬화 및 사태화를 수행합니다. 어떤 의미에서, 직렬화와 사제화는 세계에서 가장 지루한 것들입니다. 이 모든 형식과 프로토콜에 대해 누가 걱정합니까? 일부 파이썬 객체를 지속하거나 스트리밍하여 나중에 완전히 검색하려고합니다. 이것은 세상을 개념적 차원에서 볼 수있는 좋은 방법입니다. 그러나 실제 수준에서 선택한 직렬화 체계, 형식 또는 프로토콜은 속도, 보안, 유지 보수 상태 및 프로그램의 기타 측면을 결정할 수 있습니다.

Tensorflow 또는 Pytorch로 딥 러닝을 수행하는 방법은 무엇입니까?Mar 10, 2025 pm 06:52 PM

Tensorflow 또는 Pytorch로 딥 러닝을 수행하는 방법은 무엇입니까?Mar 10, 2025 pm 06:52 PM이 기사는 딥 러닝을 위해 텐서 플로와 Pytorch를 비교합니다. 데이터 준비, 모델 구축, 교육, 평가 및 배포와 관련된 단계에 대해 자세히 설명합니다. 프레임 워크, 특히 계산 포도와 관련하여 주요 차이점

파이썬의 수학 모듈 : 통계Mar 09, 2025 am 11:40 AM

파이썬의 수학 모듈 : 통계Mar 09, 2025 am 11:40 AMPython의 통계 모듈은 강력한 데이터 통계 분석 기능을 제공하여 생물 통계 및 비즈니스 분석과 같은 데이터의 전반적인 특성을 빠르게 이해할 수 있도록 도와줍니다. 데이터 포인트를 하나씩 보는 대신 평균 또는 분산과 같은 통계를보고 무시할 수있는 원래 데이터에서 트렌드와 기능을 발견하고 대형 데이터 세트를보다 쉽고 효과적으로 비교하십시오. 이 튜토리얼은 평균을 계산하고 데이터 세트의 분산 정도를 측정하는 방법을 설명합니다. 달리 명시되지 않는 한,이 모듈의 모든 함수는 단순히 평균을 합산하는 대신 평균 () 함수의 계산을 지원합니다. 부동 소수점 번호도 사용할 수 있습니다. 무작위로 가져옵니다 수입 통계 Fracti에서

아름다운 수프로 파이썬에서 웹 페이지를 긁어 내기 : 검색 및 DOM 수정Mar 08, 2025 am 10:36 AM

아름다운 수프로 파이썬에서 웹 페이지를 긁어 내기 : 검색 및 DOM 수정Mar 08, 2025 am 10:36 AM이 튜토리얼은 간단한 나무 탐색을 넘어서 DOM 조작에 중점을 둔 아름다운 수프에 대한 이전 소개를 바탕으로합니다. HTML 구조를 수정하기위한 효율적인 검색 방법과 기술을 탐색하겠습니다. 일반적인 DOM 검색 방법 중 하나는 EX입니다

인기있는 파이썬 라이브러리와 그 용도는 무엇입니까?Mar 21, 2025 pm 06:46 PM

인기있는 파이썬 라이브러리와 그 용도는 무엇입니까?Mar 21, 2025 pm 06:46 PM이 기사는 Numpy, Pandas, Matplotlib, Scikit-Learn, Tensorflow, Django, Flask 및 요청과 같은 인기있는 Python 라이브러리에 대해 설명하고 과학 컴퓨팅, 데이터 분석, 시각화, 기계 학습, 웹 개발 및 H에서의 사용에 대해 자세히 설명합니다.

Python으로 명령 줄 인터페이스 (CLI)를 만드는 방법은 무엇입니까?Mar 10, 2025 pm 06:48 PM

Python으로 명령 줄 인터페이스 (CLI)를 만드는 방법은 무엇입니까?Mar 10, 2025 pm 06:48 PM이 기사는 Python 개발자가 CLIS (Command-Line Interfaces) 구축을 안내합니다. Typer, Click 및 Argparse와 같은 라이브러리를 사용하여 입력/출력 처리를 강조하고 CLI 유용성을 향상시키기 위해 사용자 친화적 인 디자인 패턴을 홍보하는 세부 정보.

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

AI Hentai Generator

AI Hentai를 무료로 생성하십시오.

인기 기사

뜨거운 도구

SublimeText3 영어 버전

권장 사항: Win 버전, 코드 프롬프트 지원!

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

Atom Editor Mac 버전 다운로드

가장 인기 있는 오픈 소스 편집기

MinGW - Windows용 미니멀리스트 GNU

이 프로젝트는 osdn.net/projects/mingw로 마이그레이션되는 중입니다. 계속해서 그곳에서 우리를 팔로우할 수 있습니다. MinGW: GCC(GNU Compiler Collection)의 기본 Windows 포트로, 기본 Windows 애플리케이션을 구축하기 위한 무료 배포 가능 가져오기 라이브러리 및 헤더 파일로 C99 기능을 지원하는 MSVC 런타임에 대한 확장이 포함되어 있습니다. 모든 MinGW 소프트웨어는 64비트 Windows 플랫폼에서 실행될 수 있습니다.

Dreamweaver Mac版

시각적 웹 개발 도구