MLOps: AI 프로젝트 성능을 향상하기 위한 툴킷을 구축하는 방법

- 百草원래의

- 2024-09-04 13:35:57673검색

기대를 갖고 시작된 수많은 AI 프로젝트가 출발하지 못했습니다. 이는 일반적으로 기계 학습(ML) 모델의 품질 때문이 아닙니다. 제대로 구현되지 않은 구현과 시스템 통합은 프로젝트의 90%를 감소시킵니다. 조직은 AI 노력을 절약할 수 있습니다. 적절한 MLOps 방식을 채택하고 올바른 도구 세트를 선택해야 합니다. 이 기사에서는 가라앉는 AI 프로젝트를 저장하고 강력한 AI 프로젝트를 강화하여 잠재적으로 프로젝트 시작 속도를 두 배로 높일 수 있는 MLOps 사례와 도구에 대해 설명합니다.

약속을 가지고 시작된 수많은 AI 프로젝트는 실패합니다. 항해를 시작하십시오. 이는 일반적으로 기계 학습(ML) 모델의 품질 때문이 아닙니다. 잘못된 구현 및 시스템 통합으로 인해 프로젝트의 90%가 감소합니다. 조직은 AI 노력을 절약할 수 있습니다. 적절한 MLOps 방식을 채택하고 올바른 도구 세트를 선택해야 합니다. 이 문서에서는 가라앉는 AI 프로젝트를 저장하고 강력한 AI 프로젝트를 강화하여 잠재적으로 프로젝트 시작 속도를 두 배로 높일 수 있는 MLOps 사례와 도구에 대해 설명합니다.

MLOps in a 간단히 말해서

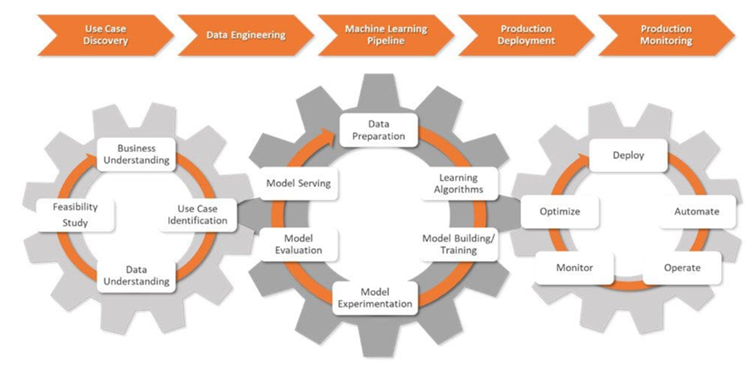

MLOps는 기계 학습 애플리케이션 개발( Dev) 및 운영 활동(Ops). 이는 ML 모델 배포를 자동화하고 간소화하는 데 도움이 되는 일련의 사례입니다. 결과적으로 전체 ML 수명 주기가 표준화됩니다.

MLOps는 복잡합니다. 이를 위해서는 데이터 관리, 모델 개발, 운영 간의 조화가 필요합니다. 또한 조직 내 기술과 문화의 변화가 필요할 수도 있습니다. MLOps를 원활하게 채택하면 전문가는 데이터 라벨링과 같은 지루한 작업을 자동화하고 배포 프로세스를 투명하게 만들 수 있습니다. 이는 프로젝트 데이터가 안전하고 데이터 개인 정보 보호법을 준수하는지 확인하는 데 도움이 됩니다.

조직은 MLOps 방식을 통해 ML 시스템을 강화하고 확장합니다. 이를 통해 데이터 과학자와 엔지니어 간의 협업이 더욱 효과적으로 이루어지고 혁신이 촉진됩니다.

도전 과제에서 AI 프로젝트 짜기

MLOps 전문가는 원시적인 비즈니스 과제를 간소화되고 측정 가능한 기계 학습 목표로 전환합니다. ML 파이프라인을 설계하고 관리하여 AI 프로젝트 수명주기 전반에 걸쳐 철저한 테스트와 책임을 보장합니다.

사용 사례 검색이라는 AI 프로젝트의 초기 단계에서 데이터 과학자는 기업과 협력하여 문제를 정의합니다. 이를 ML 문제 설명으로 변환하고 명확한 목표와 KPI를 설정합니다.

다음으로 데이터 과학자는 데이터 엔지니어와 팀을 이룹니다. 다양한 소스에서 데이터를 수집한 다음 이 데이터를 정리, 처리 및 검증합니다.

데이터 모델링이 준비되면 데이터 과학자는 CI/CD 프로세스와 통합된 강력한 ML 파이프라인을 설계하고 배포합니다. 이러한 파이프라인은 테스트 및 실험을 지원하고 모든 실험에서 데이터, 모델 계보 및 관련 KPI를 추적하는 데 도움이 됩니다.

프로덕션 배포 단계에서 ML 모델은 선택한 환경(클라우드, 온프레미스 또는 하이브리드)에 배포됩니다. .

데이터 과학자는 주요 측정항목을 사용하여 데이터 또는 모델 성능의 변화를 파악하여 모델과 인프라를 모니터링합니다. 변경 사항이 감지되면 알고리즘, 데이터, 하이퍼파라미터를 업데이트하여 ML 파이프라인의 새 버전을 생성합니다. 또한 모델의 확장성과 원활한 실행을 유지하기 위해 메모리와 컴퓨팅 리소스를 관리합니다.

MLOps 도구와 AI 프로젝트의 만남

고객의 제품 디자인 프로세스를 향상하기 위해 AI 애플리케이션을 개발하는 데이터 과학자를 상상해 보세요. 이 솔루션은 지정된 매개변수를 기반으로 AI 생성 설계 대안을 제공하여 프로토타입 제작 단계를 가속화합니다.

데이터 과학자는 프레임워크 설계부터 AI 모델 실시간 모니터링까지 다양한 작업을 탐색합니다. 올바른 도구가 필요하고 모든 단계에서 도구를 사용하는 방법을 이해해야 합니다.

더 나은 LLM 성능, 더 스마트한 AI 앱

정확하고 적응성이 뛰어난 AI 솔루션의 핵심에는 벡터 데이터베이스와 LLM 성능을 향상시키는 다음과 같은 주요 도구가 있습니다.

Guardrails는 데이터 과학자가 LLM 출력에 구조, 유형 및 품질 검사를 추가하는 데 도움이 되는 오픈소스 Python 패키지입니다. 검증에 실패할 경우 자동으로 오류를 처리하고 LLM 다시 쿼리와 같은 조치를 취합니다. 또한 JSON과 같은 출력 구조 및 유형에 대한 보장을 시행합니다.

데이터 과학자에게는 대규모 데이터 세트를 효율적으로 인덱싱, 검색 및 분석하기 위한 도구가 필요합니다. 바로 여기에 LlamaIndex가 개입합니다. 프레임워크는 광범위한 정보 저장소에서 통찰력을 관리하고 추출할 수 있는 강력한 기능을 제공합니다.

DUST 프레임워크를 사용하면 실행 코드 없이 LLM 기반 애플리케이션을 생성하고 배포할 수 있습니다. . 모델 출력을 검사하는 데 도움이 되고, 반복적인 설계 개선을 지원하며, 다양한 솔루션 버전을 추적합니다.

실험 추적 및 모델 메타데이터 관리

데이터 과학자는 시간이 지남에 따라 ML 모델을 더 잘 이해하고 개선하기 위해 실험합니다. 실제 결과를 기반으로 모델 정확성과 효율성을 향상시키는 시스템을 설정하는 도구가 필요합니다.

MLflow는 전체 ML 수명 주기를 감독하는 데 유용한 강력한 오픈 소스입니다. 실험 추적, 모델 버전 관리, 배포 기능과 같은 기능을 제공합니다. 이 제품군을 사용하면 데이터 과학자는 실험을 기록 및 비교하고 측정항목을 모니터링하며 ML 모델과 아티팩트를 체계적으로 정리할 수 있습니다.

Comet ML은 ML 모델을 추적, 비교, 설명, 최적화하기 위한 플랫폼이며, 실험. 데이터 과학자는 Scikit-learn, PyTorch, TensorFlow 또는 HuggingFace와 함께 Comet ML을 사용할 수 있습니다. 이는 ML 모델을 개선하기 위한 통찰력을 제공합니다.

Amazon SageMaker는 전체 기계 학습 수명 주기를 다룹니다. 이는 데이터에 레이블을 지정하고 준비하는 것은 물론 복잡한 ML 모델을 구축, 교육 및 배포하는 데 도움이 됩니다. 데이터 과학자는 이 도구를 사용하여 다양한 환경에서 모델을 신속하게 배포하고 확장합니다.

Microsoft Azure ML은 기계 학습 워크플로를 간소화하는 데 도움이 되는 클라우드 기반 플랫폼입니다. TensorFlow 및 PyTorch와 같은 프레임워크를 지원하며 다른 Azure 서비스와 통합할 수도 있습니다. 이 도구는 데이터 과학자의 실험 추적, 모델 관리, 배포에 도움이 됩니다.

DVC(데이터 버전 제어)는 대규모 데이터 세트와 기계 학습 실험을 처리하기 위한 오픈 소스 도구입니다. 이 도구는 데이터 과학 워크플로를 더욱 민첩하고 재현 가능하며 협업적으로 만듭니다. DVC는 Git과 같은 기존 버전 제어 시스템과 함께 작동하여 데이터 과학자가 복잡한 AI 프로젝트의 변경 사항을 추적하고 진행 상황을 공유하는 방법을 단순화합니다.

ML 워크플로 최적화 및 관리

데이터 과학자가 필요로 하는 것 AI 프로젝트에서 보다 원활하고 효과적인 프로세스를 달성하기 위해 워크플로우를 최적화했습니다. 다음 도구가 도움이 될 수 있습니다.

Prefect는 데이터 과학자가 워크플로를 모니터링하고 조정하는 데 사용하는 최신 오픈 소스 도구입니다. 가볍고 유연하며 ML 파이프라인(Prefect Orion UI 및 Prefect Cloud) 관리 옵션이 있습니다.

Metaflow는 워크플로 관리를 위한 강력한 도구입니다. 이는 데이터 과학 및 기계 학습을 위한 것입니다. MLOps의 번거로움 없이 모델 개발에 쉽게 집중할 수 있습니다.

Kedro는 데이터 과학자가 프로젝트를 재현 가능하고 모듈식이며 유지 관리하기 쉽게 유지하는 데 도움이 되는 Python 기반 도구입니다. 이는 기계 학습(모듈성, 관심사 분리 및 버전 관리)에 주요 소프트웨어 엔지니어링 원칙을 적용합니다. 이는 데이터 과학자가 효율적이고 확장 가능한 프로젝트를 구축하는 데 도움이 됩니다.

데이터 관리 및 파이프라인 버전 제어

ML 워크플로에는 정밀한 데이터 관리와 파이프라인 무결성이 필요합니다. 올바른 도구를 사용하면 데이터 과학자는 이러한 작업을 주도적으로 수행하고 가장 복잡한 데이터 문제도 자신 있게 처리할 수 있습니다.

Pachyderm은 데이터 과학자가 데이터 변환을 자동화하도록 돕고 데이터 버전 관리, 계보 및 엔드 투 엔드 파이프라인을 위한 강력한 기능을 제공합니다. 이러한 기능은 Kubernetes에서 원활하게 실행될 수 있습니다. Pachyderm은 이미지, 로그, 비디오, CSV 및 다중 언어(Python, R, SQL 및 C/C) 등 다양한 데이터 유형과의 통합을 지원합니다. 페타바이트 규모의 데이터와 수천 개의 작업을 처리할 수 있도록 확장됩니다.

LakeFS는 확장성을 위해 설계된 오픈 소스 도구입니다. 개체 스토리지에 Git과 유사한 버전 제어를 추가하고 엑사바이트 규모의 데이터 버전 제어를 지원합니다. 이 도구는 광범위한 데이터 레이크를 처리하는 데 이상적입니다. 데이터 과학자는 이 도구를 사용하여 코드를 처리하는 것처럼 쉽게 데이터 레이크를 관리합니다.

ML 모델의 품질과 공정성을 테스트하세요

데이터 과학자는 보다 안정적인 개발에 중점을 둡니다. 그리고 공정한 ML 솔루션. 편견을 최소화하기 위해 모델을 테스트합니다. 올바른 도구는 정확성 및 AUC와 같은 주요 측정항목을 평가하고, 오류 분석 및 버전 비교를 지원하고, 프로세스를 문서화하고, ML 파이프라인에 원활하게 통합하는 데 도움이 됩니다.

Deepchecks는 다음을 지원하는 Python 패키지입니다. ML 모델 및 데이터 검증을 통해 또한 모델 성능 확인, 데이터 무결성 및 분포 불일치가 쉬워집니다.

Truera는 데이터 과학자가 ML 모델의 신뢰도와 투명성을 높이는 데 도움이 되는 최신 모델 인텔리전스 플랫폼입니다. 이 도구를 사용하면 모델 동작을 이해하고, 문제를 식별하고, 편향을 줄일 수 있습니다. Truera는 모델 디버깅, 설명 가능성 및 공정성 평가 기능을 제공합니다.

Kolena는 엄격한 테스트와 디버깅을 통해 팀 조정과 신뢰를 강화하는 플랫폼입니다. 결과와 통찰력을 기록하기 위한 온라인 환경을 제공합니다. 다양한 시나리오에서 일관된 모델 성능을 유지하는 데 중요한 ML 단위 테스트 및 검증에 중점을 두고 있습니다.

모델에 생명을 불어넣기

데이터 과학자에게는 신뢰할 수 있는 도구가 필요합니다. ML 모델을 효율적으로 배포하고 안정적으로 예측을 제공합니다. 다음 도구는 원활하고 확장 가능한 ML 작업을 달성하는 데 도움이 됩니다.

BentoML은 데이터 과학자가 프로덕션에서 ML 작업을 처리하는 데 도움이 되는 개방형 플랫폼입니다. 이는 모델 패키징을 간소화하고 효율성을 위해 서비스 워크로드를 최적화하는 데 도움이 됩니다. 또한 예측 서비스의 더 빠른 설정, 배포, 모니터링을 지원합니다.

Kubeflow는 Kubernete(로컬, 온프레미스 또는 클라우드)에 ML 모델 배포를 단순화합니다. 이 도구를 사용하면 전체 프로세스가 간단해지고 이식 가능하며 확장 가능해집니다. 데이터 준비부터 예측 제공까지 모든 것을 지원합니다.

엔드 투 엔드 MLOps 플랫폼으로 ML 수명 주기 단순화

엔드 투 엔드 MLOps 플랫폼은 기계 학습 수명 주기를 최적화하는 데 필수적이며 간소화된 접근 방식을 제공합니다. ML 모델을 효과적으로 개발, 배포, 관리하는 데 도움이 됩니다. 다음은 이 분야의 몇 가지 주요 플랫폼입니다.

Amazon SageMaker는 데이터 과학자가 전체 ML 수명 주기를 처리하는 데 도움이 되는 포괄적인 인터페이스를 제공합니다. 데이터 전처리, 모델 훈련, 실험을 간소화하여 데이터 과학자 간의 협업을 강화합니다. 내장된 알고리즘, 자동화된 모델 조정, AWS 서비스와의 긴밀한 통합과 같은 기능을 갖춘 SageMaker는 확장 가능한 기계 학습 솔루션을 개발하고 배포하기 위한 최고의 선택입니다.

Microsoft Azure ML 플랫폼은 다양한 프로그래밍 언어와 프레임워크를 지원하는 협업 환경입니다. 이를 통해 데이터 과학자는 사전 구축된 모델을 사용하고, ML 작업을 자동화하고, 다른 Azure 서비스와 원활하게 통합할 수 있으므로 클라우드 기반 ML 프로젝트를 위한 효율적이고 확장 가능한 선택이 됩니다.

Google Cloud Vertex AI는 AutoML을 사용한 자동화된 모델 개발과 널리 사용되는 프레임워크를 사용한 커스텀 모델 학습을 위한 원활한 환경을 제공합니다. Google Cloud 서비스에 대한 통합 도구와 손쉬운 액세스를 통해 Vertex AI는 ML 프로세스를 단순화하고 데이터 과학 팀이 대규모로 손쉽게 모델을 구축하고 배포하는 데 이상적입니다.

종료

MLOps는 단순한 과대 광고가 아닙니다. 전문가가 대용량 데이터를 보다 빠르고, 정확하고, 쉽게 학습하고 분석할 수 있도록 돕는 중요한 분야입니다. 향후 10년 동안 이것이 어떻게 발전할지는 상상할 수 없지만 AI, 빅데이터, 자동화가 이제 막 탄력을 받기 시작했다는 것은 분명합니다.

위 내용은 MLOps: AI 프로젝트 성능을 향상하기 위한 툴킷을 구축하는 방법의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!