Die AIxiv-Kolumne ist eine Kolumne, in der diese Website akademische und technische Inhalte veröffentlicht. In den letzten Jahren sind in der AIxiv-Kolumne dieser Website mehr als 2.000 Berichte eingegangen, die Spitzenlabore großer Universitäten und Unternehmen auf der ganzen Welt abdecken und so den akademischen Austausch und die Verbreitung wirksam fördern. Wenn Sie hervorragende Arbeiten haben, die Sie teilen möchten, können Sie gerne einen Beitrag leisten oder uns für die Berichterstattung kontaktieren. E-Mail für die Einreichung: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com

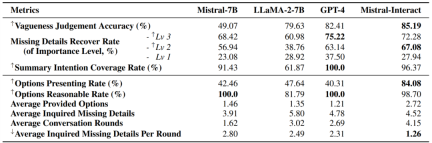

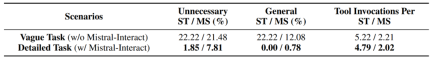

Mit Mistral-7B als Rahmen und basierend auf IN3-Training kann Mistral-Interact die Mehrdeutigkeit von Aufgaben proaktiv bewerten, Benutzerabsichten abfragen und sie in umsetzbare Ziele verfeinern, bevor die Ausführung nachgelagerter Agentenaufgaben gestartet wird. Nach der Einbettung des Modells in das XAgent-Framework führt der Artikel eine umfassende Bewertung des vollständig zustandsbehafteten Agentensystems durch.

Die Ergebnisse zeigen, dass diese Lösung eine hervorragende Leistung bei der Identifizierung mehrdeutiger Benutzeraufgaben, der Wiederherstellung und Zusammenfassung wichtiger fehlender Informationen, der Festlegung genauer und notwendiger Ziele für die Agentenausführung und der Reduzierung des Einsatzes redundanter Tools bietet. Diese innovative Methode schließt nicht nur die Lücke in der Interaktion zwischen intelligenten Agenten und Benutzern und stellt den Menschen wirklich in den Mittelpunkt des Designs intelligenter Agenten, sondern bedeutet auch, dass wir dem Ziel, intelligente Agenten zu entwerfen, die besser aufeinander abgestimmt sind, einen Schritt näher kommen mit menschlichen Absichten.

- Papiertitel: Tell Me More! Towards Implicit User Intention Understanding of Language Model Driven Agents

- Papierlink: https://arxiv.org/abs/2402.09205

- Code-Repository: https ://github.com/HBX-hbx/Mistral-Interact

- Open-Source-Modell: https://huggingface.co/hbx/Mistral-Interact

- Open-Source-Datensatz: https://huggingface.co / datasets/hbx/IN3

ㅋㅋ ~ 퍼지 태스크와 클리어 태스크 실행의 비교

Mistral-Interact 훈련 프로세스

대규모 언어 모델이 에이전트 설계의 핵심이므로 이 작업에서는 먼저 상호 작용에서 현재 오픈 소스 및 폐쇄 소스 모델의 암시적 성능을 평가하기 위한 예비 연구를 수행했습니다. 프로세스. 공식 의도 이해 능력.

대규모 언어 모델이 에이전트 설계의 핵심이므로 이 작업에서는 먼저 상호 작용에서 현재 오픈 소스 및 폐쇄 소스 모델의 암시적 성능을 평가하기 위한 예비 연구를 수행했습니다. 프로세스. 공식 의도 이해 능력.

에이전트 상호작용 능력 종합 평가

명령 이해

에이전트 상호 작용 사례 분석

에이전트 상호 작용 사례 분석

- 다양한 시나리오의 Mistral-Interact 및 사용자 사례 분석

텍스트는 사용자의 대상이 흐려지면 찾을 수 있습니다. XAgent는 사용자의 요구를 정확하게 반영하는 하위 작업을 정확하게 설정할 수 없습니다.

위 내용은 오픈 소스와 비공개 소스 모델 '카오스(Chaos)': 인간의 진짜 의도를 가장 잘 엿볼 수 있는 에이전트가 누구인지 알아보자의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

AI 게임 개발May 02, 2025 am 11:17 AM

AI 게임 개발May 02, 2025 am 11:17 AM격변 게임 : AI 에이전트와의 게임 개발 혁명 Blizzard 및 Obsidian과 같은 업계 대기업의 재향 군인으로 구성된 게임 개발 스튜디오 인 Upheaval은 혁신적인 AI 구동 Platfor로 게임 제작에 혁명을 일으킬 준비가되어 있습니다.

Uber는 Robotaxi 상점이되기를 원합니다. 제공자가 그들을 허락할까요?May 02, 2025 am 11:16 AM

Uber는 Robotaxi 상점이되기를 원합니다. 제공자가 그들을 허락할까요?May 02, 2025 am 11:16 AMUber의 Robotaxi 전략 : 자율 주행 차량을위한 승차원 생태계 최근 Curbivore 컨퍼런스에서 Uber의 Richard Willder는 Robotaxi 제공 업체를위한 승마 플랫폼이되기위한 전략을 공개했습니다. 그들의 지배적 인 위치를 활용합니다

비디오 게임을하는 AI 요원은 미래의 로봇을 변화시킬 것입니다May 02, 2025 am 11:15 AM

비디오 게임을하는 AI 요원은 미래의 로봇을 변화시킬 것입니다May 02, 2025 am 11:15 AM비디오 게임은 특히 자율적 인 에이전트 및 실제 로봇의 개발에서 최첨단 AI 연구를위한 귀중한 테스트 근거로 입증되며, 인공 일반 정보 (AGI)에 대한 탐구에 잠재적으로 기여할 수 있습니다. 에이

스타트 업 산업 단지, VC 3.0 및 James Currier 's ManifestoMay 02, 2025 am 11:14 AM

스타트 업 산업 단지, VC 3.0 및 James Currier 's ManifestoMay 02, 2025 am 11:14 AM진화하는 벤처 캐피탈 환경의 영향은 미디어, 재무 보고서 및 일상적인 대화에서 분명합니다. 그러나 투자자, 신생 기업 및 자금에 대한 구체적인 결과는 종종 간과됩니다. 벤처 캐피탈 3.0 : 패러다임

Adobe 업데이트 Adobe Max London 2025에서 Creative Cloud and FireflyMay 02, 2025 am 11:13 AM

Adobe 업데이트 Adobe Max London 2025에서 Creative Cloud and FireflyMay 02, 2025 am 11:13 AMAdobe Max London 2025는 Creative Cloud and Firefly에 상당한 업데이트를 제공하여 접근성 및 생성 AI로의 전략적 전환을 반영했습니다. 이 분석에는 Adobe Leadership과의 사전 이벤트 브리핑의 통찰력이 포함되어 있습니다. (참고 : Adob

모든 메타는 Llamacon에서 발표했습니다May 02, 2025 am 11:12 AM

모든 메타는 Llamacon에서 발표했습니다May 02, 2025 am 11:12 AMMeta의 Llamacon 발표는 OpenAi와 같은 폐쇄 된 AI 시스템과 직접 경쟁하도록 설계된 포괄적 인 AI 전략을 보여 주며 동시에 오픈 소스 모델을위한 새로운 수익원을 만듭니다. 이 다각적 인 접근법은 Bo를 대상으로합니다

AI가 정상적인 기술에 지나지 않는다는 제안에 대한 양조 논쟁May 02, 2025 am 11:10 AM

AI가 정상적인 기술에 지나지 않는다는 제안에 대한 양조 논쟁May 02, 2025 am 11:10 AM이 결론에 대한 인공 지능 분야에는 심각한 차이가 있습니다. 어떤 사람들은 "황제의 새로운 옷"을 폭로 할 때라고 주장하는 반면, 인공 지능은 단지 일반적인 기술이라는 생각에 강력하게 반대합니다. 논의합시다. 이 혁신적인 AI 혁신에 대한 분석은 다양한 영향력있는 AI 복잡성을 식별하고 설명하는 것을 포함하여 AI 분야의 최신 발전을 다루는 진행중인 Forbes 열의 일부입니다 (링크를 보려면 여기를 클릭하십시오). 공통 기술로서의 인공 지능 첫째,이 중요한 토론을위한 토대를 마련하기 위해서는 몇 가지 기본 지식이 필요합니다. 현재 인공 지능을 발전시키는 데 전념하는 많은 연구가 있습니다. 전반적인 목표는 인공 일반 지능 (AGI) 및 가능한 인공 슈퍼 인텔리전스 (AS)를 달성하는 것입니다.

모델 시민, AI 가치가 다음 비즈니스 척도 인 이유May 02, 2025 am 11:09 AM

모델 시민, AI 가치가 다음 비즈니스 척도 인 이유May 02, 2025 am 11:09 AM회사의 AI 모델의 효과는 이제 핵심 성과 지표입니다. AI 붐 이후 생일 초대장 작성부터 소프트웨어 코드 작성에 이르기까지 생성 AI는 모든 데 사용되었습니다. 이로 인해 언어 모드가 확산되었습니다

핫 AI 도구

Undresser.AI Undress

사실적인 누드 사진을 만들기 위한 AI 기반 앱

AI Clothes Remover

사진에서 옷을 제거하는 온라인 AI 도구입니다.

Undress AI Tool

무료로 이미지를 벗다

Clothoff.io

AI 옷 제거제

Video Face Swap

완전히 무료인 AI 얼굴 교환 도구를 사용하여 모든 비디오의 얼굴을 쉽게 바꾸세요!

인기 기사

뜨거운 도구

Eclipse용 SAP NetWeaver 서버 어댑터

Eclipse를 SAP NetWeaver 애플리케이션 서버와 통합합니다.

VSCode Windows 64비트 다운로드

Microsoft에서 출시한 강력한 무료 IDE 편집기

SublimeText3 Linux 새 버전

SublimeText3 Linux 최신 버전

mPDF

mPDF는 UTF-8로 인코딩된 HTML에서 PDF 파일을 생성할 수 있는 PHP 라이브러리입니다. 원저자인 Ian Back은 자신의 웹 사이트에서 "즉시" PDF 파일을 출력하고 다양한 언어를 처리하기 위해 mPDF를 작성했습니다. HTML2FPDF와 같은 원본 스크립트보다 유니코드 글꼴을 사용할 때 속도가 느리고 더 큰 파일을 생성하지만 CSS 스타일 등을 지원하고 많은 개선 사항이 있습니다. RTL(아랍어, 히브리어), CJK(중국어, 일본어, 한국어)를 포함한 거의 모든 언어를 지원합니다. 중첩된 블록 수준 요소(예: P, DIV)를 지원합니다.

드림위버 CS6

시각적 웹 개발 도구