ICML 2024 스포트라이트 | 디코딩의 재정렬로 언어 모델이 덜 환각적이고 인간 선호도와 더욱 일치하게 됩니다.

- PHPz원래의

- 2024-07-01 22:09:56560검색

AIxiv 칼럼은 본 사이트에서 학술 및 기술 콘텐츠를 게재하는 칼럼입니다. 지난 몇 년 동안 이 사이트의 AIxiv 칼럼에는 전 세계 주요 대학 및 기업의 최고 연구실을 대상으로 한 2,000개 이상의 보고서가 접수되어 학술 교류 및 보급을 효과적으로 촉진하고 있습니다. 공유하고 싶은 훌륭한 작품이 있다면 자유롭게 기여하거나 보고를 위해 연락주시기 바랍니다. 제출 이메일: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com

이 기사는 스위스, 영국, 프랑스 3개 대학의 박사과정 학생들과 Google DeepMind 및 Google Research가 작성한 언어 모델 정렬 연구에 대한 논문을 소개합니다. 연구진과의 협력으로 완성되었습니다. 그 중 교신 저자인 Tianlin Liu와 Mathieu Blondel은 각각 스위스 바젤 대학교 출신이고 Google DeepMind Paris 출신입니다. 이 논문은 ICML-2024에 의해 승인되었으며 스포트라이트 프레젠테이션으로 선정되었습니다(전체 제출의 3.5%에 불과). 주소 : https://openreview.net/forum?id=n8g6wmxt09¬eid=e3vvdpvopz

- 연구 동기

이것이 바로 언어 모델 "정렬"이 해결하려는 문제입니다. 정렬을 통해 우리는 모델이 어떤 응답이 좋고 나쁜지 이해하여 유용한 응답만 생성하기를 원합니다.

정렬된 훈련 방법에는 인간 선호 보상과 정규화라는 두 가지 핵심 요소가 있습니다. 보상은 모델이 인간에게 인기 있는 답변을 제공하도록 장려하는 반면, 정규화는 모델이 원래 상태에서 너무 멀리 벗어나지 않도록 보장하여 과적합을 방지합니다.

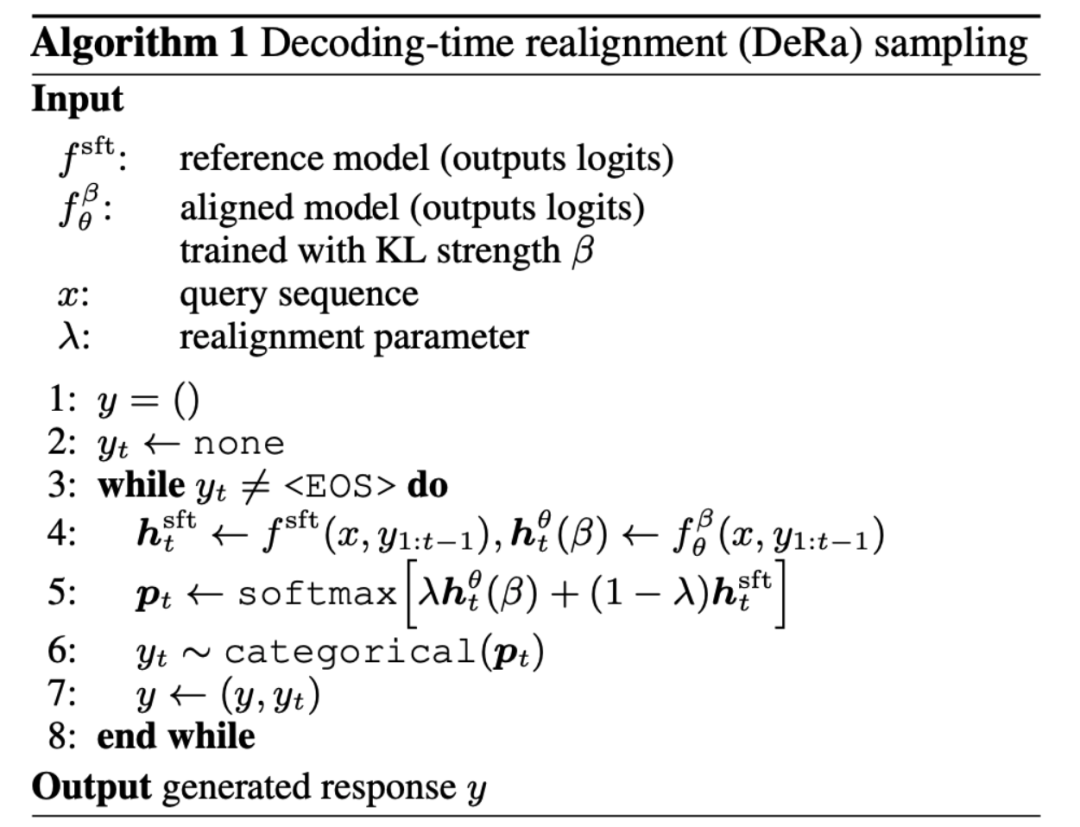

그렇다면 어떻게 보상과 정규화의 균형을 맞출 수 있을까요? "Decoding-time Realignment of Language Models"라는 논문에서는 DeRa 방법을 제안했습니다.

Flexible: DeRa를 통해 다양한 요구 사항(예: 사용자, 프롬프트 단어, 작업)에 맞게 정렬 강도를 유연하게 조정할 수 있습니다. 오버헤드 절약: DeRa를 통해 모델 추론(추론) 중에 하이퍼파라미터 스윕을 수행할 수 있으므로 반복 학습에 따른 계산 오버헤드를 피할 수 있습니다. -

방법 개요

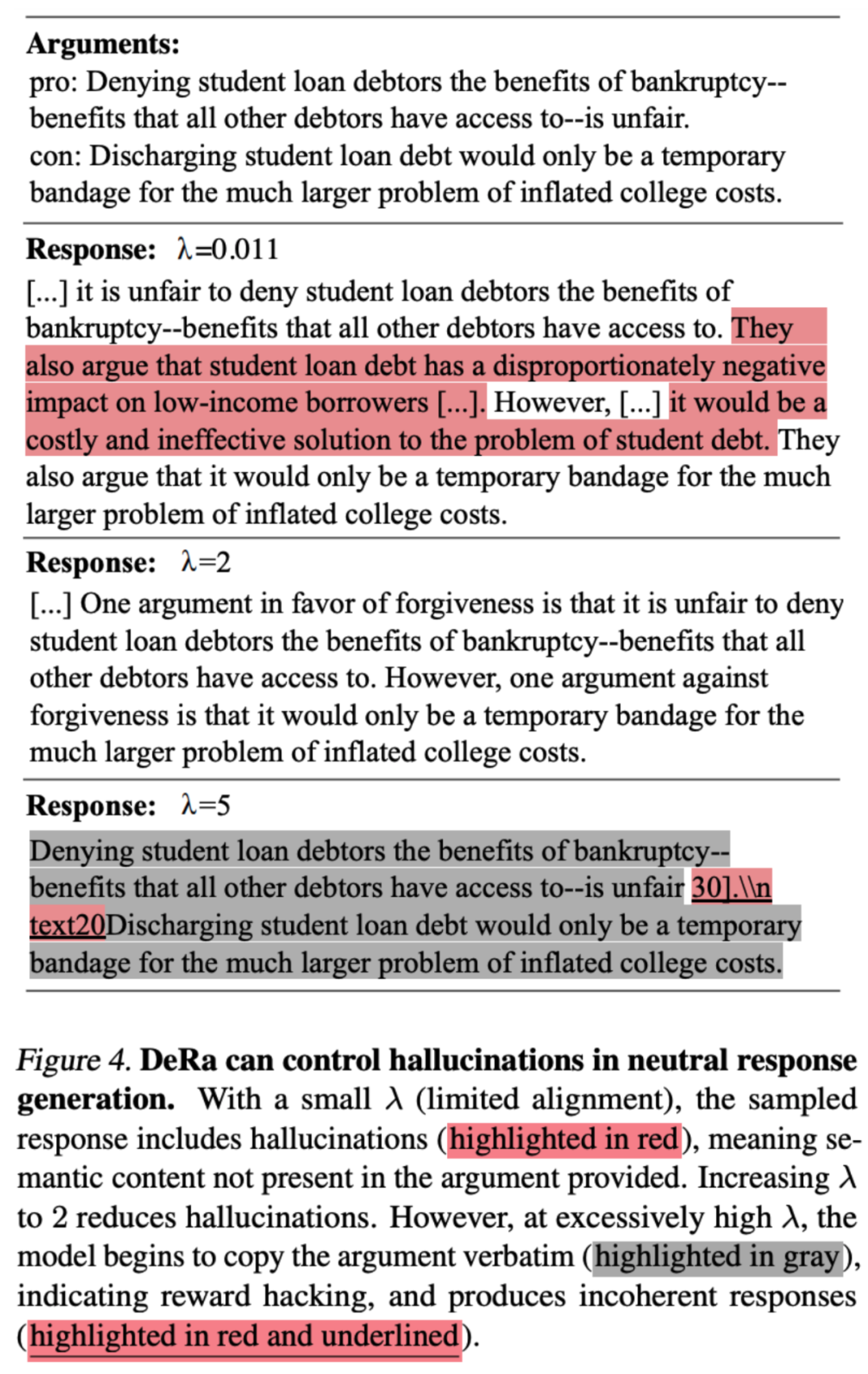

보상과 정규화의 균형을 맞추는 매개변수 β가 중요합니다. 너무 적으면 보상에 과적합(보상 해킹)이 발생하고, 너무 많으면 정렬의 효율성이 손상됩니다.

그렇다면 밸런싱을 위해 이 매개변수 β를 어떻게 선택해야 할까요? 전통적인 접근 방식은 시행착오입니다. 각 β 값에 대해 새 모델을 훈련합니다. 이 접근 방식은 효과적이지만 계산 비용이 많이 듭니다.

그렇다면 밸런싱을 위해 이 매개변수 β를 어떻게 선택해야 할까요? 전통적인 접근 방식은 시행착오입니다. 각 β 값에 대해 새 모델을 훈련합니다. 이 접근 방식은 효과적이지만 계산 비용이 많이 듭니다.

재교육 없이 보상 최적화와 정규화 사이의 균형을 탐색하는 것이 가능합니까? DeRa의 저자는

위 내용은 ICML 2024 스포트라이트 | 디코딩의 재정렬로 언어 모델이 덜 환각적이고 인간 선호도와 더욱 일치하게 됩니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!