ホームページ >テクノロジー周辺機器 >AI >ロボット運用の世界モデルについての考え

ロボット運用の世界モデルについての考え

- 王林転載

- 2024-04-28 17:31:10835ブラウズ

近年、ワールドモデルの人気がロボットの運用に重要な役割を果たしているようです。身体化された知性にとって、操作はこの段階で突破すべき最も重要なポイントです。特に、次のような長期にわたる課題では、さまざまな複雑な動作要件を達成するロボット「小脳」をどのように構築するかが、現時点で解決すべき最も緊急な問題です。

スキルをアトミック操作に分割する必要がありますか?

LM を使用してロボットに適用する場合、一般的なアプローチは、コンテキストでさまざまな API を提供し、タスク プロンプトに従って LLM に計画コードを自動的に作成させることです。 # という記事を参照してください。

##この方法の利点は、非常に直感的で、A に移動、B を拾う、C に移動、B を置くなどのタスクの分解ロジックを明確に把握できることです。ただし、この操作の前提は、タスク全体をアトミックな操作 (移動、グラブ、配置など) に分割できることです。しかし、服をたたむなど、より複雑な作業の場合は、当然、作業を分割するのは困難です。このとき、どうすればよいでしょうか。実際、操作に関しては、長期にわたる、分割が難しい多くのタスクに直面する必要があります。

世界モデルは、重要なブレークスルー ポイントとして使用できます。

長い視野を操作するための重要な点として使用できます。タスク を分割するのは難しいため、これに対処するより良い方法は、拡散ポリシーや ACT などの 模倣学習 を研究して、全体の操作軌跡をモデル化して適合させることです。ただし、この方法では問題が発生します。つまり、累積誤差を適切に処理する方法がないということです。この問題の本質は、効果的な フィードバック メカニズム が欠如していることです。

衣服をたたむ場合を例に考えてみましょう。人々は衣服をたたむとき、視覚的に見える衣服の変化に基づいて操作戦略を常に調整し、最終的には目的の外観に衣服をたたみます。実はこれには、比較的暗黙的だが非常に重要な点がある。それは、人々は、どのような操作によって服装にどのような変化が生じるかを大まかに知っているということである。さらに一歩進んで、人は実際に衣服の変形に関するモデル を持っており、どのような入力によって状態 (衣服の配置) が変化するかを大まかに知ることができます (視覚レベルはピクセル レベルです)。

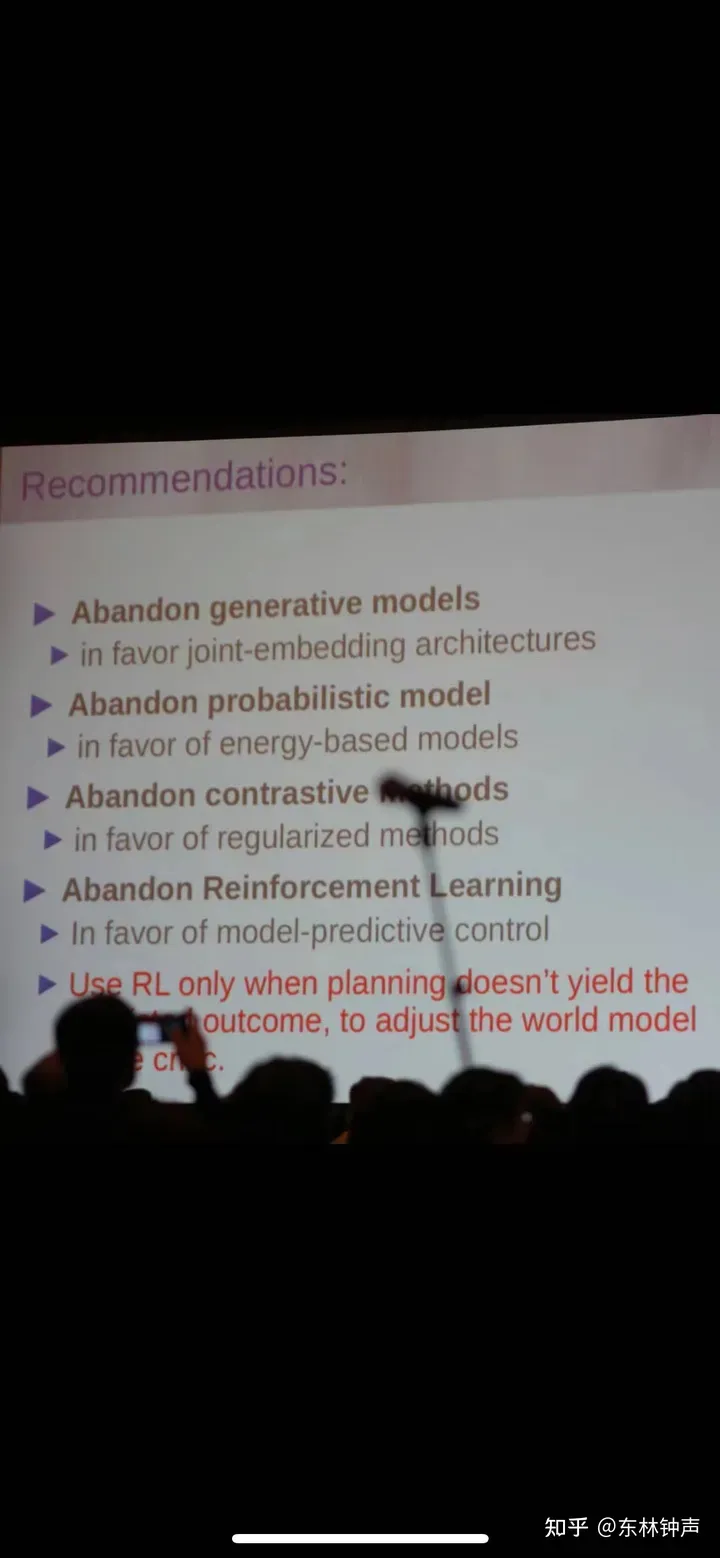

モデル予測制御のアイデアを通じて視覚的サーボを構築できます。 (Visual Servo)衣類を思いどおりの状態に折りたたむ戦略。これは実際、LeCun の最近の「暴力的な議論」のいくつかによって検証されています:

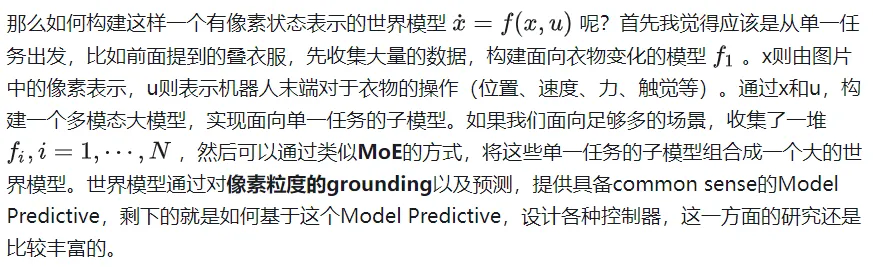

ロボット操作のための世界モデルを構築する方法

以上がロボット運用の世界モデルについての考えの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。