ホームページ >テクノロジー周辺機器 >AI >OWASP が大規模言語モデルのネットワーク セキュリティとガバナンスのチェックリストをリリース

OWASP が大規模言語モデルのネットワーク セキュリティとガバナンスのチェックリストをリリース

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2024-04-17 19:31:011253ブラウズ

人工知能テクノロジーが現在直面している最大のリスクは、大規模言語モデル (LLM) と生成人工知能テクノロジーの開発と適用の速度が、セキュリティとガバナンスの速度をはるかに超えていることです。

OpenAI、Anthropic、Google、Microsoft などの企業による生成 AI および大規模言語モデル製品の使用は、飛躍的に増加しています。同時に、オープンソースの大規模言語モデル ソリューションも急速に成長しています。HuggingFace などのオープンソース人工知能コミュニティは、多数のオープンソース モデル、データ セット、AI アプリケーションを提供しています。

人工知能の開発を促進するために、OWASP、OpenSSF、CISA などの業界団体は、OWASP AI Exchange、AI セキュリティとプライバシーなど、人工知能のセキュリティとガバナンスのための主要な資産を積極的に開発および提供しています。ガイド、およびビッグ言語モデル 10 大リスク リスト (LLMTop10)。

最近、OWASP は大規模な言語モデルのネットワーク セキュリティとガバナンスのチェックリストをリリースし、生成型人工知能セキュリティ ガバナンスのギャップを埋めました。具体的な内容は次のとおりです。

OWASP による AI の種類と脅威の定義。

OWASP の言語モデルのサイバーセキュリティとガバナンス チェックリストでは、人工知能、機械学習、生成人工知能、大規模言語モデルの違いを定義しています。

たとえば、OWASP は生成人工知能を次のように定義しています。新しいデータの作成に焦点を当てた機械学習の一種であり、大規模な言語モデルは人間に似た「自然なコンテンツ」の人工知能モデルを処理および生成するために使用されます。提供された入力に基づいて予測が行われ、出力は人間が生成したコンテンツに似た「自然なコンテンツ」になります。

以前にリリースされた「ビッグ言語モデル トップ 10 脅威リスト」に関して、OWASP は、ネットワーク セキュリティ担当者が急速に発展する AI テクノロジーに追いつき、主要な脅威を特定し、企業が基本的なセキュリティ管理を確実に行えるようにするのに役立つと考えています。生成 AI と大規模な言語モデルを使用してビジネスを保護し、サポートします。ただし、OWASP は、このリストは網羅的なものではなく、生成人工知能の開発に基づいて継続的に改善する必要があると考えています。

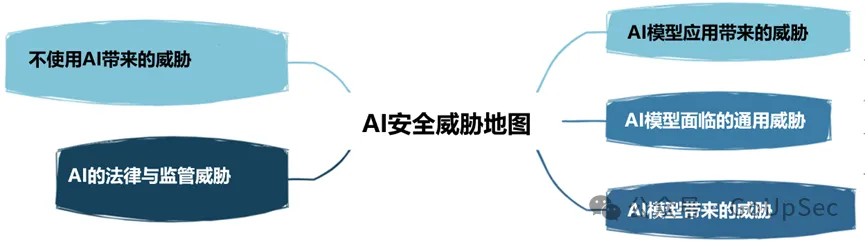

OWASP は、AI セキュリティの脅威を次の 5 つのタイプに分類します。

5. 人工知能プロジェクトのビジネス ケース

クラウド コンピューティングと同様に、ほとんどの企業は、生成人工知能や大規模言語モデルなどの新しいテクノロジを適用するための一貫した戦略的なビジネス ケースを実際には開発していません。盲目的にトレンドに従い、誇大宣伝に陥るのは簡単です。健全なビジネスケースがなければ、エンタープライズ AI アプリケーションは貧弱な結果を生み出し、リスクを増大させる可能性があります。

6. ガバナンス

ガバナンスがなければ、企業は人工知能に対する説明責任のメカニズムと明確な目標を確立できません。 OWASP チェックリストは、企業が人工知能アプリケーション用の RACI チャート (責任割り当てマトリックス) を作成し、リスク責任とガバナンス タスクを記録して割り当て、企業全体の人工知能ポリシーとプロセスを確立することを推奨しています。

7. 法的

人工知能テクノロジーの急速な発展に伴い、その法的影響は過小評価できず、企業に重大な財務的および評判上のリスクをもたらす可能性があります。

人工知能の法務には、人工知能製品の保証、人工知能エンドユーザー使用許諾契約書 (EULA)、人工知能ツールを使用して開発されたコードの所有権、知的財産リスク、契約上の補償条項などの一連の活動が含まれます。等つまり、生成 AI と大規模言語モデルを使用する際に、企業が実施する必要があるさまざまなサポート法的活動を法務チームまたは専門家が理解していることを確認してください。

8. 監督

EU の人工知能法など、人工知能に関する規制も急速に発展しており、他の国や地域でも間もなく導入される予定です。企業は、従業員の監視など、自国の AI コンプライアンス要件を理解し、AI ベンダーがデータをどのように保存および削除し、その使用を規制するかを明確に理解する必要があります。

9. 大規模言語モデル ソリューションの使用または実装

大規模言語モデル ソリューションの使用には、特定のリスクと制御を考慮する必要があります。 OWASP チェックリストには、アクセス制御、トレーニング パイプライン セキュリティ、マッピング データ ワークフロー、大規模な言語モデル モデルとサプライ チェーンにおける既存または潜在的な脆弱性の理解などの項目がリストされています。さらに、初期および継続的に、サードパーティの監査、侵入テスト、さらにはベンダーのコードレビューも必要となります。

10. テスト、評価、検証、検証 (TEVV)

TEVV プロセスは、NIST が人工知能フレームワークで特に推奨しているプロセスです。これには、AI モデルのライフサイクル全体にわたる継続的なテスト、評価、検証、検証の確立と、AI モデルの機能、安全性、信頼性に関する実行指標の提供が含まれます。

11. モデル カードとリスク カード

大規模な言語モデルを倫理的に導入するために、OWASP チェックリストでは、ユーザーが AI システムを理解し信頼できるようにするためのモデル カードとリスク カードを使用することが企業に求められています。 、偏見やプライバシーなどの潜在的なマイナスの影響に公的に対処します。

これらのカードには、モデルの詳細、アーキテクチャ、トレーニング データ メソッド、パフォーマンス メトリックなどの項目を含めることができます。責任ある AI に対する考慮事項と、公平性と透明性に関する懸念も強調されています。

12RAG: 大規模言語モデルの最適化

検索拡張生成 (RAG) は、特定のソースから関連データを取得する大規模言語モデルの機能を最適化する方法です。これは、事前トレーニングされたモデルを最適化するか、新しいデータに基づいて既存のモデルを再トレーニングしてパフォーマンスを向上させる方法の 1 つです。 OWASP は、企業が大規模な言語モデルの価値と有効性を最大化するために RAG を実装することを推奨しています。

13.AI レッド チーム

最後に、OWASP チェックリストは、AI システムに対する敵対的攻撃をシミュレートして脆弱性を特定し、既存の制御と防御を検証する AI レッド チームの重要性を強調しています。 OWASP は、レッド チームが生成 AI と大規模言語モデルを備えた包括的なセキュリティ ソリューションの不可欠な部分であるべきだと強調しています。

企業は、ポリシー違反や法的トラブルに巻き込まれることを避けるために、外部の生成 AI および大規模言語モデル ベンダーのレッド チーム サービスとシステム要件と機能を明確に理解する必要があることも注目に値します。

以上がOWASP が大規模言語モデルのネットワーク セキュリティとガバナンスのチェックリストをリリースの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。