テクノロジー周辺機器

テクノロジー周辺機器 AI

AI AIの最下層に侵入せよ! NUS Youyang のチームは拡散モデルを使用してニューラル ネットワーク パラメーターを構築しており、LeCun はそれを気に入っています

AIの最下層に侵入せよ! NUS Youyang のチームは拡散モデルを使用してニューラル ネットワーク パラメーターを構築しており、LeCun はそれを気に入っていますAIの最下層に侵入せよ! NUS Youyang のチームは拡散モデルを使用してニューラル ネットワーク パラメーターを構築しており、LeCun はそれを気に入っています

拡散モデルは、主要な新しいアプリケーションの到来をもたらしました -

Sora がビデオを生成するのと同じように、ニューラル ネットワークのパラメーターを生成し、AI の最下層に直接浸透します。

これは、シンガポール国立大学の You Yang 教授のチームと UCB、メタ AI 研究所、その他の機関による最新のオープンソース研究結果です。

具体的には、研究チームはニューラル ネットワーク パラメーターを生成するための拡散モデル p(arameter)-diff を提案しました。

これを使用してネットワーク パラメーターを生成すると、速度は直接トレーニングよりも最大 44 倍速く、パフォーマンスも劣りません。

このモデルがリリースされると、すぐに AI コミュニティで激しい議論が巻き起こり、サークルの専門家たちは、一般の人が Sora を見たときと同じように、このモデルに対して驚くべき態度を示しました。

これは基本的にAIが新しいAIを生み出すのと同じだ、と真っ向から叫ぶ人もいた。

AI の巨人 LeCun も、その結果を見て、本当にかわいいアイデアだと称賛しました。

実は、p-diff も Sora と同じ重要性を持っており、同じ研究室の Fuzhao Xue 博士 (Xue Fuzhao) が詳しく説明しています:

Sora は高次元データ、つまりビデオを生成し、Sora をワールド シミュレーター (1 次元からの AGI に近い) にします。

そして、この取り組みであるニューラル ネットワークの普及は、モデル内でパラメーターを生成することができ、別の新しい重要な次元から AGI に向けて移行する、メタワールドクラスの学習者/オプティマイザーになる可能性を秘めています。

本題に戻りますが、p-diff はどのようにしてニューラル ネットワーク パラメーターを生成するのでしょうか?

オートエンコーダと拡散モデルの組み合わせ

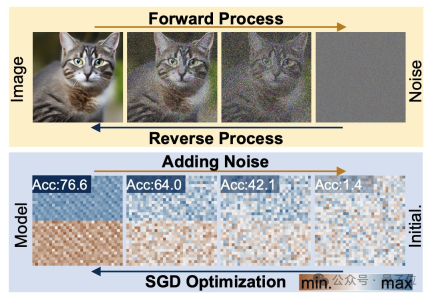

この問題を明確にするには、まず拡散モデルとニューラル ネットワークの動作特性を理解する必要があります。

拡散生成プロセスは、ランダムな分布から高度に特異的な分布への変換であり、複合ノイズの追加により、視覚情報は単純なノイズ分布に削減されます。

ニューラル ネットワークのトレーニングもこの変換プロセスに従い、ノイズの追加によって劣化する可能性があります。この機能に触発されて、研究者は p-diff 法を提案しました。

構造的な観点から見ると、p-diff は標準的な潜在拡散モデルに基づいて研究チームによって設計され、オートエンコーダーと組み合わせられています。

研究者はまず、トレーニングされ良好に実行されたネットワーク パラメーターの一部を選択し、それらを 1 次元ベクトル形式に展開します。

次に、オートエンコーダーを使用して、拡散モデルのトレーニング データとして 1 次元ベクトルから潜在表現を抽出します。これにより、元のパラメーターの主要な特徴を捉えることができます。

研究者らは、トレーニング プロセス中に、順方向および逆方向のプロセスを通じて p-diff にパラメータの分布を学習させ、完了後、拡散モデルは、視覚情報を生成するプロセスと同様に、ランダム ノイズからこれらの潜在的な表現を合成します。

最後に、新しく生成された潜在表現は、エンコーダーに対応するデコーダーによってネットワーク パラメーターに復元され、新しいモデルの構築に使用されます。

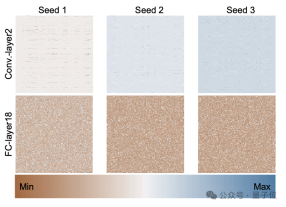

次の図は、p-diff を通じて 3 つのランダム シードを使用して最初からトレーニングされた ResNet-18 モデルのパラメーター分布であり、異なる層と同じ層間の違いを示しています。 . パラメータ間の分布パターン。

p-diff によって生成されたパラメータの品質を評価するために、研究者らは 8 つのデータセットに対してそれぞれ 2 サイズの 3 種類のニューラル ネットワークを使用してテストを行いました。

以下の表で、各グループの 3 つの数字は、元のモデル、統合モデル、および p-diff で生成されたモデルの評価結果を表します。

結果からわかるように、p-diff によって生成されたモデルのパフォーマンスは、基本的に手動でトレーニングされた元のモデルに近いか、それよりも優れています。

効率という点では、精度を損なうことなく、p-diff は従来のトレーニングよりも 15 倍速く ResNet-18 ネットワークを生成し、44 倍速く Vit-Base を生成します。

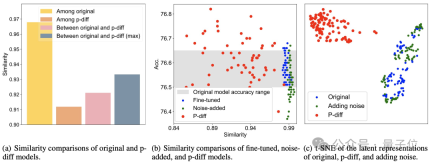

追加のテスト結果は、p-diff によって生成されたモデルがトレーニング データとは大きく異なることを示しています。

下図 (a) からわかるように、p-diff によって生成されたモデル間の類似度は、元のモデル間の類似度、および p-diff と元のモデル間の類似度よりも低くなります。モデル。

(b)と(c)から、微調整やノイズ付加手法と比較して、p-diffの類似性も低いことがわかります。

これらの結果は、p-diff がトレーニング サンプルを単に記憶するのではなく、実際に新しいモデルを生成することを示しており、優れた汎化能力を備えており、トレーニング データとは異なる新しいモデルを生成できることも示しています。

現在、p-diff のコードはオープンソース化されているので、興味のある方は GitHub で確認してみてください。

論文アドレス: https://arxiv.org/abs/2402.13144

GitHub: https ://github.com/NUS-HPC-AI-Lab/Neural-Network-Diffusion

以上がAIの最下層に侵入せよ! NUS Youyang のチームは拡散モデルを使用してニューラル ネットワーク パラメーターを構築しており、LeCun はそれを気に入っていますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

Huggingface smollmであなたの個人的なAIアシスタントを構築する方法Apr 18, 2025 am 11:52 AM

Huggingface smollmであなたの個人的なAIアシスタントを構築する方法Apr 18, 2025 am 11:52 AMオンデバイスAIの力を活用:個人的なチャットボットCLIの構築 最近では、個人的なAIアシスタントの概念はサイエンスフィクションのように見えました。 ハイテク愛好家のアレックスを想像して、賢くて地元のAI仲間を夢見ています。

メンタルヘルスのためのAIは、スタンフォード大学でのエキサイティングな新しいイニシアチブによって注意深く分析されますApr 18, 2025 am 11:49 AM

メンタルヘルスのためのAIは、スタンフォード大学でのエキサイティングな新しいイニシアチブによって注意深く分析されますApr 18, 2025 am 11:49 AMAI4MHの最初の発売は2025年4月15日に開催され、有名な精神科医および神経科学者であるLuminary Dr. Tom Insel博士がキックオフスピーカーを務めました。 Insel博士は、メンタルヘルス研究とテクノでの彼の傑出した仕事で有名です

2025年のWNBAドラフトクラスは、成長し、オンラインハラスメントの成長と戦いに参加しますApr 18, 2025 am 11:44 AM

2025年のWNBAドラフトクラスは、成長し、オンラインハラスメントの成長と戦いに参加しますApr 18, 2025 am 11:44 AM「私たちは、WNBAが、すべての人、プレイヤー、ファン、企業パートナーが安全であり、大切になり、力を与えられたスペースであることを保証したいと考えています」とエンゲルバートは述べ、女性のスポーツの最も有害な課題の1つになったものに取り組んでいます。 アノ

Pythonビルトインデータ構造の包括的なガイド-AnalyticsVidhyaApr 18, 2025 am 11:43 AM

Pythonビルトインデータ構造の包括的なガイド-AnalyticsVidhyaApr 18, 2025 am 11:43 AM導入 Pythonは、特にデータサイエンスと生成AIにおいて、プログラミング言語として優れています。 大規模なデータセットを処理する場合、効率的なデータ操作(ストレージ、管理、アクセス)が重要です。 以前に数字とstをカバーしてきました

Openaiの新しいモデルからの代替案からの第一印象Apr 18, 2025 am 11:41 AM

Openaiの新しいモデルからの代替案からの第一印象Apr 18, 2025 am 11:41 AM潜る前に、重要な注意事項:AIパフォーマンスは非決定論的であり、非常にユースケース固有です。簡単に言えば、走行距離は異なる場合があります。この(または他の)記事を最終的な単語として撮影しないでください。これらのモデルを独自のシナリオでテストしないでください

AIポートフォリオ| AIキャリアのためにポートフォリオを構築する方法は?Apr 18, 2025 am 11:40 AM

AIポートフォリオ| AIキャリアのためにポートフォリオを構築する方法は?Apr 18, 2025 am 11:40 AM傑出したAI/MLポートフォリオの構築:初心者と専門家向けガイド 説得力のあるポートフォリオを作成することは、人工知能(AI)と機械学習(ML)で役割を確保するために重要です。 このガイドは、ポートフォリオを構築するためのアドバイスを提供します

エージェントAIがセキュリティ運用にとって何を意味するのかApr 18, 2025 am 11:36 AM

エージェントAIがセキュリティ運用にとって何を意味するのかApr 18, 2025 am 11:36 AM結果?燃え尽き症候群、非効率性、および検出とアクションの間の隙間が拡大します。これは、サイバーセキュリティで働く人にとってはショックとしてはありません。 しかし、エージェントAIの約束は潜在的なターニングポイントとして浮上しています。この新しいクラス

Google対Openai:学生のためのAIの戦いApr 18, 2025 am 11:31 AM

Google対Openai:学生のためのAIの戦いApr 18, 2025 am 11:31 AM即時の影響と長期パートナーシップ? 2週間前、Openaiは強力な短期オファーで前進し、2025年5月末までに米国およびカナダの大学生にChatGpt Plusに無料でアクセスできます。このツールにはGPT ‑ 4o、Aが含まれます。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

SublimeText3 中国語版

中国語版、とても使いやすい

MinGW - Minimalist GNU for Windows

このプロジェクトは osdn.net/projects/mingw に移行中です。引き続きそこでフォローしていただけます。 MinGW: GNU Compiler Collection (GCC) のネイティブ Windows ポートであり、ネイティブ Windows アプリケーションを構築するための自由に配布可能なインポート ライブラリとヘッダー ファイルであり、C99 機能をサポートする MSVC ランタイムの拡張機能が含まれています。すべての MinGW ソフトウェアは 64 ビット Windows プラットフォームで実行できます。

ドリームウィーバー CS6

ビジュアル Web 開発ツール

mPDF

mPDF は、UTF-8 でエンコードされた HTML から PDF ファイルを生成できる PHP ライブラリです。オリジナルの作者である Ian Back は、Web サイトから「オンザフライ」で PDF ファイルを出力し、さまざまな言語を処理するために mPDF を作成しました。 HTML2FPDF などのオリジナルのスクリプトよりも遅く、Unicode フォントを使用すると生成されるファイルが大きくなりますが、CSS スタイルなどをサポートし、多くの機能強化が施されています。 RTL (アラビア語とヘブライ語) や CJK (中国語、日本語、韓国語) を含むほぼすべての言語をサポートします。ネストされたブロックレベル要素 (P、DIV など) をサポートします。

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境