ホームページ >テクノロジー周辺機器 >AI >警告!長距離LiDARセンシング

警告!長距離LiDARセンシング

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2024-02-02 11:33:311141ブラウズ

1. はじめに

昨年ツーソン AI デイが開催された後、私は常に遠距離知覚に関する研究をテキスト形式で要約したいと考えていました。最近たまたま時間ができたので、ここ数年の研究過程を記録するために記事を書くことにしました。この記事で取り上げた内容は、Tucson AI Day ビデオ [0] および公開論文に含まれていますが、特定のエンジニアリングの詳細や技術的秘密は含まれていません。

ご存知のとおり、ツーソンはトラックの自動運転技術に重点を置いています。トラックは乗用車に比べて制動距離が長く、車線変更も長くなります。その結果、ツーソンは他の自動運転企業と競争する上で独自の優位性を持っています。私はツーソンの一員としてLiDARセンシング技術を担当していますが、今回はLiDARを長距離センシングに活用する関連内容を詳しく紹介していきます。

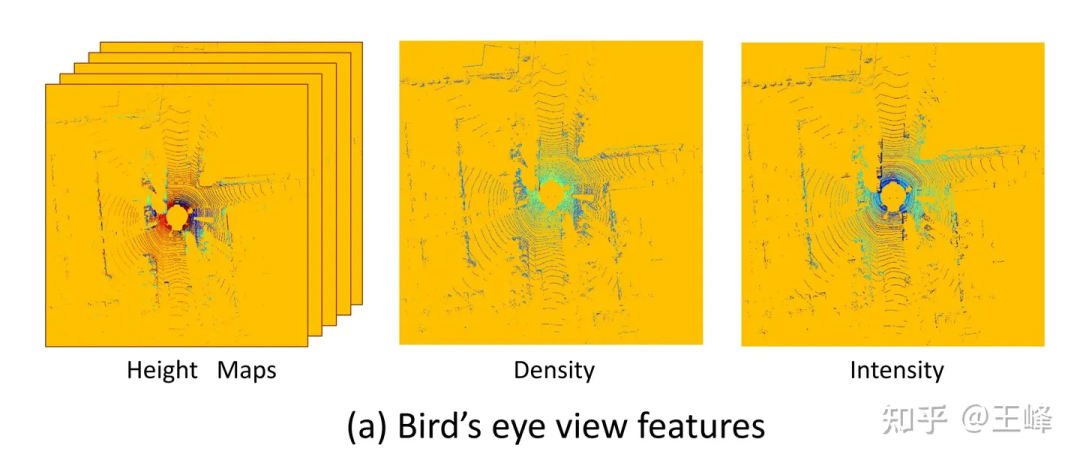

同社が最初に参加したとき、主流の LiDAR センシング ソリューションは通常、BEV (Bird's Eye View) ソリューションでした。ただし、ここでの BEV は、よく知られている Battery Electric Vehicle の略称ではなく、LiDAR 点群を BEV 空間に投影し、ターゲット検出のために 2D コンボリューションと 2D 検出ヘッドを組み合わせたソリューションを指します。私個人としては、テスラが採用しているLiDARセンシング技術は「BEV分野における多視点カメラの融合技術」と呼ぶべきだと考えている。 私の知る限り、BEV ソリューションに関する最も古い記録は、Baidu が CVPR17 カンファレンスで発表した論文「MV3D」です [1]。私が知っている多くの企業で実際に使用されているソリューションを含む、その後の多くの研究成果は、ターゲット検出のために LiDAR 点群を BEV 空間に投影する方法を採用しており、BEV ソリューションとして分類できます。このソリューションは実際のアプリケーションで広く使用されています。 要約すると、私が最初に入社したとき、主流の LiDAR センシング ソリューションは通常、LiDAR 点群を BEV 空間に投影し、ターゲット検出のために 2D コンボリューションと 2D 検出ヘッドを組み合わせていました。テスラが採用するLiDARセンシング技術は、「BEV空間における多視点カメラの融合技術」ともいえる。 CVPR17 カンファレンスで Baidu が発表した論文「MV3D」は BEV ソリューションの初期の記録であり、その後、多くの企業が同様のソリューションをターゲット検出に採用しました。

MV3D で使用される BEV パースペクティブ機能[1]

MV3D で使用される BEV パースペクティブ機能[1]

BEV スキームの大きな利点の 1 つは、成熟した 2D 検出器を直接適用できることですが、致命的な問題もあります。欠点: 認識できる範囲が制限されます。上の図からわかるように、2D 検出器を使用するため、2D 特徴マップを形成する必要があります。このとき、距離のしきい値を設定する必要があります。実際には、範囲外の LiDAR ポイントがまだ存在します。上の図では、この切り捨て操作によって破棄されました。場所がカバーされるまで距離のしきい値を増やすことはできますか?これを行うことは不可能ではありませんが、LiDAR はスキャン モード、反射強度 (距離の 4 乗で減衰)、オクルージョンなどの問題により、遠くにある点群が非常に少ないため、費用対効果が高くありません。

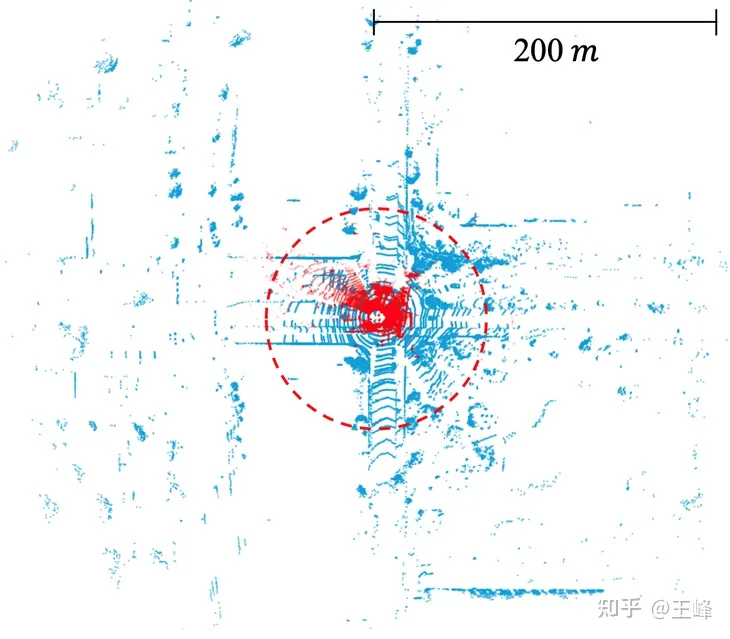

学術コミュニティは、主にデータセットの制限により、BEV スキームのこの問題にあまり注目してきませんでした。現在主流のデータセットのアノテーション範囲は通常 80 メートル未満 (nuScenes の 50 メートル、KITTI の 70 メートル、Waymo の 80 メートルなど) この距離範囲内では、BEV 特徴マップのサイズは大きくする必要はありません。しかし、産業界では、一般に使用される中距離LiDARは200メートルの走査範囲を達成でき、近年では500メートルの走査範囲を達成できる長距離LiDARもいくつかリリースされています。なお、特徴マップの面積と計算量は、距離が離れるにつれて二次関数的に増加する。 BEV スキームでは、500 メートルの範囲はもちろんのこと、200 メートルの範囲を処理するのに必要な計算量はすでに膨大です。したがって、この問題には業界でのさらなる注目と解決が必要です。

公開データセット内の LIDAR のスキャン範囲。 KITTI (赤い点、70 メートル) 対 Argoverse 2 (青い点、200 メートル)

BEV ソリューションの限界を認識した後、長年の研究を経て、ついに実現可能な代替案を見つけました。研究のプロセスは簡単ではなく、多くの挫折を経験しました。一般的に論文やレポートでは成功ばかりが強調され、失敗については触れられませんが、失敗の経験も非常に貴重です。そこで、私たちは研究の旅をブログを通じて共有することにしました。以下、時系列に沿って順を追って説明していきます。

2. 点ベースのソリューション

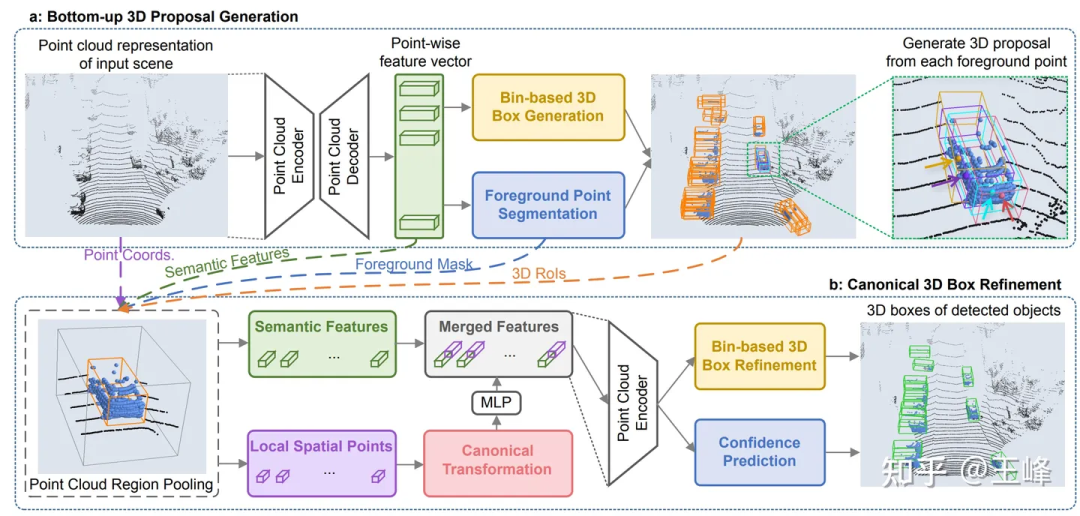

CVPR19 で、Hong Kong Chinese は PointRCNN[2] と呼ばれる点群検出器を公開しました。従来の手法とは異なり、PointRCNN は点群データを BEV (鳥瞰図) 形式に変換せずに直接計算を実行します。したがって、この点群ベースのソリューションは理論的には長距離センシングを実現できます。

しかし、試してみると問題が見つかりました。KITTI の 1 フレーム内の点群の数は、検出のためにポイントをあまり損失することなく 16,000 ポイントまでダウンサンプリングできます。しかし、当社の LiDAR の組み合わせでは 1 フレームに 100,000 点以上の点があります。 10 倍のダウンサンプリングは明らかに検出精度に大きな影響を与えます。ダウンサンプリングを行わない場合、PointRCNN のバックボーンには O(n^2) 個の演算も存在するため、bev はかかりませんが、それでも耐えられないほどの計算量になります。これらの時間のかかる操作は、主に点群自体の無秩序な性質が原因であり、ダウンサンプリングであっても近傍検索であっても、すべての点を走査する必要があることを意味します。多くの操作が関係しており、それらはすべて最適化されていない標準的な操作であるため、短期的にリアルタイムに最適化する見込みはなく、このルートは放棄されました。

しかし、この研究は無駄ではなく、バックボーンの計算量は膨大ですが、その第2段階はフォアグラウンドでのみ行われるため、計算量はまだ比較的少ないです。 PointRCNN の第 2 段階を BEV 方式の第 1 段階検出器に直接適用すると、検出フレームの精度が大幅に向上します。申請プロセス中に小さな問題も発見しました。解決した後、それを要約し、CVPR21 に掲載された記事 [3] として公開しました。このブログでも確認できます:

王峰: LiDAR R-CNN: 高速かつ多用途の 2 段階 3D 検出器

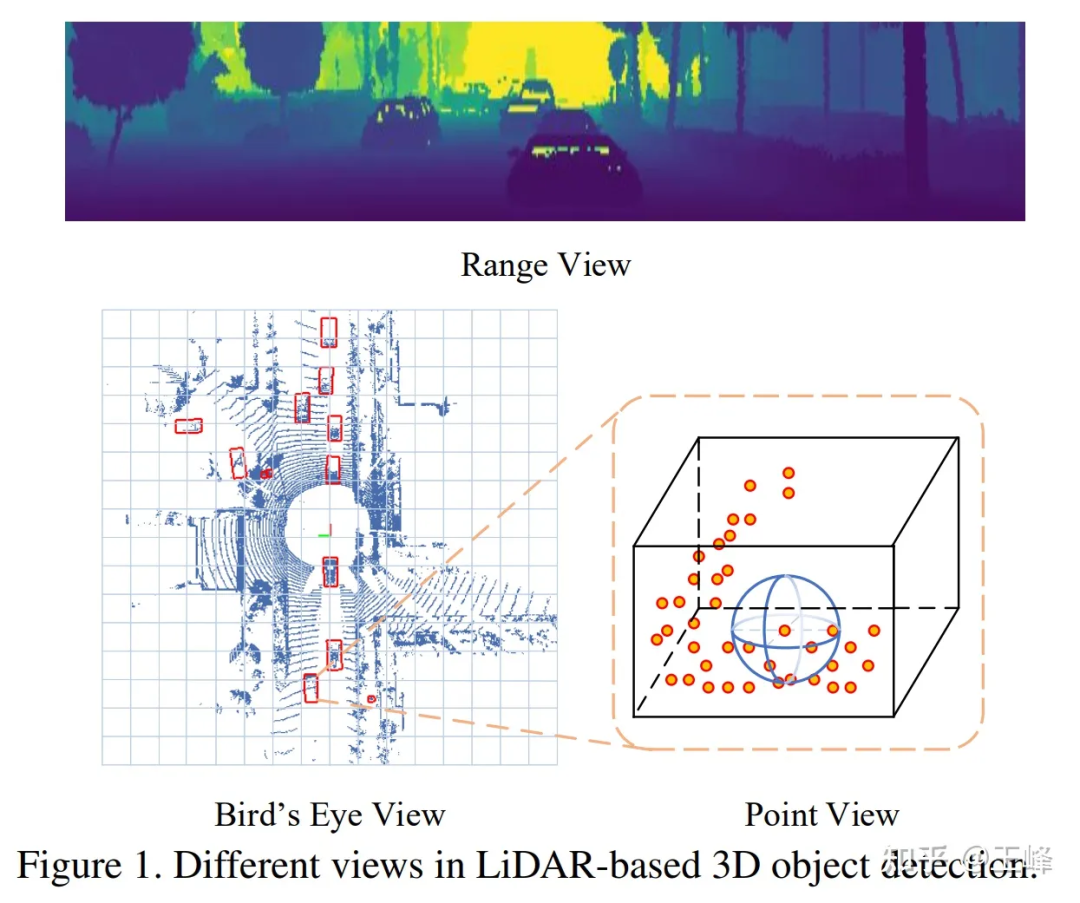

3. レンジビュー方式

ポイントベースの方式が失敗した後、私たちは次のように考えました。 Range View に注目しました。当時の LiDAR はすべて機械的に回転していました。たとえば、64 ラインの LiDAR は、異なるピッチ角を持つ 64 行の点群をスキャンします。たとえば、各行が 2048 個の点をスキャンすれば、十分です。フォーム64*2048 の範囲画像。

RV、BEV、PV の比較

RV、BEV、PV の比較

レンジ ビューでは、点群がまばらではなく密に配置され、遠くのターゲットが距離画像に表示されます。は比較的小さいですが、破棄されないため、理論的には検出できます。

画像に近いためか、RV の研究は実際には BEV よりも早いです。私が見つけた最も古い記録も百度の論文 [4] です。百度は実際には自治軍の黄埔陸軍士官学校です。 RV と BEV の両方の初期のアプリケーションは Baidu から提供されました。

そこで何気なく試してみたのですが、BEV方式に比べてRVのAPは30~40ポイントも落ちてしまいました…2次元距離画像の検出はかなり良いことが分かりましたが、出力 3D フレームは非常に貧弱です。当時、RV の特性を分析したところ、オブジェクトのスケールが不均一であること、前景と背景の特徴が混在していること、遠距離のターゲットの特徴が不明瞭であることなど、画像の欠点がすべて揃っていると感じられました。画像の豊富なセマンティック機能が利点であるため、当時私はこのソリューションについて比較的悲観的でした。

結局のところ、正社員は実装作業を行う必要があるため、そのような探索的な質問はインターンに任せたほうがよいでしょう。その後、この問題を一緒に研究するために 2 人のインターンが採用されました。彼らは公開データ セットでそれを試しましたが、案の定、彼らも 30 点を失いました…幸いなことに、2 人のインターンの方が有能でした。一連の努力と参照を通じて、その他 論文の細部を修正した後、主流の BEV 方式と同様のレベルにポイントをまとめ、最終論文は ICCV21 に掲載されました [5]。

ポイントは増加しましたが、問題は完全に解決されたわけではなく、信号対雑音比を改善するには LIDAR にはマルチフレーム フュージョンが必要であるということが当時のコンセンサスになりました。ターゲットのポイントは少ないため、フレームを積み重ねてポイントの数を増やす必要があります。 BEV ソリューションでは、マルチフレーム フュージョンは非常に簡単です。入力された点群にタイムスタンプを追加し、複数のフレームを重ね合わせるだけです。ネットワーク全体は変更せずにポイントを増やすことができます。しかし、RV では、多くのトリックが変更され、何も達成されていないが、同様の効果がある。

そしてこの時点で、LiDAR はハードウェア技術ソリューションの観点からも機械的回転から固体/半固体へと移行しており、ほとんどの固体/半固体 LiDAR は距離画像を形成できず、強制的に距離を構築することができません。 . 画像は情報を失うため、このパスは最終的に放棄されました。

4. スパースボクセルスキーム

前述したように、ポイントベースのスキームの問題は、点群が不規則に配置されているため、ダウンサンプリングなどの問題のためにトラバースが必要になることです。すべての点群では計算負荷が高くなりすぎますが、BEV スキームではデータは整理されていますが空白領域が多すぎるため、計算負荷が高くなりすぎます。この 2 つを組み合わせて、点線の領域ではボクセル化を実行して規則的にし、点線のない領域では無効な計算を防ぐために表現を行わないことが実現可能なパスと思われます。

SECOND[6] の著者である Yan Yan がツーソンに入社したため、初期の頃は sparse conv のバックボーンを試しましたが、spconv は標準の op ではないため、自分たちで実装した spconv はまだ合格していました。リアルタイムで検出するには十分に遅く、場合によっては密な conv よりも遅いため、当面は脇に置かれました。

その後、500m をスキャンできる最初の LiDAR: Livox Tele15 が到着し、長距離 LiDAR センシング アルゴリズムが目前に迫ってきました。BEV ソリューションを試しましたが、高すぎたので、spconv ソリューションを再度試しました。 Tele15 の fov は比較的狭く、遠くにある点群も非常にまばらであるため、spconv はしばらくの間、リアルタイム パフォーマンスをほとんど達成できません。

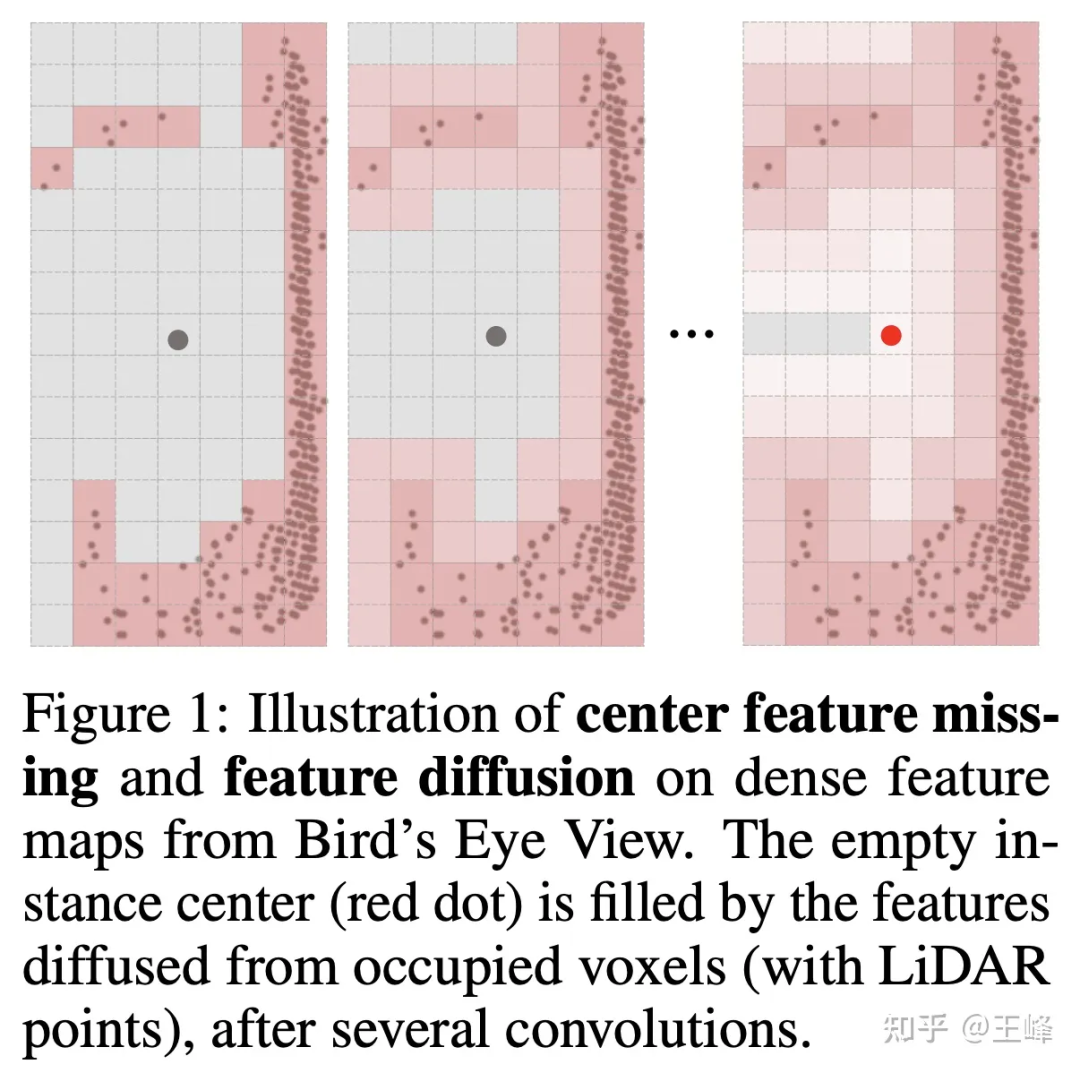

しかし、bev で撮影しない場合、検出ヘッドは 2D 検出でより成熟したアンカーまたは中心割り当てを使用できません。これは主に、LIDAR がオブジェクトの表面をスキャンし、中心位置が必ずしも点であるとは限らないためです。 (下の図に示すように) (図に示すように)、点なしで前景ターゲットを割り当てることは当然不可能です。実際、私たちは社内で多くの assign メソッドを試してきました。ここでは会社で使用されている実際のメソッドについては詳しく説明しません。インターンも assign スキームを試し、それを NIPS2022 [7] で公開しました。彼の解釈を読むことができます。:

明月不知無愿:完全にスパースな 3D オブジェクト検出器

しかし、このアルゴリズムを 500 メートル前方、後方、そして 150 メートルの LiDAR の組み合わせを適用したい場合は、左右ともまだ足りないです。たまたま、インターン生は人気を追う前に Swin Transformer のアイデアを参考にして Sparse Transformer の記事を書いていました [8]。また、20 点以上から少しずつブラッシュアップするのに大変な労力がかかりました (ありがとう)指導してくださったインターンさんへ、tql ) 当時、私は Transformer 法がまだ不規則な点群データに非常に適していると感じたので、会社のデータセットでも試してみました。

残念ながら、この手法は、同社のデータセットでは常に BEV 手法に勝てず、その差は 5 ポイント近くあります。今振り返ると、まだ私が理解していないコツやトレーニング手法があるかもしれません。 Transformer の表現力は conv に劣らないのは当然ですが、その後は試しませんでした。しかし、この時点で、assign メソッドが最適化され、多くの計算量が削減されたため、もう一度 spconv を試してみたかったのですが、驚くべき結果は、Transformer を直接 spconv に置き換えることで、近距離では BEV メソッドと同等の精度を達成できるということでした。 . なんと、遠距離の目標も探知できます。

Yan Yan が spconv[9] の 2 番目のバージョンを作成したのもこの時期でした。速度が大幅に向上したため、計算遅延がボトルネックではなくなりました。最終的に、長距離 LiDAR 認識によりすべての障害が解消されました。リアルタイムで車上で走行できるようになりました。

その後、LiDAR の配置を更新し、スキャン範囲を前方 500m、後方 300m、左右 150m に拡大しました。このアルゴリズムも良好に動作します。今後の継続的な計算能力の向上により、期待しています。 、コンピューティングの遅延はますます問題ではなくなります。

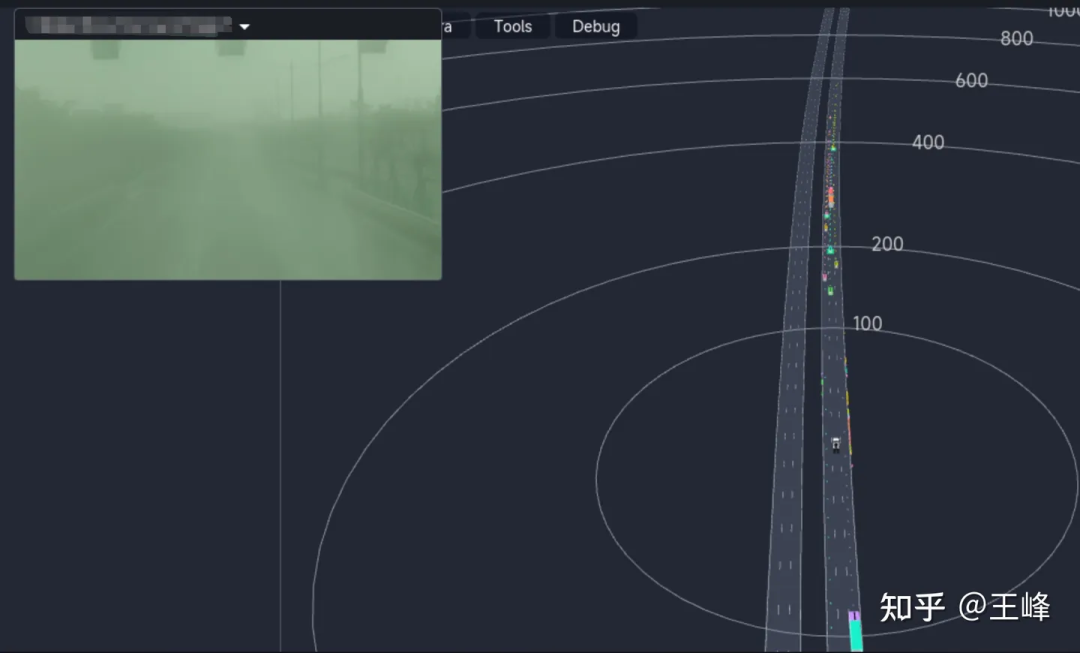

最終的な長距離検出効果は以下に示されています。また、ツーソン AI デーのビデオの 01:08:30 付近の位置を見て、動的検出効果を確認することもできます:

5. 追記

ポイントベースの手法から距離画像手法、Transformerやスパースボクセルに基づくスパースconv手法まで、長尺の探索・距離感 順風満帆とは言えず、まさに茨の道でした。最終的に、私たちがこのステップを達成できたのは、コンピューティング能力の継続的な向上と多くの同僚の継続的な努力のおかげです。ツーソンの主任科学者、ワン・ナイヤンとツーソンのすべての同僚とインターンに感謝したいと思います。アイデアとエンジニアリングの実装のほとんどは私が行ったものではありません。とても恥ずかしいです。それらはむしろ、過去と未来をつなぐ役割を果たしています。」 こんなに長い記事を書くのは久しぶりで、感動的なストーリーを形成することなく、ただの記録のように書きました。近年、L4 を行うことを主張する同僚はますます少なくなり、L2 の同僚は徐々に純粋に視覚的な研究に目を向けるようになりました。LiDAR の認識は、肉眼で見えるように徐々に疎外されてきていますが、私は直接測距センサーをもう 1 つ増やしたほうが良いと今でも強く信じています。選択の選択、しかし、業界関係者はますます反対しているようです。鮮血の履歴書でBEVやOccupancyを目にする機会が増えてくると、LiDARセンシングはいつまで続くのか、どこまで粘れるのか、記念も兼ねてこんな記事を書いてみます。 夜遅くに涙が出てきて、何を言っているのか分かりません、ごめんなさい。以上が警告!長距離LiDARセンシングの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。