ホームページ >テクノロジー周辺機器 >AI >特定の層のコンポーネントの 90% 以上が削除されても、トランス モデルの次元削減は減少し、LLM のパフォーマンスは変わりません。

特定の層のコンポーネントの 90% 以上が削除されても、トランス モデルの次元削減は減少し、LLM のパフォーマンスは変わりません。

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-12-28 15:44:20943ブラウズ

大規模モデルの時代では、Transformer だけで科学研究分野全体をサポートします。リリース以来、Transformer ベースの言語モデルは、さまざまなタスクで優れたパフォーマンスを実証してきました。基盤となる Transformer アーキテクチャは、自然言語モデリングと推論において最先端のものとなり、コンピューター ビジョンなどの分野でも有望であることが示されています。

#現在の Transformer アーキテクチャは非常に大規模で、通常、トレーニングと推論に多くのコンピューティング リソースを必要とします。

これは意図的です。これは、より多くのパラメーターまたはデータを使用してトレーニングされた Transformer が他のモデルよりも明らかに能力が高いためです。それにもかかわらず、Transformer ベースのモデルやニューラル ネットワークでは、学習した仮説を保存するためにすべての適合パラメーターを必要としないことが、研究の成果によって示されています。

一般的に言えば、大規模なオーバーパラメータ化はモデルをトレーニングするときに役立つように見えますが、これらのモデルは推論前に大幅に枝刈りされる可能性があります。調査によると、ニューラル ネットワークは多くの場合、有意な影響を与えることなく 90 % 以上の重みを削除できます。パフォーマンスの低下。この現象により、研究者はモデル推論に役立つ枝刈り戦略の研究に目を向けるようになりました。

MIT と Microsoft の研究者が「真実はそこにある」というタイトルの記事で報告しました驚くべき発見がなされました論文: レイヤー選択的ランキング削減による言語モデルの推論能力の向上。彼らは、Transformer モデルの特定のレイヤーで細かい枝刈りを行うと、特定のタスクにおけるモデルのパフォーマンスを大幅に向上させることができることを発見しました。

- 論文アドレス: https: //arxiv.org/pdf/2312.13558.pdf

- 紙のホームページ: https://pratyushasharma.github.io/laser/

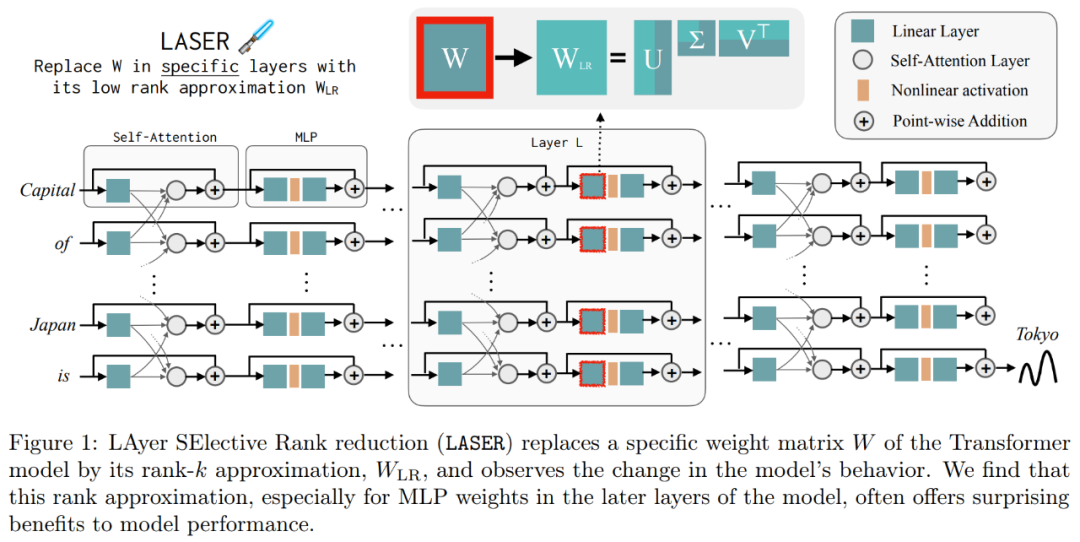

研究では、この単純な介入を LASER (LAyer SElective Rankduction) と呼んでいます。特異値分解を通じて、Transformer モデルの特定の層の学習重み行列の高次成分を選択的に削減することにより、LLM のパフォーマンスが大幅に向上します。この操作は、モデルのトレーニングが完了した後に実行でき、追加のパラメーターやデータは必要ありません

操作中に、モデル固有の重み行列とレイヤーを実行することによって重み削減が実行されます。 。この研究では、多くの同様のマトリックスが重量を大幅に削減でき、コンポーネントの 90% 以上が除去されるまでパフォーマンスの低下は一般に観察されないこともわかりました。これらの要因を減らすと、精度が大幅に向上する可能性があります。興味深いことに、この発見は自然言語だけでなく、パフォーマンスを向上させる強化学習にも当てはまり、さらに、この研究では、削除によってパフォーマンスを向上させるために、高次のコンポーネントに格納されているものを推測することも試みられています。この研究では、LASER を使用して質問に答えた後、元のモデルは主に高頻度の単語 (「the」、「of」など) を使用して応答したことがわかりました。これらの単語は正解の意味タイプとさえ一致しません。つまり、介入がなければ、これらのコンポーネントによってモデルは無関係な高頻度単語を生成します

ただし、After ではある程度ランクを下げると、モデルの答えを正しいものに変換できます。

これを理解するために、この研究では、残りのコンポーネントがそれぞれ何をエンコードしているのかも調査し、高次の特異ベクトルのみを使用して重み行列を近似しました。これらのコンポーネントは、正解と同じ意味カテゴリ内の異なる応答または共通の高頻度単語を記述していることが判明しました。

これらの結果は、ノイズの多い高次コンポーネントが低次コンポーネントと組み合わされると、それらの矛盾する応答により、不正確である可能性がある平均的な応答が生成されることを示唆しています。図 1 は、Transformer のアーキテクチャと LASER の手順を視覚的に表したものです。ここでは、多層パーセプトロン (MLP) の特定の層の重み行列が、その低ランク近似によって置き換えられます。

レーザーの概要

研究者はレーザー介入を詳細に紹介しました。シングルステップレーザー介入は 3 つのパラメータ (τ、ℓ、ρ) によって定義されます。これらのパラメータは一緒になって、低ランク近似によって置き換えられる行列と近似の次数を記述します。研究者は、介入する行列をパラメータの種類に応じて分類します。

研究者は、複数の要素から構成される行列 W = {W_q, W_k, W_v, W_o, U_in, U_out} に焦点を当てます。これは、層パーセプトロン (MLP) と注目層の行列で構成されます。レイヤーの数は研究者の介入のレベルを表し、最初のレイヤーのインデックスは 0 です。たとえば、Llama-2 は 32 レベルなので、ℓ ∈ {0, 1, 2,・・・31} と表されます。

最終的に、ρ ∈ [0, 1) は、低ランクの近似を行うときに最大ランクのどの部分を保存する必要があるかを示します。たとえば、 と仮定すると、行列の最大ランクは d です。研究者らはこれを ⌊ρ・d⌋- 近似に置き換えました。

と仮定すると、行列の最大ランクは d です。研究者らはこれを ⌊ρ・d⌋- 近似に置き換えました。

#以下は必須です 以下の図 1 に、LASER の例を示します。図中の記号 τ = U_in および ℓ = L は、MLP の第 1 層の重み行列が L 層の Transformer ブロックで更新されることを示します。ランク k 近似の k 値を制御するために使用されるパラメータもあります。

レーザー法は、そのような介入を単に探索し、最大の利益をもたらすように修正されたものです。ただし、これらの介入を組み合わせる方法は他にもたくさんあり、それが今後の研究の方向性となります。

レーザー法は、そのような介入を単に探索し、最大の利益をもたらすように修正されたものです。ただし、これらの介入を組み合わせる方法は他にもたくさんあり、それが今後の研究の方向性となります。

実験結果

実験部分では、研究者は PILE データセットで事前トレーニングされた GPT-J モデルを使用しました。レイヤー数は27、パラメータは60億通りです。次に、モデルの動作が CounterFact データセットで評価されます。このデータセットには、(トピック、関係、回答) トリプルのサンプルが含まれており、質問ごとに 3 つの言い換えプロンプトが提供されます。

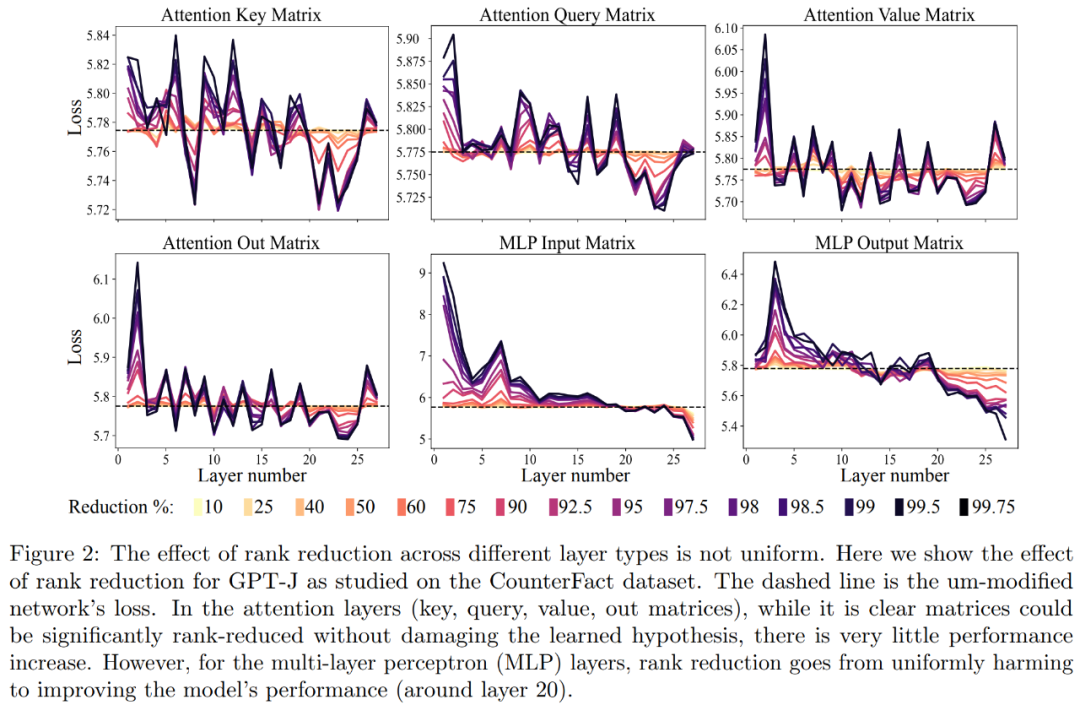

まず、CounterFact データセット上の GPT-J モデルを分析しました。図 2 は、Transformer アーキテクチャの各行列にさまざまな量のランク削減を適用した後のデータセットの分類損失への影響を示しています。各 Transformer レイヤーは、入力行列と出力行列が個別に示された 2 層の小さな MLP で構成されています。異なる色は、除去されたコンポーネントの異なるパーセンテージを表します。

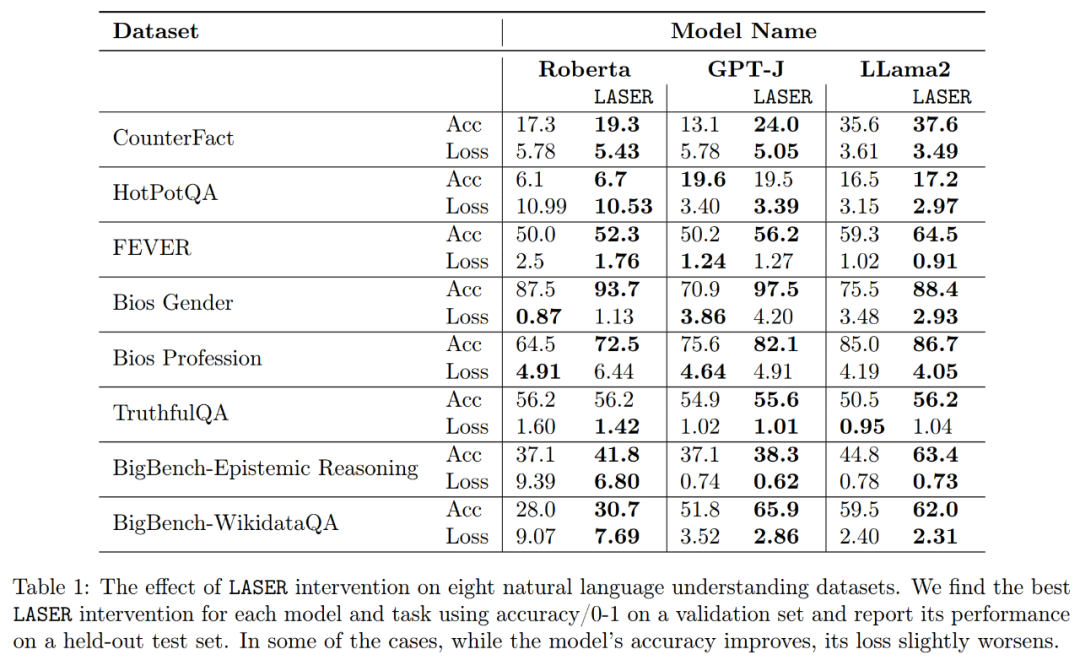

上の図 2 と下の表 1 に示すように、解釈の精度と堅牢性の向上に関して、研究者らは、単一レイヤーでランク削減を実行すると、CounterFact データセット上の GPT-J モデルの事実精度が 13.1% から 24.0% に増加したことを発見しました。これらの改善はランクの削減の結果のみであり、モデルのさらなるトレーニングや微調整は必要ないことに注意することが重要です。

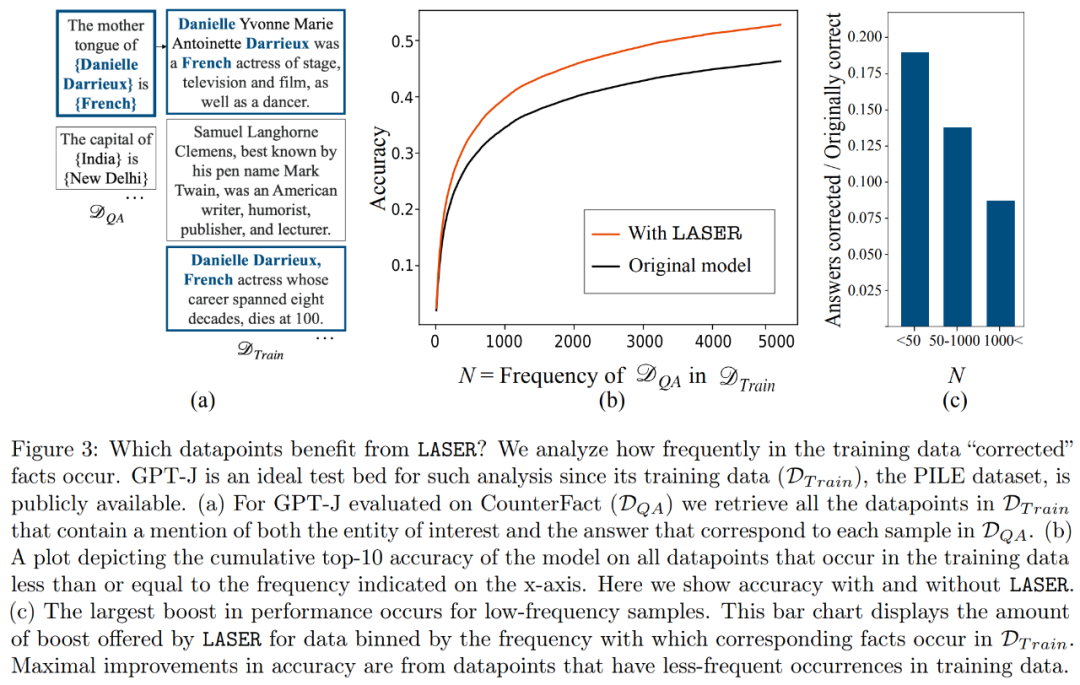

#ダウンランクリカバリを実行するとどのファクトが復元されますか?研究者らは、図 3

に示すように、ランク削減によって取得されたファクトがデータセットに現れることはほとんどないことを発見しました。コンポーネントには何が保存されますか?研究者らは、以下の図 5 (a) に示すように、(LASER のような低次成分を使用する代わりに) 高次成分を使用して最終的な重み行列を近似します。彼らは、以下の図 5 (b) に示すように、さまざまな数の高次成分を使用して行列を近似したときに、予測された答えに対する真の答えの平均コサイン類似度を測定しました。

研究者らは最終的に、複数の言語理解タスクで発見した 3 つの異なる LLM の一般化可能性を評価しました。各タスクについて、生成精度、分類精度、損失という 3 つの指標を使用してモデルのパフォーマンスを評価しました。表 1 の結果によると、行列のランクが大幅に低下した場合でも、モデルの精度が低下することはなく、むしろモデルのパフォーマンスを向上させることができます。

以上が特定の層のコンポーネントの 90% 以上が削除されても、トランス モデルの次元削減は減少し、LLM のパフォーマンスは変わりません。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。