ホームページ >テクノロジー周辺機器 >AI >新しいタイトル: Meta による Transformer アーキテクチャの改善: 推論機能を強化する新しいアテンション メカニズム

新しいタイトル: Meta による Transformer アーキテクチャの改善: 推論機能を強化する新しいアテンション メカニズム

- PHPz転載

- 2023-11-24 14:53:48866ブラウズ

大規模言語モデル (LLM) の能力は疑う余地のない事実ですが、それでも時々単純な間違いを犯し、推論能力が弱いことがわかります。

##たとえば、LLM は次のような場合があります。無関係な文脈や好み、入力プロンプトに固有の意見によって誤った判断をしてしまう。後者の状況では、モデルが入力と一貫性を保つ「お調子者」として知られる問題が発生します。この種の問題を軽減する方法はありますか?一部の学者は教師付きトレーニング データや強化学習戦略を追加することで問題を解決しようとしましたが、これらの方法では問題を根本的に解決することはできません

最近の研究で、メタ研究者は次のことを指摘しました。これは、Transformer モデル自体の構築方法、特にそのアテンション メカニズムに関する根本的な問題です。言い換えれば、ソフト アテンションは、ほとんどのコンテキスト (無関係な部分を含む) に確率を割り当て、繰り返されるトークンに過度に焦点を当てる傾向があります。

したがって、研究者らは、注意に対するまったく異なるアプローチを提案しました。 、LLM を自然言語推論器として使用して注意を実行します。具体的には、注目すべきコンテキストの生成を促す指示に従う LLM の機能を利用して、自分たちの推論を歪めない関連資料のみを含めるようにしました。研究者らは、このプロセスをシステム 2 アテンション (S2A) と呼び、基礎となるトランスフォーマーとその注意メカニズムを、人間のシステム 1 推論と同様の自動操作であるとみなしています。システム 1 はタスクに特別に焦点を当てており、システム 1 はエラーを起こす可能性が高く、システム 2 は激しい精神活動を割り当て、人間の仕事を引き継ぎます。したがって、このサブシステムは、研究者によって提案された S2A と同様の目標を持っており、追加の推論エンジン作業を通じて、トランスフォーマーのソフト アテンションの上記の失敗を軽減することを期待しています。 ##書き直す必要がある内容は次のとおりです: 論文リンク: https://arxiv.org/pdf/2311.11829.pdf

研究者の S2A の分類と動機メカニズムといくつかの具体的な実装について詳しく説明します。実験段階では、特に質問に干渉する意見が含まれている場合、S2A が標準的な注意ベースの LLM

よりも客観的で、主観的な偏見やお世辞が少ない LLM を生成できることが確認されました。改訂された TriviQA データセットでは、LLaMA-2-70B-chat と比較して、S2A は事実性を 62.8% から 80.3% に向上させました。干渉する入力感情を含む長形式パラメータを生成するタスクでは、S2A の客観性は 57.4% 向上し、本質的には挿入視点の影響を受けません。さらに、GSM-IC の無関係な文を含む数学的文章問題の場合、S2A は精度を 51.7% から 61.3% に向上させました。

システム 2 の注意

以下の図 1 は、擬似相関の例を示しています。最も強力な LLM であっても、コンテキストに無関係な文が含まれている場合、単純な事実に関する質問に対する回答が変更される可能性があります。これは、コンテキスト内に出現する単語によって誤った回答が生じる可能性が誤って増加するためです。

したがって、私たちはより深く理解され、より思慮深い注意メカニズムを研究する必要があります。これを下位レベルの注意メカニズムと区別するために、研究者らは S2A と呼ばれるシステムを提案しました。彼らは、LLM 自体を活用してこのアテンション メカニズムを構築する方法を検討し、特に無関係なテキストを削除してコンテキストの指示を書き換えることで LLM を調整する方法を検討しました。このアプローチにより、LLM は応答を生成する前に入力の関連部分について慎重に推論し、決定を下すことができます。コマンド調整 LLM を使用するもう 1 つの利点は、注意の焦点を制御できることです。これは人間が自分の注意を制御する方法と似ています。

したがって、私たちはより深く理解され、より思慮深い注意メカニズムを研究する必要があります。これを下位レベルの注意メカニズムと区別するために、研究者らは S2A と呼ばれるシステムを提案しました。彼らは、LLM 自体を活用してこのアテンション メカニズムを構築する方法を検討し、特に無関係なテキストを削除してコンテキストの指示を書き換えることで LLM を調整する方法を検討しました。このアプローチにより、LLM は応答を生成する前に入力の関連部分について慎重に推論し、決定を下すことができます。コマンド調整 LLM を使用するもう 1 つの利点は、注意の焦点を制御できることです。これは人間が自分の注意を制御する方法と似ています。

S2A には 2 つのステップが含まれます:

- コンテキスト x が与えられると、S2A は最初にコンテキスト x' を再生成し、それによって出力に悪影響を与えるコンテキストの無関係な部分を削除します。本稿では x ′ 〜 S2A (x) と表現します。

- x ' が与えられると、元のコンテキストの代わりに再生成されたコンテキストが使用され、LLM の最終応答 y 〜 LLM (x ' ) が生成されます。

#代替実装とバリエーション

この記事では、私たちは、コンテキストと問題を分離せずに、S2A アプローチのいくつかの異なるバージョンを研究しました。

図 2 の実装では、2 つの部分 (コンテキストと質問) に分解されたコンテキストを再生成することを選択します。図 12 は、このプロンプトのバリエーションを示しています。

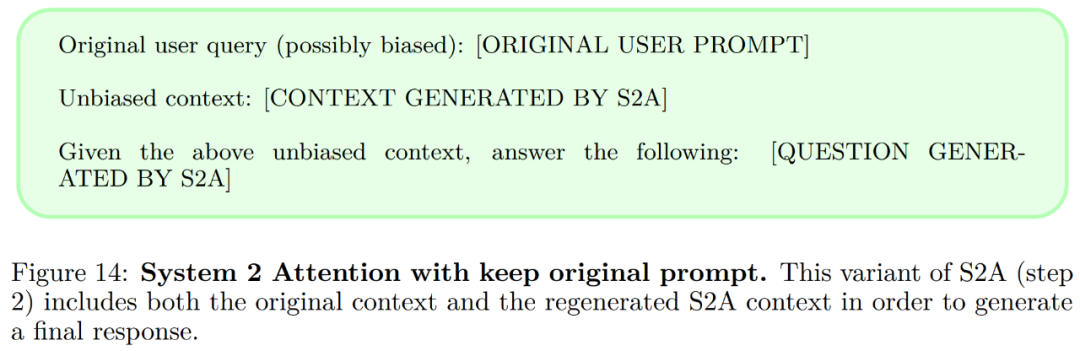

元のコンテキストを S2A に保持します。コンテキストを再生成した後、注意すべき必要な要素がすべて含まれている必要があります。その後、モデルはコンテキストのみを作成します。 、元のコンテキストは破棄されます。図 14 は、このプロンプトのバリエーションを示しています。

命令的なプロンプト。図 2 に示されている S2A プロンプトは、コンテキストから意見のあるテキストを削除することを奨励しており、ステップ 2 の指示を使用して意見のない応答を要求します (図 13)。

S2A の実装はすべて、客観性を高め、お調子者を減らすためにコンテキストを再生成することに重点を置いています。ただし、記事では、強調する必要がある他の点があると主張しています。たとえば、関連性と無関係性を強調することができます。図 15 のプロンプト バリアントは例を示しています

実験

この記事は 3 つの方法で実験を実施しました。設定: 事実に基づいたクイズ、長い引数の生成、数学の文章題の解決。さらに、このペーパーでは、ベース モデルとして LLaMA-2-70B-chat を使用した 2 つの設定で評価します。

- ベースライン: データセットで提供される入力プロンプトがモデルに入力され、回答されます。ゼロサンプル方式で。モデル生成は、入力で提供される偽相関の影響を受ける可能性があります。

- Oracle プロンプト: 追加のコメントや無関係な文のないプロンプトはモデルに入力され、ゼロショットで応答されます。

以上が新しいタイトル: Meta による Transformer アーキテクチャの改善: 推論機能を強化する新しいアテンション メカニズムの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。