ホームページ >テクノロジー周辺機器 >AI >NVIDIA が世界で最も強力な AI チップ H200 をリリース: H100 と比較してパフォーマンスがほぼ 2 倍に向上

NVIDIA が世界で最も強力な AI チップ H200 をリリース: H100 と比較してパフォーマンスがほぼ 2 倍に向上

- 王林転載

- 2023-11-14 14:33:491007ブラウズ

NVIDIA が世界で最も強力な AI チップ H200 をリリース: H100 と比較してほぼ 2 倍のパフォーマンス

Quick Technology は本日 (11 月 14 日)、2023 年のグローバル スーパーコンピューティング カンファレンス (SC2023) で、チップ大手の Nvidia が現在世界で最も強力な AI チップである H100 チップの後継チップである H200 をリリースしたと報じました。

H200 のパフォーマンスは、H100 と比較して 60% ~ 90% 直接向上します

それだけでなく、H200 と H100 は両方とも NVIDIA Hopper アーキテクチャに基づいているため、H100 を使用している企業は 2 つのチップが相互に互換性があり、最新の H200 にシームレスに置き換えることができます。

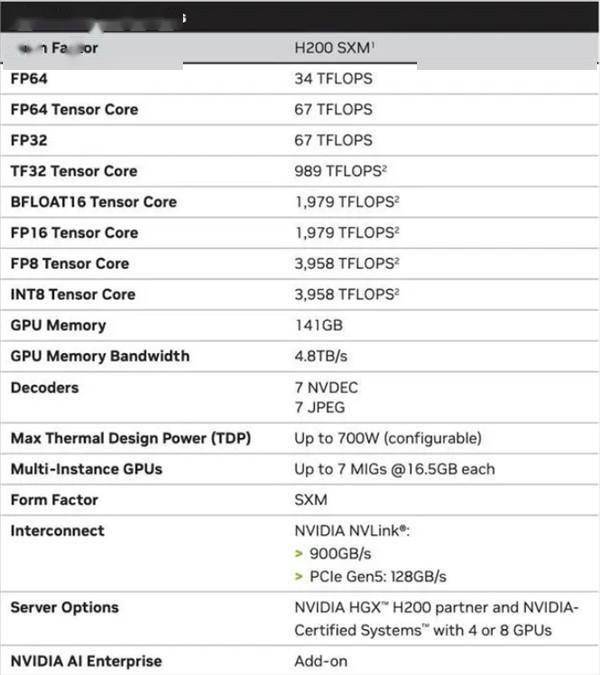

H200 は、HBM3e メモリを使用する NVIDIA の最初のチップであり、より高速で大容量であり、大規模な言語モデルのトレーニングと推論に非常に適しています。

HBM3e メモリに加えて、H200 のメモリ容量は 141GB で、帯域幅は H100 の 3.35TB/s から 4.8TB/s に増加しました。H200 のパフォーマンスの向上は主に大規模モデルの推論パフォーマンスに反映され、700 億のパラメーターを持つ大規模な Llama2 モデルにおける H200 の推論速度は H100 の 2 倍になり、H200 の推論エネルギー消費は直接的に削減されます。 H100に比べて半分になります。

H200 はより高いメモリ帯域幅を備えているため、メモリを大量に使用する高性能コンピューティング アプリケーションの場合、動作データにより効率的にアクセスできます。 H200 を使用すると、中央処理装置 (CPU) と比較して結果取得時間を最大 110 倍短縮できます

NVIDIA は、H200 は 2024 年の第 2 四半期に出荷される予定であると述べました。価格はまだ発表されていませんが、コンピューティング能力が不足する中、大手テクノロジー企業は依然として供給を蓄えることが予想されます。

以上がNVIDIA が世界で最も強力な AI チップ H200 をリリース: H100 と比較してパフォーマンスがほぼ 2 倍に向上の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

声明:

この記事はsohu.comで複製されています。侵害がある場合は、admin@php.cn までご連絡ください。