ホームページ >テクノロジー周辺機器 >AI >NVIDIA が AI チップ H200 をリリース: パフォーマンスが 90% 向上、Llama 2 の推論速度が 2 倍に

NVIDIA が AI チップ H200 をリリース: パフォーマンスが 90% 向上、Llama 2 の推論速度が 2 倍に

- 王林転載

- 2023-11-14 12:09:541058ブラウズ

DoNews は 11 月 14 日、NVIDIA が北京時間の 13 日に次世代の人工知能スーパーコンピューター チップをリリースしたと報じました。これらのチップは、OpenAI の GPT-4 などの深層学習や大規模言語モデル (LLM) で重要な役割を果たすことになります。

新世代のチップは前世代と比較して大幅な進歩を遂げており、天気や気候の予測、医薬品の研究開発、量子コンピューティングなどの複雑なタスクを処理するためにデータセンターやスーパーコンピューターで広く使用されるでしょう

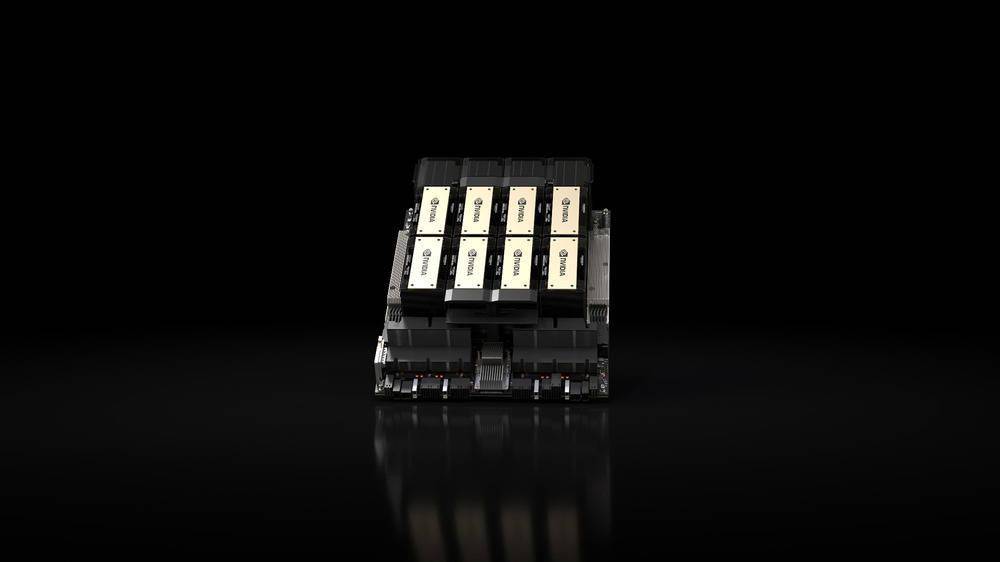

リリースされた主な製品は、Nvidia の「Hopper」アーキテクチャに基づく HGX H200 GPU です。これは、H100 GPU の後継であり、HBM3e メモリを使用する同社の最初のチップです。 HBM3e メモリは高速かつ大容量であるため、大規模な言語モデルのアプリケーションに非常に適しています

NVIDIA は、「HBM3e テクノロジーにより、NVIDIA H200 のメモリ速度は毎秒 4.8 TB に達し、容量は 141 GB となり、A100 のほぼ 2 倍となり、帯域幅も 2.4 倍増加しました。」と述べています。

人工知能の分野では、NVIDIA は、Llama 2 (700 億パラメータ LLM) 上の HGX H200 の推論速度が H100 の 2 倍であると主張しています。 HGX H200 は、H100 システムのソフトウェアおよびハードウェアと互換性のある 4 ウェイおよび 8 ウェイ構成で利用可能になりますあらゆるタイプのデータセンター (オンプレミス、クラウド、ハイブリッド クラウド、エッジ) で利用でき、Amazon Web Services、Google Cloud、Microsoft Azure、Oracle Cloud Infrastructure によって展開され、2024 年第 2 四半期に利用可能になる予定です。

今回 NVIDIA がリリースしたもう 1 つの重要な製品は、同社の NVLink-C2C インターコネクトを介して HGX H200 GPU と Arm ベースの NVIDIA Grace CPU を組み合わせた GH200 Grace Hopper「スーパーチップ」です。テラバイト規模のデータを実行する複雑な AI および HPC アプリケーションを高速化することで、世界で最も困難な問題を解決します。」

GH200 は、Dell、Eviden、Hewlett Packard Enterprise (HPE)、Lenovo、QCT、Supermicro を含む「世界中の研究センター、システム メーカー、クラウド プロバイダーの 40 を超える AI スーパーコンピューター」で使用される予定です。

特に、HPE の Cray EX2500 スーパーコンピューターは、数万の Grace Hopper スーパーチップ ノードまで拡張可能な 4 ウェイ GH200 を搭載します

以上がNVIDIA が AI チップ H200 をリリース: パフォーマンスが 90% 向上、Llama 2 の推論速度が 2 倍にの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

声明:

この記事はsohu.comで複製されています。侵害がある場合は、admin@php.cn までご連絡ください。