復旦大学とファーウェイのノアの方舟研究所の研究者は、画像拡散モデル (LDM) - VidRD (再利用と拡散) に基づいて高品質ビデオを生成するための反復ソリューションを提案しました。このソリューションは、生成されるビデオの品質とシーケンスの長さにおいて画期的な進歩を遂げ、高品質で制御可能な長いシーケンスのビデオ生成を実現することを目的としています。これは、生成されたビデオ フレーム間のジッター問題を効果的に軽減し、研究と実用的な価値が高く、現在注目を集めている AIGC コミュニティに貢献します。

潜在拡散モデル (LDM) は、ノイズ除去オートエンコーダーに基づく生成モデルであり、ランダムに初期化されたデータから徐々にノイズを除去することで高品質のデータを生成できます。ただし、モデルのトレーニングと推論の両方における計算とメモリの制限により、通常、単一の LDM は非常に限られた数のビデオ フレームしか生成できません。既存の研究では、別の予測モデルを使用してより多くのビデオ フレームを生成しようとしていますが、これにより追加のトレーニング コストが発生し、フレーム レベルのジッターが発生します。

この論文では、画像合成における潜在拡散モデル (LDM) の目覚ましい成功に触発されて、VidRD と呼ばれる「再利用と拡散」と呼ばれるフレームワークが提案されています。このフレームワークは、LDM によってすでに生成された少数のビデオ フレームの後にさらに多くのビデオ フレームを生成できるため、より長く、高品質で多様なビデオ コンテンツを繰り返し生成できます。 VidRD は、効率的なトレーニングのために事前トレーニング済みの画像 LDM モデルを読み込み、ノイズ除去のために時間情報を追加した U-Net ネットワークを使用します。

- 論文タイトル: 再利用と拡散: テキストからビデオへの生成のための反復的ノイズ除去

- 論文アドレス: https://arxiv.org/abs/2309.03549

- プロジェクト ホームページ: https://anonymous0x233.github.io/ ReuseAndDiffuse /

この記事の主な貢献は次のとおりです:

- よりスムーズなビデオを生成するために、この記事はLDM モデルは、タイミングを意識した反復的な「テキストからビデオへの」生成方法を提案しています。この方法では、既に生成されたビデオ フレームから潜在空間特徴を再利用し、毎回前の拡散プロセスに従うことにより、より多くのビデオ フレームを繰り返し生成できます。

- この記事では、高品質の「テキストビデオ」データ セットを生成するための一連のデータ処理方法を設計します。既存のアクション認識データセットに対して、この論文ではマルチモーダル大規模言語モデルを使用してビデオにテキストの説明を与えます。画像データの場合、このペーパーではランダムなスケーリングと変換方法を使用して、より多くのビデオ トレーニング サンプルを生成します。

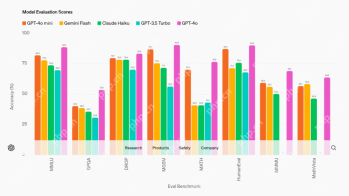

- UCF-101 データセット上で、この記事では FVD と IS の 2 つの評価指標と可視化結果を検証しました。定量的および定性的結果は次のことを示しています。 、VidRD モデルはすべてより良い結果を達成しました。

この記事では、高品質ビデオ合成のための LDM トレーニングの開始点として、事前トレーニング済みの画像 LDM を使用することが効率的で賢明な選択であると考えています。同時に、この見解は[1、2]などの研究成果によってさらに裏付けられています。これに関連して、この記事で慎重に設計されたモデルは、事前にトレーニングされた安定拡散モデルに基づいて構築されており、その優れた特性を十分に学習し、継承しています。これらには、正確な潜在表現のための変分オートエンコーダー (VAE) と強力なノイズ除去ネットワーク U-Net が含まれます。図 1 は、モデルの全体的なアーキテクチャを明確かつ直感的に示しています。

この記事のモデル設計で注目すべき特徴は、事前トレーニングされたモデルの重みを最大限に活用していることです。具体的には、VAE のコンポーネントや U-Net のアップサンプリング層とダウンサンプリング層を含むほとんどのネットワーク層は、安定した拡散モデルの事前トレーニングされた重みを使用して初期化されます。この戦略により、モデルのトレーニング プロセスが大幅に高速化されるだけでなく、モデルが最初から良好な安定性と信頼性を示すことが保証されます。私たちのモデルは、元の潜在的な特徴を再利用し、以前の拡散プロセスを模倣することにより、少数のフレームを含む最初のビデオ クリップから追加のフレームを繰り返し生成できます。さらに、ピクセル空間と潜在空間の間の変換に使用されるオートエンコーダーでは、タイミング関連のネットワーク層をデコーダーに挿入し、これらの層を微調整して時間的一貫性を向上させます。

ビデオ フレーム間の連続性を確保するために、この記事では 3D Temp-conv レイヤーと Temp-attn レイヤーをモデルに追加します。 Temp-conv 層は 3D ResNet に従い、3D 畳み込み演算を実装して空間的および時間的相関を捕捉し、ビデオ シーケンス集約のダイナミクスと連続性を理解します。 Temp-Attn 構造は Self-attention に似ており、ビデオ シーケンス内のフレーム間の関係を分析して理解するために使用され、モデルがフレーム間の実行情報を正確に同期できるようになります。これらのパラメーターはトレーニング中にランダムに初期化され、モデルに時間構造の理解とエンコードを提供するように設計されています。さらに、モデル構造に適応するために、データ入力もそれに応じて適応および調整されています。 #図 2. この記事で提案する高品質の「テキストビデオ」トレーニング データセット構築方法 VidRD モデルをトレーニングするために、この記事では、図 2 に示すように、大規模な「テキスト-ビデオ」トレーニング データセットを構築する方法を提案します。この方法は、「テキスト-画像」データと「 text-video」には説明データがありません。さらに、高品質のビデオ生成を実現するために、この記事ではトレーニング データのウォーターマークを削除することも試みます。 現在の市場では高品質のビデオ記述データセットが比較的不足していますが、多数のビデオ分類データセットが存在します。これらのデータセットには豊富なビデオ コンテンツが含まれており、各ビデオには分類ラベルが付いています。たとえば、Moments-In-Time、Kinetics-700、および VideoLT は、3 つの代表的な大規模ビデオ分類データ セットです。 Kinetics-700 は 700 の人間のアクション カテゴリをカバーし、600,000 を超えるビデオ クリップが含まれています。 Moments-In-Time には 339 のアクション カテゴリが含まれており、合計 100 万を超えるビデオ クリップが含まれています。一方、VideoLT には 1,004 のカテゴリと 250,000 の長い未編集のビデオが含まれています。 既存のビデオ データを最大限に活用するために、この記事では、これらのビデオにさらに詳細な注釈を自動的に付けることを試みます。この記事では、BLIP-2 や MiniGPT4 などのマルチモーダル大規模言語モデルを使用しています。ビデオ内のキー フレームをターゲットにし、元の分類ラベルを組み合わせることで、モデルの質問と回答を通じて注釈を生成するための多くのプロンプトを設計します。この方法は、ビデオ データの音声情報を強化するだけでなく、詳細な説明のない既存のビデオに、より包括的で詳細なビデオ説明をもたらします。これにより、より豊富なビデオ タグの生成が可能になり、VidRD モデルがより優れたトレーニング効果をもたらすことができます。 さらに、この記事では、既存の非常に豊富な画像データについて、トレーニング用に画像データをビデオ形式に変換する詳細な方法も設計しました。具体的な操作は、画像のさまざまな位置でさまざまな速度でパンとズームを行うことです。これにより、各画像に独自の動的な表示形式が与えられ、現実の静止物体をキャプチャするためにカメラを移動する効果がシミュレートされます。この方法により、既存の画像データをビデオトレーニングに有効活用することができます。

最後に、次のようになります。図 3 は、この記事で生成された結果と既存の手法である Make-A-Video [3] および Imagen Video [4] のそれぞれを視覚的に比較したもので、この記事のモデルのより優れた品質生成効果を示しています。

説明文は「空にオーロラが広がる雪国でのタイムラプス」、「キャンドルが燃えている」です。 .」、「夜の輝く街の上空を襲う壮大な竜巻。」、「美しい海の海岸にある白い砂浜の空撮。」さらに多くのビジュアライゼーションはプロジェクトのホームページでご覧いただけます。

#図 3. 既存の方法との生成効果の視覚的比較

#図 3. 既存の方法との生成効果の視覚的比較

以上が復旦大学とファーウェイ・ノアが反復的な高品質ビデオ生成を実現するVidRDフレームワークを提案の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

LM Studioを使用してLLMをローカルに実行する方法は? - 分析VidhyaApr 19, 2025 am 11:38 AM

LM Studioを使用してLLMをローカルに実行する方法は? - 分析VidhyaApr 19, 2025 am 11:38 AM自宅で大規模な言語モデルを簡単に実行する:LM Studioユーザーガイド 近年、ソフトウェアとハードウェアの進歩により、パーソナルコンピューターで大きな言語モデル(LLM)を実行することが可能になりました。 LM Studioは、このプロセスを簡単かつ便利にするための優れたツールです。この記事では、LM Studioを使用してLLMをローカルに実行する方法に飛び込み、重要なステップ、潜在的な課題、LLMをローカルに配置することの利点をカバーします。あなたが技術愛好家であろうと、最新のAIテクノロジーに興味があるかどうかにかかわらず、このガイドは貴重な洞察と実用的なヒントを提供します。始めましょう! 概要 LLMをローカルに実行するための基本的な要件を理解してください。 コンピューターにLM Studiをセットアップします

Guy Periは、データ変換を通じてMcCormickの未来のフレーバーを支援しますApr 19, 2025 am 11:35 AM

Guy Periは、データ変換を通じてMcCormickの未来のフレーバーを支援しますApr 19, 2025 am 11:35 AMGuy Periは、McCormickの最高情報およびデジタルオフィサーです。彼の役割からわずか7か月後ですが、ペリは同社のデジタル能力の包括的な変革を急速に進めています。データと分析に焦点を当てている彼のキャリアに焦点が当てられています

迅速なエンジニアリングの感情の連鎖は何ですか? - 分析VidhyaApr 19, 2025 am 11:33 AM

迅速なエンジニアリングの感情の連鎖は何ですか? - 分析VidhyaApr 19, 2025 am 11:33 AM導入 人工知能(AI)は、言葉だけでなく感情も理解し、人間のタッチで反応するように進化しています。 この洗練された相互作用は、AIおよび自然言語処理の急速に進む分野で重要です。 th

データサイエンスワークフローのための12のベストAIツール-AnalyticsVidhyaApr 19, 2025 am 11:31 AM

データサイエンスワークフローのための12のベストAIツール-AnalyticsVidhyaApr 19, 2025 am 11:31 AM導入 今日のデータ中心の世界では、競争力と効率の向上を求める企業にとって、高度なAIテクノロジーを活用することが重要です。 さまざまな強力なツールにより、データサイエンティスト、アナリスト、開発者が構築、Deplを作成することができます。

AV BYTE:OpenAIのGPT-4O MINIおよびその他のAIイノベーションApr 19, 2025 am 11:30 AM

AV BYTE:OpenAIのGPT-4O MINIおよびその他のAIイノベーションApr 19, 2025 am 11:30 AM今週のAIの風景は、Openai、Mistral AI、Nvidia、Deepseek、Hugging Faceなどの業界の巨人からの画期的なリリースで爆発しました。 これらの新しいモデルは、TRの進歩によって促進された電力、手頃な価格、アクセシビリティの向上を約束します

PerplexityのAndroidアプリにはセキュリティの欠陥が感染しているとレポートApr 19, 2025 am 11:24 AM

PerplexityのAndroidアプリにはセキュリティの欠陥が感染しているとレポートApr 19, 2025 am 11:24 AMしかし、検索機能を提供するだけでなくAIアシスタントとしても機能する同社のAndroidアプリは、ユーザーをデータの盗難、アカウントの買収、および悪意のある攻撃にさらす可能性のある多くのセキュリティ問題に悩まされています。

誰もがAIの使用が上手になっています:バイブコーディングに関する考えApr 19, 2025 am 11:17 AM

誰もがAIの使用が上手になっています:バイブコーディングに関する考えApr 19, 2025 am 11:17 AM会議や展示会で何が起こっているのかを見ることができます。エンジニアに何をしているのか尋ねたり、CEOに相談したりできます。 あなたが見ているところはどこでも、物事は猛烈な速度で変化しています。 エンジニア、および非エンジニア 違いは何ですか

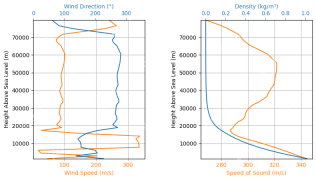

Rocketpyを使用したロケットの起動シミュレーションと分析-AnalyticsVidhyaApr 19, 2025 am 11:12 AM

Rocketpyを使用したロケットの起動シミュレーションと分析-AnalyticsVidhyaApr 19, 2025 am 11:12 AMRocketpy:A包括的なガイドでロケット発売をシミュレートします この記事では、強力なPythonライブラリであるRocketpyを使用して、高出力ロケット発売をシミュレートすることをガイドします。 ロケットコンポーネントの定義からシミュラの分析まで、すべてをカバーします

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

SublimeText3 中国語版

中国語版、とても使いやすい

Dreamweaver Mac版

ビジュアル Web 開発ツール

AtomエディタMac版ダウンロード

最も人気のあるオープンソースエディター

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

MinGW - Minimalist GNU for Windows

このプロジェクトは osdn.net/projects/mingw に移行中です。引き続きそこでフォローしていただけます。 MinGW: GNU Compiler Collection (GCC) のネイティブ Windows ポートであり、ネイティブ Windows アプリケーションを構築するための自由に配布可能なインポート ライブラリとヘッダー ファイルであり、C99 機能をサポートする MSVC ランタイムの拡張機能が含まれています。すべての MinGW ソフトウェアは 64 ビット Windows プラットフォームで実行できます。