ホームページ >テクノロジー周辺機器 >AI >MiniGPT-4 は MiniGPT-v2 にアップグレードされました。マルチモーダル タスクは GPT-4 なしでも完了できます。

MiniGPT-4 は MiniGPT-v2 にアップグレードされました。マルチモーダル タスクは GPT-4 なしでも完了できます。

- PHPz転載

- 2023-10-17 14:41:091428ブラウズ

数か月前、KAUST (サウジアラビアのキング・アブドラ科学技術大学) の数人の研究者が、MiniGPT-4 # と呼ばれる手法を提案しました。 ## プロジェクト。GPT-4 と同様の画像理解機能と対話機能を提供します。

たとえば、MiniGPT-4 は、下の写真のシーンに答えることができます。「その写真は、凍った湖の上で成長しているサボテンを描写しています。サボテンの周りには巨大な氷の結晶があり、そこには「遠くに氷の結晶が見えます。雪を頂いた山々が…」では、このような光景は現実の世界で起こり得るのでしょうか? MiniGPT-4 が出した答えは、この画像は現実世界では一般的ではない、そしてその理由です。

ほんの数か月が経ちましたが、最近、KAUST チームと Meta の研究者は、MiniGPT-4 を MiniGPT-v2 バージョンにアップグレードしたことを発表しました。 。

論文のアドレス: https://arxiv.org/pdf/2310.09478.pdf

論文ホームページ: https://minigpt-v2.github.io/

#デモ: https://minigpt-v2.github.io/

具体的には、MiniGPT-v2 は、さまざまな視覚言語タスクをより適切に処理するための統合インターフェイスとして機能します。同時に、この記事では、モデルをトレーニングするときに、さまざまなタスクに一意の識別記号を使用することをお勧めします。これらの識別記号は、モデルが各タスクの指示を簡単に区別し、各タスク モデルの学習効率を向上させるのに役立ちます。

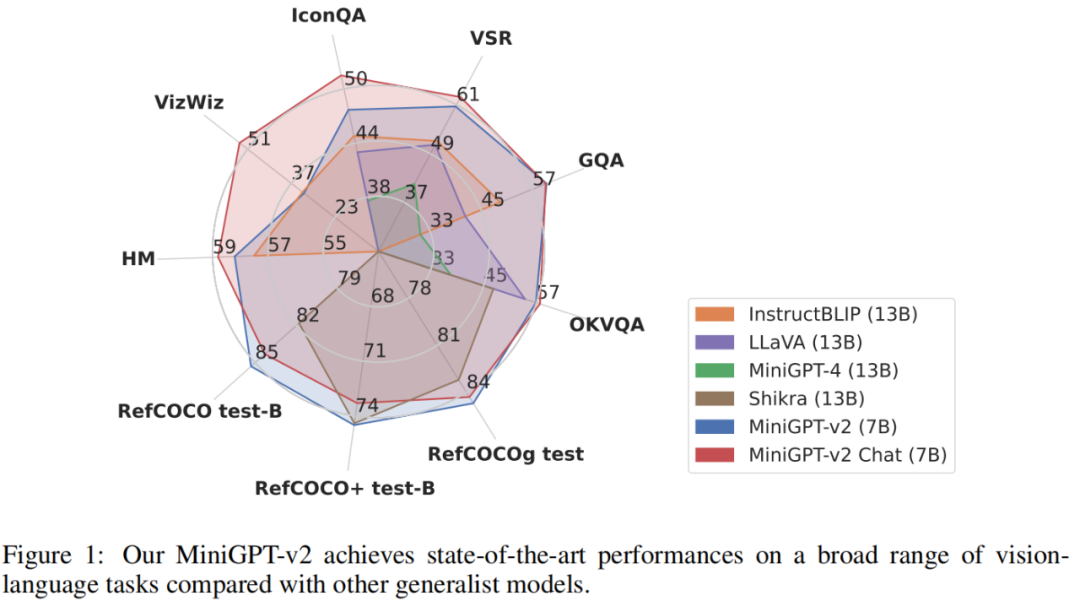

MiniGPT-v2 モデルのパフォーマンスを評価するために、研究者たちはさまざまな視覚言語タスクについて広範な実験を実施しました。結果は、MiniGPT-4、InstructBLIP、LLaVA、Shikra などの以前のビジョン言語汎用モデルと比較して、MiniGPT-v2 がさまざまなベンチマークで SOTA または同等のパフォーマンスを達成していることを示しています。たとえば、VSR ベンチマークでは、MiniGPT-v2 は MiniGPT-4 を 21.3%、InstructBLIP を 11.3%、LLaVA を 11.7% 上回っています。

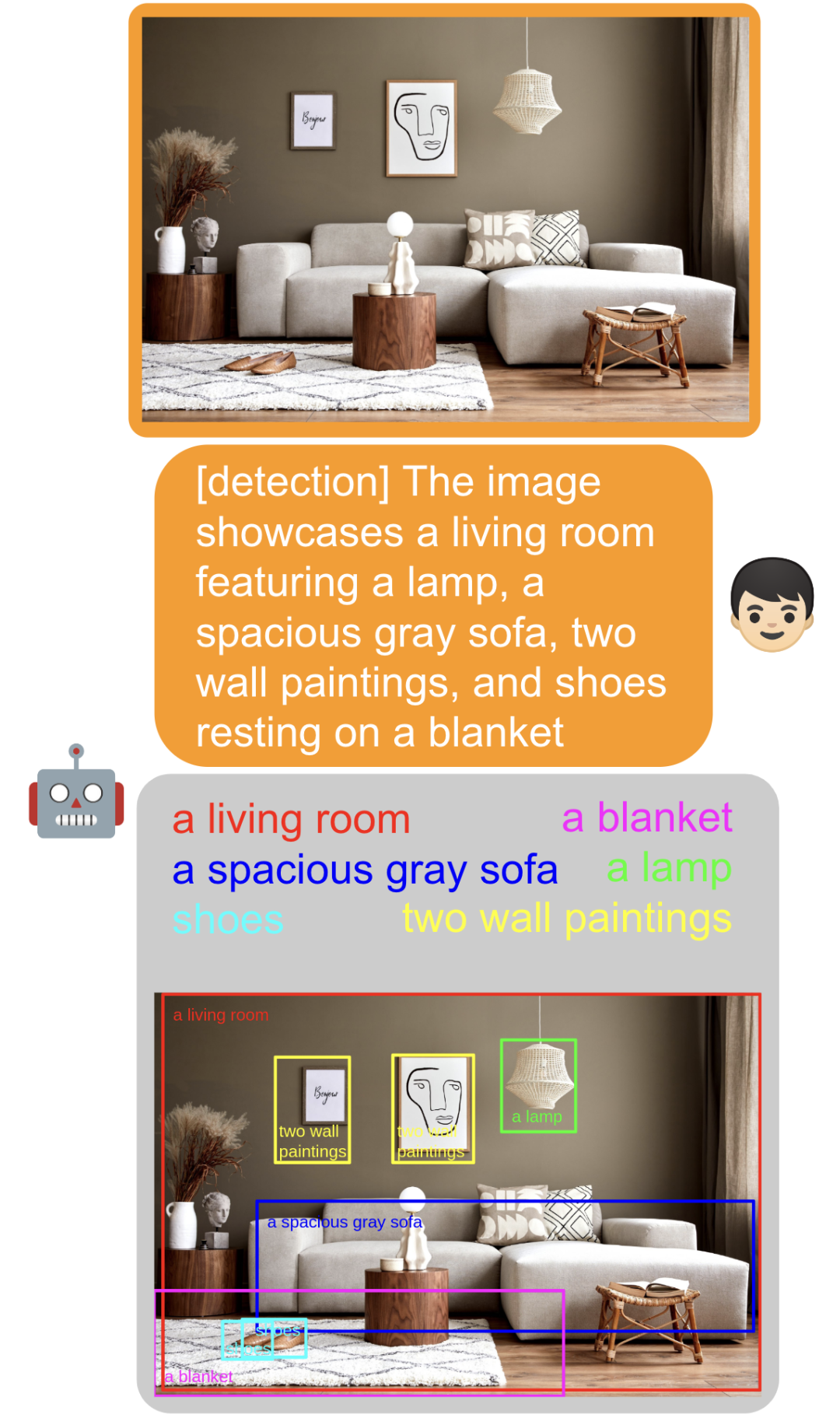

以下では、特定の例を使用して MiniGPT-v2 識別シンボルの役割を説明します。

たとえば、[グラウンディング] 認識シンボルを追加することで、モデルは空間位置認識を備えた画像記述を簡単に生成できます。

[検出] 認識シンボルを追加することにより、モデルは入力テキスト内のオブジェクトを直接抽出し、画像内のオブジェクトの空間位置を見つけることができます。

画像内のオブジェクトをフレーム化します。[identify] を追加すると、モデルはオブジェクトの名前を直接識別できます。参照] オブジェクトの説明を使用すると、モデルはオブジェクトの対応する空間位置を見つけるのに直接役立ちます。

また、タスクを追加せずにマッチング、対話用の画像:

また、タスクを追加せずにマッチング、対話用の画像:

# モデルの空間認識も強化され、登場するモデルに直接質問することができます写真の左、中、右:

メソッドの紹介

ビジュアル バックボーン: MiniGPT-v2 はバックボーン モデルとして EVA を使用し、トレーニング中にビジュアル バックボーンはフリーズします。モデルは 448x448 の画像解像度でトレーニングされ、より高い画像解像度にスケールするために位置エンコードが挿入されます。

線形投影層: この記事の目的は、凍結されたビジュアル バックボーンからすべてのビジュアル トークンを言語モデル空間に投影することです。ただし、より高解像度の画像 (例: 448x448) の場合、すべての画像トークンを投影すると非常に長いシーケンス入力 (例: 1024 トークン) が発生し、トレーニングと推論の効率が大幅に低下します。したがって、この論文では、エンベディング空間内の 4 つの隣接するビジュアル トークンを単純に連結し、それらを大規模な言語モデルの同じ特徴空間内の 1 つのエンベディングに一緒に投影することで、ビジュアル入力トークンの数を 4 分の 1 に削減します。

大規模言語モデル: MiniGPT-v2 は、言語モデルのバックボーンとしてオープン ソースの LLaMA2-chat (7B) を使用します。この研究では、言語モデルはさまざまな視覚言語入力のための統一されたインターフェイスとして考慮されます。この記事では、LLaMA-2 言語トークンを直接使用して、さまざまな視覚言語タスクを実行します。空間的位置の生成を必要とする基本的な視覚タスクの場合、この論文では、空間的位置を表す境界ボックスのテキスト表現を生成する言語モデルを直接必要とします。

#マルチタスク指示トレーニング

##この記事では、タスク認識の記号指示を使用してタスク認識をトレーニングします。モデルは3段階に分かれています。トレーニングの各段階で使用されるデータセットを表 2 に示します。

フェーズ 1: 事前トレーニング。この論文では、より多様な知識を取得するために、弱くラベル付けされたデータセットに高いサンプリング レートを与えます。

フェーズ 2: マルチタスク トレーニング。各タスクで MiniGPT-v2 のパフォーマンスを向上させるために、現在の段階では、モデルをトレーニングするためのきめの細かいデータセットの使用のみに焦点を当てています。研究者らは、GRIT-20MやLAIONなどの弱い教師付きデータセットをステージ1から除外し、各タスクの頻度に応じてデータサンプリング率を更新しました。この戦略により、モデルは高品質に位置合わせされた画像とテキストのデータを優先することができ、その結果、さまざまなタスクにわたって優れたパフォーマンスが得られます。

フェーズ 3: マルチモーダル命令のチューニング。その後、このペーパーでは、よりマルチモーダルな命令データセットを使用してモデルを微調整し、チャットボットとしての会話機能を強化することに焦点を当てます。

最後に、公式は読者がテストできるデモも提供しています。たとえば、下の画像の左側で、写真をアップロードし、[検出]を選択して、次のように入力します。 「赤い風船」と入力すると、モデルは写真内の赤い風船を識別できます。

#興味のある読者は、紙のホームページで詳細を確認してください。

以上がMiniGPT-4 は MiniGPT-v2 にアップグレードされました。マルチモーダル タスクは GPT-4 なしでも完了できます。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。