ホームページ >テクノロジー周辺機器 >AI >DragGAN は 3 日間で 23,000 個のスターを対象にオープンソース化されました。また DragDiffusion が登場します

DragGAN は 3 日間で 23,000 個のスターを対象にオープンソース化されました。また DragDiffusion が登場します

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-06-28 15:28:171365ブラウズ

AIGC の魔法の世界では、画像を「ドラッグ」するだけで、希望する画像を変更したり合成したりできます。たとえば、ライオンが頭を向けて口を開けたとします。

この効果を実現するための研究は、「Drag Your GAN」論文から得られています。中国人著者が主導し、上記で出版され、今月リリースされ、SIGGRAPH 2023 カンファレンスに参加することが承認されました。

1 か月以上が経過し、研究チームは最近正式なコードをリリースしました。わずか3日間でスターの数が23,000を超えており、その人気の高さがうかがえます。

#写真

#写真

GitHub アドレス: https://github.com/XingangPan/DragGAN

偶然にも、今日、別の同様の研究である DragDiffusion が人々の目に留まりました。以前の DragGAN は、ポイントベースのインタラクティブな画像編集を実装し、ピクセルレベルの精度の編集効果を実現しました。ただし、欠点もあります。DragGAN は敵対的生成ネットワーク (GAN) に基づいており、その汎用性は事前トレーニングされた GAN モデルの容量によって制限されます。

新しい研究では、シンガポール国立大学とバイトダンスの数名の研究者が、このタイプの編集フレームワークを拡散モデルに拡張し、DragDiffusion を提案しました。大規模な事前トレーニング済み拡散モデルを活用して、現実世界のシナリオにおけるポイントベースのインタラクティブ編集の適用性を大幅に向上させます。

現在のほとんどの拡散ベースの画像編集方法はテキストの埋め込みに適していますが、DragDiffusion は拡散潜在表現を最適化し、正確な空間制御を実現します。

写真

写真

- 論文アドレス: https://arxiv.org/pdf/2306.14435.pdf

- プロジェクトアドレス: https://yujun-shi.github.io/projects/dragdiffusion.html

研究者らは、拡散モデルは反復的に画像を生成し、拡散ポテンシャル表現の「ワンステップ」最適化で一貫した結果を生成するのに十分であり、DragDiffusion が効率的に実行できると述べています。完全な高品質編集。

彼らは、DragDiffusion の可塑性と多用途性を検証するために、さまざまな困難なシナリオ (複数のオブジェクト、異なるオブジェクト カテゴリなど) の下で広範な実験を実施しました。

DragDiffusion の効果を見てみましょう。

まず、下の図の子猫の頭を上げたいと思います。ユーザーは赤い点を青い点にドラッグするだけです:

#次に、山を少し高くします。問題はありません。赤いキー ポイントをドラッグするだけです。

Picture

Picture

彫刻の頭を回転させたい場合は、ドラッグして行うことができます:

彫刻の頭を回転させたい場合は、ドラッグして行うことができます:

写真

写真

# 海岸の花を広く咲かせましょう:

# 海岸の花を広く咲かせましょう:

##メソッドの紹介

##メソッドの紹介

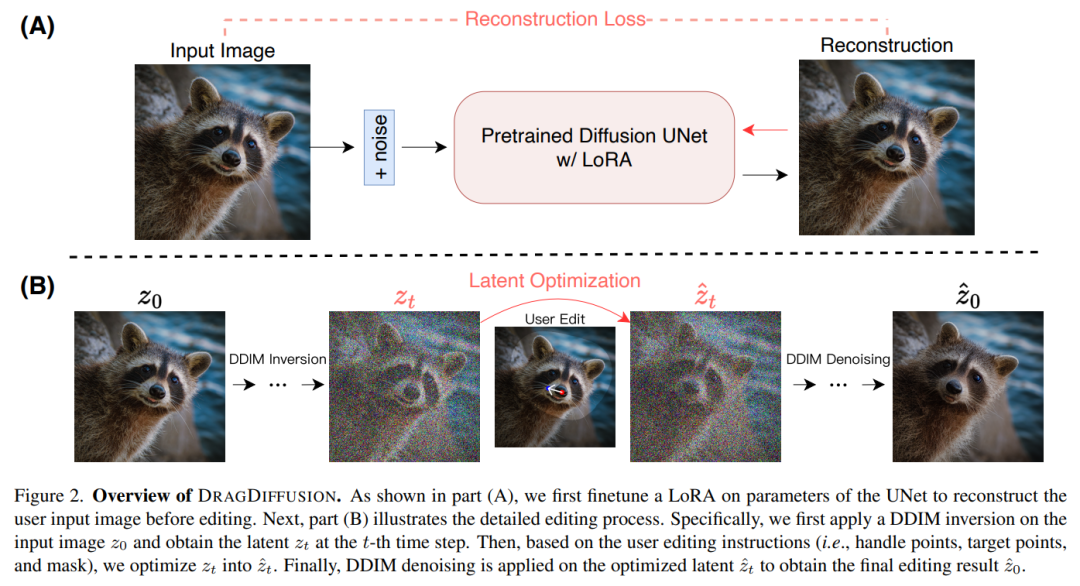

この記事で提案する DRAGDIFFUSION は、特定の拡散潜在変数を最適化して、インタラクティブなポイントベースの画像編集を実現することを目的としています。

この目標を達成するために、この研究ではまず拡散モデルに基づいて LoRA を微調整し、ユーザー入力画像を再構築します。これにより、入力画像と出力画像のスタイルの一貫性を保つことができます。

次に研究者らは、入力画像に対して DDIM 逆変換 (拡散モデルの逆変換と潜在空間操作を探索する方法) を使用して、特定のステップでの拡散潜在変数を取得しました。

編集プロセス中、研究者はモーション監視とポイント追跡を繰り返し使用して、以前に取得した t 番目のステップの拡散潜在変数を最適化し、それによって処理ポイントのコンテンツをドラッグしました)ターゲットの場所。編集プロセスでは、画像のマスクされていない領域が変更されないように、正則化項も適用されます。

最後に、DDIM を使用してステップ t で最適化された潜在変数のノイズを除去し、編集結果を取得します。全体概要図は次のとおりです。

写真

写真

実験結果

与えられた入力イメージを定義し、DRAGDIFFUSION はキー ポイント (赤) の内容を対応するターゲット ポイント (青) に「ドラッグ」します。たとえば、写真 (1) では子犬の頭を裏返し、写真 (7) ではトラの口を閉じます。

写真

写真

その他のサンプル デモンストレーションを次に示します。図(4)のように山の頂上を高くしたり、図(7)のようにペン先を大きくしたりしてください。 ###############写真###############

以上がDragGAN は 3 日間で 23,000 個のスターを対象にオープンソース化されました。また DragDiffusion が登場しますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。