公式 GPT-4 ユーザー ガイドが入手可能になりました。

お聞きのとおり、今回は自分でメモを取る必要はありません。OpenAI が個人的にメモを作成してくれました。

これには、皆さんの 6 か月間の使用体験が集められており、あなた、私、そして彼のヒントやテクニックがすべて統合されていると言われています。

要約すると 6 つの主要戦略 しかありませんが、詳細は決して曖昧ではありません。

このチートブックでは、一般の GPT-4 ユーザーがヒントやコツを得ることができるだけでなく、アプリケーション開発者もインスピレーションを得られるかもしれません。

ネチズンは次々にコメントし、自分の「読んだ後の感想」を述べました:

とても興味深いです!要約すると、これらの技術の中核となる考え方には 2 つの主要な点が含まれます。まず、より具体的に書いて、いくつかの詳細なヒントを提供する必要があります。次に、これらの複雑なタスクを小さなプロンプトに分割して完了できます。

実践的なヒント:

1. 詳細を知ることでのみ、より関連性の高い回答を得ることができます

出力を作成するには入力には強い相関関係があり、すべての重要な詳細情報をモデルにフィードできます。 たとえば、「GPT-4: 会議議事録の要約」 の場合は、ステートメントにできるだけ詳細を追加できます:「会議議事録の要約」段落。次に、出席者とその要点をリストしたマークダウン リストを作成します。最後に、出席者から次のステップについての提案がある場合は、それをリストします。2. モデルに特定の役割を果たすよう要求する

システム メッセージを変更することで、GPT-4 は、従来よりも特定の役割を果たしやすくします。対話での提案 より高いレベルの強調が必要です。 文書に返信するように指定されている場合は、文書内の各段落に興味深いコメントが必要です:

3. 区切り文字を使用して、入力の異なる部分を明確にマークします。

「""三重引用符""」、

4. タスクを完了するために必要な手順を明確に指定します。

一部のタスクは、次のような場合により効果的です。それらは段階的に実行されます。したがって、モデルがより簡単に手順に従って、目的の結果を出力できるように、一連の手順を明確に指定することをお勧めします。たとえば、システム メッセージで応答する手順を設定します。

モデルの出力を特定のパターンに従わせたい場合は、はあまり良くありません。具体的なスタイルを説明してから、例を示してください。たとえば、例を示した後、「忍耐力を教えてください」と言うだけで、例のスタイルに従って鮮やかに説明します。

6. 必要な出力長を指定します

単語、文、段落、箇条書きなどの数を具体的に生成するようにモデルに依頼することもできます。ただし、モデルが特定の数の単語/文字を生成するように要求された場合、精度がそれほど高くない可能性があります。

戦略 2: 参考テキストを提供する

難解なトピック、引用、URL などに関しては、GPT モデルは非常に意味のないことを話す可能性があります。

GPT-4 の参考テキストを提供すると、架空の回答の発生を減らし、回答の内容の信頼性を高めることができます。

実践的なヒント:

1. 参考資料を参照してモデルに答えてもらいます。

いくつかのヒントを提供できる場合は、質問に関する信頼できる情報。提供された情報を使用して回答を整理するように指示できます。

2. モデルに参考資料を引用させて回答させます。

すでに入力されている場合は、上記のダイアログ入力に関連情報を追加して、提供された情報を回答に引用するようモデルに直接依頼することもできます。

ここで、出力内で参照されている部分をモデルにプログラム的に検証させることができることに注意してください。

実践的なヒント:

1. 意図を分類する

さまざまな状況に対処する必要がある多数の独立したタスクの場合、これらのタスクは最初に分類できます。 次に、分類に基づいて必要な指示を決定します。 たとえば、顧客サービス アプリケーションの場合、クエリを分類できます (請求、テクニカル サポート、アカウント管理、一般的なクエリなど)。 ユーザーが次のように尋ねた場合:インターネットを通常の状態に戻す必要があります。ユーザー クエリの分類に従って、ユーザーの特定の要求をロックし、次のステップのために一連のより具体的な指示を GPT-4 に提供できます。 たとえば、ユーザーが「トラブルシューティング」についてサポートを必要としているとします。 次のステップを設定できます:

ルーターのすべてのケーブルが接続されているかどうかをユーザーに確認するように要求します...

2. 以前の会話を要約またはフィルタリングする

GPT-4 の会話ウィンドウは限られているため、コンテキストが長すぎてはなりません。会話ウィンドウで無期限に続行されます。 しかし、解決策はありません。 1 つの方法は、これまでの会話を要約することです。入力テキストの長さが所定のしきい値に達すると、会話の一部を要約するクエリがトリガーされ、要約された部分がシステム メッセージの一部になる可能性があります。 さらに、会話中にバックグラウンドでこれまでの会話を要約することができます。 もう 1 つのアプローチは、以前の会話を取得し、埋め込みベースの検索を使用して効率的な知識の検索を行うことです。3. 長い文書を段落ごとに要約し、完全な要約を再帰的に構築します。

それでも問題は、テキストが長すぎることです。 たとえば、GPT-4 で本を要約したい場合、一連のクエリを使用して本の各部分を要約できます。 次に、部分的な概要を接続して要約し、一般的な答えを形成します。 このプロセスは、書籍全体が要約されるまで再帰的に実行できます。 ただし、一部の部分では、後続の部分を理解するために前の部分から情報を借用する必要がある場合があります。ここにトリックがあります:今回の内容を要約する場合は、本文中の今回の内容よりも前の内容をまとめてまとめます。

簡単に言うと、前節の「まとめ」を今節まで流用して、まとめます。

OpenAI は以前、GPT-3 に基づいてトレーニングされたモデルを使用して、本の要約の効果を研究しました。

戦略 4: GPT に「考える」時間を与える

17 掛ける 28 を計算するように求められたら、計算できないかもしれません。すぐにわかりますが、時間が経てば答えは計算できます。

同様に、GPT-4 は質問を受けたとき、じっくり考える時間をとらず、すぐに答えようとするため、推論に誤りが生じる可能性があります。

したがって、モデルに答えを求める前に、まずモデルに一連の推論プロセスを実行してもらい、推論を通じて正しい答えに到達できるようにします。

実践的なヒント:

1. モデルに解決策を定式化させます

次のことを明確にすると、次のことがわかるかもしれません。結論に達する前に第一原理から推論するようにモデルに指示すると、より良い結果が得られます。

たとえば、数学の問題に対する生徒の解答をモデルで評価したいとします。

最も直接的な方法は、生徒の答えが正しいかどうかをモデルに単純に尋ねることです。

上の図では、GPT-4 は生徒の解答が正しいと信じています。

しかし実際には、生徒の計画は間違っています。

この時点で、モデルにこれを認識させるために、モデルに独自のソリューションを生成するよう促すことができます。

モデルは、独自の解決策と推論を生成した後、前の生徒の解決策が間違っていることに気づきました。

2. 隠れた推論プロセス

前述したように、モデルに推論を実行させ、解決策を提供します。

しかし、一部のアプリケーションでは、モデルが最終的な答えに到達する推論プロセスがユーザーと共有するのに適していません。

たとえば、宿題の個別指導では、生徒が問題に対する独自の解決策を考え、正しい答えに到達することを奨励したいと考えています。しかし、生徒の解決策に関するモデルの推論によって、生徒に答えが明らかになる可能性があります。

現時点では、モデルが「内なる独白」戦略を実装し、ユーザーから隠すべき出力の部分を構造化された形式にモデルが配置できるようにする必要があります。

出力は解析され、ユーザーに表示される前に出力の一部のみが表示されます。

次の例のように:

まず、モデルに独自の解決策を定式化させてから (学生の解決策が間違っている可能性があるため)、次にそれを学生の解決策と比較します。

生徒が解答のいずれかのステップで間違えた場合は、生徒に完全な正解を直接与えるのではなく、モデルにこのステップのヒントを与えます。

生徒がまだ間違っている場合は、前のステップに進みます。

「クエリ」戦略を使用することもできます。この戦略では、最後のステップを除くすべてのクエリの出力がユーザーから非表示になります。

まず、モデルに問題を独自に解決するように依頼できます。この最初のクエリは学生の解決策を必要としないため、省略できます。これにより、モデルの解が生徒の解のバイアスの影響を受けないという追加の利点も得られます。

次に、モデルに利用可能なすべての情報を使用して、生徒の解答の正しさを評価させることができます。

最後に、モデルに独自の分析を使用してメンターの役割を構築させることができます。

あなたは数学の家庭教師です。生徒が間違って答えた場合は、答えを明かさずに生徒に促します。生徒が正解した場合は、励ましのコメントを与えるだけです。

3. コンテンツが欠落しているかどうかをモデルに確認する

GPT-4 に特定のソース ファイルの抜粋をリストするよう依頼しているとします。各抜粋が書き込まれた後、モデルは次の抜粋の書き込みを続けるか停止するかを決定する必要があります。

ソース ファイルが大きい場合、モデルは多くの場合途中で停止し、関連するすべての抜粋をリストできなくなります。

この場合、多くの場合、モデルに後続のクエリを実行させて、前の処理で見逃した抜粋を見つけることができます。

つまり、モデルによって生成されるテキストは非常に長くなる可能性があり、一度に生成できないため、テキストを確認して不足している内容を埋めることができます。

実践的なヒント:

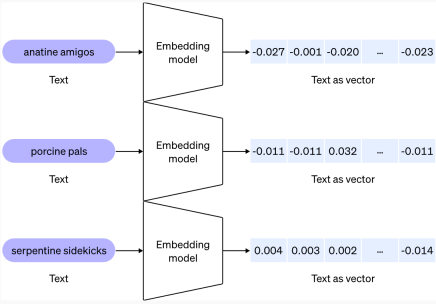

1. 埋め込みベースの検索を使用して効率的なナレッジ検索を実現します

このヒントは上記に記載されています記事の中で言及されています。 追加の外部情報がモデルの入力に提供されると、モデルがより適切な答えを生成するのに役立ちます。 たとえば、ユーザーが特定の映画について質問する場合、その映画に関する情報 (俳優、監督など) をモデルの入力に追加すると便利な場合があります。 埋め込みを使用すると、モデルの実行中に関連情報をモデルの入力に動的に追加することで、効率的なナレッジの取得が可能になります。 テキスト埋め込みは、テキスト文字列の関連性を測定するベクトルです。類似または関連する文字列は、無関係な文字列よりも緊密に結合されます。これは、高速ベクトル検索アルゴリズムの存在と組み合わせることで、埋め込みを使用して効率的な知識検索を実現できることを意味します。 特に、テキスト コーパスを複数の部分に分割し、各部分を埋め込んで保存することができます。次に、クエリが与えられると、ベクトル検索を実行して、クエリに最も関連するコーパス内の埋め込みテキスト部分を見つけることができます。2. より正確な計算を行うにはコード実行を使用するか、外部 API を呼び出します

正確な計算をモデル自体だけに依存することはできません。 必要に応じて、自律計算を実行するのではなく、コードを記述して実行するようにモデルに指示できます。 実行するコードを指定した形式にするようにモデルに指示できます。出力が生成された後、コードを抽出して実行できます。出力が生成された後、コードを抽出して実行できます。最後に、コード実行エンジン (つまり、Python インタープリター) の出力は、必要に応じて次の入力として使用できます。

戦略 6: 変更を系統的にテストする

変更によってシステムが改善されるか悪化しないかを判断するのが難しい場合があります。 。

いくつかの例を見ることでどちらが優れているかを確認することは可能ですが、サンプルサイズが小さいと、実際に改善が見られたのか、それとも単なる偶然の幸運なのかを区別するのは困難です。

おそらく、この「変更」により、一部の入力の有効性は向上しますが、他の入力の有効性は低下する可能性があります。

評価手順 (または「eval」) は、システム設計を最適化するのに非常に役立ちます。優れた評価には次の特徴があります。

1) 現実世界の使用法 (または少なくともさまざまな使用法) を表します

2) より優れた統計的検出力を達成するために多くのテスト ケースが含まれています (表を参照)以下)

3) 自動化または反復の容易さ

出力の評価は、コンピューターによって行うことも、手動で評価することもできます。または両方の組み合わせ。コンピューターは、客観的な基準を使用して自動的に評価することも、モデルを使用してモデルを評価するなど、主観的またはあいまいな基準を使用することもできます。

OpenAI は、自動評価を作成するためのツールを提供するオープン ソース ソフトウェア フレームワークである OpenAI Evals を提供します。

モデルベースの評価は、同等の高品質の出力が連続する場合に役立ちます。

実践的なヒント:

1. ゴールドスタンダードの答えを参照してモデルの出力を評価します

既知の質問に対する回答は、特定の一連の既知の事実を参照する必要があります。

その後、答えに必要なファクトがいくつ含まれているかをモデルに尋ねることができます。

たとえば、次のシステム メッセージを使用します。

必要な確立された事実を入力してください:

ニール アームストロングは月面を歩いた最初の人間でした。

ニール・アームストロングが初めて月面に着陸した日は1969年7月21日でした。

答えに指定された事実が含まれている場合、モデルは「はい」と答えます。それ以外の場合、モデルは「いいえ」と答え、最後に「はい」の答えが何個あるかをモデルに数えさせます。

以下には 2 つが含まれます。入力例 (イベントと時間の両方あり):

確立された事実を 1 つだけ満たす入力例 (時間なし):

次の入力例には確立された事実が含まれていません:

#これは、専門家の回答 (ニール アームストロングが月面歩行を行った 2 人目の人類であるということ) と直接矛盾する回答を含む入力例です。

#これは、専門家の回答 (ニール アームストロングが月面歩行を行った 2 人目の人類であるということ) と直接矛盾する回答を含む入力例です。

最後のものは、正しい答えを含むサンプル入力ですが、必要以上に詳細な情報も提供しています (時刻はちょうど 02:56、そして次のことを指摘しています)これは人類史上不滅の功績です):

ポータル: https://github.com/openai/evals (OpenAI Evals)

以上がGPT-4 の最も完全な戦略がここにあります。 OpenAIが正式リリース、半年間の経験を全て詰め込むの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

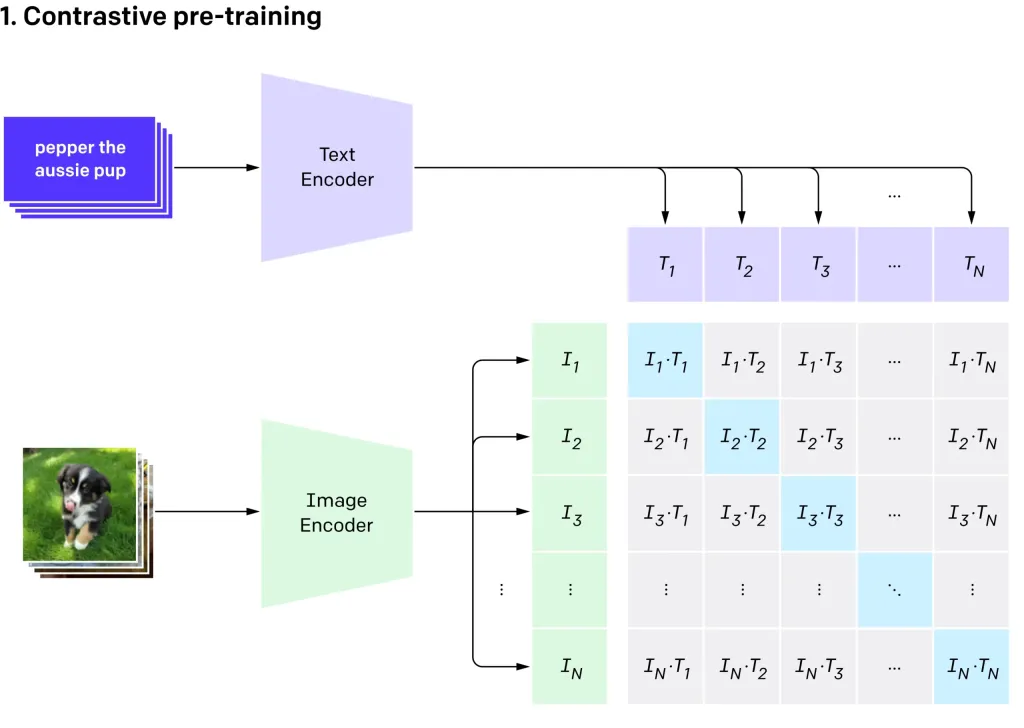

Openai'のクリップVIT-L14を使用したゼロショット画像分類Apr 11, 2025 am 10:04 AM

Openai'のクリップVIT-L14を使用したゼロショット画像分類Apr 11, 2025 am 10:04 AMOpenaiのクリップ(コントラスト言語 - イメージ前訓練)モデル、特にクリップVIT-L14バリアントは、マルチモーダル学習と自然言語処理の大幅な進歩を表しています。 この強力なコンピュータービジョンシステムは、RepreSeに優れています

コードなしでAIエージェントを構築するための7つのステップ-AnalyticsVidhyaApr 11, 2025 am 10:03 AM

コードなしでAIエージェントを構築するための7つのステップ-AnalyticsVidhyaApr 11, 2025 am 10:03 AMWordwareを使用してAIエージェントのパワーを活用してください:楽なAIエージェント作成のためのノーコードプラットフォーム。 AIエージェントは、コンピューターとの対話方法、タスクの自動化、意思決定の合理化に革命をもたらしています。 このブログは、構築方法を示しています

モバイルのLLMS:現在および将来の可能性 - 分析vidhyaApr 11, 2025 am 09:58 AM

モバイルのLLMS:現在および将来の可能性 - 分析vidhyaApr 11, 2025 am 09:58 AM生成AI:次のスマートフォンの戦場 スマートフォン業界は、高度な生成AIを統合するための競争である激しい競争に閉じ込められています。 ユーザーの相互作用の向上から生産性の向上まで、利害関係は高いです。 AppleのiPhone16

2025年に続くトップ10の生成AIサブレッドディット - 分析vidhyaApr 11, 2025 am 09:51 AM

2025年に続くトップ10の生成AIサブレッドディット - 分析vidhyaApr 11, 2025 am 09:51 AM生成AI:10の必須redditコミュニティへのガイド 生成AIは急速に進化しており、新しいモデルが絶えず出現しています。 更新のままであることが重要であり、Redditはこの分野に特化した活気のあるコミュニティを提供しています。この記事はtを強調しています

AIモデルの重要な課題と制限 - 分析VidhyaApr 11, 2025 am 09:44 AM

AIモデルの重要な課題と制限 - 分析VidhyaApr 11, 2025 am 09:44 AM導入 人工知能(AI)は、AIの研究開発への実質的な投資によって促進されたさまざまな職場に急速に統合されています。 AIのアプリケーションは、仮想アシスタントのような単純なタスクからcomまで、幅広い範囲に広がっています

SQLでnull値を処理しますApr 11, 2025 am 09:37 AM

SQLでnull値を処理しますApr 11, 2025 am 09:37 AM導入 データベースの領域では、ヌル値はしばしば独自の課題を提示します。 欠落している、未定義、または未知のデータを表して、データ管理と分析を複雑にする可能性があります。顧客のフィードバックが欠落している販売データベースまたはORDEを検討してください

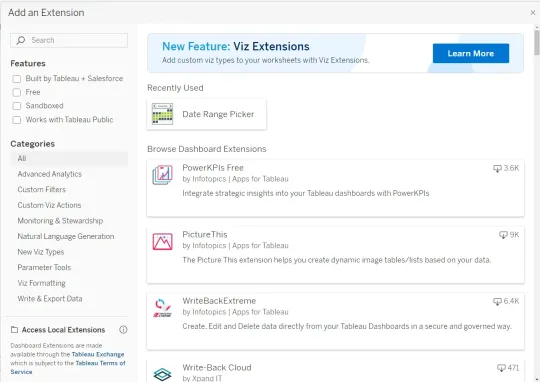

Google GeminiをTableau Dashboardsに統合する方法は?Apr 11, 2025 am 09:27 AM

Google GeminiをTableau Dashboardsに統合する方法は?Apr 11, 2025 am 09:27 AMTableauでGoogle Geminiのパワーを利用するダッシュボード:AI駆動の強化 Tableauの堅牢な視覚化機能、データ準備(Tableau Prep Builder)、データストーリーテリング(Tableau Desktop)、およびCollaborative共有(Table

ベクトル埋め込みとは何ですか?タイプとユースケースApr 11, 2025 am 09:18 AM

ベクトル埋め込みとは何ですか?タイプとユースケースApr 11, 2025 am 09:18 AMベクトル埋め込みのパワーのロックを解除:生成AIのガイド あなたの言語を話さない人にラグ(検索拡張生成)を説明することを想像してください - 困難な仕事ですよね? 今、マシンを検討してください

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

SublimeText3 Linux 新バージョン

SublimeText3 Linux 最新バージョン

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

SublimeText3 中国語版

中国語版、とても使いやすい

VSCode Windows 64 ビットのダウンロード

Microsoft によって発売された無料で強力な IDE エディター

mPDF

mPDF は、UTF-8 でエンコードされた HTML から PDF ファイルを生成できる PHP ライブラリです。オリジナルの作者である Ian Back は、Web サイトから「オンザフライ」で PDF ファイルを出力し、さまざまな言語を処理するために mPDF を作成しました。 HTML2FPDF などのオリジナルのスクリプトよりも遅く、Unicode フォントを使用すると生成されるファイルが大きくなりますが、CSS スタイルなどをサポートし、多くの機能強化が施されています。 RTL (アラビア語とヘブライ語) や CJK (中国語、日本語、韓国語) を含むほぼすべての言語をサポートします。ネストされたブロックレベル要素 (P、DIV など) をサポートします。