ホームページ >テクノロジー周辺機器 >AI >Yann LeCun: 社会規範に関係なく、ChatGPT は現実の人間とはかけ離れています

Yann LeCun: 社会規範に関係なく、ChatGPT は現実の人間とはかけ離れています

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-15 10:25:021421ブラウズ

OpenAI は 2022 年末に ChatGPT を開始し、その人気は今日まで続いています。このモデルは単に交通を歩くだけであり、どこへ行っても間違いなく熱狂的な議論を引き起こすでしょう。

大手テクノロジー企業、機関、さらには個人も、ChatGPT のような製品の研究開発を強化しています。同時に、Microsoft は ChatGPT を Bing に接続し、Google は検索エンジンを強化するために Bard をリリースしました。 NVIDIA CEO の Jensen Huang 氏は、ChatGPT を高く評価し、ChatGPT は人工知能分野における iPhone の瞬間であり、コンピューティング史上最も偉大なテクノロジーの 1 つであると述べました。

多くの人は会話型 AI が登場したと信じていますが、これらのモデルは本当に完璧なのでしょうか?必ずしもそうとは限りませんが、彼らの中には、自由奔放な発言をしたり、世界征服の計画について雑談したりするなど、常に不気味な瞬間が存在します。

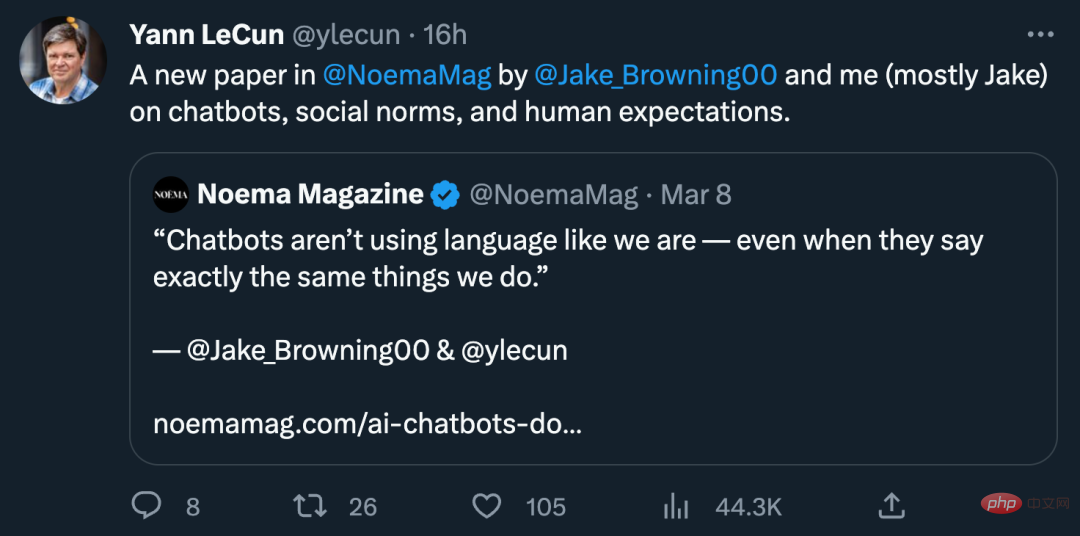

会話型 AI のこうした不条理な瞬間を理解するために、深層学習の 3 人の巨人の 1 人であるヤン ルカン氏と、ニューヨーク大学コンピューター サイエンス学部の博士研究員であるジェイコブ ブラウニング氏は共同で次の論文を書きました。記事「AI チャットボットは社会規範を気にしない」では、チャットボット、社会規範、人間の期待という会話型 AI の 3 つの側面について説明しています。

#その記事では、人間は失言を避け、間違いや失礼な言動を防ぐのが非常に得意であると述べました。対照的に、チャットボットは間違いを犯すことがよくあります。したがって、なぜ人間が間違いを避けるのが得意なのかを理解することは、チャットボットが現在信頼できない理由をよりよく理解するのに役立ちます。

チャットボットは、モデルが間違ったことを言うのを防ぐために人間のフィードバックを追加します

GPT-3 の場合、間違いを犯す方法には、不正確なモデル統計が含まれます。 GPT-3 はユーザー プロンプトに大きく依存しており、コンテキストや状況などの理解は、ユーザー プロンプトから取得できるもののみに焦点を当てています。 ChatGPT にも同じことが当てはまりますが、新しくて興味深い方法でわずかに変更されています。統計に加えて、モデルの応答は人間の評価者によって強化されました。システムの出力については、人間の評価者が良い応答を出力するように強化します。その結果、システムはもっともらしいことを言うだけでなく、(理想的には)人間が適切だと判断するようなことも言うようになります。たとえモデルが間違ったことを言ったとしても、少なくとも他人を怒らせることはありません。

しかし、この方法は機械的すぎるように感じます。人間の会話では、間違ったことを言う方法が無数にあります。不適切なこと、不誠実なこと、混乱を招くこと、または単なる愚かなことを言うこともあります。私たちは正しいことを言っているのに、間違った口調やイントネーションを言ったことで批判されることさえあります。他人と関わる過程で、私たちは無数の「会話の地雷原」をくぐり抜けます。間違ったことを言わないようにすることは、会話の重要な部分であるだけでなく、多くの場合、会話そのものよりも重要です。場合によっては、口を閉ざすことが唯一の正しい行動かもしれません。

これは 2 つの疑問につながります。モデルが間違ったことを言わないという危険な状況をどのように制御できるでしょうか?そして、なぜチャットボットは間違ったことを言わないよう効果的に制御できないのでしょうか?

会話はどのように進めるべきですか?

人間の会話には、まるで台本があるかのように、あらゆるトピックが含まれます。レストランでの食べ物の注文、雑談、遅刻の謝罪など。ただし、これらは書かれた台本ではなく、即興に満ちているため、この人間の会話モデルはより一般的なモデルであり、ルールはそれほど厳密ではありません。

このスクリプト化された人間の言動は、言葉によって制限されません。言語が理解できなくても、相手が何を望んでいるのかを知るためにジェスチャーをするなど、同じスクリプトが機能します。社会規範はこれらのスクリプトを管理し、私たちが人生をナビゲートするのに役立ちます。これらの規範は、特定の状況で全員がどのように行動すべきかを指示し、各人に役割を割り当て、行動方法について広範な指針を与えます。規範に従うことは有益です。標準化および合理化することで対話が簡素化され、お互いの意図を予測しやすくなります。

人間は、どのフォークを使用するか、クラクションを鳴らすまでにどれくらいの時間待つべきかに至るまで、社会生活のあらゆる側面を管理するルーチンと規範を開発してきました。これは、私たちが出会う人々のほとんどがまったくの見知らぬ人であり、その信念が自分の信念と一致しない可能性がある、何十億人もの人々が住む世界で生き残るために非常に重要です。これらの共有規範を整備することで、会話が可能になるだけでなく、会話が実り豊かになり、話すべきことと話すべきではない事柄の概要が明確になります。

規範の裏側

人間は、規範に違反する者を、時には公然と、時には秘密裏に制裁する傾向があります。社会規範により、たとえば初デートで見知らぬ人を評価することが非常に簡単になります。会話や質問を通じて、双方が互いの行動を評価し、相手が規範のいずれかに違反していないかどうかを評価します。失礼または不適切 – 多くの場合、私たちは彼らを判断して 2 回目のデートを拒否します。

人間の場合、これらの判断は冷静な分析に基づいているだけでなく、世界に対する感情的な反応にも基づいています。子供の頃の教育の一部は、会話の中で適切なタイミングで適切な感情を確実に発するための感情訓練です。誰かがエチケットの規範に違反したときに怒り、誰かが攻撃的なことを言ったときに嫌悪感を抱き、嘘をついたときに嫌悪感を抱き、恥ずかしいと感じます。私たちの道徳的良心により、会話中の不適切な事柄に即座に反応し、他の人が自分の言葉にどのように反応するかを予測することができます。

しかし、それ以上に、単純な規範に違反した場合、その人の人格全体が問われます。もし彼が1つのことについて嘘をついたとしたら、他のことについても嘘をつくだろうか?したがって、開示は相手に恥をかかせることを目的としており、その過程で相手に自分の行動について謝罪(または少なくとも弁護)を強いることになります。規範も強化されました。

つまり、人間は社会規範を厳格に遵守する必要があり、そうでないと発言する危険が高くなります。私たちは自分の発言には責任があるので、慎重に発言を選び、周囲の人にも同じことを期待してください。

制約のないチャットボット

人間の会話は一か八かのリスクを伴うため、チャットボットが非常に不安になる原因が明らかになります。会話がどうなるかを予測するだけで、彼らは人間の規範に緩く従うことになりますが、その規範に縛られることはありません。私たちがチャットボットと気軽にチャットしたり、言語パズルを解く能力をテストしたりすると、多くの場合、チャットボットはもっともらしい答えを返し、通常の人間と同じように動作します。チャットボットを人間と間違える人もいるかもしれません。

しかし、プロンプトを少し変更したり、別のスクリプトを使用したりすると、チャットボットは突然陰謀論、人種差別的な暴言、またはナンセンスを吐き出します。これは、彼らが Reddit やその他のプラットフォームで陰謀論者や荒らしなどによって書かれたコンテンツで訓練されているためである可能性があります。

私たちの誰もが荒らしのようなことを言うことができますが、荒らしの言葉にはナンセンス、攻撃的な発言、残虐さ、不誠実さが満ちているため、そうすべきではありません。私たちのほとんどは、これらのことを信じていないため、これらのことを言いません。良識の規範により、攻撃的な行為は社会の片隅に押しやられており、私たちのほとんどはあえてそれを口にしないほどです。

対照的に、チャットボットは、統計的にどれだけ可能性が高くても、言ってはいけないことがあることに気づいていません。彼らは、発言することと発言しないことの境界を定義する社会規範に気づいておらず、私たちの言語使用に影響を与える深い社会的圧力にも気づいていません。チャットボットは自分が失敗したことを認めて謝罪しても、その理由がわかりません。私たちが間違っていると指摘すると、チャットボットは正しい答えを得るために謝罪さえします。

これは、より深い問題を浮き彫りにします。私たちは人間の話者がその発言に忠実であることを期待しており、その責任を彼らに負わせます。これを行うために彼らの脳を調べたり、心理学について何も理解する必要はありません。必要なのは、彼らが一貫して信頼でき、ルールに従い、信頼するために敬意を持って行動することを知ることだけです。チャットボットの問題は、チャットボットが「ブラック ボックス」であることやテクノロジーに不慣れであることではなく、改善の努力もされず、問題があったという認識さえなく、長い間信頼性が低く不快なままであったことです。問題。

開発者はこれらの問題を確実に認識しています。 AI テクノロジーを広く活用してもらいたい企業だけでなく、自社のチャットボットの評判を心配し、難しい会話を避けたり、不適切な応答を排除したりするためにシステムの再構築に多くの時間を費やしています。これはチャットボットの安全性を高めるのに役立ちますが、開発者はチャットボットを破ろうとする人々に対抗するために懸命に取り組む必要があります。その結果、開発者のアプローチは事後対応的で常に後手後手に回っており、物事がうまくいかない原因が多すぎて予測できません。

賢いけど人間ではない

人間がどれほど賢いのか、チャットボットがどれほど愚かであるのかについて、私たちが満足する必要はありません。むしろ、何でも話す彼らの能力は、人間の社会生活と世界全体についての深い(または表面的な)理解を明らかにします。チャットボットは、少なくともテストで良い成績を収めたり、有益な情報を提供したりするのに十分な賢さを備えています。チャットボットが教育者の間で引き起こしたパニックは、書籍に基づいた学習から学ぶ彼らの素晴らしい能力を雄弁に物語っています。

しかし問題は、チャットボットは気にしないことです。彼らには対話を通じて達成したい本質的な目標はなく、他人の考えや反応によって動機付けられることもありません。彼らは嘘をつくことに悪い気はせず、正直さが報われることもありません。トランプさえも少なくとも正直であると主張するほど自分の評判を気にしているほど、彼らは恥知らずだ。

したがって、チャットボットの会話は無意味です。人間にとって、会話は、つながりを作る、プロジェクトで助けを得る、時間を潰す、何かを学ぶなど、欲しいものを得る手段です。会話には、話している相手に興味を持ち、理想的には気を配る必要があります。

話している相手のことを気にしなくても、少なくとも相手が自分をどう思っているかは気になります。私たちは、人生の成功 (親密な人間関係を築く、良い仕事をするなど) は、良い評判に依存することを深く理解しています。社会的地位が低下すれば、私たちはすべてを失う危険があります。会話は他人が私たちをどのように見るかを形成し、私たちの多くは自分自身についての認識を形成するために内なる独白を使用します。

しかし、チャットボットには語るべき独自のストーリーや守るべき評判がありません。また、チャットボットは私たちと同じように責任を持って行動するという強い気持ちを感じません。チャットボットは、いくつか例を挙げると、ダンジョン マスターのプレイ、賢明なコピーの作成、著者のアイデア探索の支援など、高度にスクリプト化された多くの状況で役立ちます。しかし、彼らは、私たちがほとんどの場合話したいと思うような、信頼できる社会的エージェントになるための自分自身や他人についての知識が不足しています。

正直さと礼儀に関する規範を理解しておらず、自分の評判を気にしない場合、チャットボットの有用性は限られており、チャットボットに依存することは大きな危険を伴います。

奇妙な会話

したがって、チャットボットは人間のような方法で会話しているわけではなく、統計的に信じられそうな方法で会話するだけでは決して目的を達成することはできません。社会世界を真に理解していなければ、これらの AI システムは、どんなに機知に富んでいて雄弁に見えても、単なる退屈なおしゃべりにすぎません。

これは、これらの AI システムが単に非常に興味深いツールである理由と、人間がそれらを擬人化することができない理由を明らかにするのに役立ちます。人間は単に冷静な思考者や発言者であるだけでなく、本質的に規範を遵守する生き物であり、共有され強制された期待を通じて互いに感情的につながっています。人間の思考と発言は、人間自身の社会的性質に由来します。

純粋な対話は世界の広範な参加から切り離されており、人間との共通点は何もありません。チャットボットは、たとえ私たちと全く同じように話すことはあっても、私たちのような言語を使用しません。しかし結局のところ、彼らはなぜ私たちがこのように話すのかを理解していません、それは明らかです。

以上がYann LeCun: 社会規範に関係なく、ChatGPT は現実の人間とはかけ離れていますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。