ホームページ >テクノロジー周辺機器 >AI >推論速度はStable Diffusionの2倍で、画像の生成と修復を1つのGoogleモデルで行うことができ、新しいSOTAを実現します。

推論速度はStable Diffusionの2倍で、画像の生成と修復を1つのGoogleモデルで行うことができ、新しいSOTAを実現します。

- 王林転載

- 2023-04-14 18:49:031096ブラウズ

テキストから画像への生成は、2022 年に最も注目されている AIGC の方向性の 1 つであり、「Science」誌によって 2022 年の科学的ブレークスルー トップ 10 の 1 つに選ばれました。最近、Google の新しいテキストから画像への生成に関する論文「Muse: Text-To-Image Generation via Masked Generative Transformers」が大きな注目を集めています。

- 論文アドレス: https://arxiv.org/pdf/2301.00704v1.pdf

- プロジェクト アドレス: https://muse-model.github.io/

Google の以前の Imagen モデルと同様に、この調査では、現実的で高品質の画像生成には、事前トレーニングされた LLM に基づく調整が重要であることがわかりました。 Muse モデルは、Transformer (Vaswani et al.、2017) アーキテクチャに基づいて構築されています。

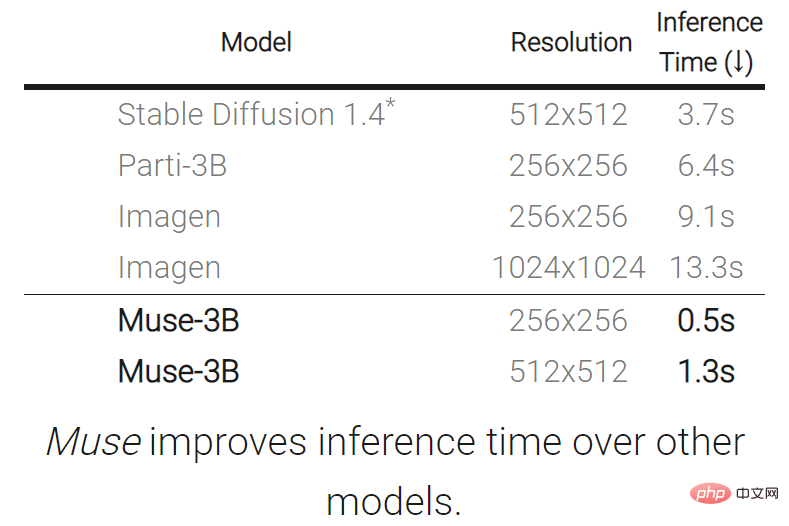

カスケードピクセル空間拡散モデルに基づく Imagen (Saharia et al., 2022) または Dall-E2 (Ramesh et al., 2022) との比較 Muse との比較、効率個別トークンの使用により大幅に改善されます。 SOTA 自己回帰モデル Parti (Yu et al., 2022) と比較すると、Muse は並列デコードを使用するため、より効率的です。

TPU-v4 での実験結果に基づいて、研究者らは、Muse の推論速度は Imagen-3B または Parti-3B モデルよりも 10 倍以上速く、Stable Diffusion v1 よりも速いと推定しています。 .4 (Rombach et al., 2022) 2 倍高速になります。研究者は、拡散モデルが Stable Diffusion v1.4 で使用されており、推論中に明らかにより多くの反復が必要になるため、Muse の方が Stable Diffusion よりも高速であると考えています。

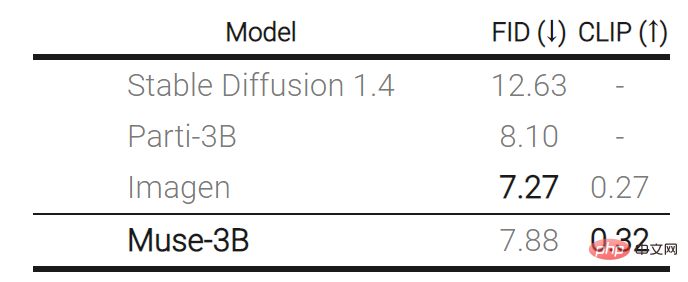

一方、Muse の効率が向上しても、生成される画像の品質が低下したり、入力テキスト プロンプトのモデルの意味理解が低下したりすることはありません。この研究では、CLIP スコア (Radford et al., 2021) や FID (Heusel et al., 2017) などの複数の基準に対して Muse の生成結果を評価しました。 Muse-3B モデルは、COCO (Lin et al., 2014) ゼロショット検証ベンチマークで CLIP スコア 0.32 および FID スコア 7.88 を達成しました。

Muse 生成効果を見てみましょう:

テキストと画像の生成: Muse モデルは、テキストから高品質の画像を迅速に生成します。 (TPUv4 では、解像度 512x512 のイメージを生成するのに 1.3 秒かかり、解像度 256x256 のイメージを生成するのに 0.5 秒かかります)。たとえば、「自転車に乗っているクマとハンドルバーに止まっている鳥」を生成します。

モデルの紹介

モデルの紹介

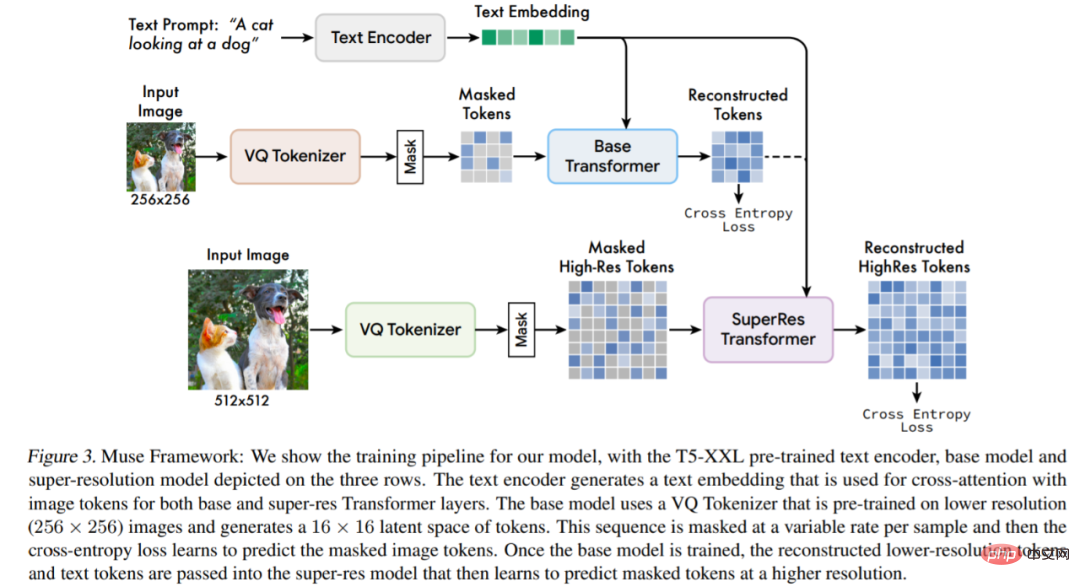

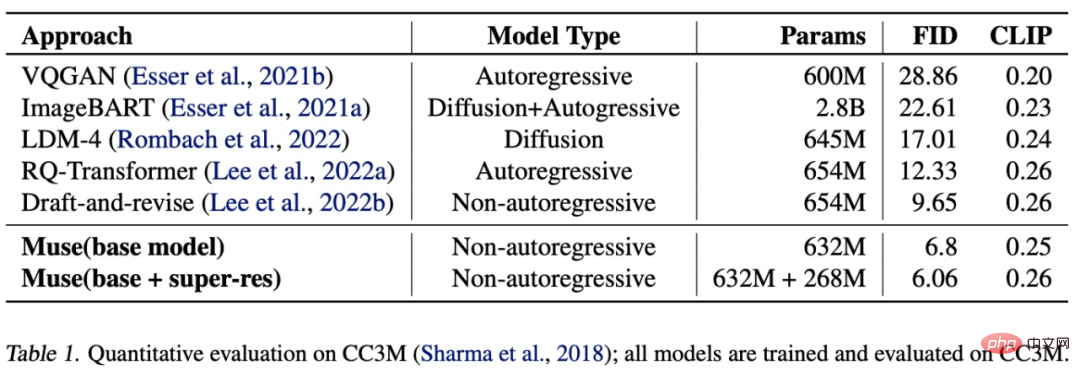

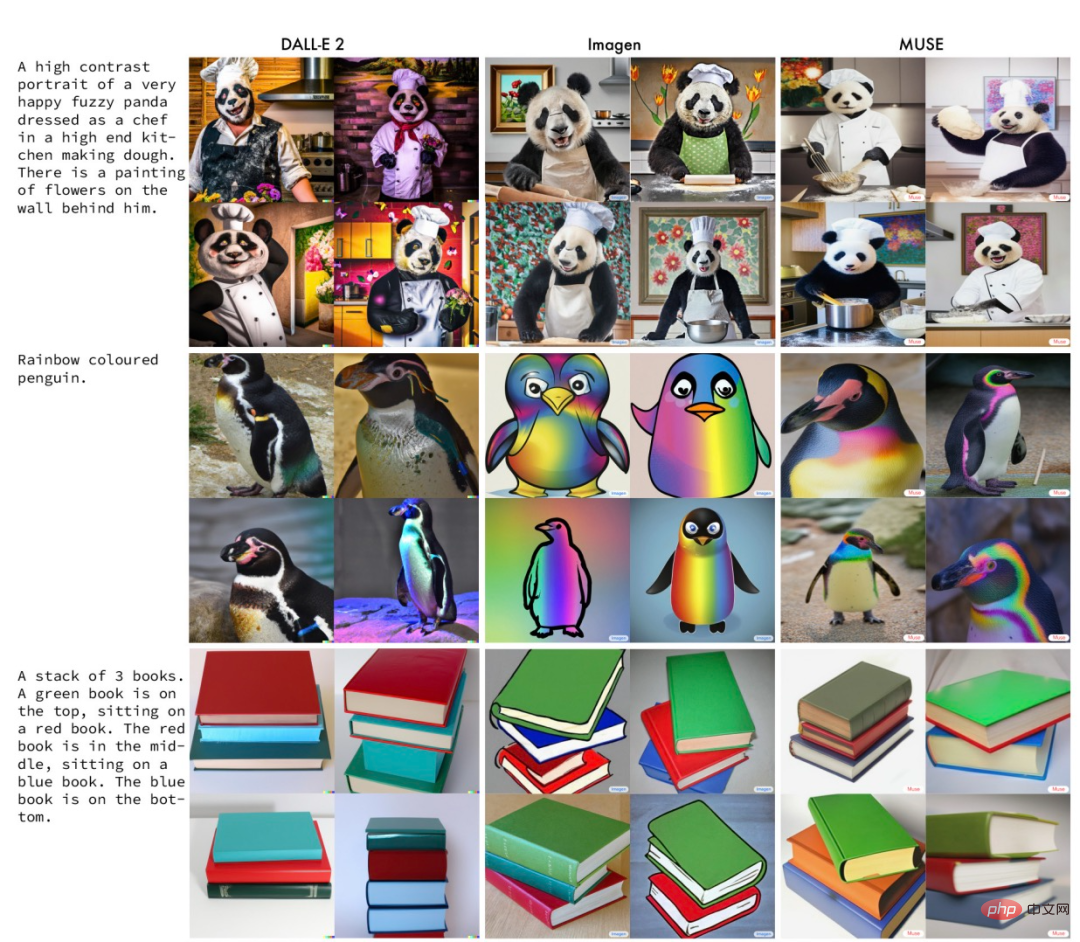

事前トレーニングされたテキスト エンコーダー: この研究では、事前トレーニングされた大規模言語モデル (LLM) を利用すると画像生成の品質を向上できることがわかりました。彼らは、Muse モデルが LLM 埋め込みの豊富な視覚的および意味論的な概念を生成された画像にマッピングすることを学習したと仮説を立てました。この研究では、入力テキストのサブタイトルが与えられると、それをフリーズされた T5-XXL エンコーダーに通し、言語埋め込みベクトルの 4096 次元シーケンスが生成されます。これらの埋め込みベクトルは、Transformer モデルに線形投影されます。 VQGAN を使用したセマンティック トークン化: このモデルのコア コンポーネントは、VQGAN モデルから取得したセマンティック トークンの使用です。このうち、VQGANはエンコーダとデコーダで構成され、量子化層は入力画像を学習コードブックのトークン列にマッピングします。この研究ではすべて、畳み込み層を使用してエンコーダとデコーダを構築し、さまざまな解像度の画像のエンコードをサポートしています。 基本モデル: 基本モデルは、入力が埋め込みと T5 に投影されたイメージ トークンであるマスク トランスフォーマーです。この研究では、すべてのテキスト埋め込みを (マスクなしで) 保持し、異なる比率の画像トークンをランダムにマスクし、特別な [マスク] トークンに置き換えます。 超解像度モデル: この研究では、モデルのカスケードを使用することが有益であることが判明しました。まず、16 × 16 の潜在マップ (256 × 256 の画像に相当) を生成する基本モデルを使用します。基本潜在マップは、64 × 64 潜在マップ (512 × 512 画像に相当) である超解像度モデルにアップサンプリングされます。 デコーダの微調整: モデルの詳細を生成する能力をさらに向上させるために、この研究では、エンコーダの容量を維持しながら、より多くの残留レイヤとチャネルを追加することで VQGAN デコーダの容量を増加します。変更なし。その後、VQGAN エンコーダーの重み、コードブック、トランスフォーマー (つまり、ベース モデルと超解像度モデル) をフリーズしながら、新しいデコーダー レイヤーが微調整されます。 Muse には、上記のコンポーネントに加えて、可変マスク比コンポーネント、推論中の反復並列デコード コンポーネントなども含まれています。 以下の表に示すように、Muse は他のモデルと比較して推論時間を短縮します。 #次の表は、ゼロショット COCO のさまざまなモデルによって測定された FID スコアと CLIP スコアを示しています。 以下の表に示すように、Muse (632M (ベース) 268M (超解像度) パラメーター モデル) は、CC3M データセットでトレーニングおよび評価した場合、6.06 の SOTA FID スコアを取得しました。 次の図は、同じプロンプトで Muse、Imagen、および DALL-E 2 によって生成された結果の例です。 興味のある読者は、論文の原文を読んで研究の詳細を学ぶことができます。 実験と結果

以上が推論速度はStable Diffusionの2倍で、画像の生成と修復を1つのGoogleモデルで行うことができ、新しいSOTAを実現します。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。