テクノロジー周辺機器

テクノロジー周辺機器 AI

AI スチュアート・ラッセル氏へのインタビュー: ChatGPT に関して、より多くのデータとより多くのコンピューティング能力が真のインテリジェンスをもたらすことはできません

スチュアート・ラッセル氏へのインタビュー: ChatGPT に関して、より多くのデータとより多くのコンピューティング能力が真のインテリジェンスをもたらすことはできませんスチュアート・ラッセル氏へのインタビュー: ChatGPT に関して、より多くのデータとより多くのコンピューティング能力が真のインテリジェンスをもたらすことはできません

『Artificial Intelligence: A Modern Approach』の第 4 版中国語版が最近リリースされ、Machine Heart は著者のスチュアート ラッセル教授に独占インタビューを実施しました。 AI 分野の古典として、『Artificial Intelligence: A Modern Approach』は何度か再版され、内容と構成は 2 人の著者の進化する理解が反映されています。最新の第4版は、過去10年間のAIの進歩、特にディープラーニングの影響を全体的な枠組みに組み込んだ上での最新の解説であり、人工知能のトレンドとこの主題の発展に対する両巨匠の洞察が反映されています。システム。

このインタビューも「現代的なアプローチ」に従っており、テクノロジーのトレンドと知能理論について、開発に沿った観点からラッセル教授の見解を示したいと考えています。テクノロジーと時代の概念、一般的な考え方と古典的な考え方を比較し、AI 研究者や実践者にインスピレーションをもたらします。

スチュアート ラッセルはカリフォルニア大学バークレー校で働き、現在は大学の教授を務めています。コンピュータサイエンス学科(元学科長)、人間互換人工知能センター所長。 1990 年に優秀な若手科学者に与えられる全米科学財団大統領賞を、1995 年には IJCAI コンピューティングおよびアイデア賞を受賞しました。彼は AAAI、ACM、AAAS のフェローであり、人工知能の分野で幅広いトピックをカバーする 300 以上の論文を発表しています。画像出典: kavlicenter.berkeley.edu

ラッセル教授は、今後 10 年間で、人々の焦点はエンドツーエンドのディープ ネットワークへの依存から移行すると考えています。学習し、モジュール式で数学的に論理的で意味的に明確に定義された表現で構成されるシステムに戻り、深層学習は、生の感覚データを取得する上で重要な役割を果たします。モジュール式で意味的に明確に定義された表現は、手動で設計したり柔軟性に欠けたりする必要はなく、そのような表現はデータから学習できることを強調することが重要です。

人気のある ChatGPT について、ラッセル教授は、タスク領域を区別し、どのような状況で使用されるかを把握することが重要であると考えています。非常に良い 事実に基づいて計画システムと統合すると、より大きな価値をもたらすツール。問題は、ChatGPT がどのように機能するのか現時点では不明であり、おそらくそれを理解できないことです。そのためには、予測が難しい概念的なブレークスルーが必要になるでしょう。

彼は、真にインテリジェントなシステムを構築するには、数学的論理と知識推論にもっと注意を払うべきだと信じています。なぜなら、私たちが理解している方法に基づいてシステムを構築する必要があるからです。 AIが制御不能にならないようにするためです。彼はスケールアップが解決策であるとは信じておらず、より多くのデータとより多くのコンピューティング能力が問題を解決できるとも信じていません。これはあまりにも楽観的で、知的に面白くありません。

深層学習データの非効率性という根本的な問題を無視すると、「真のインテリジェンスに向かって進んでいると自分自身を騙しているのではないかと心配です。本当に重要なことは、実際にはまったくスマートなモデルではないものに、より多くのピクセルを追加することだけです。」

#-1-

##Heart of the Machine: ChatGPT に代表される大規模な事前トレーニング済み言語モデル (LLM) は本質的に人工知能をより高いレベルに引き上げると思いますか? LLM は、常識の獲得や知識の推論など、深層学習システムのいくつかの基本的な問題を克服しますか?

スチュアート・ラッセル: 私の頭に浮かぶ最初の答えは、「いいえ、わからないから」です。モデルがどのように機能するかは、モデルを作成する人も含めて誰もが知っています。

ChatGPT は何を知っていますか?推理できるでしょうか?どのような意味で答えが理解できますか?我々は知りません。

オレゴン州立大学の友人がモデルに「象と猫、どちらが大きいですか?」と尋ねると、モデルは「象のほうが大きいです」と答えました。 「象と猫ではどちらが大きいですか?」と質問すると、モデルは「象も猫もどちらか一方より大きくありません」と答えました。つまり、モデルは象と猫のどちらが大きいかを知っているということですか?別の方法で尋ねると、矛盾した結論が得られるため、わかりません。

#それでは、モデルは何を知っているのでしょうか?

別の例を挙げましょう。これも実際に起こったことです。これらのモデルのトレーニング データには、統一されたコードとシンボルで表される多数のチェス ゲームが含まれています。ゲームは、シーケンス e4 e5 Nf3 Nc6 Bb5... のように見えます。プレイヤーは、これらのシンボルの意味と、これらのシーケンスによって描かれる動きを知っています。しかし、モデルは知りません。モデルはチェス盤があることも、動きも知りません。モデルにとって、これらの記号は単なる記号にすぎません。したがって、これでブラインド チェスをプレイし、「チェスをプレイしましょう、g4」と言うと、「e6」と応答する可能性があります。もちろん、これは良い手かもしれませんが、モデルにはチェスをプレイするという概念がありません。ただ学習するだけです。トレーニング データ内で類似したシーケンスを検索し、これらのシーケンスに対して適切な変換を実行して、次の手を生成します。 80%、あるいは 90% の確率で良い手を生み出すこともありますが、それ以外の場合には、チェス盤上で手を打つという概念がないため、愚かな、または完全にルールに反する手を打つこともあります。

チェスだけでなく、これは実際に大きなモデルが現在行っているすべてのことに当てはまると思います。80% の場合、それは非常に賢い人のように見えますが、残りの 20% の場合は完全にバカに見えます。

データがたくさんあるので賢そうに見えますが、これまで人間が書いた本や記事はほぼすべて読んできましたが、それにもかかわらず、After では膨大な量の有用な情報を受け取っても、それが何を意味するのかわからないことを吐き出します。この意味で、大規模な言語モデルはおそらく人工知能の進歩ではないと思います。

ChatGPT の本当に優れている点は、ユーザーとの会話と以前に読んだテキストを一般化する機能です。類似点を見つけて適切な変換を行うことができることです。 したがって、その答えは賢明だと思われます。ただし、モデルがこれをどのように行うのか、この一般化機能の境界がどこにあるのか、そしてこの一般化が回路にどのように実装されるのかがわかりません。

それを本当に知っていれば、それを基礎として使用して開発できるため、それは確かに人工知能の進歩であると言えます。 ChatGPT システムに基づくその他のアプリケーション。しかし現段階では、すべてが謎のままだ。私たちが前進できる唯一の方法は、モデルが機能しない場合ですか?さて、さらにデータを与えて、モデルをもう少し大きくしましょう。

#スケールアップが解決策だとは思いません。データはいずれ枯渇し、現実世界では常に新たな状況が発生しています。私たちがチェス プログラムを作成するとき、本当にチェスを上手にプレイできるプログラムは、これまでに見たことのない状況に対処できます。理由は 1 つだけです。それは、これらのプログラムがチェスのルールを理解し、チェスの駒を進化させることができるからです。チェス盤上の位置、つまり駒を動かすことができる点と、チェスのゲームで記録されたことのない手を含む対戦相手の可能な次の動きを視覚化します。

#一般的な現実世界の状況でこれを実行できるようになるには、まだ程遠いです。同時に、言語の大きなモデルがこの目標の達成に近づくとは思えません。ただし、言語の大規模なモデルにより、テキストに保存された人間の知識を使用できるようになります。

#大規模な言語モデルは、既知の事実に固定できればさらに便利になります。 5,000 億の事実を含む Google ナレッジ グラフについて考えてみましょう。ChatGPT がこれらの事実に基づいて、これらの事実に関連する質問に正しい答えを与えることができれば、ChatGPT の信頼性はさらに高まります。

大規模な言語モデルを、正しく推論して計画できる推論エンジンに結合する方法を見つけることができれば、画期的な進歩を遂げたと言えるでしょう。人工知能 ボトルネック。現在、私たちは多くの計画アルゴリズムを持っていますが、これらの計画アルゴリズムに車の組み立てなどの正しく合理的な計画を実行させ、必要な知識を提供することは、理解する必要があることが多すぎるため困難です。すべてを書き留めて、すべてが正しいことを確認するのは非常に困難です。しかし、言語の大きなモデルは、車に関するあらゆる本を読んでおり、おそらく必要な知識を構築するのに役立ち、または必要に応じて必要な質問に答えるだけで、計画を立てるときにこれらの知識をすべて把握できるようになります。

ChatGPT を何かを行うのに役立つブラック ボックスとして単に見るのと比較して、 大規模な言語モデルと計画アルゴリズムを組み合わせて、計画システムに知識を入力します。真に価値のあるビジネス ツールにつながります。私の知る限り、この方向に取り組んでいる人々はすでに存在しており、成功すれば大きな進歩となるでしょう。

Heart of the Machine: 教師として、ChatGPT についてどう思いますか。学生に ChatGPT を使用してレポートを作成させることを許可しますか?ユーザーとして、ChatGPT が生み出したさまざまなアプリケーション、特に商用アプリケーションについてどう思いますか?

スチュアート・ラッセル: 数週間前、私が世界経済フォーラムに出席していたときのことです。ダボス ビジネスの世界の人々と話すとき、誰もが言語の大きなモデルと、それを会社でどのように使用しているかについて私に尋ねます。

次のように考えることができると思います。つまり、6 歳の子供をあなたの会社で同じポジションに置きますか?

両者には能力差はありますが、こんな感じで比較できるのではないかと思います。大きな言語モデルやChatGPTは信頼できず、常識がなく、間違った情報を真面目に流します。したがって、社内で ChatGPT または同様のモデルを使用する場合は、十分に注意する必要があります。社内の特定の役職や責任をネットワーク内のノードとして考えると、言語はこれらのノードで入力および出力されます - もちろん、このように考えることもできます。これは、ジャーナリストや教授などの多くの仕事に当てはまります。 。 そんなこと。ただし、それを ChatGPT に置き換えることができるという意味ではありません。

#教育に関しては、非常に慎重でなければなりません。 ChatGPT の出現により、多くの人がパニックに陥りました。ああ、学校では ChatGPT を無効にしなければならない、と言う人もいます。 19世紀の議論を引き合いに出して、ChatGPTを禁止するのはばかばかしいと言う人もいた - 誰かが機械式電卓を禁止しなければならないと言ったとき、もし学生が機械式電卓を使い始めたら、彼らは決して学べなくなるからだ、と誰かが言った。

# これは説得力があるように思えませんか? ChatGPT を禁止する必要があるように思えませんか?しかし、このたとえは完全に間違っています。機械式計算機は、まったく同じ機械的なプロセスを自動化します。 26 桁の数値の掛け算は非常に機械的な一連の指示であり、答えを得るには、ステップバイステップ、ステップバイステップで手順に従うだけです。特にその人が指示の内容を理解していない場合、指示に従うことの知的価値は限られています。

しかし、ChatGPT が置き換えるのは、指示に機械的に従うことではなく、質問に答える能力、読んで理解する能力、アイデアを整理する能力です。書類。これらも学ばずにChatGPTに任せてしまうと、本当にダメ人間になってしまうかもしれません。

今では電子計算機がありますが、私たちは今でも子供たちに算数を教えており、算術のルールを教え、数字が何であるかを理解できるように努めています。それは物理世界の物事などに対応します。彼らがこのことを理解し、算術の規則を習得した後にのみ、私たちは彼らに電子計算機を与え、機械的な手順に従う必要がないようにします。

#私たちの時代、電卓がなかったとき、私たちはさまざまなサイン、コサイン、対数関数の値が記載された印刷された表を使用していました。は、これらの表を使用して数学を学ぶことはできないと言ったことがある。

#したがって、学生が ChatGPT のようなツールを使い始めるのに適切な時期はいつなのかを判断する必要があります。あなたの質問に答えるために、論文を書くというタスクの頭の悪い部分を見つけることができたなら、実際、論文を書くのは頭が働かず、単調で退屈なプロセスを機械的に繰り返すだけのことがよくありますが、あなたはおそらく ChatGPT が利用可能であり、それについては問題ありません。

#しかし、書くことは退屈なプロセスばかりではありません。書くことは本質的に思考の一種であり、人々が考えることを学ぶ方法でもあります。私たちが最も望んでいないのは、質問も答えも理解せずに ChatGPT を盲目的に使用する人です。

ChatGPT の他のアプリケーション (画像や音楽の生成など) についても、状況は似ていると思いますが、重要なのはタスク領域を明確に区別することです。アートを作るプロセスは大きく2つに分けられると思います。まず作りたいものをイメージし、次にそのビジョンに基づいて実際にそれを作成する比較的機械的なプロセスです。人によっては、後者は非常に難しく、どれだけ頑張っても見栄えの良い写真を作ることができないため、特別な訓練を受けたアーティスト、特に商業アーティストがその仕事にあまり創造性を必要とせず、より注意を払っています。ニーズに応じて写真を作成する能力。とても脅かされている職業だと思います。

本を書いているときにこのような経験をしました。『人工知能: 現代的なアプローチ』には 500 ~ 600 枚の図があり、そのほとんどすべてが私が描いたものです。優れたイラストや図を作成するには、時間と労力がかかり、多くのスキルとスキルが必要です。私の本にあるような図や技術的なイラストを作成する大規模なモデルやアプリケーションがあれば、喜んで使用するでしょう。

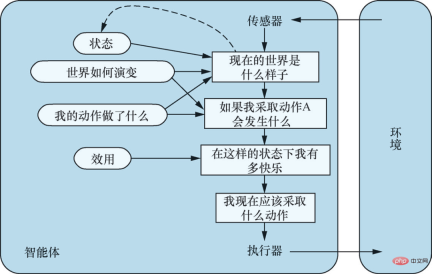

モデルベース、ユーティリティベースのエージェント。出典: 『人工知能: 最新のアプローチ (第 4 版)』図 2-14

万能学習エージェント。出典: 『人工知能: 最新のアプローチ (第 4 版)』 図 2-15

-2-# #心心: ChatGPT の原理はわかりませんが、エンジニアリング実装を通じて、特定の状況で役立つツールを入手しました。ChatGPT は、人々を参加させる良い例でもあるようです。 ChatGPT はエンジニアリングの観点から見た改良版ですか?

Stuart Russell: ChatGPT をプロジェクトと呼んでいいのかわかりません。一般的に言えば、私たちは「工学」とは、物理学、化学、機械学、電子工学などの知識を組み合わせて、複雑かつ独創的な方法で人間に役立つものを生み出す応用工学科学の学問であると考えています。同時に、それらの有用な特性は特定の方法によって実現され、再現できるため、これらのものがなぜ役立つのかも理解できます。

#しかし、ChatGPT はどのようにして開発したのでしょうか?人間のフィードバックを組み込むことは有用ですが、結果から判断すると、ChatGPT は多数のデータセットに対して勾配降下法を実行することによって得られました。これは 1950 年代を思い出させます。当時は遺伝的プログラミングに多大な努力が払われ、生物進化をシミュレートすることで知能を実現することが期待されていた Fortran プログラムは惨めに失敗しました。

理論的には、十分な Fortran プログラムがあり、それらに十分な突然変異を生成させると、原理的には人間よりも賢いものを生み出すことが可能です。しかし、この可能性は原則として実際には実現していません。

# さて、十分な大きさの回路と十分なデータで勾配降下法を実行すると、突然真のインテリジェンスを作成できるようになりますか?私は、その可能性は低いと思います。Fortran プログラムが進化するよりも少し高いかもしれませんが、Fortran プログラムが回路よりも強力な機能を持つ一種の表現であると考える理由があるため、Fortran プログラムの可能性が高いとは言えません。彼らが 1958 年に Fortran プログラムを放棄したとき、計算能力は今日のものより 15 ~ 16 桁も低かったのです。

Machine Heart: 「プロジェクト」という言葉を抜きにして、OpenAI が行っていることについてどう思いますか? Stuart Russell: OpenAI がやっていること、それを Cookery と呼んでもいいでしょう なぜなら、私たちは本当にそうしているからです。これらのモデルがどのように機能するかはわかりません。ケーキを作るときと同じように、それがどうやってケーキになったのかわかりません。人間は何千年もの間、ケーキを作り続けてきました。彼らはさまざまな原材料やさまざまな方法を試してきました。勾配降下法を何度も繰り返した結果、 、ある日、私は魔法のものを発見しました - ケーキ、それは料理です。ケーキの基本原理については少しわかってきましたが、まだ完璧ではありません。料理から得られるものは限られており、そのプロセスは知的価値があまりありません。 ChatGPT の根本的な問題が原因である場合は、プロンプトや指示を入力しても期待どおりの結果が得られなくなる日が来るでしょう。 ?またレシピを変えるつもりですか?トークンを 4000 から 5000 に増やし、ネットワーク層の数を 2 倍にしますか?それは科学ではないし、知的に面白いとも思えない。 ChatGPT は驚くほど多くの一般化を行っており、それによって初めてどのように機能することができるのかを理解するだけなので、言語作業の大規模モデルがどのように機能するかを理解しようとする研究は確かに価値があります。私たちは真に有意義なインテリジェント システムを開発します。現在、多くの人がこれに取り組んでおり、多くの論文が出版されています。 しかし、ChatGPT の内部メカニズムを理解できるかどうかは、複雑すぎるためリバース エンジニアリングする方法がないため、何とも言えないと思います。中で何が起こっているのか。 #興味深い例えは、30,000 年前に人間と犬の間で起こったことです。犬の脳がどのように機能するかは私たちには理解されておらず、犬が何を考えているのかを正確に把握することは困難ですが、私たちは犬を飼いならす方法を学び、今では犬は私たちの生活に溶け込んでおり、さまざまな貴重な役割を果たしています。私たちは、犬が家の世話や子供と遊ぶことなど、多くのことに優れていることを発見しましたが、私たちはそれを工学的に行うのではなく、育種や配合の微調整を通じてそれらの特性を選択し、改善します。しかし、あなたはあなたの犬があなたの代わりに記事を書いてくれるなどとは期待しないでしょうし、犬がそんなことはできないことを知っていますし、おそらくあなたもあなたの犬がそれをすることを期待していないでしょう。 ChatGPT この全体について驚くべきことは、AI システムが実際に世間の注目を集めるのはこれが初めてではないかということです。大きな変化。 OpenAI 自体には良いことわざがあります。つまり、ChatGPT は本物の知能ではありませんが、人間の体に本物の (人工) 知能の実現を味わうことができ、誰もがその知能を使ってやりたいあらゆる種類のことを実行できるということです。 . . マシンの心臓部: 多くの人が懸念しているもう 1 つの点は、LLM によってもたらされる中間タスクの消滅です。意味分析や構文分析などの中間タスクは、技術的な反復の観点から現在多くの価値があると思いますか?また、将来的には本当になくなるのでしょうか?強力なハードウェア リソースや強力なドメイン知識を持たない中間層の AI 研究者や実践者は職を失う危険にさらされているのでしょうか? スチュアート・ラッセル: それは良い質問ですね。実際のところ、最近では意味分析に関する論文を出版するのは困難です。実際、言語の大きなモデルについて話すか、大きなモデルを使用して大きなベンチマークを更新しない限り、NLP コミュニティの人々に何かを聞いてもらうのは困難です。ほとんどの論文は大きなベンチマークの更新に関するものですが、言語構造、言語理解、または意味解析、構文解析などの大きなベンチマークの更新に関するもの以外の論文を出版することは困難であるため、大規模モデルを評価するための大きなベンチマークは論文執筆の唯一の選択肢となっており、これらの大きなベンチマークは言語とは何の関係もありません。 #今日の自然言語処理の分野では、ある意味、私たちは言語を勉強しなくなりましたが、これは非常に残念なことだと思います。同じことがコンピュータ ビジョンにも当てはまり、今日のほとんどのコンピュータ ビジョン研究では、ビジョンについては研究されなくなり、データ、トレーニング、予測精度のみが研究されています。 #次にAIをどのように開発するかについては、知識と論理的推論を中心に、私たちが理解している方法に焦点を当てるべきだと思います。理由は 2 つあります。まず、AI システムの信頼性が高く、安全で制御可能であることを数学的に保証する必要があります。つまり、構築しているシステムを理解する必要があります。 第 2 に、データ効率の観点から考えてみましょう。これは、人間の脳が 20 メガワットではなく 20 ワットで動作し、一般的な知能を実現する場合に必要になります。回路はあまり表現力豊かな言語ではなく、これらのアルゴリズムのデータ効率は人間の学習よりも桁違いに低く、世界について私たちが知っていることの多くを回路に書き出すのは困難でしょう。汎用コンピューターとプログラミング言語が登場すると、回路を使用するのをやめました。これは、プログラムで必要なことを表現するのにはるかにシンプルで使いやすいためであり、AI コミュニティはほとんど忘れ去っていました。迷っている。 Heart of the Machine: 「人工知能: 最新のアプローチ」の第 4 版には重要な更新があります。 、いいえ さらに、AI システムまたはエージェントには固定の目標があると仮定します。以前は、人工知能の目的は「人間が目標を設定し、期待される有用性を最大化しようとするシステムを作成すること」と定義されていましたが、現在では AI システムに目標を設定する必要はなくなりました。 スチュアート・ラッセル: 理由はいくつかあります。まず、人工知能が実験室から現実世界に移行するにつれて、目標を完全に正しく定義することが難しいことがわかります。たとえば、道路を運転しているときは、目的地に早く到着したいと考えますが、それは時速 200 マイルで運転する必要があるという意味ではありません。また、自動運転車に安全を最優先するように指示した場合、ガレージに永久に駐車されることになるかもしれない。目的地に安全かつ迅速に到着すること、他のドライバーに親切にすること、乗客に不快感を与えないこと、法律や規制を遵守することなど、さまざまな目標の間にはトレードオフがあります。道路には常に何らかの危険が伴い、避けられない事故も発生しますが、運転中の目標をすべて書き出すことは困難であり、運転は人生の中でほんの小さなことであり、単純なことです。したがって、現実的な観点から、AI システムの目標を設定することは不合理です。 #第二に、この本で私が挙げたミダス王の例 (ミダス王問題) が関係しています。ミダスはギリシャ神話の王でした。彼は非常に貪欲で、すべてを黄金に変える力を神に求めました。神は彼の願いを聞き入れ、彼が触れたものはすべて黄金に変わりました。彼は目標を達成しました。しかし、その後、水と食べ物を手に入れました。自身も黄金に変わり、彼に触れた家族も黄金に変わり、最後は黄金に包まれながら無念の死を遂げた。これは、非常に強力なシステムの目標を定義するときは、定義した目標が完全に正しいことを確認する必要があることを思い出させます。しかし、それができないことがわかった今、AI システムがより強力になるにつれて、AI システムがその本当の目的を知らないことがますます重要になっています。 #目標とは実際には非常に複雑なものです。たとえば、お昼にオレンジを買いたいと言ったら、それが目標になりますよね?日常的な文脈では、目標は達成できるものとみなされ、達成されればそれで終わりです。しかし、哲学や経済学が定義する合理的選択理論では、そのような目標はありません。私たちが持っているのは、さまざまな可能性のある未来の好みや順位です。それぞれの可能性のある未来は、現在から終末まで続きます。そこには宇宙のすべてが含まれています。それは目的、人間が本当に望んでいることについて、より複雑でより深い理解だと思います。 Heart of the Machine: この変革は人工知能の将来の発展にどのような影響を及ぼしますか? スチュアート ラッセル: 1940 年代にコンピューター サイエンスとともに人工知能が誕生して以来、 1950年代、研究者はインテリジェンスに基づいて研究を行うために、インテリジェンスの概念を持つ必要がありました。初期の作品の一部は人間の認知を模倣することに重点が置かれていましたが、最終的に勝利を収めたのは合理性の概念でした。つまり、機械が行動を通じて意図された目標を達成できるほど、機械はよりインテリジェントであると考えられます。 人工知能の標準モデルでは、これが私たちが作成しようとしているタイプのマシンです。人間が目標を定義し、残りはマシンが行います。たとえば、決定論的環境の解法システムの場合は、コスト関数と目標基準を与えて、機械が目標状態に到達するための最小コストのアクション シーケンスを見つけられるようにします。確率的環境の強化学習システムの場合は、次のようにします。報酬関数と割引係数を与えて、期待される割引報酬の合計を最大化する戦略を機械に学習させます。このアプローチは人工知能の分野以外でも見られます。制御科学者はコスト関数を最小化し、運用研究者は報酬を最大化し、統計学者は期待損失関数を最小化し、経済学者は個人の効用や集団の福祉を最大化します。 しかし、標準モデルは実際には間違っています。先ほど述べたように、私たちが目標を完全に正確に指定することはほとんど不可能であり、マシンの目標が私たちが本当に望んでいることと一致しない場合、マシンは先制的に対策を講じて何でも実行するため、マシンの制御を失う可能性があります。価格によって、定められた目標を確実に達成できます。既存の AI システムのほとんどは標準モデルの枠組み内で開発されており、これが大きな問題を引き起こしています。 #「人工知能: 最新のアプローチ (第 4 版)」では、人工知能には新しいモデルが必要であると提案しています。 新しいモデルは、AI システムの目標の不確実性を強調しており、この不確実性により、機械は人間の好みを学習し、行動を起こす前に人間の意見を求めることができます。 AI システムの動作中、人間の目標が最初に設定されると無関係になるのではなく、人間の本当の好みを示す何らかの情報が人間から機械に流れる必要があります。これには、機械を固定目標から切り離し、機械と人間の間の二項結合が必要です。標準モデルは、機械の範囲内で、囲碁をプレイしたりパズルを解くなど、人間の望ましい目標を機械が完全に正確に指定できる極端なケースと考えることができます。 本書では、不確実な設定、オフスイッチの問題、アシスタンス アシスタンス ゲームなど、新しいモデルがどのように機能するかを説明するいくつかの例も提供しています。しかし、これらはほんの始まりにすぎず、私たちは研究を始めたばかりです。 機械の中心: 急速に発展している人工知能の分野で、ホットスポットをやみくもに追いかけることなく、技術トレンドに追いつくにはどうすればよいでしょうか? AIの研究者や実践者は何に留意すべきでしょうか? Stuart Russell: 真にインテリジェントなシステムを構築するには、根本的な問題があると思います。宇宙に含まれる様々な凹凸を表現言語を使って表現することができる。 インテリジェンスと回路の本質的な違いは、私たちが知る限り、回路はそのような不規則性をうまく表現できず、実際にはデータ効率の極端な低下として現れるということです。 。 簡単な例として、正弦関数の定義を (数式を使用して) 書き留めたり、正弦関数を経験的に説明してみることもできます。多数のピクセルを使用します。 1,000 万ピクセルしかない場合、sine 関数の一部しかカバーできませんが、カバーした領域を見ると、sine 関数のかなり優れたモデルができているように見えます。しかし、実際のところ、私はsin関数をよく理解していません、関数の形も知りませんし、その数学的性質も知りません。 #私たちは、真の知性を目指して進んでいると思い込んでいるのではないかと心配しています。私たちが実際に行っているのは、まったくスマートなモデルではないものにピクセルをどんどん追加しているだけです。 AI システムを構築するときは、基本的な表現機能を備えたメソッドに焦点を当てる必要があると思います。その核となるのは、すべてを宣言できることです。オブジェクト。囲碁のルールを書き留めたいとします。すると、これらのルールはボード上のすべてのマス目に適用されなければなりません。各 x に対して各 y に何が起こるかを言うことができます。また、C または Python で書くこともできます。英語で書かれ、一次論理で書かれています。これらの言語はいずれもルールを表現する表現力を備えているため、ルールを非常に簡潔に書き留めることができます。ただし、これを回路で行うことはできず、回路ベースの表現 (深層学習システムを含む) ではこのクラスの一般化を表現できません。 #この事実を無視して、ビッグデータを通じてインテリジェンスを実現しようとするのは、私の意見ではばかげています。碁の駒も、チェスの駒も、何十億ものトレーニング例があるからです。人間の知性が何をしてきたかを考えてみると、私たちはLIGOを建設し、宇宙の裏側から重力波を検出しました。どうやってやったの?知識と推論に基づいています。 LIGO を構築する前に、トレーニング サンプルをどこで収集しましたか?もちろん、先人たちは感覚的な経験も含めて何かを学び、それを英語や数学などの表現言語で記録しており、私たちはそこから学び、宇宙の法則を理解し、それに基づいて推論や工学を行ってきました。設計などを行って、宇宙の反対側でブラックホールの衝突を観察します。 もちろん、ビッグデータに基づいてインテリジェンスを実現することは可能であり、さまざまなことが可能であり、人間よりも賢い Fortran プログラムを進化させることも可能です。しかし、私たちは二千年以上かけて知識と推論を理解し、知識と推論に基づいて数多くの優れた技術を開発し、それらの技術に基づいて何千もの有用なアプリケーションが開発されてきました。さて、あなたは知性には興味がありますが、知識や推論には興味がありません。それについては何も言うことはありません。 -3-

以上がスチュアート・ラッセル氏へのインタビュー: ChatGPT に関して、より多くのデータとより多くのコンピューティング能力が真のインテリジェンスをもたらすことはできませんの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

顔を抱きしめます' S 7BモデルオリンピックコダーはClaude 3.7を破っていますか?Apr 23, 2025 am 11:49 AM

顔を抱きしめます' S 7BモデルオリンピックコダーはClaude 3.7を破っていますか?Apr 23, 2025 am 11:49 AMFaceのOlympiccoder-7Bを抱き締める:強力なオープンソースコード推論モデル 優れたコードに焦点を当てた言語モデルを開発するための競争は激化しており、顔を抱き締めることは、恐るべき競争相手との競争に参加しました:Olympiccoder-7B、製品

4つの新しいジェミニ機能は、見逃す余裕がありますApr 23, 2025 am 11:48 AM

4つの新しいジェミニ機能は、見逃す余裕がありますApr 23, 2025 am 11:48 AMAIが質問に答えるだけでなく、AIができることを望んでいる人は何人いますか?私は自分が持っていることを知っています、そして最近、私はそれがどのように変容しているかに驚いています。 aiチャットボットはもうチャットするだけでなく、作成することです。

Camundaは、エージェントAIオーケストレーションの新しいスコアを作成しますApr 23, 2025 am 11:46 AM

Camundaは、エージェントAIオーケストレーションの新しいスコアを作成しますApr 23, 2025 am 11:46 AMSmart AIは、エンタープライズソフトウェアプラットフォームとアプリケーションのあらゆるレベルのレベルに統合され始めているため(強力なコアツールと信頼性の低いシミュレーションツールの両方があることを強調する必要があります)、これらのエージェントを管理するための新しいインフラストラクチャ機能のセットが必要です。 ドイツのベルリンに拠点を置くプロセスオーケストレーション会社であるCamundaは、Smart AIが適切な役割を果たし、新しいデジタル職場での正確なビジネス目標とルールと一致するのに役立つと考えています。同社は現在、組織がAIエージェントのモデル化、展開、管理を支援するように設計されたインテリジェントオーケストレーション機能を提供しています。 実用的なソフトウェアエンジニアリングの観点から、これはどういう意味ですか? 確実性と非決定的プロセスの統合 同社は、鍵はユーザー(通常はデータサイエンティスト、ソフトウェア)を許可することだと言いました

キュレーションされたエンタープライズAIエクスペリエンスに価値はありますか?Apr 23, 2025 am 11:45 AM

キュレーションされたエンタープライズAIエクスペリエンスに価値はありますか?Apr 23, 2025 am 11:45 AM次の'25年にGoogle Cloudに参加して、GoogleがどのようにAIの製品を区別するかを見たいと思っていました。 エージェントスペース(ここで説明)とカスタマーエクスペリエンススイート(ここで説明)に関する最近の発表は、ビジネス価値を強調し、

ぼろきれに最適な多言語埋め込みモデルを見つける方法は?Apr 23, 2025 am 11:44 AM

ぼろきれに最適な多言語埋め込みモデルを見つける方法は?Apr 23, 2025 am 11:44 AM検索拡張生成(RAG)システムのための最適な多言語埋め込みモデルの選択 今日の相互接続された世界では、効果的な多言語AIシステムを構築することが最重要です。 REには、堅牢な多言語埋め込みモデルが重要です

ムスク:オースティンのロボタキシスは、10,000マイルごとに介入が必要ですApr 23, 2025 am 11:42 AM

ムスク:オースティンのロボタキシスは、10,000マイルごとに介入が必要ですApr 23, 2025 am 11:42 AMテスラのオースティンロボタキシローンチ:マスクの主張を詳しく見る Elon Muskは最近、テキサス州オースティンでのテスラの今後のRobotaxi発売を発表しました。当初、安全上の理由で10〜20台の車両の小さな艦隊を展開し、迅速な拡大を計画しました。 h

AI'の衝撃的なピボット:作業ツールからデジタルセラピストやライフコーチまでApr 23, 2025 am 11:41 AM

AI'の衝撃的なピボット:作業ツールからデジタルセラピストやライフコーチまでApr 23, 2025 am 11:41 AM人工知能の適用方法は予期しない場合があります。当初、私たちの多くは、それが主にコードの作成やコンテンツの作成など、創造的で技術的なタスクに使用されていると思うかもしれません。 ただし、Harvard Business Reviewによって報告された最近の調査では、そうではないことが示されています。ほとんどのユーザーは、仕事だけでなく、サポート、組織、さらには友情のために人工知能を求めています! 報告書は、AIアプリケーションの最初のケースは治療と交際であると述べています。これは、その24時間年中無休の可用性と匿名の正直なアドバイスとフィードバックを提供する能力が非常に価値があることを示しています。 一方、マーケティングタスク(ブログの作成、ソーシャルメディアの投稿の作成、広告コピーなど)は、一般的な使用リストではるかに低くランク付けされています。 なぜこれがなぜですか?研究の結果とそれがどのように続くかを見てみましょう

企業はAIエージェントの採用に向けて競い合っていますApr 23, 2025 am 11:40 AM

企業はAIエージェントの採用に向けて競い合っていますApr 23, 2025 am 11:40 AMAIエージェントの台頭は、ビジネス環境を変えています。 Cloud Revolutionと比較して、AIエージェントの影響は指数関数的に大きく、知識作業に革命をもたらすことを約束していると予測されています。 人間の意思決定-makiをシミュレートする能力

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

SublimeText3 Linux 新バージョン

SublimeText3 Linux 最新バージョン

VSCode Windows 64 ビットのダウンロード

Microsoft によって発売された無料で強力な IDE エディター

MinGW - Minimalist GNU for Windows

このプロジェクトは osdn.net/projects/mingw に移行中です。引き続きそこでフォローしていただけます。 MinGW: GNU Compiler Collection (GCC) のネイティブ Windows ポートであり、ネイティブ Windows アプリケーションを構築するための自由に配布可能なインポート ライブラリとヘッダー ファイルであり、C99 機能をサポートする MSVC ランタイムの拡張機能が含まれています。すべての MinGW ソフトウェアは 64 ビット Windows プラットフォームで実行できます。

Dreamweaver Mac版

ビジュアル Web 開発ツール

DVWA

Damn Vulnerable Web App (DVWA) は、非常に脆弱な PHP/MySQL Web アプリケーションです。その主な目的は、セキュリティ専門家が法的環境でスキルとツールをテストするのに役立ち、Web 開発者が Web アプリケーションを保護するプロセスをより深く理解できるようにし、教師/生徒が教室環境で Web アプリケーションを教え/学習できるようにすることです。安全。 DVWA の目標は、シンプルでわかりやすいインターフェイスを通じて、さまざまな難易度で最も一般的な Web 脆弱性のいくつかを実践することです。このソフトウェアは、