ホームページ >テクノロジー周辺機器 >AI >メタ「ディバイド・エブリシング」の超進化版が登場! IDEA は国内トップチームを率いて、あらゆるものを検出、セグメント化、生成し、2,000 個のスターを獲得します

メタ「ディバイド・エブリシング」の超進化版が登場! IDEA は国内トップチームを率いて、あらゆるものを検出、セグメント化、生成し、2,000 個のスターを獲得します

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-13 14:40:031974ブラウズ

Meta の「すべてを分割する」モデルが登場した後、業界の人々はすでに CV など存在しないと叫んでいます。

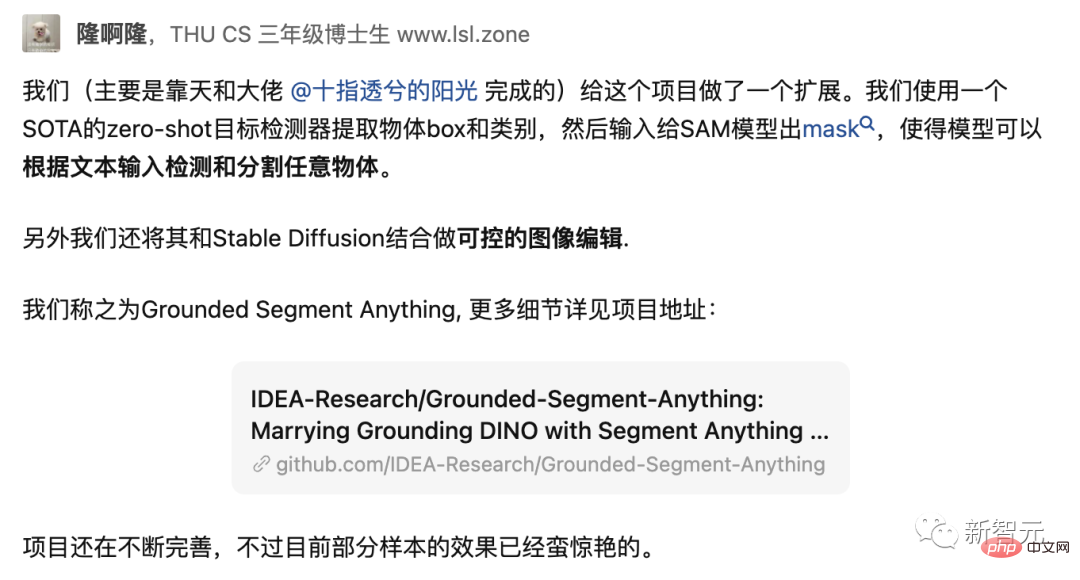

SAM がリリースされた翌日、国内チームはこれをベースにした進化版「Grounded-SAM」を作成しました。

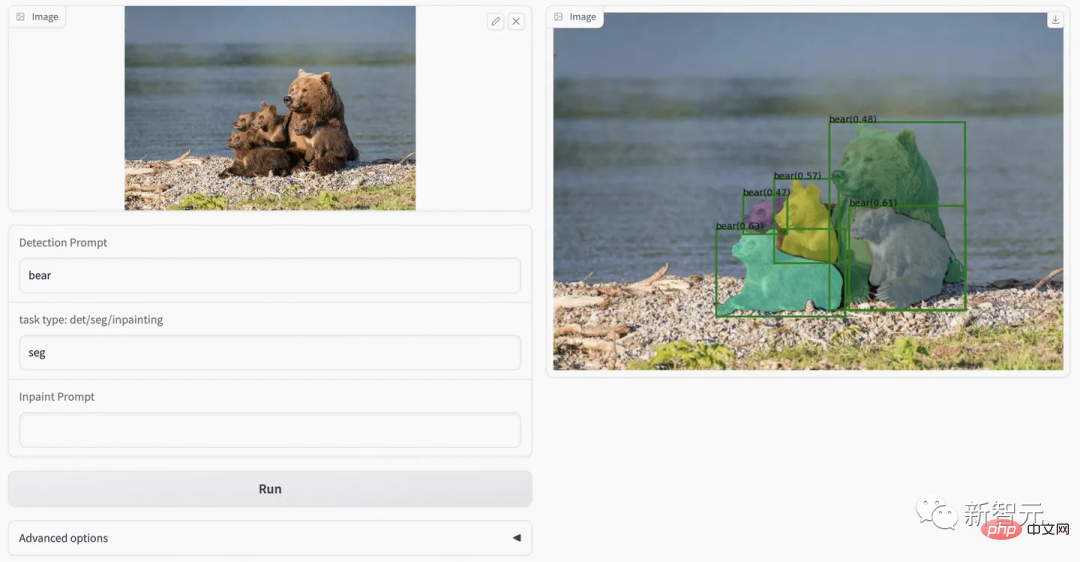

#注: プロジェクトのロゴは、チームが Midjourney を 1 時間使用して作成したものです。 #Grounded-SAM は、SAM と BLIP および安定拡散を統合し、画像の「分割」、「検出」、「生成」の 3 つの機能を 1 つに統合し、最も強力なゼロショット ビジュアル アプリケーションとなります。

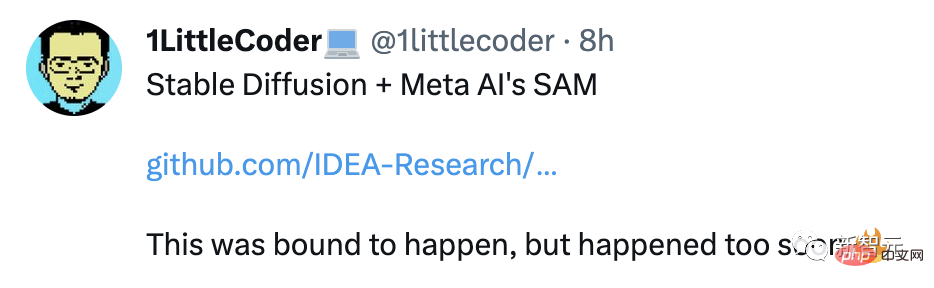

ネチズンは、巻き毛すぎると表現しました。

Google Brain の研究科学者であり、ウォータールー大学のコンピュータ サイエンス助教授である Wenhu Chen 氏は、「これは速すぎます。 」

AI のボス Shen Xiangyang も、この最新プロジェクトをみんなに勧めました:

Grounded-Segment-Anything : 画像とテキストを入力すると、あらゆるものを自動的に検出、セグメント化、生成します。エッジのセグメンテーションはさらに改善できます。

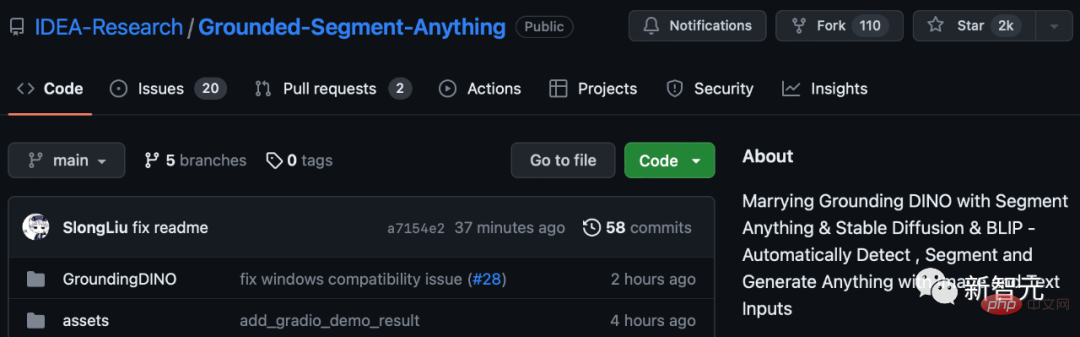

これまでのところ、このプロジェクトは GitHub で 2,000 個のスターを獲得しています。

すべてを検出、すべてを分割、すべてを生成

このモデルは、統合フレームワーク プロンプト エンコーダーで点、境界ボックス、文を指定し、ワンクリックで任意のオブジェクトを直接セグメント化できます。

SAM には幅広い汎用性があります。つまり、ゼロサンプルで移行できる機能があり、これで十分な機能をカバーできます。追加のトレーニングにより、水中写真や細胞顕微鏡などの新しいイメージング領域ですぐに使用できます。

#SAM は非常に強力であることがわかります。

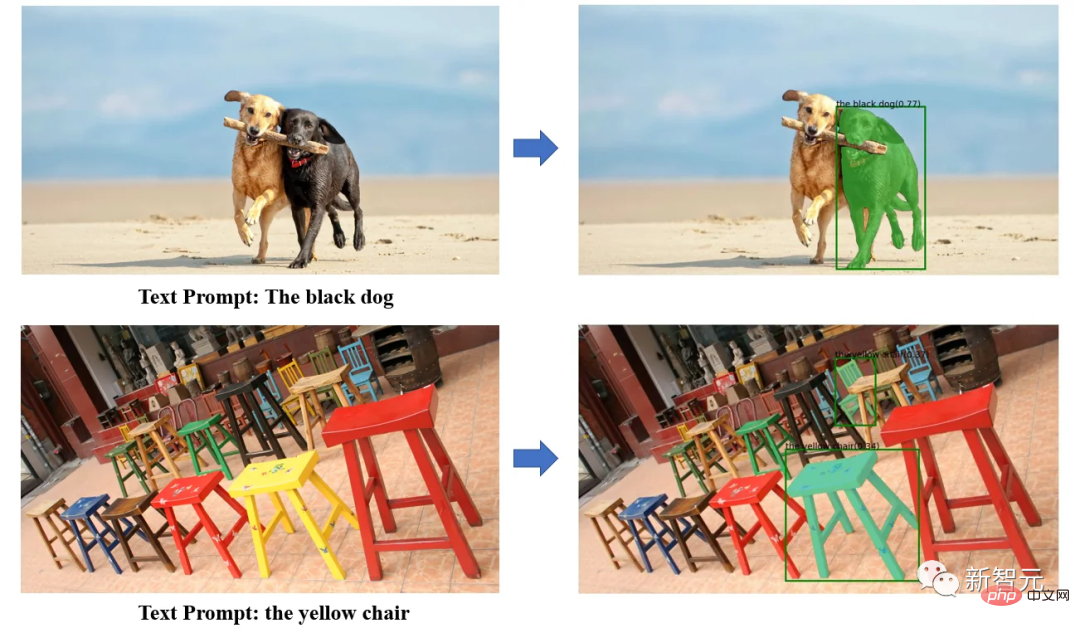

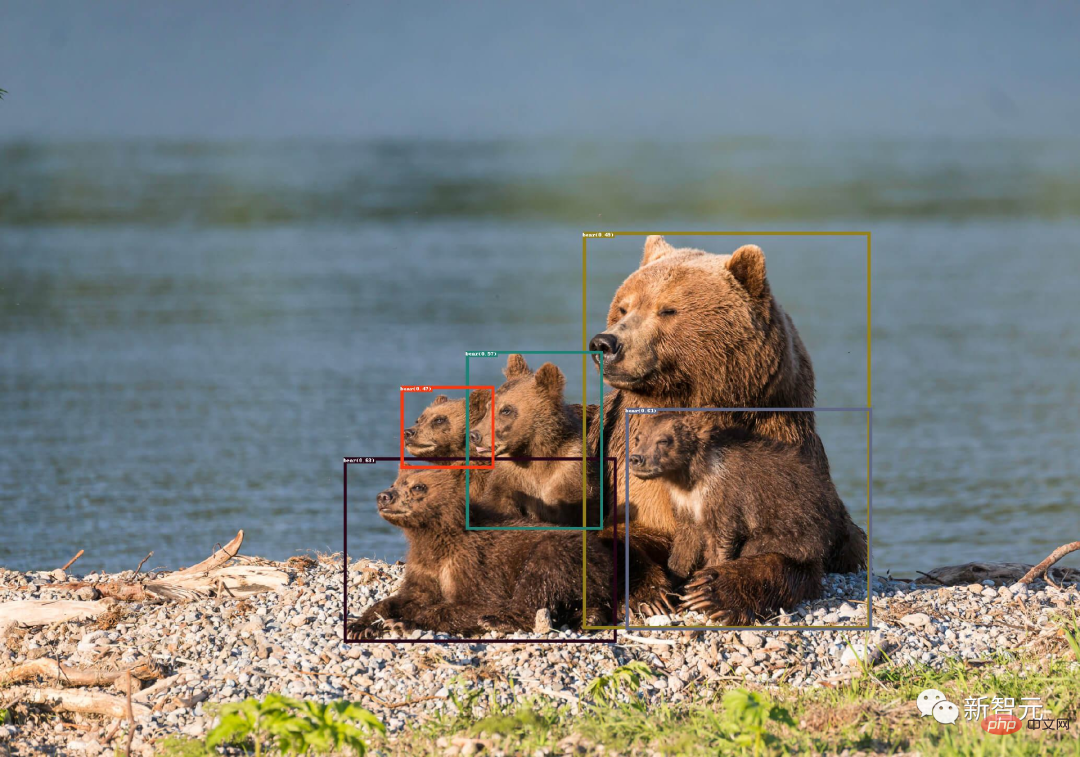

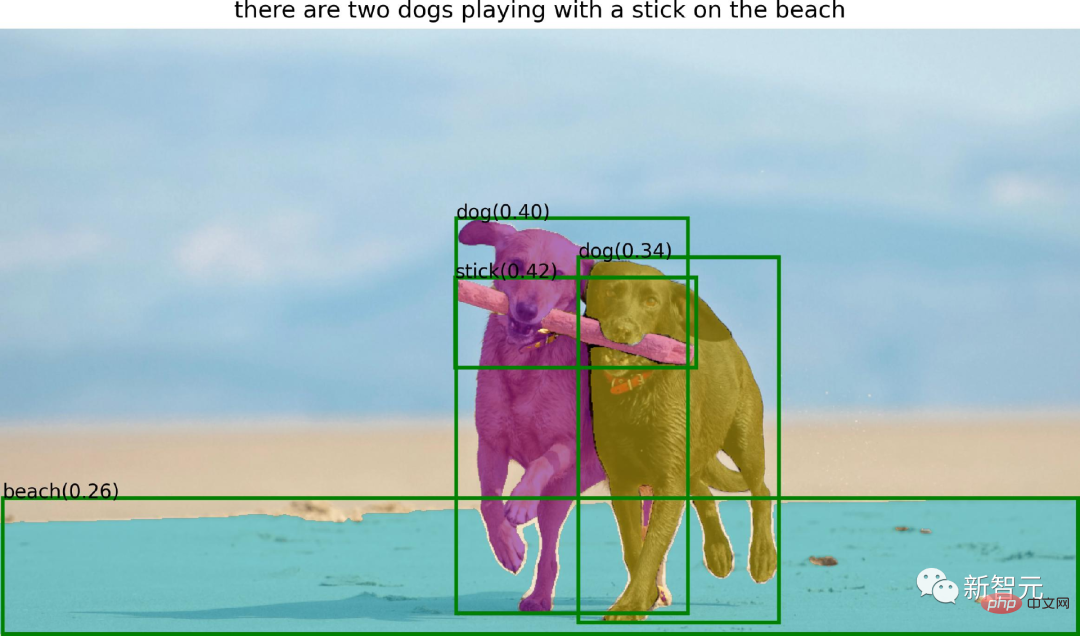

Grounding DINO の強力なゼロサンプル検出機能を使用すると、Grounded SAM はテキストの説明を通じて画像内の任意のオブジェクトを検索し、SAM の強力なセグメンテーション機能を使用してオブジェクトをセグメント化できます。きめ細かいやり方。

最後に、安定拡散を使用して、セグメント化された領域に制御可能なテキストと画像を生成することもできます。

グラウンデッド SAM の具体的な実践では、研究者らはセグメントエニシングと 3 つの強力なゼロサンプル モデルを組み合わせて自動ラベル付けシステム プロセスを構築し、非常に印象的な結果を実証しました。

#このプロジェクトは、次のモデルを組み合わせています:

· BLIP: 強力な画像注釈モデル

· Grounding DINO: 最先端のゼロショット検出器

· セグメント-何でも: 強力なゼロ-ショット セグメンテーション モデル

· 安定拡散: 優れた生成モデル

すべてのモデルを組み合わせることができます使用することも、独立して使用することもできます。強力なビジュアルワークフローモデルを構築します。ワークフロー全体には、すべてを検出し、すべてをセグメント化し、すべてを生成する機能があります。

システムの機能は次のとおりです。

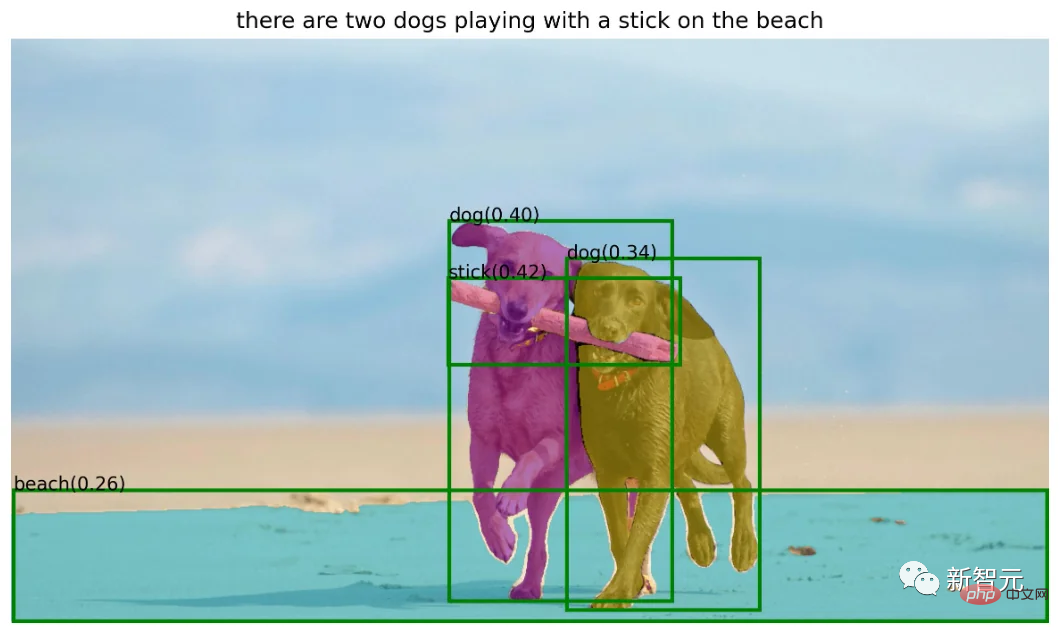

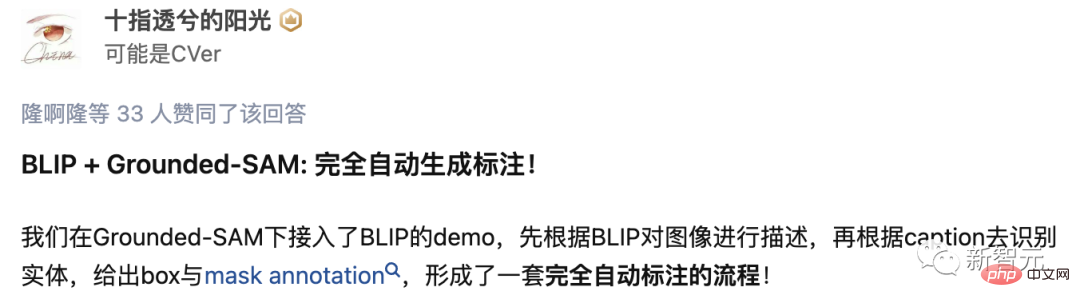

BLIP グラウンデッド-SAM=自動ラベラー

BLIP モデルを使用してタイトルを生成し、タグを抽出し、Ground-SAM を使用してボックスとマスクを生成します:

#· 半自動アノテーション システム: 検出 テキストを入力し、正確なボックス注釈とマスク注釈を提供します。

· 完全自動アノテーション システム:

最初に BLIP を使用します。モデル 入力画像に対して信頼性の高い注釈を生成し、Grounding DINO に注釈内のエンティティを検出させ、続いて SAM でボックス キューのインスタンス セグメンテーションを行います。

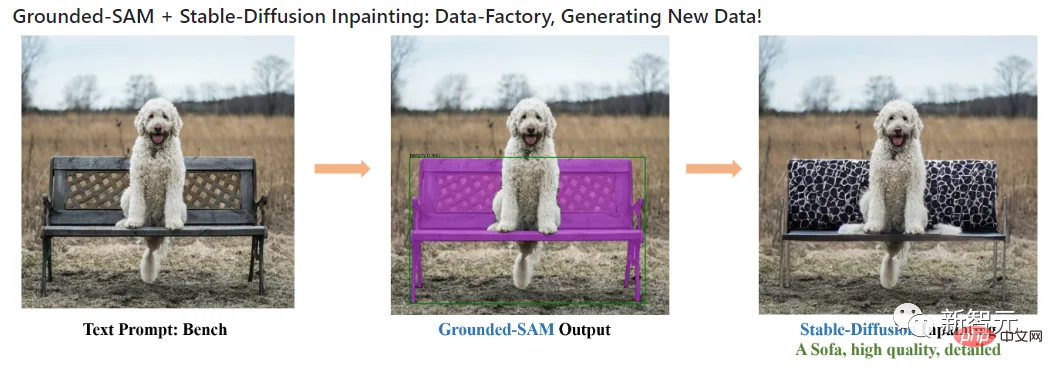

安定拡散のグラウンデッド-SAM=Data Factory

· 新しいデータを生成するデータ ファクトリとして使用:拡散修復モデルを使用して、マスクに基づいて新しいデータを生成できます。

このブランチでは、著者は次を使用します。セグメント 人の髪や顔を編集するためのもの。

· SAM ヘアエディター

##著者は、Grounded-SAM モデルについて考えられる将来の研究の方向性をいくつか提案しました。

##著者は、Grounded-SAM モデルについて考えられる将来の研究の方向性をいくつか提案しました。

著者紹介

Grounded-SAM プロジェクトの研究者の 1 人は、清華大学コンピューター サイエンス学部博士課程 3 年生の Liu Shilong です。

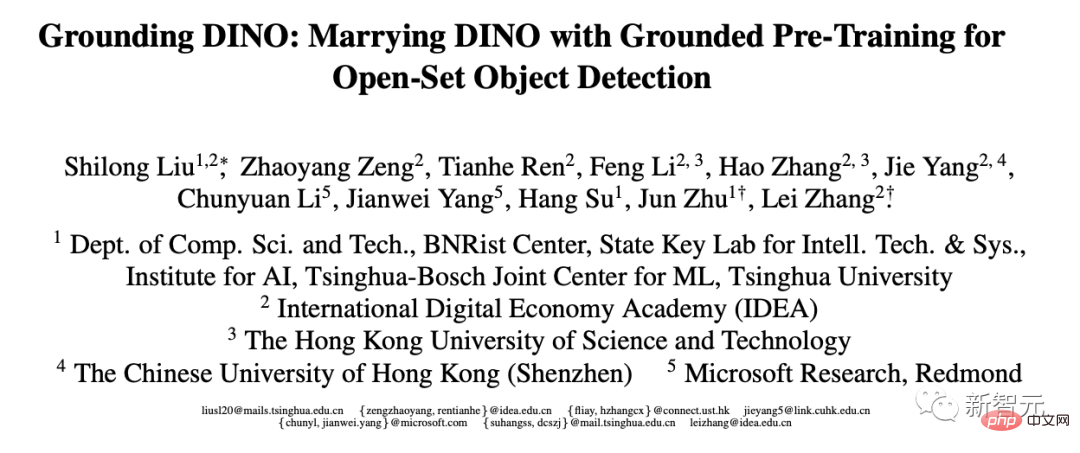

彼は最近、彼と彼のチームが GitHub 上で作成した最新プロジェクトを紹介し、それはまだ改良中であると述べました。現在、Liu Shilong は、広東・香港・マカオ大湾区デジタル経済研究所 (IDEA 研究所) のコンピューター ビジョンおよびロボット研究センターでインターンをしています。 Zhang Lei 教授が指導しており、彼の研究の方向性には、ターゲット検出とマルチモーダル学習が含まれます。 これに先立ち、彼は 2020 年に清華大学で生産工学の学士号を取得し、2019 年には Megvii で一定期間インターンをしていました。 個人ホームページ: http://www.lsl.zone/ ところで、Liu Shilong 今年3月に発売された目標探知モデルGrounding DINOの作品でもあります。 さらに、彼の論文のうち 4 件が CVPR 2023 に、2 件の論文が ICLR 2023 に、1 件の論文が AAAI 2023 にそれぞれ採択されました。 論文アドレス: https://arxiv.org/pdf/2303.05499.pdf ##Liu Shilong が言及したビッグボスである Ren Tianhe 氏は、現在 IDEA Research Institute でコンピュータ ビジョン アルゴリズム エンジニアとして働いています。彼は Zhang Lei 教授の指導も受けています。彼の主な研究方向はターゲット検出とマルチモダリティです。

# をインストールして実行します##プロジェクトでは、Python 3.8 以降、pytorch 1.7 以降、torchvision 0.8 以降のインストールが必要です。さらに、著者は CUDA をサポートする PyTorch と TorchVision をインストールすることを強く推奨します。 セグメントを何でも取り付けます:

# さらに、このプロジェクトの共同研究者には、中国科学院大学博士課程 3 年生の Li Kunchang 氏が含まれます。方向性はビデオ理解とマルチモーダル学習、IDEA 研究所のコンピュータ ビジョンおよびロボティクス研究センターのインターンで、主な研究方向は生成モデルである Cao He 氏、Alibaba Cloud のシニア アルゴリズム エンジニアである Chen Jiayu 氏です。

# さらに、このプロジェクトの共同研究者には、中国科学院大学博士課程 3 年生の Li Kunchang 氏が含まれます。方向性はビデオ理解とマルチモーダル学習、IDEA 研究所のコンピュータ ビジョンおよびロボティクス研究センターのインターンで、主な研究方向は生成モデルである Cao He 氏、Alibaba Cloud のシニア アルゴリズム エンジニアである Chen Jiayu 氏です。  Ren Tianhe、Liu Shilong

Ren Tianhe、Liu Shilongpython -m pip install -e segment_anything

アースDINOを取り付けます:

python -m pip install -e GroundingDINO

ディフューザーを取り付けます:

pip install --upgrade diffusers[torch]

マスクの後処理、COCO 形式でのマスクの保存、サンプル ノートブック、ONNX 形式でのモデルのエクスポートに必要なオプションの依存関係をインストールします。同時に、プロジェクトではサンプル ノートブックを実行するために jupyter も必要です。

pip install opencv-python pycocotools matplotlib onnxruntime onnx ipykernel

Grounding DINO デモ

groundingdino チェックポイントをダウンロード: cd Grounded-Segment-Anything

wget https://github.com/IDEA-Research/GroundingDINO/releases/download/v0.1.0-alpha/groundingdino_swint_ogc.pth

デモを実行:

export CUDA_VISIBLE_DEVICES=0 python grounding_dino_demo.py --config GroundingDINO/groundingdino/config/GroundingDINO_SwinT_OGC.py --grounded_checkpoint groundingdino_swint_ogc.pth --input_image assets/demo1.jpg --output_dir "outputs" --box_threshold 0.3 --text_threshold 0.25 --text_prompt "bear" --device "cuda"

モデル予測の視覚化は次のように出力ディレクトリに保存されます:

#Grounded-Segment- Anything BLIP デモンストレーション

1. BLIP (または他のラベル付けモデル) を使用してラベルを生成します。

2. 注釈からタグを抽出し、ChatGPT を使用して複雑になる可能性のある文を処理します。

3. Ground-Segment-Anything を使用してボックスとマスクを生成します。

伪标签和模型预测可视化将保存在output_dir中,如下所示: 作者在此提供了可视化网页,可以更方便的尝试各种例子。 对于这个项目logo,还有个深层的含义: 一只坐在地上的马赛克风格的熊。坐在地面上是因为ground有地面的含义,然后分割后的メタ「ディバイド・エブリシング」の超進化版が登場! IDEA は国内トップチームを率いて、あらゆるものを検出、セグメント化、生成し、2,000 個のスターを獲得します可以认为是一种马赛克风格,而且马塞克谐音mask,之所以用熊作为logo主体,是因为作者主要示例的メタ「ディバイド・エブリシング」の超進化版が登場! IDEA は国内トップチームを率いて、あらゆるものを検出、セグメント化、生成し、2,000 個のスターを獲得します是熊。 看到Grounded-SAM后,网友表示,知道要来,但没想到来的这么快。 项目作者任天和称,「我们用的Zero-Shot检测器是目前来说最好的。」 未来,还会有web demo上线。 最后,作者表示,这个项目未来还可以基于生成模型做更多的拓展应用,例如多领域精细化编辑、高质量可信的数据工厂的构建等等。欢迎各个领域的人多多参与。export CUDA_VISIBLE_DEVICES=0

python automatic_label_demo.py

--config GroundingDINO/groundingdino/config/GroundingDINO_SwinT_OGC.py

--grounded_checkpoint groundingdino_swint_ogc.pth

--sam_checkpoint sam_vit_h_4b8939.pth

--input_image assets/demo3.jpg

--output_dir "outputs"

--openai_key your_openai_key

--box_threshold 0.25

--text_threshold 0.2

--iou_threshold 0.5

--device "cuda"

Grounded-Segment-Anything+Inpainting演示

CUDA_VISIBLE_DEVICES=0

python grounded_sam_inpainting_demo.py

--config GroundingDINO/groundingdino/config/GroundingDINO_SwinT_OGC.py

--grounded_checkpoint groundingdino_swint_ogc.pth

--sam_checkpoint sam_vit_h_4b8939.pth

--input_image assets/inpaint_demo.jpg

--output_dir "outputs"

--box_threshold 0.3

--text_threshold 0.25

--det_prompt "bench"

--inpaint_prompt "A sofa, high quality, detailed"

--device "cuda"

Grounded-Segment-Anything+Inpainting Gradio APP

python gradio_app.py

网友评论

以上がメタ「ディバイド・エブリシング」の超進化版が登場! IDEA は国内トップチームを率いて、あらゆるものを検出、セグメント化、生成し、2,000 個のスターを獲得しますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。