ホームページ >テクノロジー周辺機器 >AI >T5 に基づく 2 段階マルチタスク Text-to-SQL 事前トレーニング モデル MIGA

T5 に基づく 2 段階マルチタスク Text-to-SQL 事前トレーニング モデル MIGA

- PHPz転載

- 2023-04-13 09:46:021379ブラウズ

事前トレーニング済み言語モデル (PLM) には豊富な知識が含まれていることが、ますます多くの研究で証明されています。さまざまなタスクに対して、適切なトレーニング方法を使用して PLM を活用することで、モデルのパフォーマンスをより向上させることができます。 Text-to-SQL タスクでは、現在の主流のジェネレーターは構文ツリーに基づいており、SQL 構文用に設計する必要があります。

最近、NetEase Interactive Entertainment AI Lab は、広東外国語大学およびコロンビア大学と協力して、事前トレーニングに基づいた 2 段階のマルチタスク事前トレーニング モデル MIGA を提案しました。事前トレーニング済み言語モデル T5 のメソッド。 MIGA は、事前トレーニング段階で 3 つの補助タスクを導入し、それらを統合生成タスク パラダイムに編成し、すべての Text-to-SQL データ セットを均一にトレーニングできるようにします。同時に、微調整段階では、MIGA は次のエラーをターゲットにします。複数回の対話 転送問題は SQL 摂動に使用され、モデル生成の堅牢性が向上します。

現在の Text-to-SQL 研究では、主に SQL 構文ツリーに基づくエンコーダ/デコーダ モデルが主流です。これにより、生成された結果が SQL 構文に準拠していることが保証されます。ただし、SQL 構文が特別に設計されているため、ターゲットを絞る必要があります。最近では、生成言語モデルに基づいた Text-to-SQL に関する研究も行われており、事前にトレーニングされた言語モデルの知識と機能を簡単に継承できます。

構文ツリーへの依存を軽減し、事前トレーニングされた言語モデルの機能をより適切に活用するために、この研究では、事前トレーニングの枠組みの下で 2 段階の多言語モデルを提案しました。トレーニングされた T5 モデル タスク Text-to-SQL 事前トレーニング モデル MIGA (MMultI-タスク G世代 frAmework)。

MIGA は、トレーニング プロセスの 2 つの段階に分かれています。

- MIGA は、事前トレーニング段階では、同じ事前トレーニング プロセスを使用します。 T5 としてのトレーニング パラダイムでは、事前トレーニングされた言語モデルの知識をより良く刺激するために、Text-to-SQL に関連する 3 つの追加の補助タスクが提案されています。このトレーニング方法では、すべての Text-to-SQL データ セットを統合し、トレーニング データの規模を拡張できます。また、より効果的な補助タスクを柔軟に設計して、事前トレーニングされた言語モデルの潜在的な知識をさらに探索することもできます。

- 微調整フェーズでは、MIGA は、複数ラウンドの会話や SQL で発生しやすいエラー伝達の問題をターゲットにします。これにより、トレーニング プロセス中に履歴 SQL が混乱し、 SQL の現在のラウンドの生成がより効率的になります。

MIGA モデルは、2 つのマルチターン ダイアログ Text-to-SQL 公開データ セットで、最良の構文ツリー ベースのモデルよりも優れたパフォーマンスを発揮します。関連する研究は AAAI によって実施されています。 2023 年に承認されました。

文書アドレス: https://arxiv.org/abs/2212.09278

MIGAモデルの詳細

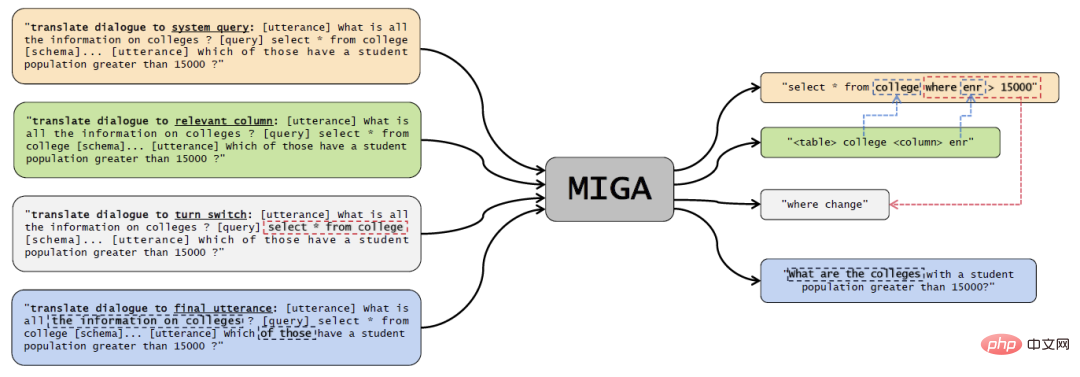

図 1 MIGA モデル図。

#マルチタスク事前トレーニングフェーズ

この研究では主に事前トレーニング方法について言及します。トレーニングされた T5 モデルは、次の 4 つの事前トレーニング タスクで設計されています。- Text-to-SQL 主なタスク: 上の図の黄色の部分では、プロンプトを「ダイアログをシステム クエリに変換する」ように設計し、いくつかの特別なトークンを使用して履歴ダイアログとデータベースを結合します。情報と SQL ステートメントは結合されて T5 エンコーダーに入力され、デコーダーは対応する SQL ステートメントを直接出力します;

- 関連情報の予測: 上図の緑色の部分について、設計プロンプトは「ダイアログを関連する列に変換する」であり、T5 エンコーダーの入力もメイン タスクと一致しており、デコーダーはモデルの理解を高めるために、現在の問題に関連するデータ テーブルと列を出力する必要があります。 Text-to-SQL;

- 今回のラウンドの動作予測: 上図の灰色の部分は「ダイアログを翻訳してスイッチを回す」タスクです。複数ラウンドのダイアログでコンテキストを理解し、前のラウンドのダイアログと SQL を比較すると、デコーダーは現在のダイアログの目的にどのような変更が加えられたかを出力する必要があります。たとえば、図の例では、where 条件が変更されました。変更;

- 最終対話予測: 上の図の青い部分、デザイン プロンプト 「対話を最終発話に変換する」の目的は、モデルが文脈に沿った対話をよりよく理解できるようにすることです。デコーダは、マルチラウンドのダイアログ全体と、SQL に対応する完全な問題の説明を最後の瞬間に出力する必要があります。

このような統合されたトレーニング方法の設計により、MIGA は多用途かつ柔軟になり、より多くの追加のタスク関連タスクを処理できるようになり、次の利点もあります。

- 人間が SQL を記述する手順を参照すると、SQL タスクへの会話テキストは複数のサブタスクに分解され、メイン タスクがそれらから学習できるようになります。 トレーニング サンプルの構築形式は T5 と一致しており、ターゲット タスクに対して事前トレーニングされた T5 モデルの可能性を最大化できます。

- ##統合されたフレームワークにより、複数のタスクの柔軟なスケジューリングが可能になります。補助的なタスク。特定のタスクに適用する場合、上記の事前トレーニング済みモデルは、特定のタスクのラベル付きデータ内の同じトレーニング目標を使用して微調整するだけで済みます。

- この調査では、トレーニング前の段階で、Text-to-SQL データセット Spider と会話型 Text-to-SQL データセット SparC および CoSQL のデータを統合して、 T5モデル。

微調整段階

事前トレーニング段階の後、この研究では単純に Text-to- SQL タスクを実行してモデルをさらに微調整します。本研究では,SQL の現ラウンドを予測する際に,前ラウンドの予測 SQL をつなぎ合わせることで,複数ラウンドの対話と生成によって生じるエラー伝達問題を克服するために,SQL 摂動スキームを提案する. . 、入力データ内の SQL の履歴ラウンドを α の確率で摂動させます。 SQL ステートメントの摂動は主に、対応するトークンを β の確率でサンプリングし、次の摂動のいずれかを実行します。

同じデータ テーブル内の列を使用してランダムに実行します。変更または新規 SELECT 部分に列を追加します;

- 2 つのテーブルの位置を交換するなど、JOIN 条件内の構造をランダムに変更します;

- Modify"* " すべての列は他の列です。

- 「asc」と「desc」を入れ替えてください。

- 上記の摂動は、実験で統計的に見つかったエラー伝達によって引き起こされる最も一般的な SQL 生成エラーです。したがって、モデルの負荷を軽減するために、これらの状況に対して摂動が実行されます。この側面に依存します。

実験的評価

マルチターン会話 Text-to-SQL の評価データセット: SparC および CoSQL。評価指標は次のとおりです:

QM: 質問の一致。これは、1 回の質問で生成された SQL が完全に一致したことを意味します。割合;

- IM: インタラクション マッチ、マルチラウンド ダイアログの完全なラウンド全体で生成されたすべての SQL のうち、アノテーション出力と完全に一致する割合を示します。

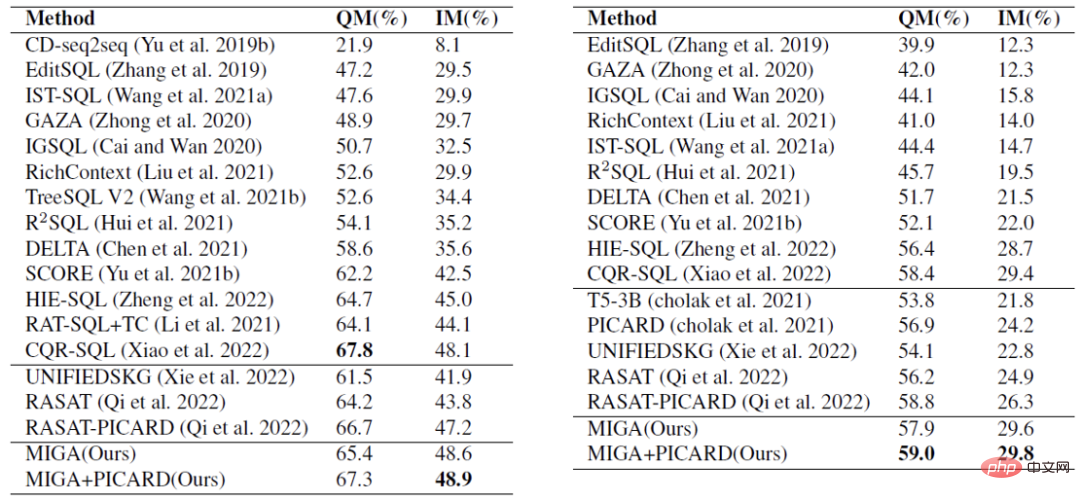

- 表 1 の比較実験では、MIGA は、2 つのデータ セットの IM スコアと CoSQL の QM スコアの点で、現在の最高のマルチターン ダイアログを上回りました。 -SQLモデル。また、同じタイプの T5 ベースのソリューションと比較して、MIGA は IM を 7.0%、QM を 5.8% それぞれ改善しました。

#表 1 実験解析の比較。最初の部分はツリー モデル、2 番目の部分は事前トレーニングに基づく生成モデルです。

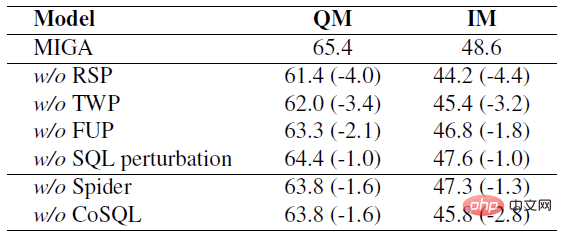

表 2 のアブレーション実験では、この研究では MIGA の 2 段階のトレーニング プロセスにおけるいくつかのタスクを調査し、同時にこれらのタスクがそれぞれに影響を与えることを証明しました。タスクはさまざまな程度に改善されました。

#表 2 SparC タスクの場合、各タスクまたはデータがそれぞれ削除されると、インジケーターが減少します。

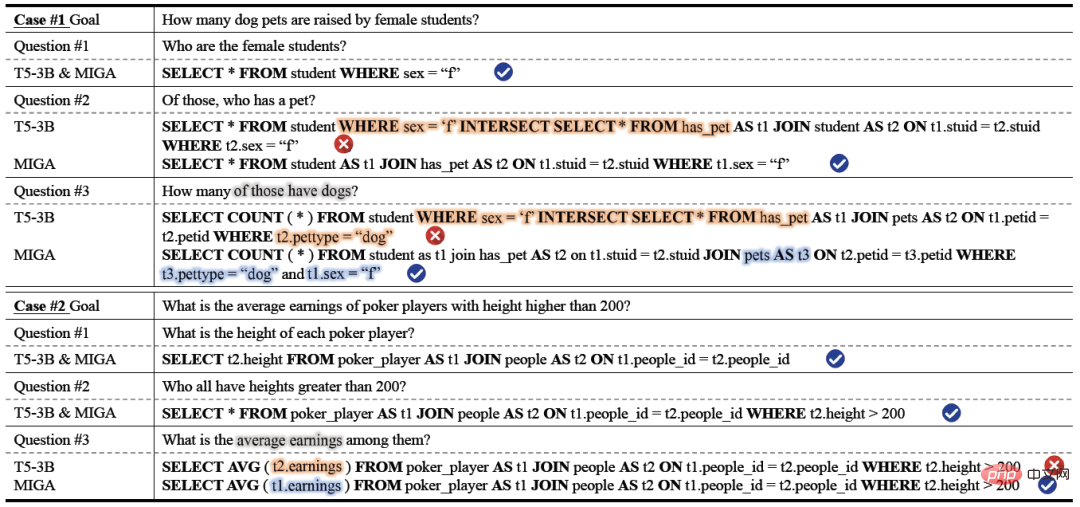

実際のケース分析結果では、MIGA 生成の安定性と正確性は、T5-3B トレーニング モデルに基づくものより優れていることがわかります。 MIGA は生成において優れています。複数テーブルの結合操作や列とテーブルのマッピングにおいては、他のモデルよりも優れています。 Case#1 の質問 #2 では、T5-3B モデルは比較的複雑な JOIN 構造 (2 つのテーブルの接続) に対して効果的な SQL を生成できません。これにより、質問のより複雑な JOIN 構造 (3 つのテーブルの接続) に対する予測が不正確になります。 #3. 。 MIGA は JOIN 構造を正確に予測し、以前の条件 t1.sex="f" を適切に維持します。ケース #2 では、T5-3B が異なるテーブルの複数の列を混同し、people テーブルの列の収益を間違えますが、MIGA はその列を poker_player テーブルに属するものとして正しく識別し、それを t1 にリンクします。

結論

NetEase Interactive Entertainment AI Lab は、Text-to-SQL の T5 に基づく 2 段階のマルチタスク事前トレーニング モデルを提案しました: MIGA 。事前トレーニング段階では、MIGA は Text-to-SQL タスクを 3 つの追加のサブタスクに分解し、それらをシーケンスからシーケンスの生成パラダイムに統合して、事前トレーニングされた T5 モデルの動機を高めます。また、複数回の Text-to-SQL 生成シナリオにおけるエラー送信の影響を軽減するために、微調整段階で SQL 摂動メカニズムが導入されています。

研究チームは今後、非常に大規模な言語モデルの機能を活用するためのより効果的な戦略をさらに検討し、誤った送信によって引き起こされる問題をさらに克服するためのより洗練された効果的な方法を検討します。 . 効果減少問題。

以上がT5 に基づく 2 段階マルチタスク Text-to-SQL 事前トレーニング モデル MIGAの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。