ホームページ >テクノロジー周辺機器 >AI >ジミー リンの顔の 3D 再構成は、2 台の A100 と 2D CNN で実現できます。

ジミー リンの顔の 3D 再構成は、2 台の A100 と 2D CNN で実現できます。

- 王林転載

- 2023-04-13 08:19:061299ブラウズ

三次元再構築 (3D Reconstruction) テクノロジーは、コンピューター グラフィックスおよびコンピューター ビジョンの分野において常に重要な研究分野です。

簡単に言えば、3D 再構成とは、2D 画像に基づいて 3D シーン構造を復元することです。

ジミー・リンが交通事故に遭った後、彼の顔の復元計画には三次元復元が使用されたと言われています。

三次元再構築のさまざまな技術ルートの統合が期待される

実際、三次元再構築技術はゲームでも活用されています。 、映画、測量、測位、ナビゲーション、自動運転、VR/AR、工業製造および消費財分野で広く使用されています。

GPU と分散コンピューティング、ハードウェアの発展に伴い、Microsoft の Kinect、Asus の XTion、Intel の RealSense などの深度カメラが徐々に成熟し、3D 再構築のコストが上昇しました。増加傾向にあるが、減少傾向を示している。

運用上、3D 再構成プロセスは大きく 5 つのステップに分けることができます。

最初のステップは、画像を取得することです。

3D 再構成はカメラの逆操作であるため、最初にカメラを使用して 3D オブジェクトの 2D 画像を取得する必要があります。

照明条件、カメラの幾何学的特性などが後続の画像処理に大きな影響を与えるため、このステップは無視できません。

2 番目のステップはカメラのキャリブレーションです。

このステップでは、カメラでキャプチャした画像を使用して空間内のオブジェクトを復元します。

通常、カメラで捉えた画像と 3 次元空間の物体との間には線形関係があると仮定され、その線形関係のパラメータを解くプロセスは次のようになります。カメラキャリブレーションと呼ばれます。

#3 番目のステップは特徴抽出です。

フィーチャには、主にフィーチャ ポイント、フィーチャ ライン、領域が含まれます。

ほとんどの場合、特徴点はマッチング プリミティブとして使用され、特徴点が抽出される形式は、使用されるマッチング戦略と密接に関係します。

したがって、特徴点を抽出するときは、まずどのマッチング方法を使用するかを決定する必要があります。

#4 番目のステップはステレオ マッチングです。ステレオマッチングとは、抽出された特徴に基づいて画像ペア間の対応関係、つまり 2 つの異なる画像内の同じ物理空間点の撮像点間の対応関係を確立することを指し、1 対 1 に対応します。

#5 番目のステップは 3 次元再構築です。

比較的正確なマッチング結果と、カメラ キャリブレーションの内部パラメータと外部パラメータを組み合わせて、3 次元シーン情報を復元できます。

これらの 5 つのステップは連動しており、各リンクが高精度かつ小さな誤差で行われて初めて、比較的正確な立体視システムを設計できます。

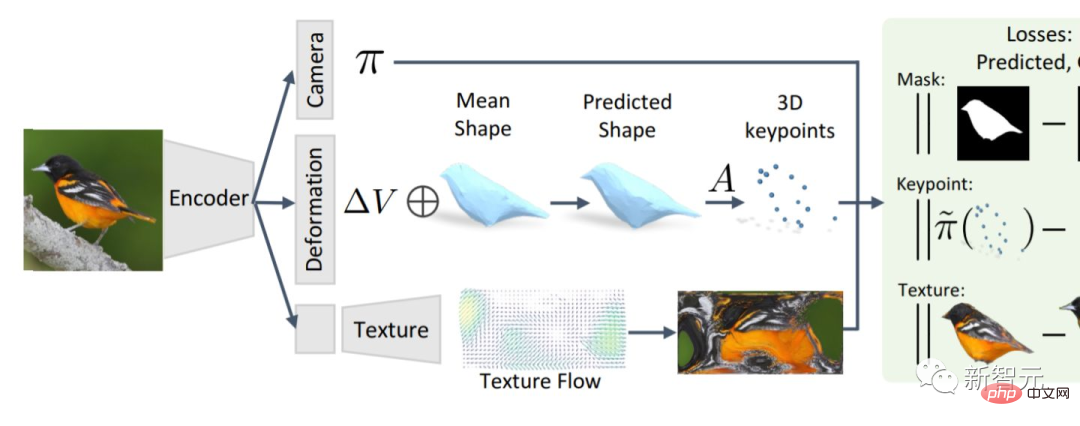

アルゴリズムに関しては、3D 再構成は大きく 2 つのカテゴリに分類でき、1 つは従来の多視点ジオメトリに基づく 3D 再構成アルゴリズムです。

#もう 1 つは、深層学習に基づく 3 次元再構成アルゴリズムです。

現在、画像特徴マッチングにおける CNN の大きな利点により、ますます多くの研究者が深層学習に基づく 3 次元再構成に注目し始めています。

ただし、この方法はほとんどが教師あり学習方法であり、データセットに大きく依存します。

データセットの収集とラベル付けは、教師あり学習にとって常に問題の原因となっているため、深層学習に基づく 3 次元再構成は主に、より小さなデータセットの再構成の方向で研究されています。オブジェクト。

さらに、深層学習に基づく 3 次元再構成は忠実度が高く、精度の点で優れたパフォーマンスを発揮します。

しかし、モデルのトレーニングには多くの時間がかかり、3D 再構成に使用される 3D 畳み込み層は非常に高価です。

そこで、一部の研究者は従来の三次元再構成手法を再検討し始めました。

従来の 3 次元再構成手法にはパフォーマンスの点で欠点がありますが、この技術は比較的成熟しています。

したがって、2 つの方法を特定に統合すると、より良い結果が得られる可能性があります。

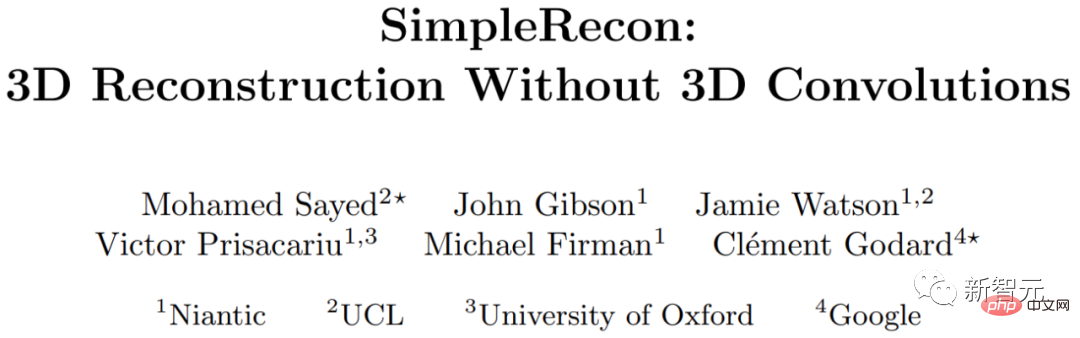

3D 畳み込み層を使用しない 3D 再構成

ロンドン大学、オックスフォード大学、Google、Niantic より (Google の各機関の研究者からスピンアウト) AR を研究する Unicorn Company など) は、3D 畳み込みを必要としない 3D 再構成方法を研究しました。

彼らは、シンプルな最先端のマルチビュー深度推定器を提案しています。

このマルチビュー深度推定器には 2 つの画期的な点があります。

1 つ目は、強力な画像事前分布を利用して、平面スキャン特徴量と幾何学的損失を取得できる、慎重に設計された 2 次元 CNN です。

2 つ目は、キーフレームと幾何学的メタデータをコスト ボリュームに統合し、情報に基づいた深度平面スコアリングを可能にする機能です。

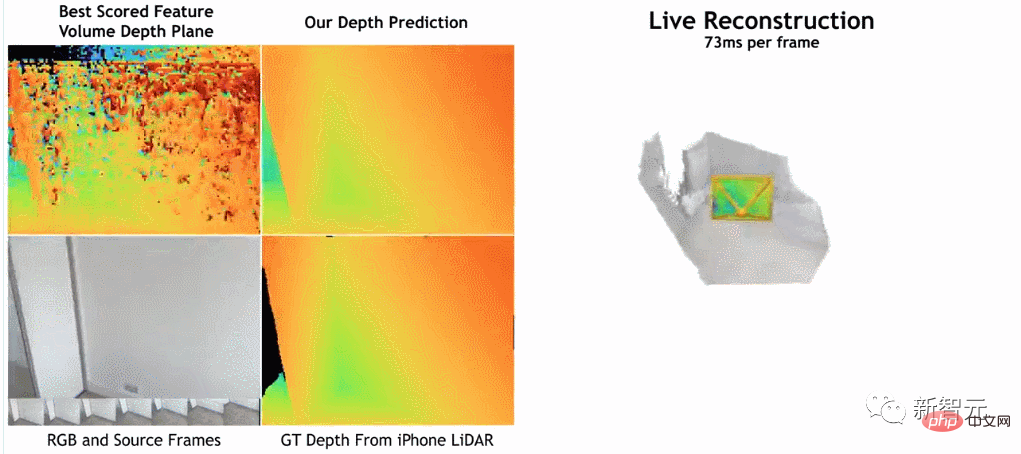

研究者らによると、彼らの方法は深度推定において現在の最先端の方法より明らかに優れています。

これは、ScanNet および 7-Scenes での 3D 再構成に近いか、それ以上の性能を備えていますが、それでもオンラインでのリアルタイムの低メモリ再構成が可能です。

さらに、再構成速度は非常に速く、1 フレームあたりわずか約 73 ミリ秒しかかかりません。

研究者らは、これにより高速深層融合による正確な再構成が可能になると考えています。

#研究者らによると、彼らの方法では、画像エンコーダを使用して参照画像からデータを抽出し、一致する特徴を抽出し、それらをコスト ボリュームに入力し、2D 畳み込みエンコーダ/デコーダ ネットワークを使用してコスト ボリュームの出力結果を処理します。

調査は PyTorch を使用して実装され、一致特徴抽出には ResNet18 を使用し、2 つの 40GB A100 GPU も使用し、全体の作業を 36 時間で完了しました。

さらに、このモデルは 3D 畳み込み層を使用していませんが、深度予測インジケーターではベースライン モデルを上回っています。

これは、慎重に設計されトレーニングされた 2D ネットワークが高品質の深度推定に十分であることを示しています。

興味のある読者は、論文の原文を読むことができます:

https://nianticlabs.github.io/ simplerecon /resources/SimpleRecon.pdf

ただし、この論文を読むには専門的な基準があり、一部の詳細は簡単には気づかない可能性があることに注意してください。

海外のネチズンがこの論文から何を発見したかを見てみるのもいいかもしれません。

「stickshiftplease」という名前のネチズンは、「A100 の推論時間は約 70 ミリ秒ですが、これはさまざまなテクニックで短縮でき、メモリ要件はそれほど高くありません」と述べています。 40GB、最小モデルでは 2.6GB のメモリを搭載。」

「IrreverentHippie」という名前の別のネチズンは、「この研究はまだLiDAR深度センサーのサンプリングに基づいていることに注意してください。これが、この方法が品質と精度の理由でこれほど優れた結果を達成する理由です。」と指摘しました。 。

「ニックソーピー」という名前の別のネチズンは、「ToF カメラの長所と短所は十分に文書化されています。ToF は、元の画像処理を悩ませるさまざまな問題を解決します。そのうちの 2 つの大きな問題は、スケーラビリティと詳細。ToF では、テーブルの端や細いポールなどの小さな詳細を識別するのが常に困難です。これは、自律または半自律アプリケーションにとって非常に重要です。センサー、混雑した交差点や自作の倉庫などで複数のセンサーを一緒に使用すると、画質が急速に低下します。シーンが多いほど、より正確な記述を作成できます。多くの研究者は、より柔軟な生の画像データを研究することを好みます。」

以上がジミー リンの顔の 3D 再構成は、2 台の A100 と 2D CNN で実現できます。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。