ホームページ >テクノロジー周辺機器 >AI >開発者は狂ったように笑っています! LLaMa の衝撃的なリークは、ChatGPT の置き換えの熱狂を引き起こし、オープンソース LLM 分野は変化しました。

開発者は狂ったように笑っています! LLaMa の衝撃的なリークは、ChatGPT の置き換えの熱狂を引き起こし、オープンソース LLM 分野は変化しました。

- 王林転載

- 2023-04-12 23:40:061210ブラウズ

予期せぬ LLaMA 漏洩が、オープンソース LLM 分野で最大のイノベーションの火花を散らすことになるとは誰が想像したでしょうか。

ChatGPT に代わる一連の優れたオープンソース ツール、「Alpaca Family」が、その後、めくるめく形で登場しました。

オープンソースと API ベースの配布の間の摩擦は、生成 AI エコシステムにおける最も差し迫った緊張の 1 つです。

テキストから画像への領域では、Stable Diffusion のリリースは、オープン ソースが基礎となるモデルの実行可能な配布メカニズムであることを明確に示しています。

ただし、大規模な言語モデルの分野ではこの限りではなく、GPT-4、Claude、Cohere などのモデルなど、この分野で最大のブレークスルーを実現できるのは、 APIを通じて。

これらのモデルに代わるオープンソースの代替品は、特に人間の指示に従う能力において、同じレベルのパフォーマンスを発揮しません。しかし、予期せぬ漏洩により状況は一変した。

LLaMA の「壮大な」リーク

数週間前、Meta AI は大規模言語モデル LLaMA を発表しました。

LLaMA には、7B、13B、33B、65B パラメーターなど、さまざまなバージョンがあります。GPT-3 よりも小さいですが、多くのタスクで GPT-3 と競合できます。パフォーマンスは同等です。 。

LLaMA は当初オープンソースではありませんでしたが、リリースから 1 週間後にモデルが突然 4chan に流出し、数千件のダウンロードを引き起こしました。

このインシデントは、大規模言語モデルの分野における無限のイノベーションの源となっているため、「壮大なリーク」と呼ぶことができます。

わずか数週間で、その上に構築された LLM エージェントの革新が爆発的に進みました。

アルパカ、ビキューナ、コアラ、ChatLLaMA、FreedomGPT、ColossalChat... この爆発的な「アルパカ ファミリー」がどのようにして生まれたのかを振り返ってみましょう。

アルパカ 3月中旬、スタンフォード大学から発売された大型モデルのアルパカが人気になりました。

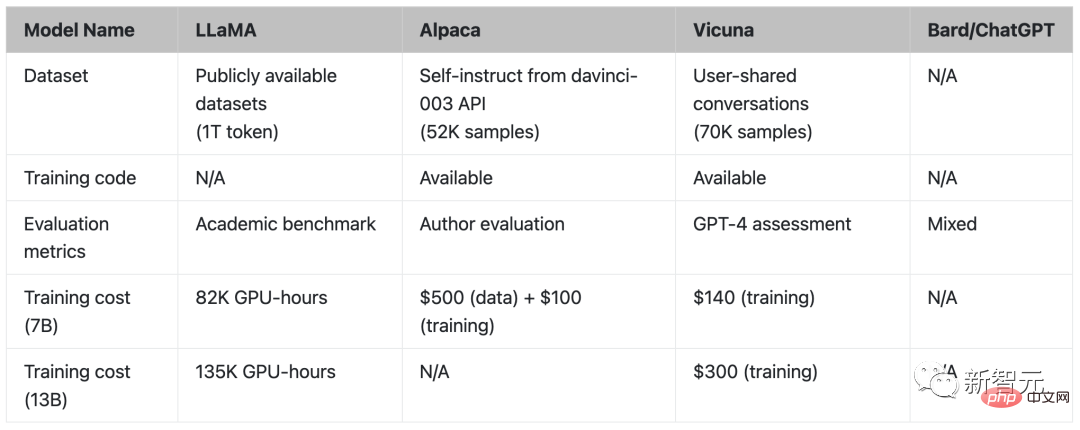

Alpaca は Meta の LLaMA 7B を微調整した新しいモデルで、使用するデータは 52k のみで、パフォーマンスは GPT-3.5 とほぼ同等です。

重要なのは、トレーニング費用が 600 米ドル未満と非常に低いことです。

スタンフォード大学の研究者は GPT-3.5 (text-davinci-003) と Alpaca 7B を比較し、2 つのモデルのパフォーマンスが非常に似ていることを発見しました。 GPT-3.5 に対しては、アルパカが 90 回対 89 回勝ちます。

スタンフォード大学のチームにとって、予算内で高品質の指導次モデルをトレーニングしたい場合は、2 つの重要な課題に直面する必要があります。それは、強力な事前トレーニング言語モデルを用意することです。高品質の指示追従データ。

まさに、学術研究者に提供された LLaMA モデルは、最初の問題を解決しました。

2 番目の課題については、論文「Self-Instruct: 自己生成命令による言語モデルの調整」が良いインスピレーションを与えてくれました。つまり、既存の強力な言語モデルを使用してコマンドを自動的に生成するというものです。データ。

LLaMA モデルの最大の弱点は、命令の微調整ができないことです。 OpenAI の最大のイノベーションの 1 つは、GPT-3 での命令チューニングの使用です。

これに関して、スタンフォード大学は既存の大規模言語モデルを使用して、次の指示のデモンストレーションを自動的に生成しました。

現在、Alpaca はネチズンから直接「大きなテキスト モデルの安定した普及」とみなされています。

Vicuna 3 月末、カリフォルニア大学バークレー校、カーネギーメロン大学、スタンフォード大学、カリフォルニア大学サンディエゴ校の研究者が、GPT-4 バージョンのパフォーマンスに匹敵する LLaMA 微調整である Vicuna をオープンソース化しました。 。

130 億パラメータの Vicuna は、ShareGPT によって収集されたユーザー共有会話に基づいて LLaMA を微調整することによってトレーニングされます。トレーニング コストはほぼ 300 米ドルです。

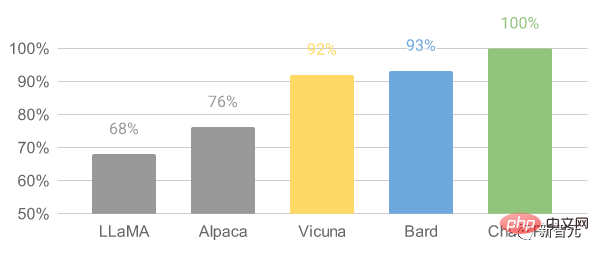

結果は、Vicuna-13B が 90% 以上のケースで ChatGPT や Bard に匹敵する機能を達成していることを示しています。

Vicuna-13B トレーニング プロセスの詳細は次のとおりです。

まず、研究者が ChatGPT での会話を開始 約 70,000 の会話が共有 Web サイト ShareGPT に収集されています。

次に、研究者らは、モデルが複数回の対話や長いシーケンスをより適切に処理できるように、Alpaca が提供するトレーニング スクリプトを最適化しました。次に、PyTorch FSDP を 8 つの A100 GPU での 1 日のトレーニングに使用しました。

モデルの品質評価の観点から、研究者は 80 の異なる質問を作成し、GPT-4 を使用してモデルの出力を評価しました。

さまざまなモデルを比較するために、研究者らは各モデルの出力を 1 つのプロンプトに結合し、どのモデルがより良い答えを与えるかを GPT-4 に評価させました。

##LLaMA、アルパカ、ビキューナ、ChatGPT の比較コアラ

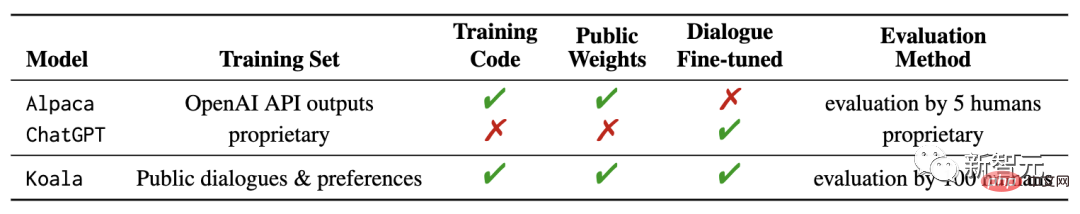

最近、カリフォルニア大学バークレー校 AI 研究所 (BAIR) が新しいモデル「Koala」をリリースしました。以前は OpenAI の GPT データを使用して命令の微調整を行っていましたが、Koala の違いはネットワーク取得を使用していることです。トレーニング用の質の高いデータ。研究結果は、コアラがさまざまなユーザーの質問に効果的に回答でき、生成された回答はアルパカよりも人気があることが多く、回答の少なくとも半分では ChatGPT と同じくらい効果的であることを示しています。時間の上下。

研究者らは、この実験の結果によって、大規模なクローズドソース モデルと小規模な公開モデルの相対的なパフォーマンスに関する議論がさらに進むことを期待しています。特に、この結果が示すように、ローカルで実行 トレーニング データが注意深く収集されていれば、小さなモデルでも大規模なモデルのパフォーマンスを達成できます。

これは、バークレーの研究者がコアラ モデルを開発してリリースするという当初の意図でもあり、この議論の結果の別の実験的証拠を提供することを望んでいます。

Koala は、ChatGPT などの高性能クローズドソース モデルとのインタラクションを含めることに特に重点を置き、Web から取得した無料のインタラクション データを微調整します。

研究者らは、データ量を最大化するためにできるだけ多くのネットワーク データをクロールすることを追求せず、ChatGPT 蒸留データ、オープンソース データなどを含む小規模で高品質のデータセットを収集することに重点を置きました。 。

ChatLLaMA

Nebuly は、独自のデータを使用して会話アシスタントを作成できるフレームワークである ChatLLaMA をオープンソース化しました。ChatLLaMA を使用すると、独自のデータと最小限の計算を使用して、ハイパーパーソナライズされた ChatGPT のようなアシスタントを作成できます。

将来、「全員を支配する」1 人の大きなアシスタントに依存しなくなると仮定すると、誰もが人間のさまざまなニーズをサポートできる、独自のパーソナライズされたバージョンの ChatGPT アシスタントを作成できるようになります。一種の需要。

ただし、このようなパーソナライズされたアシスタントを作成するには、データセットの作成、RLHF を使用した効率的なトレーニング、推論の最適化など、多くの面で労力が必要です。

このライブラリの目的は、大量のデータの最適化と収集に必要な作業を抽象化することで、開発者に安心感を与えることです。

ChatLLaMA は、開発者が RLHF トレーニングと最適化された推論に関連するさまざまなユースケースを処理できるように設計されています。使用事例の参考例をいくつか示します:

- 業種別の特定のタスク (法律、医療、ゲーム、学術研究など) 用に ChatGPT のようなパーソナライズされたアシスタントを作成します。

- ローカル ハードウェア インフラストラクチャ上の限られたデータを使用して、効率的な ChatGPT のようなアシスタントをトレーニングしたい;

- ChatGPT の独自のパーソナライズされたバージョンを作成したいアシスタントと同様に、同時に制御不能なコストを回避します;

- どのモデル アーキテクチャ (LLaMA、OPT、GPTJ など) が私の要件を最もよく満たすかを知りたいです。ハードウェア、コンピューティングの予算、パフォーマンスの条件;

- アシスタントを私の個人/会社の価値観、文化、ブランド、マニフェストに合わせたいと考えています。

- FreedomGPT

Electron と React で構築された FreedomGPT は、ユーザーがローカル マシン上で LLaMA を実行できるようにするデスクトップ アプリケーションです。

FreedomGPT の特徴はその名前からも明らかです。回答する質問は検閲やセキュリティ フィルタリングの対象になりません。

このアプリは、AI ベンチャー キャピタル会社 Age of AI によって開発されました。

FreedomGPT は Alpaca に基づいて構築されています。 Alpaca は他のモデルに比べてアクセスやカスタマイズが比較的簡単であるため、FreedomGPT は Alpaca の特徴的な機能を使用します。

ChatGPT は OpenAI の使用ポリシーに従い、憎しみ、自傷行為、脅迫、暴力、性的コンテンツを制限します。

ChatGPT とは異なり、FreedomGPT は偏見やひいき目なしに質問に答え、物議を醸すトピックや物議を醸すトピックにも躊躇なく答えます。

FreedomGPT は、OpenAI が特に GPT-4 から削除した「自宅で爆弾を作る方法」にも回答しました。

FreedomGPT がユニークなのは、検閲の制限を克服し、物議を醸すトピックに何の保証も与えない点です。そのシンボルが自由の女神であるのは、このユニークで大胆な大きな言語モデルが自由を象徴しているためです。

FreedomGPT は、インターネット接続を必要とせずに、コンピュータ上でローカルに実行することもできます。

さらに、オープンソース バージョンが間もなくリリースされ、ユーザーや組織が完全にカスタマイズできるようになります。

ColossalChat

UC Berkeley が提案した ColossalChat は、中国語と英語のバイリンガル機能を実現するために 100 億未満のパラメータを必要とし、その効果は ChatGPT および GPT-3.5 と同等です。

さらに、LLaMA モデルに基づく ColossalChat も完全な RLHF プロセスを再現しており、現在、ChatGPT の元の技術的ルートに最も近いオープン ソース プロジェクトです。

中国語と英語のバイリンガル トレーニング データ セット

ColossalChat は、約 100,000 の中国語と英語の質問と回答のペアを含むバイリンガル データ セットをリリースしました。

このデータ セットは、ソーシャル メディア プラットフォーム上の実際の問題シナリオからシード データ セットとして収集およびクリーンアップされ、自己指示を使用して拡張されます。アノテーションのコストは約 900 ドルです。

他の自己指導メソッドによって生成されたデータセットと比較して、このデータセットには、より現実的で多様なシード データが含まれており、より広範囲のトピックをカバーしています。

このデータセットは、微調整と RLHF トレーニングに適しています。 ColossalChat は、高品質のデータを提供することで、より優れた会話対話を実現でき、中国語もサポートします。

完全な RLHF パイプライン

RLHF アルゴリズムのレプリケーションには 3 つの段階があります:

RLHF-Stage1 では、上記のバイリンガル データセットを使用して教師あり命令の微調整が実行され、モデルが微調整されます。

RLHF-Stage2 では、同じプロンプトのさまざまな出力を手動でランク付けして対応するスコアを割り当て、報酬モデルのトレーニングを監視することによって報酬モデルがトレーニングされます。

RLHF-Stage3 では、トレーニング プロセスの最も複雑な部分である強化学習アルゴリズムが使用されます。

#さらに多くのプロジェクトがすぐにリリースされると思います。

この LLaMA の予期せぬ漏洩が、実際にオープンソース LLM の分野で最大のイノベーションの火花を散らすことになるとは誰も予想していませんでした。

以上が開発者は狂ったように笑っています! LLaMa の衝撃的なリークは、ChatGPT の置き換えの熱狂を引き起こし、オープンソース LLM 分野は変化しました。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。