この記事はAI New Media Qubit(公開アカウントID:QbitAI)の許可を得て転載していますので、転載については出典元にご連絡ください。

AI絵画の侵害が確認されました!

最新の研究では、拡散モデルが トレーニング セット内のサンプルを しっかりと記憶し、生成時に「例に従う」ことが示されています。

つまり、Stable Diffusion によって生成された AI 絵画では、すべてのストロークの背後に侵害事件が存在する可能性があります。 研究と比較の結果、トレーニング サンプルから「盗用」する拡散モデルの能力は GAN の 2 倍であり、拡散モデルが生成されるほど、トレーニング サンプルを記憶する能力も強化されます。

この研究は、Google、DeepMind、カリフォルニア大学バークレー校で構成されるチームによるものです。

論文にはもう 1 つの悪いニュースがあります。つまり、この現象に対応して、

論文にはもう 1 つの悪いニュースがあります。つまり、この現象に対応して、

。 このニュースが出るやいなや、ネチズンは爆発的に増え、この論文の著者の関連する Twitter のリツイートは 1,000 件を超えようとしていた。

一部の人は嘆きました。他人の著作権で保護された結果を盗むと言うのは理にかなっていることがわかりました。

一部の人は嘆きました。他人の著作権で保護された結果を盗むと言うのは理にかなっていることがわかりました。

訴訟を支持してください!訴えてやる!

誰かが拡散モデルの側に立って次のように話しました。

誰かが拡散モデルの側に立って次のように話しました。

一部のネチズンはまた、この結果を拡張しました。 ChatGPT について:

一部のネチズンはまた、この結果を拡張しました。 ChatGPT について:

既存のプライバシー保護方法はすべて無効です

既存のプライバシー保護方法はすべて無効です

拡散モデルの原則は、したがって、研究者が実際に研究する必要があるのは、

彼らはトレーニングに使用された画像を覚えていて、最終的に生成中に

を「盗用」したかということです。 トレーニング セット内の画像はインターネットから取得されることが多く、著作権や商標で保護されており、民間の医療用 X 線写真などプライベートなものもあります。 拡散モデルが個々のトレーニング サンプルを

記憶して再生成できるかどうかを解明するために、研究者らはまず「記憶」の新しい定義を提案しました。 一般的に、記憶の定義はテキスト言語モデルに焦点を当てています。トレーニング セットから単語ごとのシーケンスを復元するようにモデルに指示できる場合、それはシーケンスが抽出され記憶されていることを意味します。対照的に、研究チーム

は画像の類似性に基づいて「記憶」を定義しました。 しかし、チームは「記憶」の定義が保守的であることも率直に認めています。たとえば、左側の画像は安定拡散によって生成された「オバマの写真」です。この画像は右側の特定のトレーニング画像とは似ていないため、この画像は記憶に基づくものとしてカウントできません。 生成する。

#しかし、これは、新しい識別可能な画像を生成する Stable Difusion の機能が著作権とプライバシーを侵害しないという意味ではありません。

次に、個人の写真や会社の入札書など 1,000 件を超えるトレーニング サンプルを抽出し、

2 段階のデータ抽出 (データ抽出攻撃)

(データ抽出攻撃)

この方法を Stable Diffusion と Imagen に適用すると、チームはトレーニング画像の近似または同一のコピーを 100 個以上抽出しました。 個人を特定できる写真と商標ロゴが含まれており、検査した結果、そのほとんどは著作権で保護されています。

次に、「記憶」がどのように発生するかをより深く理解するために、研究者らはモデルから 100 万回サンプリングし、CIFAR-10 で数百の拡散モデルをトレーニングしました。

目的は、モデルの精度、ハイパーパラメーター、拡張機能、重複排除のどの動作がプライバシーに影響を与えるかを分析することです。

最終的に次の結論に達しました:

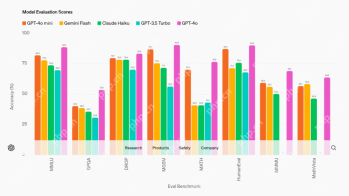

まず第一に、拡散モデルは GAN よりも多くのメモリを備えています。

しかし、拡散モデルは評価された画像モデルの中で最悪のプライベートグループでもあり、GANの2倍以上のトレーニングデータを漏洩しています。

また、モデルが大規模であれば、より多くのデータを記憶できる可能性があります。

この結論を受けて、研究者らは 20 億パラメータのテキスト画像拡散モデル Imagen についても研究し、分布外で最高スコアを持つ 500 枚の画像を抽出し、それらをトレーニング データ セットのサンプルとして使用することを試みました。すべてが記憶されていることがわかりました。

対照的に、同じ方法を安定拡散に適用しても、メモリの動作は特定されませんでした。

したがって、Imagen は、コピーされた画像とコピーされていない画像に関して、Stable Difusion よりもプライバシーが劣ります。研究者らは、Imagen が使用するモデルの容量が Stable Difusion よりも大きいため、より多くの画像を記憶していることがその理由であると考えています。

さらに、より優れた生成モデル(FID 値が低くなります)より多くのデータが保存されます 。

言い換えれば、時間が経つにつれて、同じモデルからより多くのプライバシーが漏洩し、より多くの著作権を侵害することになります。

(GAN モデルは FID で並べ替えられ、FID 値が低いほど効果が高くなります)

モデルのトレーニングを通じて、チームは次のことを発見しました。その ユーティリティの増加はプライバシーを低下させます し、単純な防御手段 (重複排除など) だけではメモリ攻撃を完全に解決するのに十分ではありません。

したがって、プライバシー強化テクノロジーは、プライバシーとユーティリティの許容可能なトレードオフを提供しません。

最終的に、チームは拡散モデルをトレーニングする人に 4 つの提案を行いました:

- トレーニング データ セットから重複データを削除し、オーバートレーニングを最小限に抑えることをお勧めします。 # トレーニング モデルのプライバシー リスクを評価するには、データ抽出またはその他の監査手法を使用することをお勧めします。

- より実用的なプライバシー保護テクノロジがある場合は、可能な限りそれらを使用することをお勧めします。 ;

- AI によって生成された画像が表示されないことを願っています プライバシーに関連する部分はユーザーに無料で提供されます。

(ゲッティイメージズ) は著作権侵害の名目でロンドン高等裁判所にStability AIを訴えた。

一度も写真代理店とやり取りしませんでした。 多くの AI 企業は、この行為が米国のフェアユース原則などの法律によって保護されていると信じていますが、ほとんどの著作権所有者はこの声明に同意しておらず、この行為が自社の権利を侵害していると考えています。

Stability AI は以前、次のバージョンでは著作権所有者 がトレーニング ギャラリー内の自分の著作権で保護された作品を削除できるとの声明を発表しましたが、現段階では、まだ不満を持っている人もいます。 1月中旬、3人のアーティストがStability AIとMidjourneyに対して訴訟を起こした。

法律専門家も統一見解を得るためにさまざまな意見を持っていますが、著作権保護の問題については裁判所が判決を下す必要があるという点では全員一致しています。 ゲッティ イメージズ CEO クレイグ ピーターズ氏は、同社が Stability AI に「間もなく英国で訴訟されるだろう」という通知を送ったと述べました。同社は次のようにも述べています:

当社は侵害によって生じる損失については気にしておらず、AI アート ツールの開発を中止するつもりはありません。

Stability AI を法廷に持ち込むことは、ゲッティ家の利益にはなりません。

訴訟を選択することには、より深い長期的な目的があり、裁判所が新しい法律を制定して現状を規制することを願っています。

以上がAI絵画侵害が確定!拡散モデルはあなたの写真を記憶する可能性があり、既存のプライバシー保護方法はすべて無効になりますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

LM Studioを使用してLLMをローカルに実行する方法は? - 分析VidhyaApr 19, 2025 am 11:38 AM

LM Studioを使用してLLMをローカルに実行する方法は? - 分析VidhyaApr 19, 2025 am 11:38 AM自宅で大規模な言語モデルを簡単に実行する:LM Studioユーザーガイド 近年、ソフトウェアとハードウェアの進歩により、パーソナルコンピューターで大きな言語モデル(LLM)を実行することが可能になりました。 LM Studioは、このプロセスを簡単かつ便利にするための優れたツールです。この記事では、LM Studioを使用してLLMをローカルに実行する方法に飛び込み、重要なステップ、潜在的な課題、LLMをローカルに配置することの利点をカバーします。あなたが技術愛好家であろうと、最新のAIテクノロジーに興味があるかどうかにかかわらず、このガイドは貴重な洞察と実用的なヒントを提供します。始めましょう! 概要 LLMをローカルに実行するための基本的な要件を理解してください。 コンピューターにLM Studiをセットアップします

Guy Periは、データ変換を通じてMcCormickの未来のフレーバーを支援しますApr 19, 2025 am 11:35 AM

Guy Periは、データ変換を通じてMcCormickの未来のフレーバーを支援しますApr 19, 2025 am 11:35 AMGuy Periは、McCormickの最高情報およびデジタルオフィサーです。彼の役割からわずか7か月後ですが、ペリは同社のデジタル能力の包括的な変革を急速に進めています。データと分析に焦点を当てている彼のキャリアに焦点が当てられています

迅速なエンジニアリングの感情の連鎖は何ですか? - 分析VidhyaApr 19, 2025 am 11:33 AM

迅速なエンジニアリングの感情の連鎖は何ですか? - 分析VidhyaApr 19, 2025 am 11:33 AM導入 人工知能(AI)は、言葉だけでなく感情も理解し、人間のタッチで反応するように進化しています。 この洗練された相互作用は、AIおよび自然言語処理の急速に進む分野で重要です。 th

データサイエンスワークフローのための12のベストAIツール-AnalyticsVidhyaApr 19, 2025 am 11:31 AM

データサイエンスワークフローのための12のベストAIツール-AnalyticsVidhyaApr 19, 2025 am 11:31 AM導入 今日のデータ中心の世界では、競争力と効率の向上を求める企業にとって、高度なAIテクノロジーを活用することが重要です。 さまざまな強力なツールにより、データサイエンティスト、アナリスト、開発者が構築、Deplを作成することができます。

AV BYTE:OpenAIのGPT-4O MINIおよびその他のAIイノベーションApr 19, 2025 am 11:30 AM

AV BYTE:OpenAIのGPT-4O MINIおよびその他のAIイノベーションApr 19, 2025 am 11:30 AM今週のAIの風景は、Openai、Mistral AI、Nvidia、Deepseek、Hugging Faceなどの業界の巨人からの画期的なリリースで爆発しました。 これらの新しいモデルは、TRの進歩によって促進された電力、手頃な価格、アクセシビリティの向上を約束します

PerplexityのAndroidアプリにはセキュリティの欠陥が感染しているとレポートApr 19, 2025 am 11:24 AM

PerplexityのAndroidアプリにはセキュリティの欠陥が感染しているとレポートApr 19, 2025 am 11:24 AMしかし、検索機能を提供するだけでなくAIアシスタントとしても機能する同社のAndroidアプリは、ユーザーをデータの盗難、アカウントの買収、および悪意のある攻撃にさらす可能性のある多くのセキュリティ問題に悩まされています。

誰もがAIの使用が上手になっています:バイブコーディングに関する考えApr 19, 2025 am 11:17 AM

誰もがAIの使用が上手になっています:バイブコーディングに関する考えApr 19, 2025 am 11:17 AM会議や展示会で何が起こっているのかを見ることができます。エンジニアに何をしているのか尋ねたり、CEOに相談したりできます。 あなたが見ているところはどこでも、物事は猛烈な速度で変化しています。 エンジニア、および非エンジニア 違いは何ですか

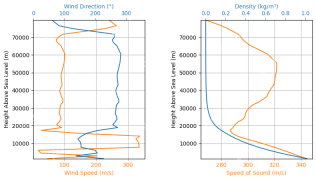

Rocketpyを使用したロケットの起動シミュレーションと分析-AnalyticsVidhyaApr 19, 2025 am 11:12 AM

Rocketpyを使用したロケットの起動シミュレーションと分析-AnalyticsVidhyaApr 19, 2025 am 11:12 AMRocketpy:A包括的なガイドでロケット発売をシミュレートします この記事では、強力なPythonライブラリであるRocketpyを使用して、高出力ロケット発売をシミュレートすることをガイドします。 ロケットコンポーネントの定義からシミュラの分析まで、すべてをカバーします

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

MinGW - Minimalist GNU for Windows

このプロジェクトは osdn.net/projects/mingw に移行中です。引き続きそこでフォローしていただけます。 MinGW: GNU Compiler Collection (GCC) のネイティブ Windows ポートであり、ネイティブ Windows アプリケーションを構築するための自由に配布可能なインポート ライブラリとヘッダー ファイルであり、C99 機能をサポートする MSVC ランタイムの拡張機能が含まれています。すべての MinGW ソフトウェアは 64 ビット Windows プラットフォームで実行できます。

SublimeText3 中国語版

中国語版、とても使いやすい

EditPlus 中国語クラック版

サイズが小さく、構文の強調表示、コード プロンプト機能はサポートされていません

AtomエディタMac版ダウンロード

最も人気のあるオープンソースエディター

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境