ホームページ >テクノロジー周辺機器 >AI >Meta が MoDem ワールド モデルを発表: LeCun が提案した、視覚分野における 3 つの主要な課題を解決

Meta が MoDem ワールド モデルを発表: LeCun が提案した、視覚分野における 3 つの主要な課題を解決

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-12 20:22:011607ブラウズ

#12 月 27 日、

#、MetaAI の A

## 27日夕方現在、このツイートの読書量は73.9kに達しました。

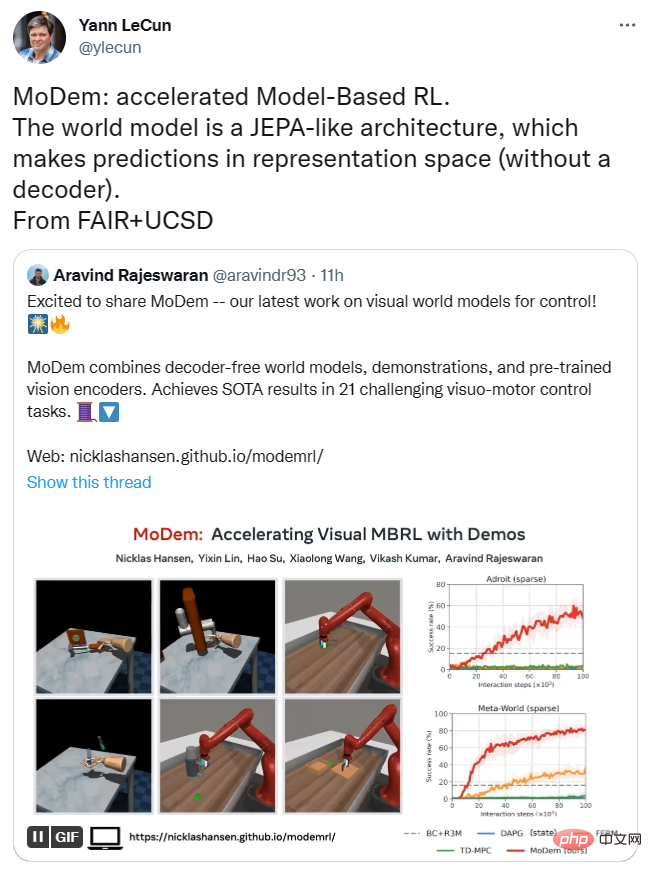

彼は、わずか 5 つのデモンストレーションで、MoDem は 10 万のインタラクション ステップで、報酬がまばらで高次元のアクション スペースの問題を解決できると述べました。困難な視覚的モーション制御タスクに対する最先端の手法。

それはどれほど優れていますか? 彼らは、MoDem が低データ領域での以前の方法よりも、まばらな報酬タスクの完了において 150% ~ 250% 高い成功率を達成したことを発見しました。

## ####。

Lecun 氏はまた、この研究を転送し、MoDem のモデル アーキテクチャは JEPA に似ており、デコーダを必要とせずに表現空間で予測を行うことができると述べました。 。

#編集者が以下にリンクを貼っていますので、ご興味があればご覧ください~

紙のリンク: https://arxiv.org/abs/2212.05698

Github リンク: https://arxiv.org/abs/2212.05698 : //github.com/facebookresearch/modem

研究のイノベーションとモデル アーキテクチャ

サンプル効率が低いということは、深層強化学習の導入の実用化です ( RL) アルゴリズム 主な課題、特に視覚運動制御。モデルベースの RL には、ワールド モデルの学習と計画とポリシーの改善のための合成デプロイメントの使用を同時に行うことで、高いサンプル効率を達成できる可能性があります。

しかし、実際には、モデルベースの RL におけるサンプルの効率的な学習は探索の課題によってボトルネックになっており、この研究はこれらの主な課題を正確に解決します。

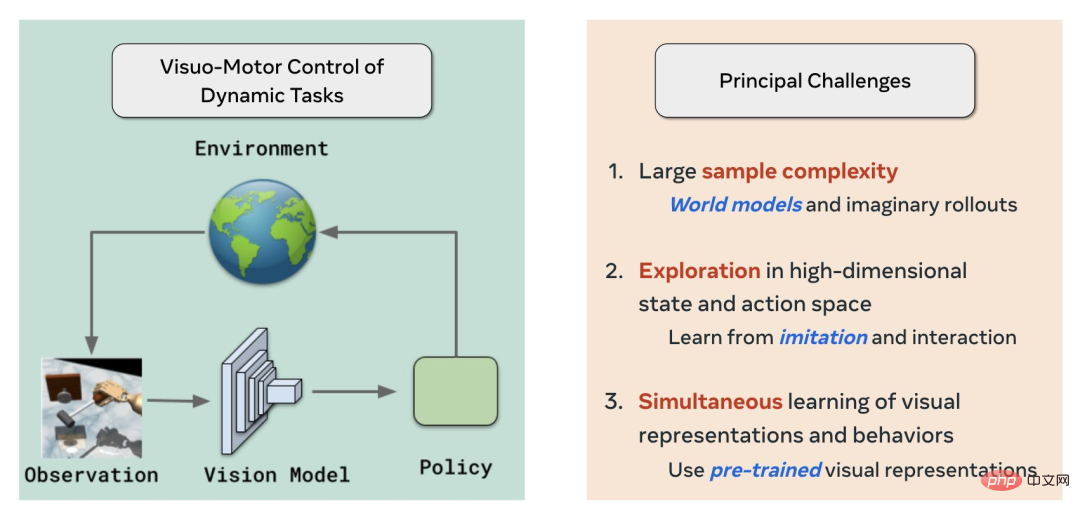

まず、MoDem は、ワールド モデルを使用し、RL と自己教師あり視覚事前トレーニングをそれぞれ模倣することで、視覚強化学習/制御の分野における 3 つの主要な課題を解決します。

- サンプルの複雑さが大きい

- 高次元の状態およびアクション空間の探索

- 同時学習視覚的表現と動作の

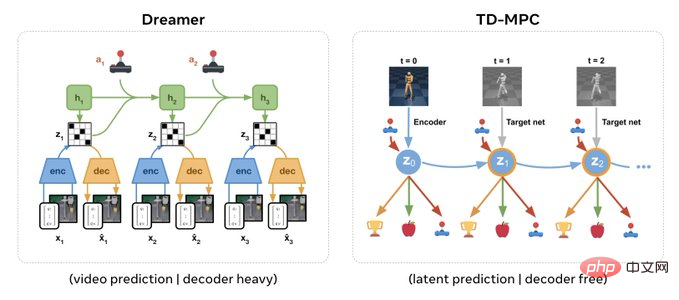

#これ モデル アーキテクチャは、Yann LeCun の JEPA に似ており、デコーダを必要としません。

著者の Aravind Rajeswaran 氏は、ピクセル レベルの予測にデコーダが必要で重いアーキテクチャを持つ Dreamer と比較して、デコーダのないアーキテクチャは、事前に視覚表現の直接挿入をサポートできると述べました。 -SSLを使用してトレーニングされています。

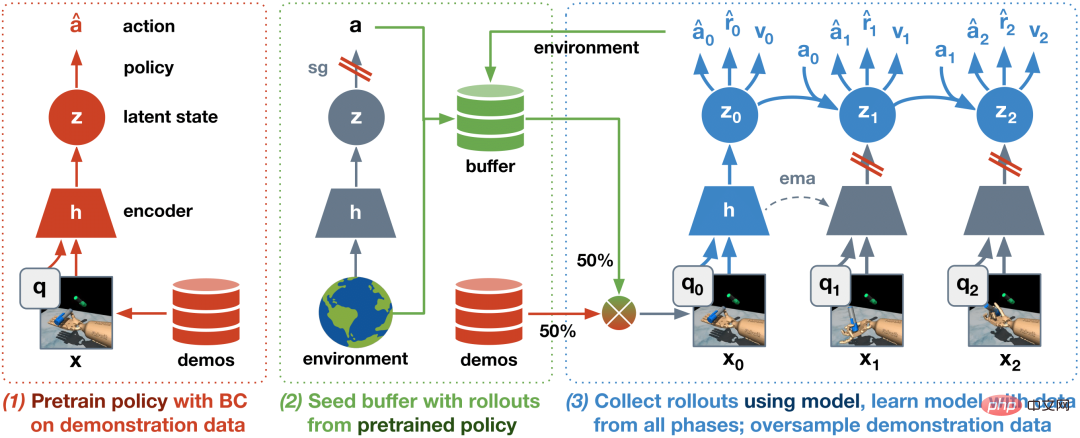

さらに、IL RL に基づいて、次の 3 段階のアルゴリズムを提案しました。

- BC 事前トレーニング戦略

- デモンストレーションと探索を含むシード データセットを使用して世界モデルを事前トレーニングします。この段階は全体的な安定性と効率にとって重要です。

- オンライン インタラクションによる世界モデルの微調整

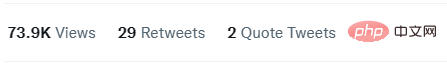

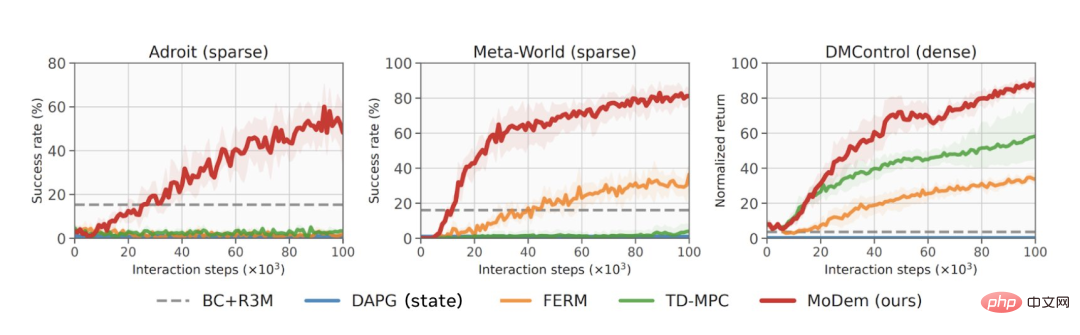

##結果は、生成されたアルゴリズムは、Adroit の器用な操作、MetaWorld、DeepMind コントロール スイートを含む、ハード ビジュアル モーション コントロール タスクで 21 の SOTA 結果 (最先端の結果) を達成しました。

データの観点から見ると、MoDem はさまざまなタスクにおいて他のモデルよりもはるかに優れたパフォーマンスを発揮し、結果は以前の SOTA 手法よりも 150% ~ 250% 高くなります。

#赤い線は、さまざまなタスクにおける MoDem のパフォーマンスを示しています。

このプロセスでは、MoDem のさまざまな段階の重要性、ビジュアル MBRL のデータ拡張の重要性、事前トレーニングされたビジュアル表現の有用性についても明らかにしています。最後に、凍結された R3M 機能を使用することは、直接的な E2E アプローチよりもはるかに優れています。これは刺激的であり、ビデオからの視覚的な事前トレーニングが世界モデルをサポートできることを示しています。

しかし、8 月の強力なデータを持つ E2E は凍結された R3M と競合します。事前トレーニングを通じてより良い結果を得ることができます。

以上がMeta が MoDem ワールド モデルを発表: LeCun が提案した、視覚分野における 3 つの主要な課題を解決の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。