ホームページ >テクノロジー周辺機器 >AI >ChatGPTの過去と現在:OpenAIの技術「頑固さ」と「大きな賭け」

ChatGPTの過去と現在:OpenAIの技術「頑固さ」と「大きな賭け」

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB転載

- 2023-04-12 12:16:031104ブラウズ

1. ChatGPT、もはや「愚か」ではない人工知能

ChatGPT 関連のトピックは、AlphaGo 以来、最も人気のある人工知能のホットスポットとみなされるべきです。簡単に言うと自然言語で会話できるロボットで、どんな質問をしても(もちろん間違った答えをすることもありますが、指導したり修正したりすることができます)、とてもスムーズで標準的な自然な言葉で答えてくれます。言語、あなた。それだけでなく、コーディングの質問や数学の質問などにも答えることができ、どんな問題についても楽しく会話することができます。

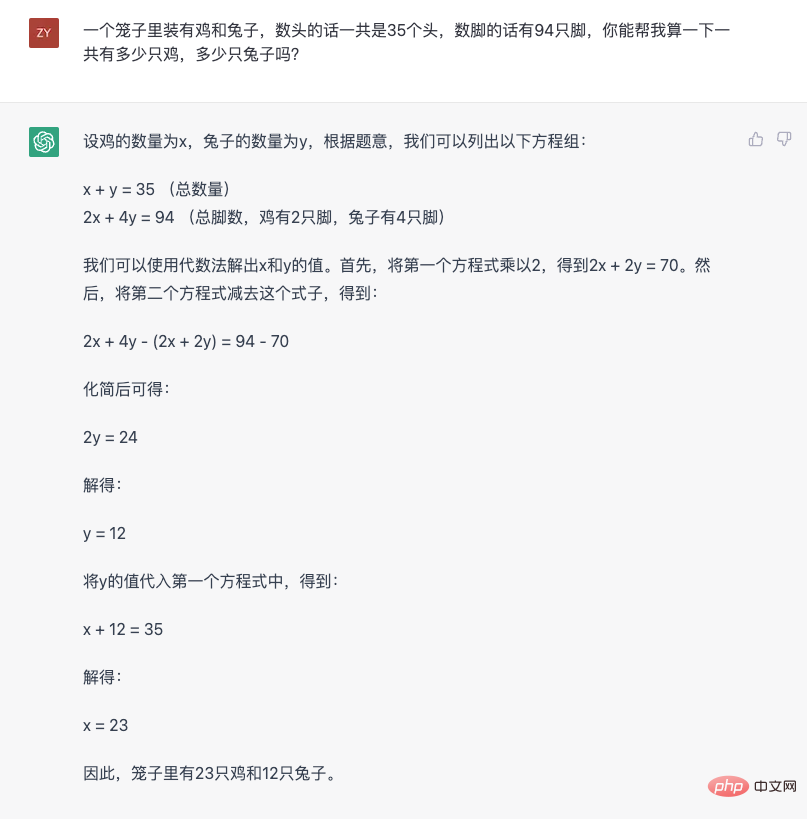

古典的なニワトリとウサギの問題を使用して、ChatGPT の機能を知覚的に理解できます。

この回答からは、いくつかの特徴が観察できます。 1 つ目は、自然言語を理解し、数学的問題に変換する能力であり、2 つ目は、より複雑な推論問題を段階的に分解して、最終的な答えを段階的に得る能力です。この能力は業界では「思考の連鎖」と呼ばれています。次に、質問を変更して、その反応を確認します。

この図から、ChatGPT がその内容を認識しており、その理由を説明できることがわかります。 。さらに、間違いがあることもわかります(最初に耳の数を計算したときは間違っていました。ここで豆知識ですが、ニワトリには「耳」に似た機能的な器官があります)が、指導することはできます。正しい答えを述べ、なぜ間違っているのかを説明してください。

これが人工知能モデルであることを事前に断っておきますが、ChatGPT は論理的思考と言語コミュニケーション能力を備えた本物の人間のように感じられます。 その姿は、人工知能が人間と正常にコミュニケーションできていることを初めて誰もが感じさせたものであり、時には間違いを犯すこともありましたが、少なくともコミュニケーションのプロセスには言語と論理の壁はありませんでした。あなたが話していることを「理解」し、人間の思考パターンと言語規範に従ってフィードバックを返します。この非常にインテリジェントなエクスペリエンスが、業界の小さなサークルを突破し、一般の人々に衝撃をもたらす理由です。

また、このエクスペリエンスの問題についても改めて強調したいと思います。おそらく過去には、技術的な制限により、業界はシーン内の特定のタスクを完了するためにこの点を無視していたからです。今日の ChatGPT の出現は、人工知能がもはや過去の「便利だが愚かな」形式ではないことを意味します。ChatGPT の非常にインテリジェントな感覚がどのようにして生まれたのかをよりよく理解するには、過去の「愚かな」人工知能から始めることが避けられません。正確に言うと、ChatGPT は依然として自然言語処理 (NLP) テクノロジーを使用していますが、元のパラダイムを破壊しています。

これを理解するには、まず現在の主流の実践を見てみましょう。人間のコミュニケーションは言語に依存しており、人間の思考も言語に基づいていると多くの人が信じています。したがって、自然言語を理解して使用することは、人工知能において常に重要なテーマです。しかし、言語は複雑すぎるため、コンピューターが言語を理解して使用するために、このプロセスは通常、技術分野でよく「タスク」と呼ばれる多くの部分に分割されます。いくつかの例を挙げると:

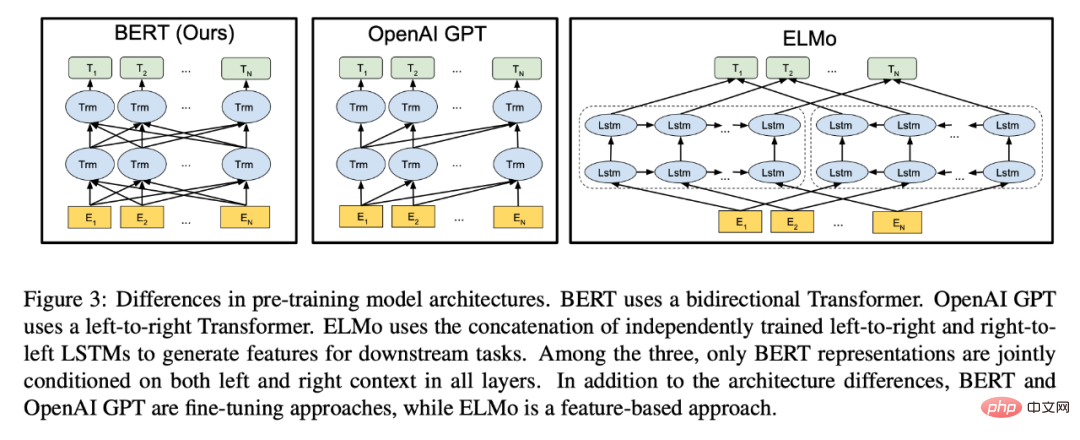

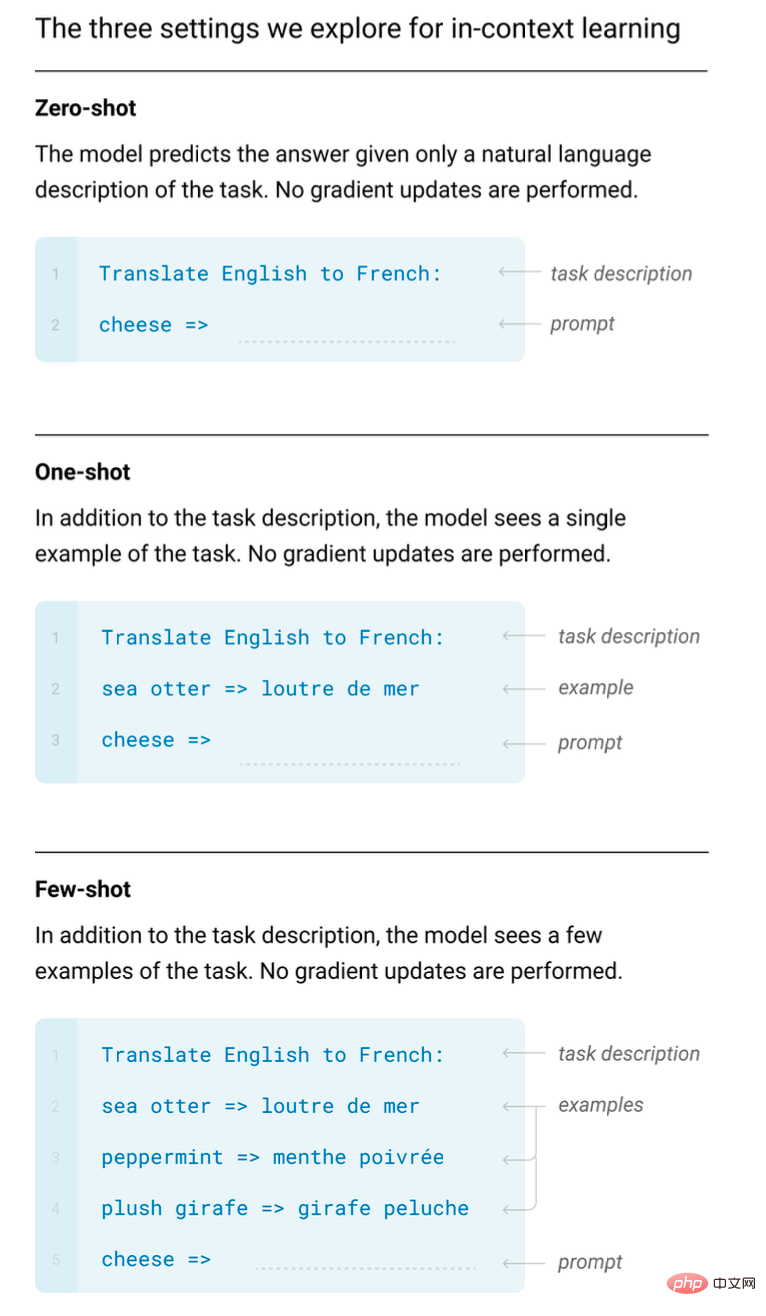

#このようなタスクは多数あり、そのすべてが特定の細分化された自然言語を分析します。これを行うことには多くの利点があります。たとえば、これらの分割を使用すると、自然言語処理システムのセグメンテーション機能をさまざまな次元から調べることができます。また、特定のセグメント化された項目に特化したシステムまたはモデルを設計することもできます。技術的な観点から見ると、複雑なタスク (自然言語の理解と使用) を多くの単純なタスク (さまざまな NLP タスク) に分割することは、複雑な問題を解決するための典型的な方法であり、現在の主流の手法でもあります。しかし、ChatGPT の出現後、後から考えると、おそらくこの分割は、コンピュータが自然言語を理解して使用できるようにするための最も効果的な方法ではありません。 単一タスクで優れたパフォーマンスを発揮しても、システムが自然言語を習得していることを意味するわけではありません。 人工知能に対する人々の「知性の感覚」は、人工知能に自然言語を適用する全体的な能力に基づいており、それは ChatGPT に明確に反映されています。 OpenAI は ChatGPT の API サービスをオープンしておらず、外部の世界は細分化されたさまざまな NLP タスクに対するその具体的な効果を評価できませんでしたが、その前身である GPT-3、InstructGPT、およびその他のモデルの過去の外部テストでは、一部の特定のタスクに対して、特殊なデータを使用して微調整された小さなモデルであるタスクは、確かにより良い結果を達成できます (詳細な分析については、「言語モデルの創発機能の詳細な理解」を参照してください)。しかし、単一のタスクでより優れたパフォーマンスを発揮するこれらの小さなモデルは、大きな範囲外の効果を引き起こしません。結局のところ、能力が一つしかないからです。優れた能力が 1 つあるだけでは、自然言語を理解して使用する能力があるとは限りません。そのため、それだけでは実際のアプリケーション シナリオで役割を果たすことはできません。このため、通常、実際のアプリケーション シナリオでは、シングルポイント機能を備えた複数のモジュールが人為的に設計され、まとめられますが、この人為的なパッチワーク方法が、過去の人工知能システムをインテリジェントではないと感じさせる原因の 1 つとなっています。 人間が自然言語を理解して使用するという観点から見ると、この現象は実際には簡単に理解できます。一般の人が自然言語を理解して使用する場合、頭の中で自然言語をいくつかのタスクに分割し、それぞれのタスクを一つ一つ分析し、それを要約するのではなく、人間が自然言語を使用する方法ではありません。人が文章を聞くときと同じように、その構文構造、実体の内容と関係性、感情的傾向などを一つ一つ分析して、その文章の意味をつなぎ合わせていくのではなく、人が言語を理解するプロセスです。総合的なプロセス。さらに、この文に対する人々の全体的な理解は、返信を通じて自然言語の形で完全に表現されます。このプロセスは、単一のタスクを分割し、感情分析ラベル、エンティティ情報の断片、または他の単一タスクの結果を 1 つずつ出力し、これらを使用して応答をつなぎ合わせる人工知能システムとは異なります。 そしてChatGPT に代表される GPT シリーズ モデルが行うことは、人間の言語を理解して使用する能力に非常に近いものです。自然言語を直接受け取り、その後、直接自然言語に応答し、言語の流暢さと論理を確保します。これは人々がコミュニケーションをとる方法なので、誰もがこれを「非常にスマートな」経験だと考えています。 ChatGPTみたいにできたらいいのに、と思う人も多いかもしれませんが、これまでのタスクの分割は技術的な限界から苦肉の策でした。技術応用の観点からは、このような迂回的なアプローチは当然必要ですが、この方法は古くから採用されており、実際のシナリオで多くの問題を解決できます。しかし、GPT シリーズ モデルの開発プロセスを振り返ると、OpenAI が別の道に「賭け」、「賭け」て勝利したことがわかります。 2. OpenAI の「ギャンブル」 GPT の第一世代、ここからすべてが始まります 2018 年という早い時期に、OpenAI は GPT モデルの初期バージョンをリリースしました。OpenAI の公開論文 (生成的事前トレーニングによる言語理解を向上させる) から、このモデルが 12 層のトランスフォーマー デコーダ構造を使用していることがわかります。 . 、言語モデル タスクのトレーニングには、約 5 GB の教師なしテキスト データが使用されました。 第一世代 GPT モデルはすでに生成事前トレーニング (GPT、Generative Pre-Training、つまり生成事前トレーニングの名前の由来でもあります) を使用していましたが、教師なし事前トレーニングを使用していました。下流タスクのトレーニング。微調整されたパラダイム。このパラダイムは実際には新しい発明ではなく、CV (コンピュータ ビジョン) の分野で広く使用されていましたが、同年の ELMo モデルの優れた性能により、NLP の分野に再導入されました。 GPT モデルの登場は、その年業界である程度の注目を集めましたが、その年の主役は C ではありませんでした。なぜなら、同じ年にGoogleのBERTモデルが発表され、その優れた結果でほぼすべての注目を集めたからです(このシーンは現在のChatGPTに少し似ています。GoogleとOpenAIの間の「不満」は本当に深刻であるとため息をつきました)生まれ変わり)。 画像は BERT 論文からのものです。図から、BERT が以下に対してベンチマークされたことがわかります。 GPT および双方向エンコード機能が誇らしげに注目されています。 #BERT モデルも GPT と同じ Transformer モデル構造を使用していますが、ほぼ「教師なし事前トレーニングと下流タスク」のパラダイムに合わせてカスタマイズされたモデルです。微調整"。 GPT と比較すると、BERT で使用されるマスク言語モデルはテキストを直接生成する機能を失いますが、双方向エンコーディングの機能が得られ、モデルに強力なテキスト エンコーディングが与えられ、パフォーマンスは下流のタスク効果の大幅な向上に直接反映されます。テキストを生成する機能を維持するために、GPT は一方向エンコードのみを使用できます。 その年の観点から見ると、BERT は間違いなく優れたモデルです。 BERT と GPT はどちらも「トレーニング前微調整」パラダイムを採用しており、下流タスクは依然として分類、マッチング、シーケンス ラベリングなどの「古典的な」NLP タスク形式であるため、BERT モデルは機能にさらに注意を払います。品質の下流タスクは、微調整するタスクに一致する適切な損失関数を選択しますが、これは明らかに、これらのタスクを「回りくどく」完了するための GPT のテキスト生成方法よりも直接的です。 BERT モデルの登場後、「教師なしトレーニングの下流タスクの微調整」というパラダイムがその優位性を確立し、さまざまなタイプの人々が BERT のアイデアに従い、「どうすれば改善できるか」を考えました。 「テキスト特徴エンコーディング」手法が大量に登場しているため、生成タスクを対象としたモデルである GPT は「エイリアン」のように見えます。今にして思えば、もし OpenAI が「トレンドに従い」、生成的事前トレーニングの道を放棄していたら、ChatGPT のようなモデルが登場するまでもっと待たなければならなかったかもしれません。 GPT-2 がもたらした希望 もちろん、ChatGPT が登場したので、OpenAI はまだ登場していません。生成前トレーニングルートは諦めました。実際、粘り強さの「ご褒美」は2年目、つまり2019年に迫ってきました。 OpenAI は、48 層の Transformer 構造を備えた GPT-2 モデルをリリースしました。発表された論文 (言語モデルは教師なしマルチタスク学習者) では、教師なしデータと生成トレーニングを通じて、GPT がゼロショット マルチタスク機能を実証したことがわかりました。驚くべきことは、これらのマルチタスク機能がトレーニング データに明示的または人為的に追加されていないことです。分かりやすい言葉で例を挙げると、GPT-2 によって実証される機能の 1 つは翻訳ですが、驚くべきことに、通常翻訳に特化して使用されるモデルは、教師ありの大量の並列コーパス (つまり、2 つの異なる言語間のペア データ) を必要とします。しかし、GPT-2 はこの種のデータを使用せず、大量のコーパスに対して生成トレーニングを実行するだけで、「突然」翻訳することができます。この発見は多かれ少なかれ破壊的であり、人々に 3 つの重要な現象を示します: 今日の観点から見ると、当時 GPT-2 によって実証されたさまざまな機能はまだ比較的初歩的であり、その効果は他のいくつかの優れたモデルの効果とは程遠いものでした。まだ明らかなギャップがありますが、OpenAI がその潜在的な機能に対する期待に満ちていることを妨げるものではないため、論文の要約の最後の文で、OpenAI は、 GPT シリーズ モデルの将来: 一連の出来事の展開によって、それらが実際にこの有望な道の方向に進んでいたことが後に証明されました。第一世代の GPT モデルが登場した 2018 年当時、GPT の生成事前トレーニングはまだ「特徴の抽出」を目的とした BERT のような事前トレーニング モデルによってあらゆる面で潰されることに直面していたとすると、GPT-2 では生成的事前トレーニングは、BERT タイプのモデルでは代替できない潜在的な利点、つまり、言語モデルのタスクによってもたらされるマルチタスク機能を提供し、このマルチタスク機能はデータのラベル付けを必要としないことを発見しました。 もちろん、その時点では、生成テクノロジーの道は依然としてリスクと課題に直面しています。結局のところ、当時の GPT-2 のさまざまなタスクにおけるパフォーマンスは、ファインチューニングされたモデルよりもまだ悪く、その結果、GPT-2 には翻訳や要約などの機能はありましたが、その効果はあまりに貧弱で実際には使用できませんでした。使用済み。したがって、その時点で使用可能な翻訳モデルが必要な場合、最善の選択肢は、注釈付きデータを使用して翻訳専用のモデルをトレーニングすることです。 GPT-3、データ フライホイールの始まり ChatGPT 時代から振り返ると、OpenAI はおそらくGPT - 2 の調査結果により、GPT シリーズ モデルに対する信頼がさらに高まり、研究開発への投資を増やすことを決定しました。なぜなら、2020年に彼らは1,750億個のパラメーターを備えたGPT-3をリリースしました。これは今日の観点から見ても驚くほど大規模なモデルです。 OpenAI はこのモデルのトレーニングにかかるコストを明らかにしていませんでしたが、当時は 1,200 万ドルかかると誰もが見積もっていました。また、この新しい巨大企業によって実証された新機能について詳しく説明した 60 ページを超える論文 (言語モデルは少数の学習者である) もリリースされました。最も重要な発見は、論文のタイトルに記載されているとおり、言語モデルには小さなサンプル (少数のショット) で学習する能力があるということです。 スモールサンプル学習は機械学習の専門用語ですが、「人間は少数のサンプルを通して新しい言語タスクを学習できる」という非常に単純な概念です。例の「」。中国語の授業で、「置く」という単語を「ある」という単語に置き換える方法を学ぶことを想像してみてください (服は雨で濡れました - 服は雨で濡れました)。教師はいくつかの例を挙げ、生徒は次のようにします。この能力を使いこなすことができるようになります。 しかし、ディープ ラーニング モデルの場合、新しい能力を習得するには通常、何千ものサンプルを学習 (トレーニング) する必要がありますが、GPT-3 が人間に似ており、同様の能力も持っていることに誰もが気づきました。そして重要な点は、いくつかの例を示すだけでよく、追加のトレーニングを必要とせずに (つまり、勾配バックプロパゲーションや従来のトレーニングを必要とせずに) パラメーターの更新をせずに、例で指定されたタスクを「模倣」するということです。その後の研究で、この能力は巨大モデルに特有のものであることが判明し、業界では「コンテキスト学習」と呼ばれています。 GPT-3 論文で実証された英語からフランス語への文脈に沿った学習能力。 実際、小規模サンプルの学習能力自体はそれほど驚くべき発見ではありません。結局のところ、業界は小規模サンプル学習に関する研究を行っており、小規模サンプル学習に特化した多くのモデルは優れた小規模サンプル学習機能を備えています。ただし、GPT-3 によって示された「コンテキスト内の学習」という少数サンプルの能力は非常に予想外であり、その理由は GPT-2 によって証明されたマルチタスク能力と同じです。 #GPT-3 は、小さなサンプルの能力を取得するために、学習データや学習方法に特別な設計を行っておらず、言語モデル タスクで学習された単なる生成モデルにすぎません。 それ以来、GPT シリーズ モデルのデータ フライホイールが回転し、高品質のユーザー データが増えるほど、モデルの反復が向上します。 ChatGPT とは異なり、GTP-3 は会話型対話モデルではなく、テキスト継続モデル (つまり、入力したテキストに従う) (以下に記述) であるため、現在の ChatGPT が備えているマルチターン会話機能を備えています。しかし、ストーリーの作成、メールのオートコンプリートなど、すでに多くのことができます。しかしその一方で、事実と異なる内容が出力されたり、有害な発言が出力されたりするなど、問題点も徐々に皆に見えてきました。これは、このテキスト生成モデルの最も顕著な欠点であり、何度も反復されてきましたが、ChatGPT は現在でも同様の問題に直面しています。

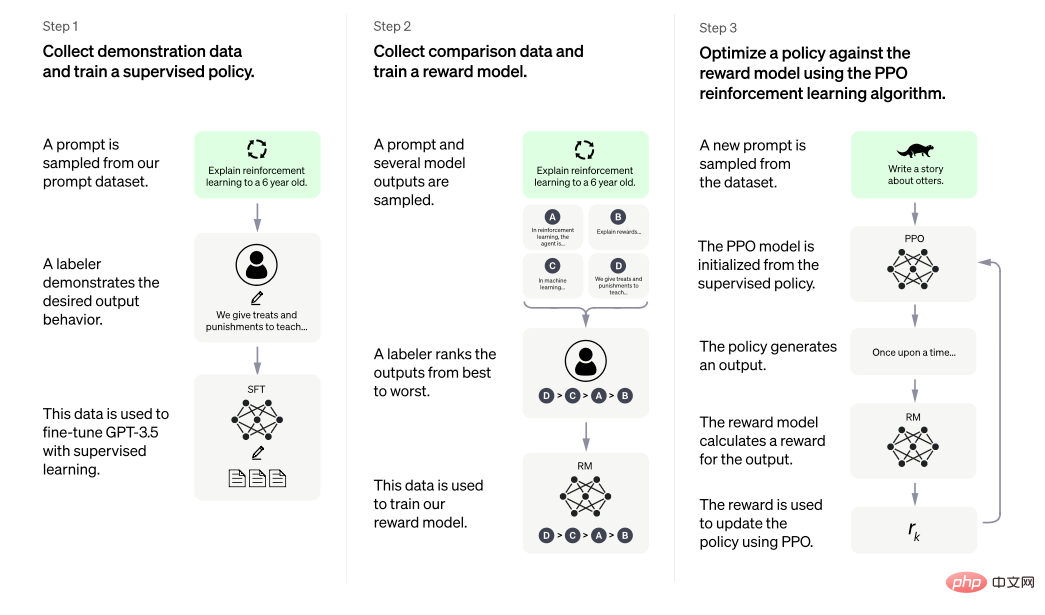

OpenAI の GPT-3 の研究でまた驚くべきことが判明いくつかのコメントに基づいて非常に単純なコードを生成できることがわかりました。そのため、2021 年にコード生成に専用の研究投資を注ぎ、CodeX モデルをリリースしました。 これは、コード特化機能を備えた GPT モデルとみなすことができ、自然言語入力に基づいて比較的複雑なコードを生成できます。 コード生成の研究と GPT シリーズモデルの開発が同時に行われているかどうかは、外部から見るとわかりません。しかし当時は、実際的な観点から言えば、モデルにコードを生成する機能を与えることが実際より有意義であったのですが、結局のところ、GPT-3 には今日の ChatGPT のような強力な機能がまだありませんでした。一方、モデルにコードを生成させると、有害なテキスト コンテンツが生成されるリスクも回避されます。 CodeX ペーパーでは、いくつかの重要なポイントが説明されています。まず、テキスト データで事前トレーニングされた GPT モデルを特別なコード データで使用します (データは、次のオープン ソース コードから取得されます)。 github、合計 159G) トレーニングにより、コードを理解して出力するモデルの能力が実際に大幅に向上します。第二に、論文では 120 億パラメータの「小規模」モデルが使用されています。この情報は、オープン インターフェイスを備えた 1,750 億パラメータの GPT-3 モデルに加えて、OpenAI 内に異なるサイズの他のモデル バージョンが存在することを側面から反映しています。 モデルがコードの決定を理解して生成できるようにするためにコード トレーニングを追加する本来の目的は、GPT にもう 1 つのアプリケーション シナリオがあることを期待しているだけかもしれません。 GPT シリーズのモデルが自然言語を理解して使用する能力とはあまり関係がないようですが、その後の研究によると (詳細な分析については、記事「 」を参照してください) GPT の分解とトレース - 3.5 さまざまな機能の起源 》)、コード データのトレーニングの増加により、後の GPT モデルが複雑な推論と思考の連鎖を自然に実行する能力が誘発される可能性があります。言語。 おそらく OpenAI は、最初に CodeX を使い始めたときはこのような結果を期待していませんでしたが、テキスト生成タスクを使用して GPT モデルを作成し、その後 GPT-2 とGPT -3 は「マルチタスクの能力」と「コンテキスト内で学習する能力」を「解放」し、コード データの導入により再び予期せぬ利益が得られました。少し偶然のように思えますが、技術的なルートを前向きに理解し、粘り強く継続的に投資することが明らかに重要な要素です。 GPT に指示して、GPT に適切に話させます GPT-3 についてはすでに説明しましたが、すでに強力な機能を備えています。 , ネット化後、利用者が増えるにつれ多くの問題が発見されましたが、最も深刻なものは「真面目にくだらない話をする」「有害なコンテンツを出力する」ことのはずです。 OpenAI は 2021 年にモデルを理解してコードを生成できるようにすることに一時的に焦点を当てているようですが、GPT-3 でこれらの問題を解決しようとしていたはずです。 2022 年初頭に、OpenAI は InstructGPT 論文 (人間のフィードバックを使用した指示に従う言語モデルのトレーニング) を公開しました。そこから、これらの問題を解決する方法を垣間見ることができます。 この論文の中心的なアイデアは、モデルが人間の教え (フィードバック) を受け入れられるようにすることです。これは、タイトル に明確に記載されています。 GPT-3が「真面目にバカ話をする」「有害なコンテンツを出力する」といった問題がある理由は、GPT-3が使用する学習データにあります。 GPT-3 のような巨大なシステムには、膨大な量のデータが必要です。そのデータ ソースは GPT-3 論文から見つけることができます。GPT-3 論文は、Web コンテンツ、百科事典コンテンツ、書籍の 3 つのカテゴリに大別できます。 Web コンテンツの量は非常に多いですが、非常に「汚くて、乱雑で、貧弱」でもあり、当然のことながら、虚偽で有害なコンテンツが多く含まれています。 GPT-3 はこのデータに基づいてトレーニングし、これらのことを自然に学習します。 しかし、外部の世界にサービスを提供する製品として、GPT-3 はより慎重に回答する必要があります。この問題を解決するための難しさの 1 つは、モデルがどのように話すかを定義する方法にあります。生成モデルの出力内容は、分類ラベルや実体名詞などの明確で客観的な善悪の内容ではなく、自然言語そのものであるためです。明確な善悪がないため、従来の NLP モデルのトレーニングのように、目標に直接向けてトレーニング タスクを設計することは不可能です。 InstructGPT が提供する解決策は非常に直接的であり、「良い答え」の評価指標にはさまざまな影響要因があり、それらの要因が相互に絡み合っているため、誰かに任せてください。答えの書き方を教えます。人間は「明確な要件と曖昧な範囲の両方」を持つこの種の問題を扱うのが得意であるため、実際の人間にいくつかの「優れた例」を書かせ、モデルにこれらの「優れた例」を学習させます。これはまさに InstructGPT が提案した一般的なアイデアです。 具体的には、InstructGPT は、GPT が人間によって与えられた「優れた例」を学習できるようにする 2 段階のパスを提案しています。強化学習です。最初の段階 (下図の左端のステップ 1 に相当) では、実際の人間にさまざまなプロンプトに従ってもらいます (大まかに言えば、ChatGPT を使用するときにダイアログ ボックスに入力するテキストと考えることができます。業界では、これはコマンドと呼ばれます) 真実で、無害で、役立つ回答を書いてください。実際の運用では、このコンテンツの品質を保証するために、回答を作成するアノテーターにいくつかの規範的なガイドラインが与えられ、その後、事前トレーニングされた GPT モデルがこれらの人が編集したデータでトレーニングを続けることが許可されます。この段階は、モデルに対する一種の「躾」とも言え、大雑把に例えると、中国語の先生が黙って優秀な作文を書けと言うようなものです。

画像は InstructGPT の論文から引用したもので、教師あり命令の微調整と強化を通じてモデルの出力を合理的にすることを提案しています。人間のフィードバックの学習。

#第 2 段階は強化学習で、技術的には 2 つのステップに分かれています。最初のステップ (上の図の中央のステップ 2 に相当) は、「トレーニングされた」モデルにさまざまなプロンプトに基づいて複数の異なる回答を生成させ、人間がこれらの回答を良いまたは悪い基準に従って分類することです。次に、これらのラベル付きデータを使用してスコアリング モデルをトレーニングし、より多くのデータを自動的に並べ替えてスコアリングできるようにします。強化学習段階の 2 番目のステップ (上図の右側のステップ 3 に相当) は、このスコアリング モデルを強化学習における環境フィードバックとして使用し、ポリシー勾配 (正確には PPO アルゴリズム) を使用します。 ) すでに「規制されている」を評価します。 トレーニングされた GPT モデルがトレーニングされます。第 2 段階のプロセス全体は、モデルの「強化」として見ることができます。大まかに例えると、中国人の先生が小論文の採点をし、その得点から何が良いのか、何が良いのかを区別するよう求めるようなものです。 . 良くない場合は、改善を続けます。

したがって、非常に大まかですが、一般の人にも理解できるかもしれませんが、InstructGPT は、まず「目立たない」GPT を「書くことによって」実現します。 「優れた人間のエッセイを黙って読む」という方法を使えば、最初は「上手に話す」ことを学び、次に「書いたことだけでスコアを与え、戻って理解させて進歩を続ける」ことができます。もちろん、「優れた論文」の具体的な仕様や量などのデータの問題や、強化学習におけるスコアリングモデルの選択やアルゴリズムパラメータの設定などのアルゴリズムの問題など、より技術的に複雑になります。すべては最終結果に影響を与えます。しかし、最終的な結果は、この方法が非常に効果的であることを示しており、論文では、上記の方法でトレーニングされた 13 億の小規模モデルが、この方法でトレーニングされていない大規模なモデルよりも優れたパフォーマンスを発揮できることも指摘しています。 さらに、この論文には言及する価値のある内容がいくつかあります。まず、Prompt に関するいくつかの発見です。 InstructGPT のトレーニング中に使用される Prompt は主に 2 つの部分で構成され、1 つは専門の AI トレーナーによって作成され、もう 1 つは OpenAI モデルのオンライン サービス中にユーザーが作成した内容から取得されます。データフライホイールは反映されています。この記事では、これらのプロンプトの具体的な報道内容、配布、質問方法について詳細な分析は行っていませんが、これらのプロンプトが次のようなものであることは合理的に推測できます。特定の特徴、多様性と高品質。実際、この記事では、実際の人々によって書かれたこれらのプロンプトを使用してトレーニングされたモデルと、一部のオープンソース NLP タスク データ セット (T0 データ セット、FLAN データ セットなど) に組み込まれたプロンプトを使用してトレーニングされたモデルを比較しました。実際の人々がプロンプトを作成すると、与えられた回答は査読者にとってより受け入れられやすくなります。

もう 1 つのポイントは、新しい Prompt に対するトレーニング済みモデルの一般化能力についてです。トレーニング済みモデルが Prompt の一般化能力を生成できない場合、次のような能力が発揮されると考えられます。現在、ChatGPT でほぼすべての質問に答えることは不可能です。なぜなら、モデルの微調整段階では、データがいくらあっても、人が入力する可能性のある内容をすべて網羅することは不可能だからです。 InstrctGPT 論文では、この論文で使用されている方法が Prompt の一般化能力を生み出すことができると指摘しています。

InstructGPT の紹介にさらに多くの文字を費やした理由は、ChatGPT の公式ページの紹介によると、InstructGPT のメソッドはまさに ChatGPT のトレーニングに使用されるメソッドだからです。唯一の違いは次のとおりです。 ChatGPT 会話型データ構成が使用されていること。

GPT-3.5 時代と ChatGPT の誕生

その後、OpenAI は GPT-3.5 シリーズと呼ばれる複数のモデルをリリースしましたが、これらのモデルには関連する論文は出版されていませんでしたが、 この記事の分析によれば、 #GPT-3.5シリーズは、GPT-3時代にOpenAIが蓄積した技術、データ、経験を統合して開発する必要があります。詳細な公式公開情報がないため、外部では主に、使用体験、関連する技術文書、OpenAI の API ドキュメントの紹介を分析することによって、これらのモデルの具体的な情報を推測しています。 分析によると、GPT-3.5 シリーズのモデルは GPT-3 で微調整されていない可能性がありますが、コードと自然言語データが融合されている可能性があります。ゼロから訓練されました。このモデルは、GPT-3 の 1,750 億パラメータよりも大きい可能性があり、OpenAI の API では codex-davinci-002 という名前が付けられています。次に、この基本モデルに基づいて、ChatGPT を含む一連の後続のモデルが命令の微調整と人間によるフィードバックを通じて取得されました。

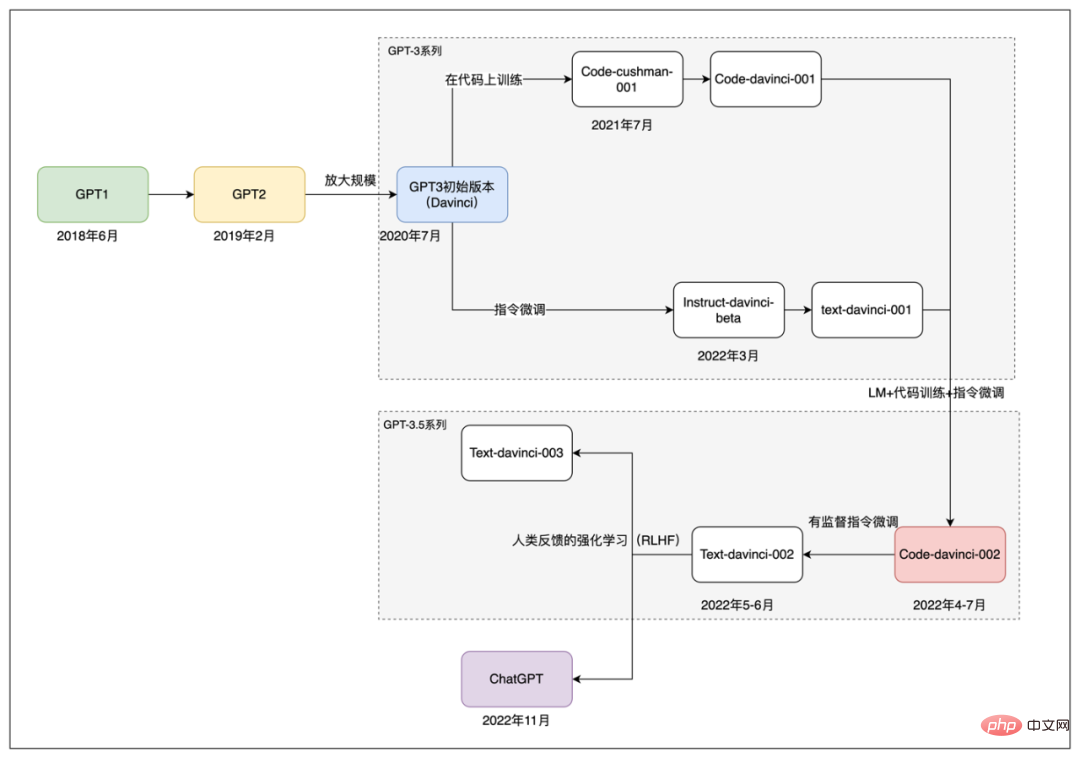

#GPT シリーズ モデルの開発パス。

簡単に言うと、code-davince-002 モデルから開始して、教師あり命令の微調整を通じて text-davinci-002 が取得されます。そして、その後の text-davinci-003 と ChatGPT も、GPT-3.5 シリーズのモデルに対する命令の微調整と人間による強化学習のフィードバックを通じて得られました。そして、text-davinci-003 と ChatGPT はどちらも 2022 年 11 月にリリースされました。違いは、text-davinci-003 が GPT-3 と同様にテキスト補完モデルであることです。 ChatGPT の公式導入によると、過去のデータを会話形式に加工し、新しい会話データを追加することで学習されます。これまで、2018 年の初代 GPT から現在の ChatGPT までの OpenAI GPT シリーズ モデルの開発と反復プロセスを大まかにレビューしてきました。このプロセスにおいて、

OpenAI は、生成事前トレーニング モデルの技術的道筋への「頑固さ」を常に維持し続けてきました。 また、進化する NLP テクノロジーから新しい手法を吸収してきました。初期の Transformer モデル構造から、その後のコマンド微調整 (プロンプト チューニング) などのテクノロジの出現に至るまで、これらの要素が共同して今日の ChatGPT の成功に貢献しています。 GPT シリーズ モデルの開発を理解したら、今日の ChatGPT に戻って見てみましょう。 3. ChatGPT を詳しく見てみる

最初の章で、ChatGPT がサークルから外れている主な理由は次のとおりであると説明しました。自然言語を使用して人間が入力した自然言語をフィードバックするため、通信する人々に強い知性を与えます。第 2 章では、GPT シリーズモデルの開発の歴史を振り返りながら、ChatGPT の成功までの軌跡を学びます。この章では、部外者にも可能な限り理解できる方法で技術的な内容をもう少し深く掘り下げ、現在の大規模なテキスト生成モデルの一部が同じ効果を達成できない理由を探ります。この部分の主な参考資料は、「言語モデルの緊急機能の詳細な理解」と「GPT-3.5 機能の起源の解体と追跡」の 2 つの記事と、いくつかの関連論文から得られます。詳細については、読者が原文を読んでください。ChatGPT によってもたらされる驚くべき効果がさまざまな NLP タスクに包括的に反映されていることは第 1 章で指摘しましたが、その背後にあるテクノロジーを分析すると、まだ解明されていません。その機能をより明確に分類することができます。全体的に、ChatGPT によって実現される機能は、次の次元に大別できます。

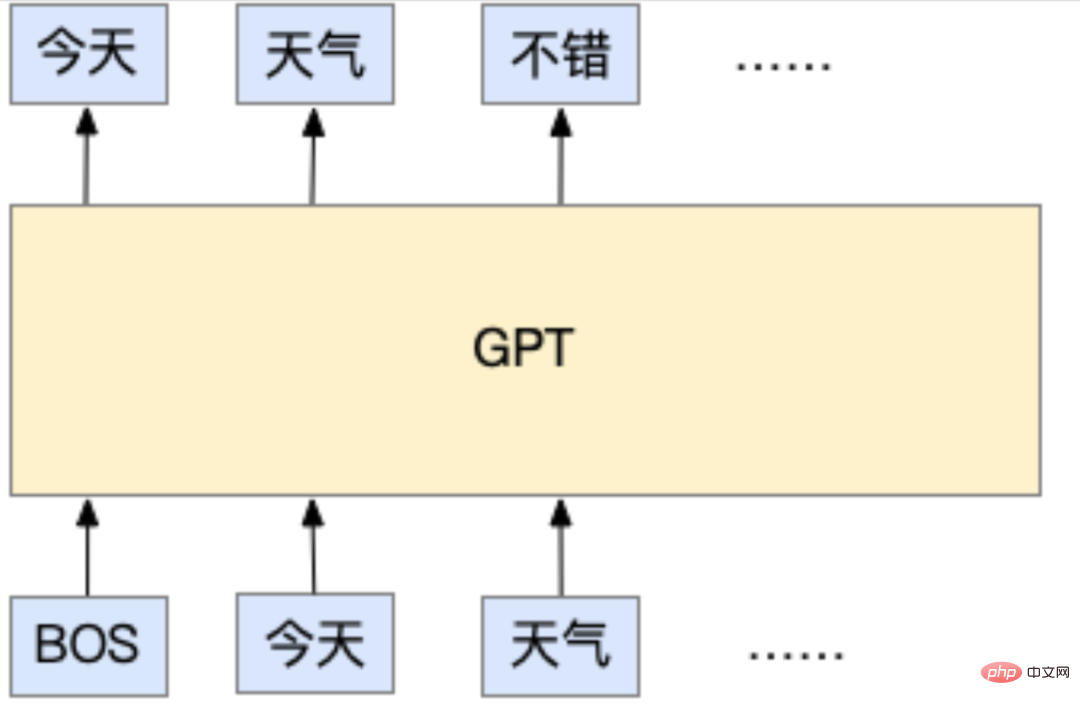

- テキスト生成機能: ChatGPT のすべての出力は即座に生成されます。テキストは最も基本的な要件です。 この機能は実際にはそのトレーニング メソッドから来ており、事前トレーニング中、ChatGPT は標準の自己回帰言語モデル タスクであり、すべての OpenAI GPT シリーズ モデルの基礎となります。いわゆる自己回帰言語モデル タスクは、一般的に次のように理解されています。入力されたテキストに基づいて次のトークンが何であるかを予測できます。ここで言及するトークンは、モデルで使用される文字フラグメントの最小単位を表し、文字 (中国語では文字を使用するのが一般的です) または単語 (英語の各単語は自然にスペースで区切られます) にすることができます。言葉もよく使われます)、あるいは文字さえも。しかし、現在の方法では通常、サブワード(文字と単語の間にあるサブワード。主な目的は単語の数を減らすことです)を使用します。しかし、どちらであっても、自己回帰言語モデル タスクの基本的な考え方は、次の例のように、入力されたテキストに基づいて次に出力されるテキストを予測することです。

この例では、BOS は入力の始まりを表し、各トークンは単語です。GPT モデルは入力「」を使用します。 today" と " 「天気」という 2 つの単語により、次の出力は「良い」と予測されます。

学習時には、Webページの記事や各種書籍などのテキストデータが大量に用意されます。通常のテキストコンテンツであれば、トレーニングに使用されます。この種のデータはもともと人によって書かれたものであるため、この種のデータには手動による追加の注釈が必要ないことに言及する価値があります。モデルが行う必要があるのは、「前のテキストを考慮して、これらの人々によって書かれたテキストに基づいて」を学習することです。 , 次に「この言葉の後ろにあるこの場所は何でしょう?」という質問です。これは、業界で「教師なしトレーニング」と呼ばれるものです。実際、モデルは実際には教師なしではありません (そうでなければ、モデルは何を学習するでしょうか?) が、そのデータには手動による追加の注釈は必要ありません。追加のアノテーションを必要としないタスクだからこそ、大量のデータを「無料」で入手できるのですが、インターネットの普及により、実際の人間が書いた大量のテキストコンテンツを学習用に「簡単」に入手できるようになりました。これも GPT シリーズのモデルの特徴の 1 つであり、大規模なモデルの学習には大量のデータが使用されます。それでは、ChatGPT を使用すると、どのように機能するのでしょうか?実際、これはトレーニング方法と同じです。モデルは、ダイアログ ボックスに入力したコンテンツに基づいて、コンテンツに続く次のトークンを予測します。このトークンを取得した後、前のコンテンツと結合されて、テキストがモデルに与えられ、モデルは次のトークンを予測し、特定の条件が満たされて停止するまでこれを繰り返します。この停止条件を設計するにはさまざまな方法があり、たとえば、出力テキストが特定の長さに達した場合や、停止を表すために使用される特別なトークンをモデルが予測する場合などがあります。モデルが次のトークンを予測するとき、それは実際には舞台裏でサンプリング プロセスであることにも言及する価値があります。つまり、モデルがトークンを予測するとき、実際にはすべての可能なトークンの確率を出力し、この確率分布からトークンをサンプリングします。したがって、ChatGPT を使用すると、同じ入力であっても、出力として異なるトークンを密かにサンプリングするため、出力が毎回異なることがわかります。

これを理解したら、モデルが何を学習しているのかを戻って考えてみましょう。それは質問と答えに答える方法を学ぶことですか?それとも、自然言語に含まれる情報、論理、感情を理解する方法を学んでいるのでしょうか?それとも膨大な量の知識を学んでいるのでしょうか?学習タスクの設計から判断するとそんなことはなく、「入力されたテキストを基に人間が次に何を書くか」を膨大なテキストデータから学習しているだけのようです。しかし、この種のモデルが ChatGPT に「進化」すると、豊富な知識、複雑な論理的推論などを習得し、人間が言語を使用するために必要なほぼすべての能力を習得したように見えます。これは非常に不思議なことであり、その「進化」プロセスについては次の章でさらに詳しく紹介します。

#- 豊富な知識の蓄え: ChatGPT は、歴史、文学、数学、物理学、プログラミングなどを含む多くの質問に正しく答えることができます。 ChatGPT の現在のバージョンは外部知識を利用しないため、この知識の内容はモデル内に「保存」されます。

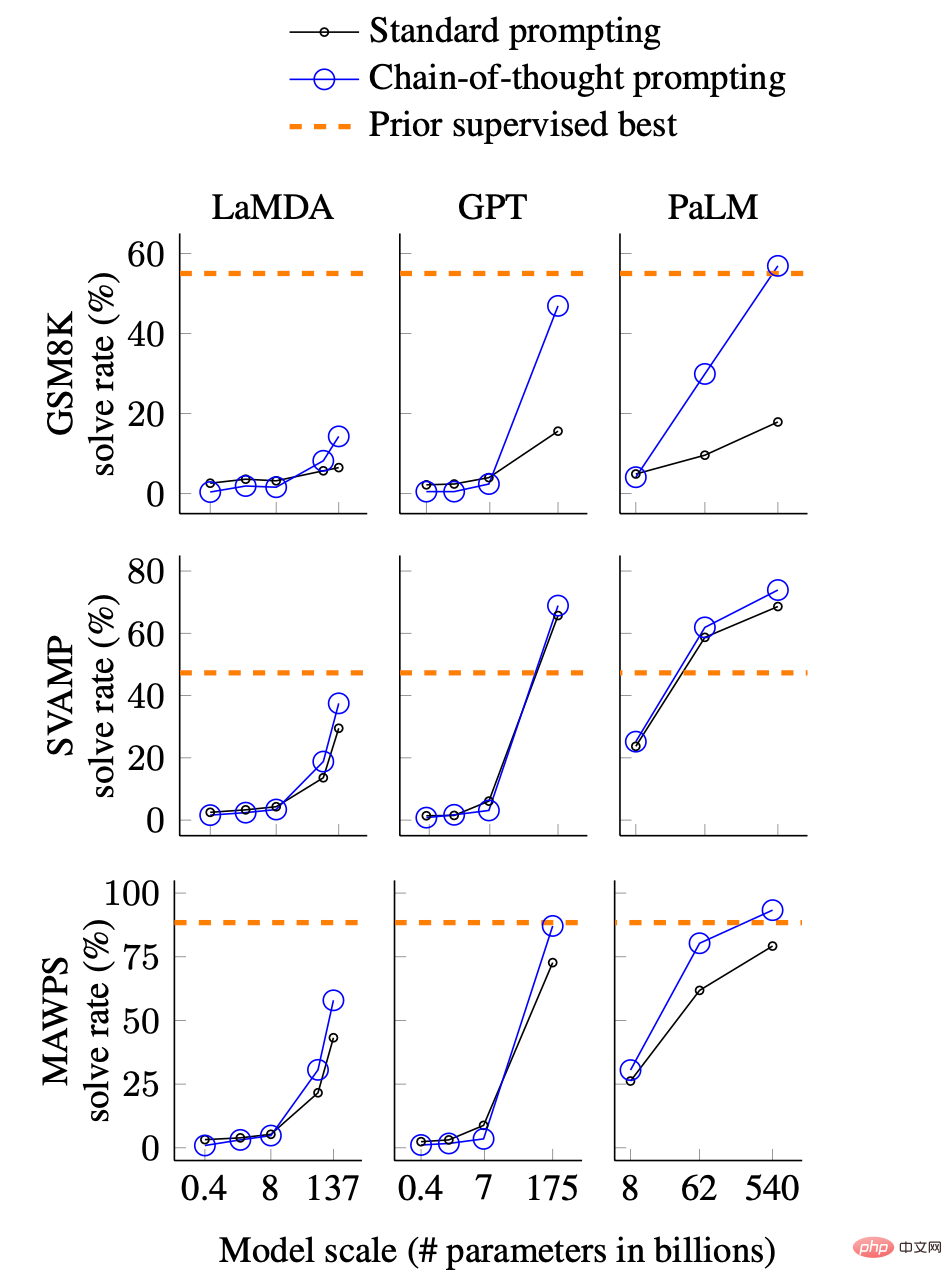

ChatGPT の豊富なナレッジ ベースは、トレーニング データと、これらのコンテンツを学習するのに十分なサイズから得られます。 ChatGPT で使用されるトレーニング データの詳細は公式には公開されていませんが、その前身である GPT-3 の論文から、データは Web コンテンツ、書籍コンテンツ、百科事典コンテンツの 3 つの大きなカテゴリに大別できることが推測できます。 。これらのコンテンツには、百科事典や書籍はもちろんのこと、当然ながら多くの知識が含まれていると考えられますが、Webコンテンツにもニュースやコメント、意見などが多く含まれており、Webページには専門的なQ&Aのバーティカルサイトも数多く含まれています。これらは ChatGPT の知識源です。公式の紹介文では、ChatGPT は 2021 年以降に何が起こったのかを答えることができないと指摘しているため、トレーニング データの収集は 2021 年に終了するというのが妥当な推測です。 しかし、データの量は 1 つの側面にすぎず、モデルがこのデータを「マスター」するには、それ自体の量が小さくてはなりません。 GPT-3を例にとると、1,750億個のパラメータがあり、これらのデータの内容とモデルのさまざまな機能が、各パラメータの具体的な値の形で学習済みモデルに固定されていることが大まかに理解できます。 。モデルにパラメータが 1 つしかない場合、モデルは何もできないというのが知覚的な理解です。より厳密な分析と比較については、この論文の評価「言語モデルの全体的な評価」を参照してください。方向性のある結論は、モデルが大きいほど、完了するために知識が必要なタスクのパフォーマンスが向上するということです。 論文アドレス: https://arxiv.org/pdf/2211.09110.pdf -論理的推論と思考連鎖能力: 第 1 章の写真にある同じ檻の中のニワトリとウサギの例からわかるように、ChatGPT は強力な論理的推論能力を備えています。また、複雑な内容を複数の小さなステップに分解し、段階的に推論して最終的な答えを得ることができ、この能力は思考連鎖と呼ばれます。 前の紹介から、モデルにはトレーニング中の論理的推論と思考チェーンのための特定の設計がないことがわかりました。現在の主流の見方は、論理的な推論と思考の連鎖は 2 つの要素に関連している可能性が高いというものです。1 つ目はモデルのサイズで、2 つ目はモデルがコード データでトレーニングされているかどうかです。 モデルのサイズと推論および思考連鎖の能力との関係については、「言語モデルの創発的能力の詳細な理解」に対応する紹介があります。下の図は、思考連鎖能力とモデル サイズの関係を示しています。

さまざまなモデルとさまざまなサイズの思考連鎖効果の比較。図は論文から引用したものです。 GSM8K、SVAMP、MAWPS は論理的推論を必要とする 3 つの数学的文章題データ セットであり、LaMDA、GPT、PaLM はそれぞれ 3 つの異なるモデルです。

簡単に説明すると、このグラフは、3 つの数学的文章題データ セットに対する 3 つの異なるモデルの正答率を示しています。注目に値するのは次の側面です:

- 思考チェーンの能力 (青い実線) は、モデルのサイズが十分に大きい場合、効果が突然変化します。

- #モデルが十分に大きい場合、思考連鎖の能力は標準的なプロンプト (黒の実線) 方法よりも効果的です。

- 能力モデルが十分に大きい場合、思考連鎖のレベルは教師あり手法 (オレンジ色の点線) に近いか、それを超える可能性があります。

平たく言えば、モデルが十分に大きくなると、思考連鎖の能力が突然現れ、データセットの推論を専門とする能力に達するか、それを超えることさえあります。トレーニング。この図は、現在私たちが目にしている ChatGPT の優れた推論機能と思考連鎖機能を部分的に説明している可能性があります。

推論および思考チェーンの機能に関するもう 1 つの要素は、モデルがコード データでトレーニングされているかどうかに関係します。現時点では、これは単なる推論にすぎません。「GPT-3.5 の機能の分解と起源の追跡」の分析では、同様のサイズの大きなモデルは、訓練されていない場合、思考連鎖と推論が非常に弱いか、ほとんどないことが示されています。コードの能力。そして、ChatGPT は実際にコード データでトレーニングされており、コードを理解して生成する能力からもわかります。第 2 章の開発プロセスのレビューで述べたように、OpenAI は 2021 年にコードに特化した CodeX モデルをリリースしました。その頃から、GPT の学習データへのコード データの追加が開始されていたはずです。

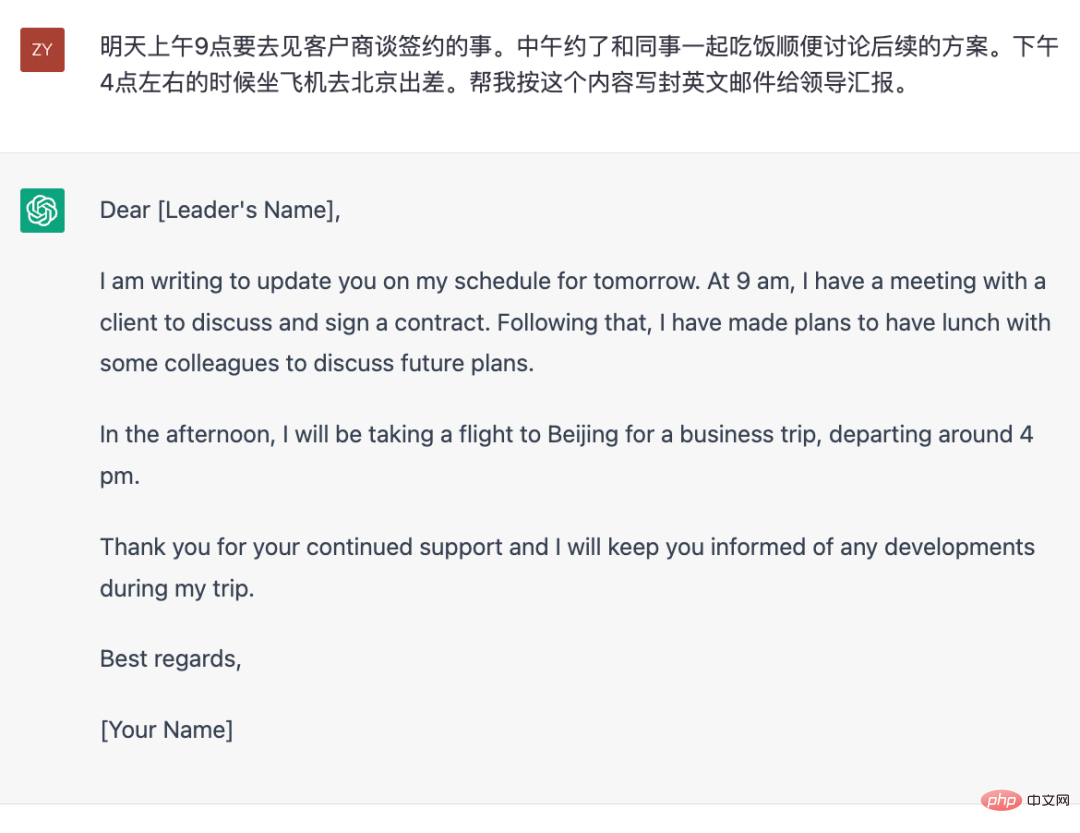

- 人々の質問や指示に応答する機能: ChatGPT は、狭い「質問と回答」形式の対話を使用するだけでなく、入力要件にも応答できます。例えば、「手紙を書いて」といったコマンド形式のリクエストにも優れた性能を発揮します。この機能により、答えを提供する「高度な検索エンジン」だけでなく、自然言語と対話できるワードプロセッサ ツールとしても機能します。

一般の人々は現在、検索エンジンのようなツールとして ChatGPT に注目していますが、関連する知識にアクセスして答えを与えることだけが ChatGPT の機能ではありません。実際、ChatGPT 自体に関する限り、知識に関する質問に答えることはその長所ではなく、結局のところ、ChatGPT 自体のトレーニング データは 2021 年に修正されています。最新のデータで学習させても時事の変化には追いつけないため、知識問答ツールとして利用したい場合は、やはり検索エンジンなどの外部知識源と組み合わせる必要があります。 Bing が現在行っているのと同じです。

しかし、別の観点から見ると、ChatGPT は「完全な言語」テキスト ツールのようなもので、指定された要件に従って、指定されたタスクをテキスト形式で完了できます。内容は以下の例のようなものです。

# 指定された計画内容に応じて、報告用の英語メールを作成します。

#ここで言う「言語完成度」とは、言語を使用する能力を指します。上記の例では、書き込む必要があるコンテンツがすでに提供されているため、実際には知的コンテンツは含まれていないことがわかります。ただし、このメールを書くには、単語や文章の選択、言語の切り替え、メールの形式など、言語を使用する能力が必要です。

ここで、戻って「指示に従ってタスクを完了する」という能力をどのように獲得したかを分析してみましょう。学術界ではこのような指示をプロンプトと呼んでいますが、実際には会話でのユーザー入力やQ&Aでの質問もプロンプトなので、チャットボックスに入力されたものはすべてプロンプトであると大まかに理解できます。この章の最初のセクションで言語モデルについて紹介した内容を理解していれば、より厳密に言うと、「モデルへの上記の入力」はすべてプロンプトであるということになります。

ChatGPT が入力コマンド (プロンプト) に従って応答する機能は、コマンド微調整 (プロンプト チューニング) と呼ばれるモデル トレーニング方法に基づいています。実際、原理は非常に単純です。モデルは依然として「入力内容に基づいて次のトークンを予測します。」しかし、命令の微調整段階では、入力内容はこれらの事前に作成されたプロンプトに置き換えられ、その内容はこれは、プロンプトの後に生成する必要があります。これは、事前に書かれた答えです。したがって、この段階と最初に述べた教師なし自己回帰言語モデルのトレーニングとの最大の違いはデータにあります。ここでのデータ、つまりプロンプトとそれに対応する応答はすべて人間によって書かれており、言い換えれば、この段階では手動でラベル付けされたデータによる教師ありトレーニングが使用されます。

手動でラベル付けされたデータの場合、ラベル付けされた各データにはコストがかかるため、当然のことながら必要なデータ量が必要になります。 (トレーニングの第 1 段階と同様に) ラベル付けの必要がない場合、当然トレーニングに使用できる大量のテキスト データが存在しますが、ラベル付けが必要な場合、このデータはどれくらい必要になるでしょうか。ご存知のとおり、アノテーターがプロンプトを手書きし、数百語の正確で詳細な回答を手書きするのは非常にコストがかかります。論文「人間のフィードバックによる指示に従う言語モデルのトレーニング」によると、実際に必要なデータはそれほど多くありません(教師なし段階で使用されるデータと比較して)。 ChatGPT がどの程度使用されているかについては正確な情報は開示されていませんが、教師なしトレーニングに使用される Web ページ、百科事典、書籍で構成されるデータ セットよりもその規模がはるかに小さいことは確かです。

論文アドレス: https://arxiv.org/pdf/2203.02155.pdf

比較的小規模なもののみ手動でアノテーションを付けたプロンプトデータは、モデルが指示に従って応答できるようにするという目的を達成できますが、この事実は、学術界でプロンプトの汎化能力と呼ばれる現象を実際に暗示しています。ご想像のとおり、世界中の人々が常に ChatGPT について質問しており、彼らが尋ねる質問はあらゆる種類の奇妙なものに違いありません。これらの質問は実際にはプロンプトです。しかし、ChatGPT の命令を微調整するために使用されるプロンプトは決して多くありません。これは、モデルが一定量のプロンプトと対応する回答を学習した後、「推論を導き」、これまでに見たことのないプロンプトに回答できることを示しています。プロンプトの汎化能力です。記事「 GPT-3.5 のさまざまな機能の起源を分解して追跡する 」の分析では、この一般化能力が密接に関係していることが指摘されています。命令の微調整段階に関連し、モデルが学習するラベル付きデータの量と多様性に関連します。

さらに、少量のプロンプト データを使用して、ChatGPT などの強力な機能を備えたモデルを微調整することができます。その背後には、表示されるさまざまな項目という別の推測があります。能力は、教師なしトレーニング段階でモデルにすでに存在している可能性があります。実際、これは容易に理解できますが、結局のところ、これらの手動でラベル付けされたプロンプトの数は、教師なしデータに比べて少なすぎるため、モデルがこれらのラベル付けされたデータのみから学習してさまざまな能力を開発したとは考えにくいです。この観点から見ると、命令の微調整のプロセスは、特定の仕様に従ってモデルに応答することを学習させることに重点が置かれており、モデルの知識、ロジック、その他の機能はすでに存在しています。

- 「客観的かつ公平」である能力: ChatGPT に有害な質問や物議を醸す質問をすると、ChatGPT の回答が非常に「慎重」で、非常に回答的であることがわかります。まるで訓練された報道広報担当者のように。まだ十分ではありませんが、この機能が OpenAI が製品として公に使用することを敢えて行う核心的な要素です。

#モデルの出力を人間の価値観と一致させることが、OpenAI が取り組んできたことです。 2020 年の GPT-3 の時点で、OpenAI は、オンライン データを通じてトレーニングされたこのモデルが差別的で危険な物議を醸すコンテンツを生成することを発見しました。外部サービスを提供する製品として、このような有害なコンテンツは明らかに不適切です。現在の ChatGPT はこの点で大幅に改善されています。モデルにこの「動作変更」を行わせるための主な方法も、InstructGPT の論文から来ています。より正確には、教師あり命令の微調整と人間によるフィードバックによって実現されます。第 2 章でも紹介した強化学習と併用します。

上記の分析を通じて、技術的手法の観点からは、ChatGPT に関連するすべてのコンテンツが既知であることがわかります。しかし、なぜ現時点でこのような驚くべきパフォーマンスを発揮できるのは ChatGPT だけなのでしょうか?実際、ChatGPT の立ち上げ以来、NLP コミュニティはその理由を分析しており、多くの結論は推測にすぎませんが、同様のモデルのローカライズにある程度の啓発ももたらします。

# モデル サイズの要因

#機能の出現の前提は、モデル サイズが一定に達することです。特定の指標ガイドラインはありませんが、現在の事実から判断すると、思考連鎖などの比較的「高度な」機能は、数百億以上のパラメータを持つモデルで十分なパフォーマンスを発揮する必要があります。

データ量の要因

モデルのサイズだけが要因ではありません。 DeepMind は、この論文「コンピューティングに最適な大規模言語モデルのトレーニング」でいくつかの分析的結論を提供し、モデルのサイズに応じてトレーニング データの量を増やす必要があることを指摘しています。より正確には、モデルをトレーニングするときに、「モデルのサイズに応じて「トークン」の数を増やす必要があります。

論文アドレス: https://arxiv.org/pdf/2203.15556.pdf

データ品質の要因

#教師なしデータの場合、データ量は大きな障害にはなりませんが、データの品質は見落とされやすいことがよくあります。実際、GPT-3 論文にはデータ処理に関する特別な内容が含まれています。 GPT-3 のトレーニング データをクリーンにするために、OpenAI は大量の Web ページ データからより高品質のデータを取得するためにデータ フィルタリング モデルを特別にトレーニングしました。比較すると、Meta の Opt や BigScience の Bloom など、GPT-3 と同等のサイズの一部のオープンソース モデルは、このクリーンアップのステップを経ていないようです。これが、これら 2 つのオープンソース モデルが GPT-3 よりも劣る理由の 1 つである可能性があります。

さらに、データ品質の測定次元は単一ではなく、データの多様性、コンテンツの重複、データの分散などのすべての要素を考慮する必要があります。たとえば、Web ページ データの総量は、GPT-3 で使用される 3 つのデータ カテゴリ (Web ページ、百科事典、書籍) の中で最大ですが、トレーニング中のこれら 3 種類のデータのサンプリングは量に基づいていません。実際のデータの。

また、指示を微調整する段階では、手動による指示の使用が重要な影響要因となる可能性があることにも言及する価値があります。 InstructGPT の論文では、評価プロセス中、手動で書かれた命令を使用してトレーニングされたモデルの方が、テンプレートを介して命令を構築するために既存の NLP データセットを使用してトレーニングされたモデルよりも良い結果が得られると明確に指摘しています。これは、T0 や FLAN などの NLP データ セットで構成される命令データ セットでトレーニングされたモデルの効果が低い理由を説明している可能性があります。

#トレーニング プロセスの影響

このタイプの巨大モデルは、データ並列処理を使用しながらクラスターを通じてトレーニングされます。モデルの並列処理、および ZeRO オプティマイザー (トレーニング プロセスのメモリ使用量を削減する方法)、これらの方法では、トレーニングの安定性により多くの変数が導入されます。次の分析は、モデルが bfloat16 精度を使用するかどうかが結果に大きな影響を与えることを示しています。

分析リンク: https://jingfengyang.github.io/gpt

上記の内容は理解できたと思います。内容としては、ChatGPT のようなバージョンを偽造する方法と直面する問題について、誰もが一般的に理解できるようになります。幸いなことに、OpenAI はこの技術的パスが実現可能であることを証明しており、ChatGPT の出現は実際に NLP テクノロジーの開発トレンドを変えています。

4. 今後の展望ChatGPT は 2022 年 11 月のローンチ以来、大きな注目を集めています。専門家でなくても、コンピュータにあまり縁のない人でも、その存在は多かれ少なかれ知っていると思いますが、この現象自体が、その見た目が少々特殊であることを反映しています。サークルの外にいる一般の人々は、好奇心、驚き、または賞賛の感情を持ってその外観をより知覚的に認識します。実務家にとって、その出現は、むしろ将来の技術トレンドについて考えることになります。

#技術的な観点から見ると、ChatGPT の出現は、NLP 分野における新たなパラダイム シフトを示しています。。 「また」と言われる理由は、初代 GPT がリリースされた 2018 年に、同年にリリースされた BERT モデルにより、NLP の「トレーニング前微調整」パラダイムの時代が到来したためです。その優れた性能については、第 2 章で具体的な内容を紹介しています。ここではChatGPTで実現できる「テキスト生成コマンド」のパラダイムを中心に紹介します。具体的には、トレーニング済みの ChatGPT または同様のテキスト生成モデルを使用して、適切な指示 (プロンプト) を入力することで特定のシナリオを完了します。

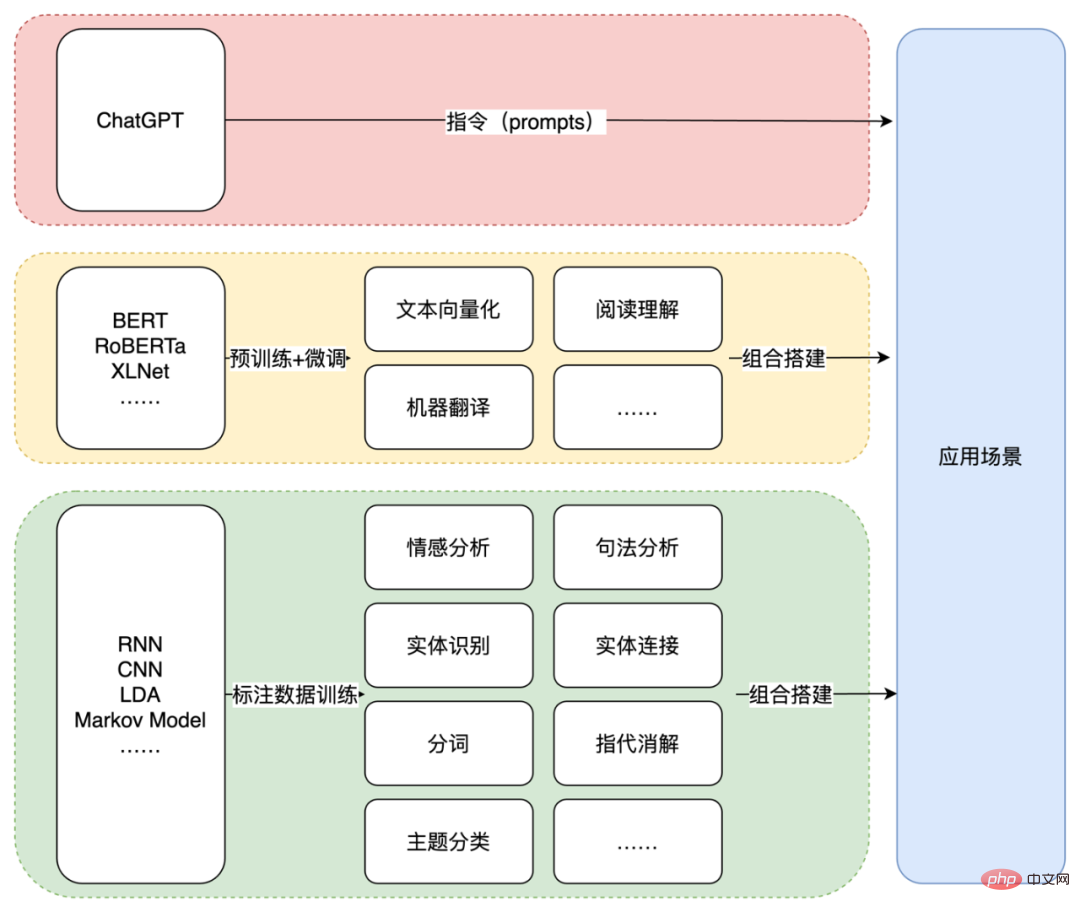

このパラダイムは、以前の NLP テクノロジー アプリケーションとは大きく異なります。 LDA や RNN などの統計モデルや小規模な深層学習モデルを使用する初期の時代であっても、BERT などの事前トレーニングや微調整を使用する後期の時代であっても、テクノロジーによって提供される機能は比較的細分化されており、はるかに優れています。実際のアプリケーションのシナリオから一定の距離を置きます。

ChatGPT に要件に従って英語の電子メールを作成するよう要求する上記の例を見てみましょう。以前の実践によれば、エンティティ、イベント、およびその他のコンテンツ (時間、場所、イベントなど) を抽出する必要がある場合があります。 .) 最初に、次にテンプレートを使用するか、モデルによって電子メールの形式が形成され、その後、翻訳モデルを通じて英語に変換されます。もちろん、データ量がエンドツーエンド モデルをトレーニングするのに十分な場合は、いくつかの中間ステップをスキップすることもできます。ただし、どの方法を使用する場合でも、最終シーンをアトミックな NLP タスクに分割するか、対応する注釈データが必要になります。 ChatGPT の場合、必要なのは適切なコマンドだけです。

NLP テクノロジー パラダイムの 3 段階。

プロンプトと組み合わせたこの種の生成モデルは、途中にあるさまざまな NLP 機能コンポーネントを直接スキップし、最も直接的な方法でアプリケーションの問題を解決します。シーン。このパラダイムの下では、端末アプリケーションを完成させるための技術的パスは、ビルディング ブロックを介したシングルポイント NLP 機能モジュールの組み合わせではなくなります。

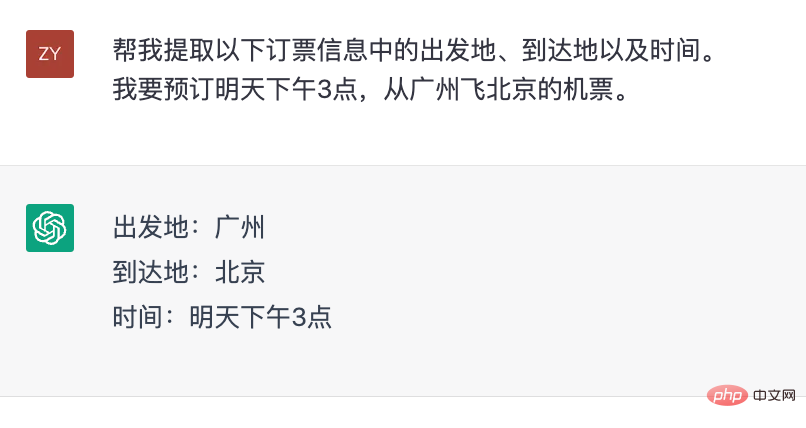

もちろん、このプロセスは一夜にして達成されるわけではありません。また、NLP の単一点の能力が重要でなくなるわけでもありません。評価の観点から見ると、各単一能力点の質は、モデルの有効性を評価するための指標として引き続き使用できます。さらに、シナリオによっては、シングルポイント機能が依然として強い需要となっています。たとえば、チケット予約システムでは、時間と場所を抽出する必要があります。ただし、以前とは異なり、追加の機能モジュールを使用せずに、ChatGPT 自体でシングルポイント機能を完了することもできます。

#ChatGPT は情報抽出を実行します。

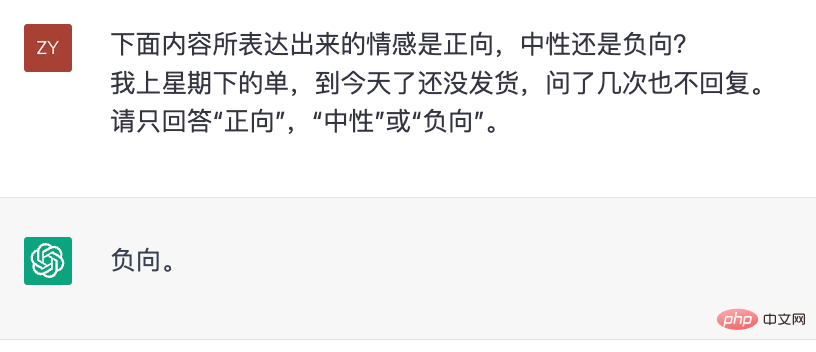

#ChatGPT は感情的な判断を行います。

この観点から、ChatGPT は対話型媒体として自然言語を使用する NLP ツールとみなすことができます。以前にモデル データを使用したトレーニング タスクを設計することで特定の NLP 機能を完成させた場合、ChatGPT は命令を設計することでこれらの機能を完成させます。ご想像のとおり、ChatGPT の登場により、NLP テクノロジーの適用の敷居は大幅に下がりました。しかし、それはまだ全能ではありません。最も重要な点は、正確で信頼できる垂直領域の知識が欠如していることです。回答の信頼性を高めるために、最も直接的な方法は、Microsoft が Bing の検索結果を情報源として使用しているのと同じように、外部の知識ソースを提供することです。その答え。

したがって、「従来の」NLP テクノロジーは完全に消滅するわけではありませんが、ChatGPT の現在の欠点を補う「補助的な」役割を果たすことになります。これが将来の新しいパラダイムになる可能性があります。 NLP技術の応用。

以上がChatGPTの過去と現在:OpenAIの技術「頑固さ」と「大きな賭け」の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。